Internet Outages Timeline

Dive into high-profile Internet disruptions. Discover their impact, root causes, and essential lessons to ensure the resilience of your Internet Stack.

January

TikTok

What Happened?

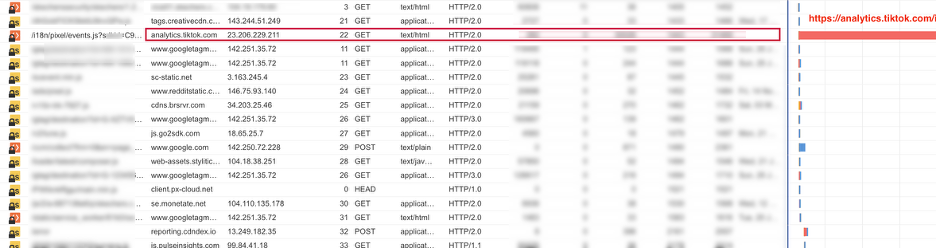

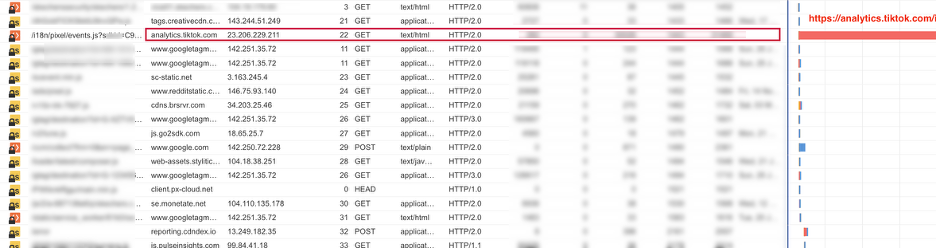

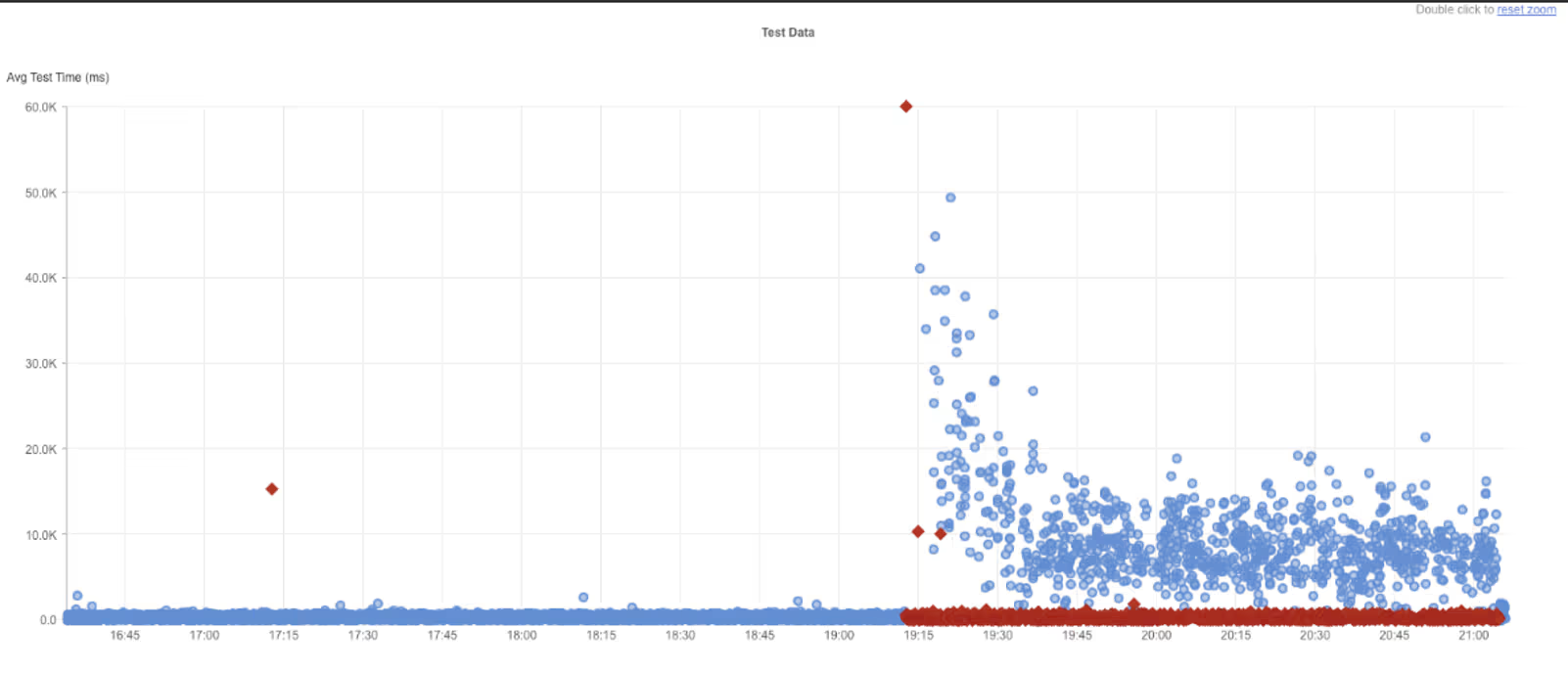

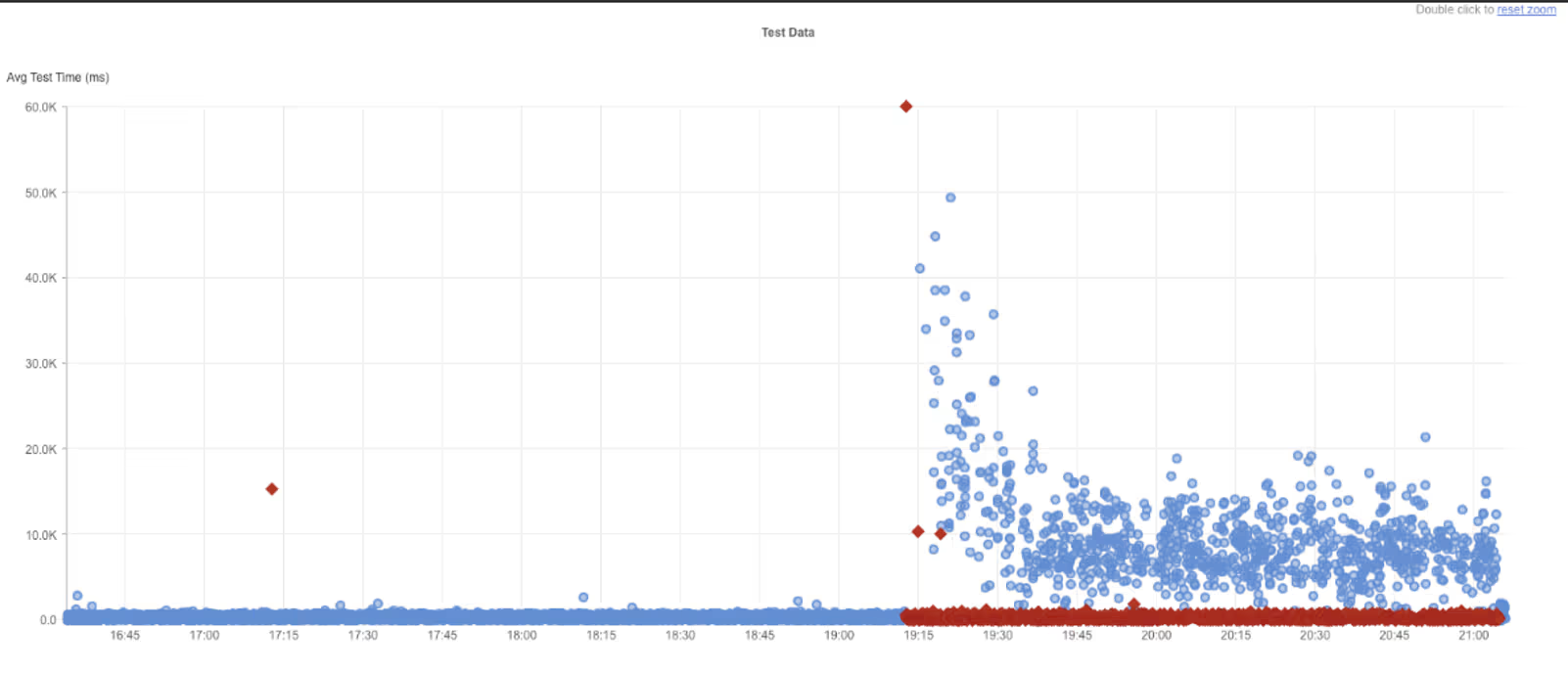

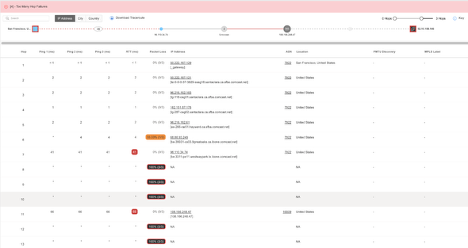

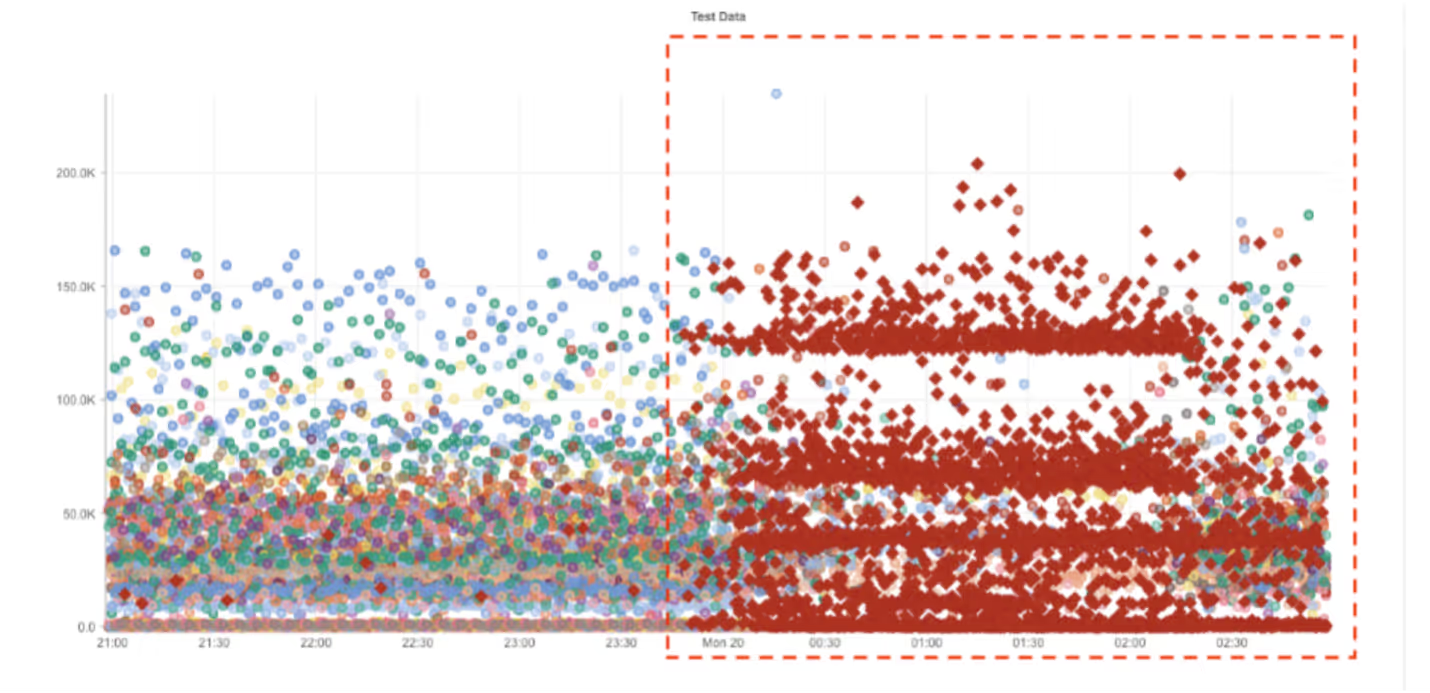

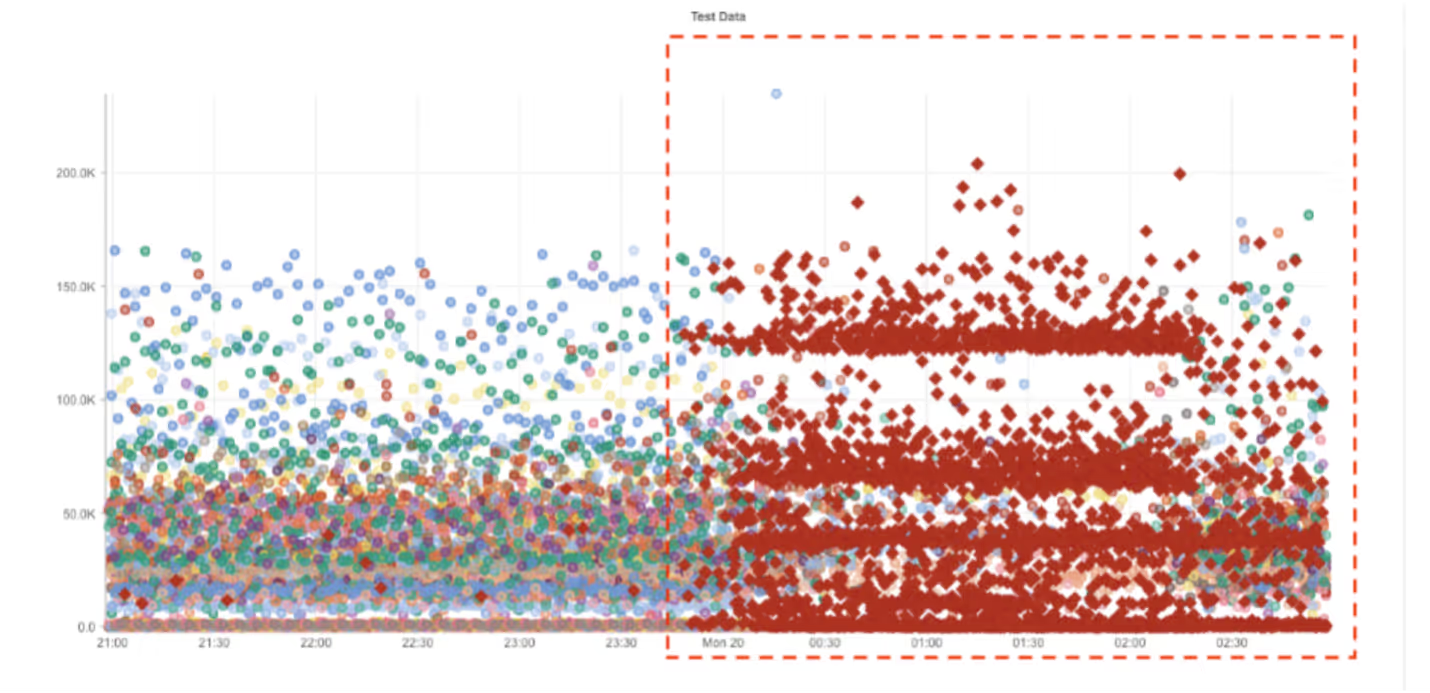

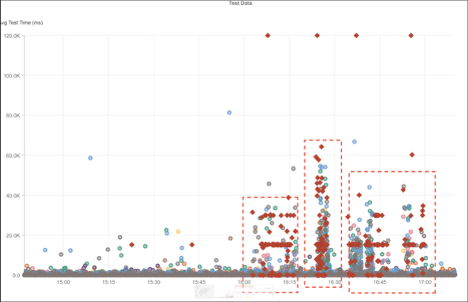

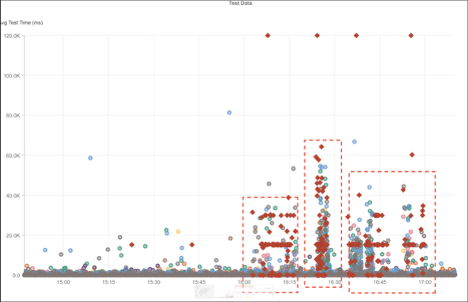

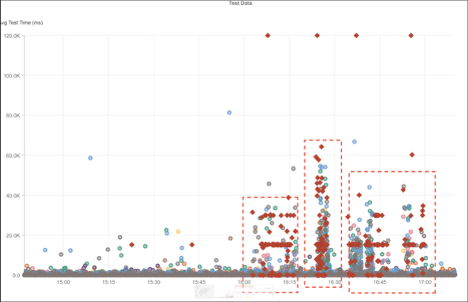

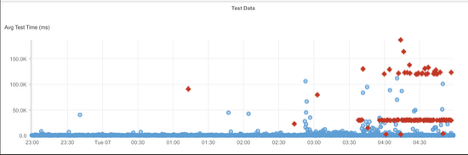

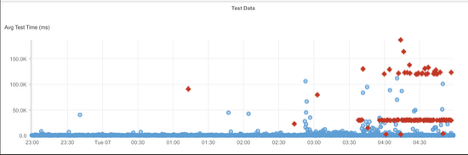

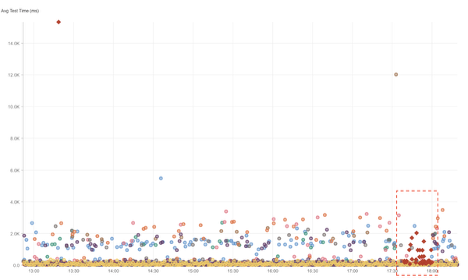

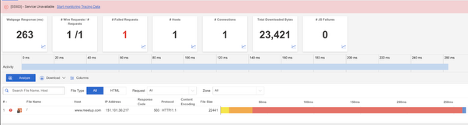

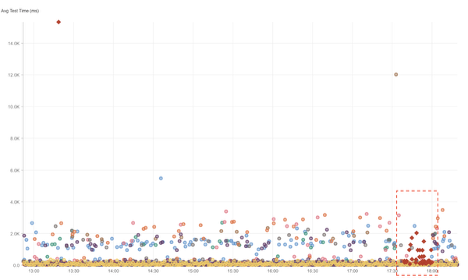

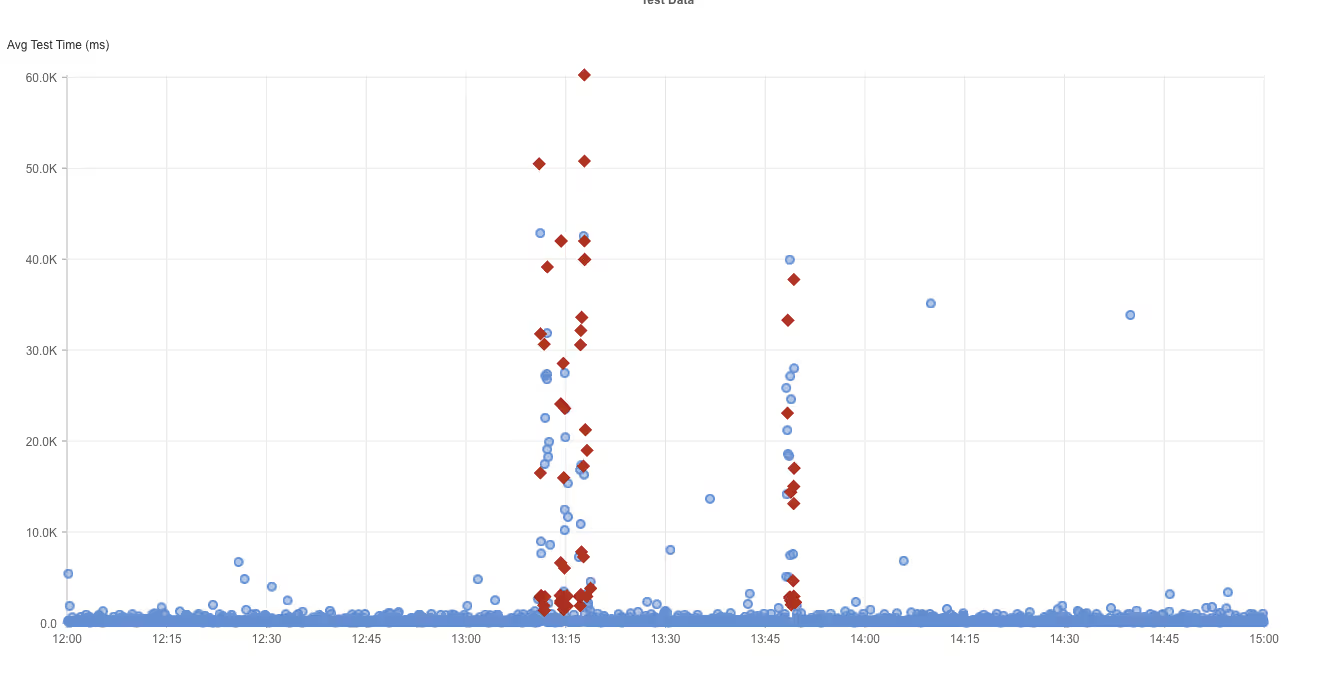

Catchpoint test data and browser timing showed that requests to TikTok’s analytics service were delayed during the connection (TCP connect) phase, with connection times reaching 20–30 seconds in some cases. DNS resolution, SSL negotiation, server processing, and page rendering times were normal, indicating the delay occurred before a successful network connection was established.

Because the TikTok scripts were included in the critical page load path, browsers waited for these third-party connections before completing the page load. As a result, pages appeared slow or unresponsive to users, even though the website’s own application, backend services, and CDN were operating normally and availability remained high.

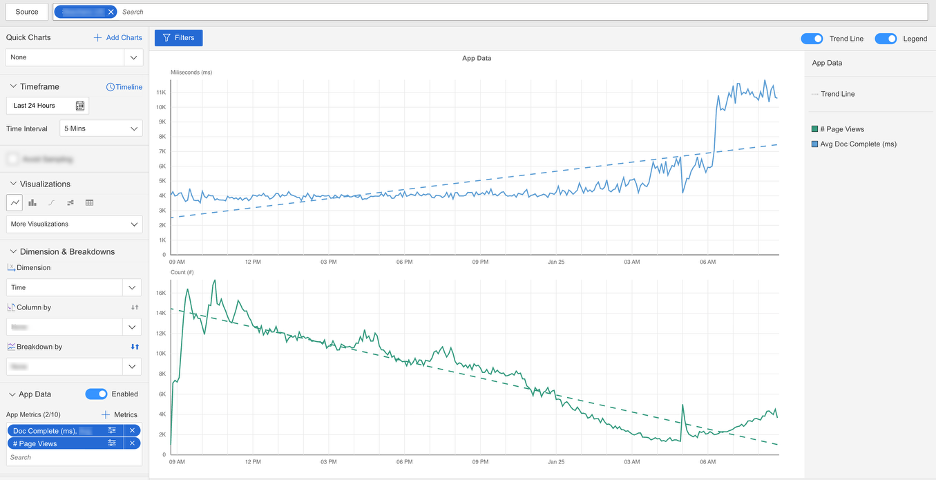

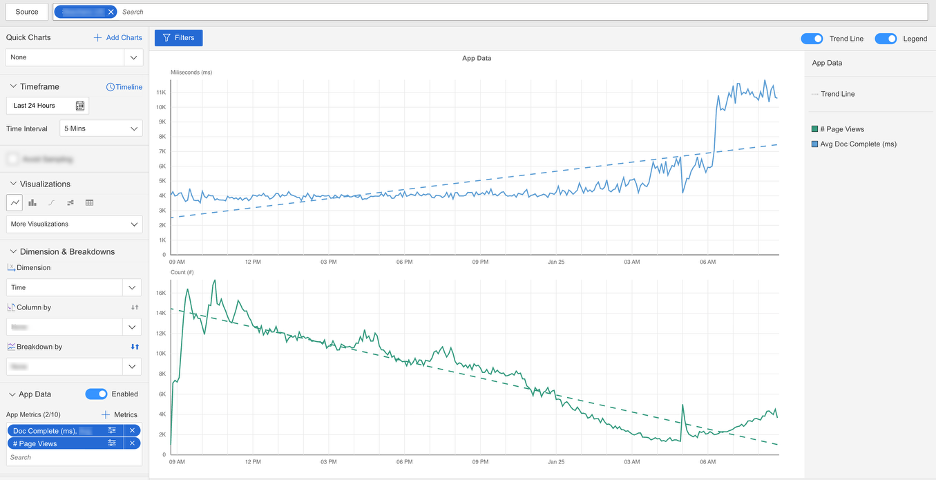

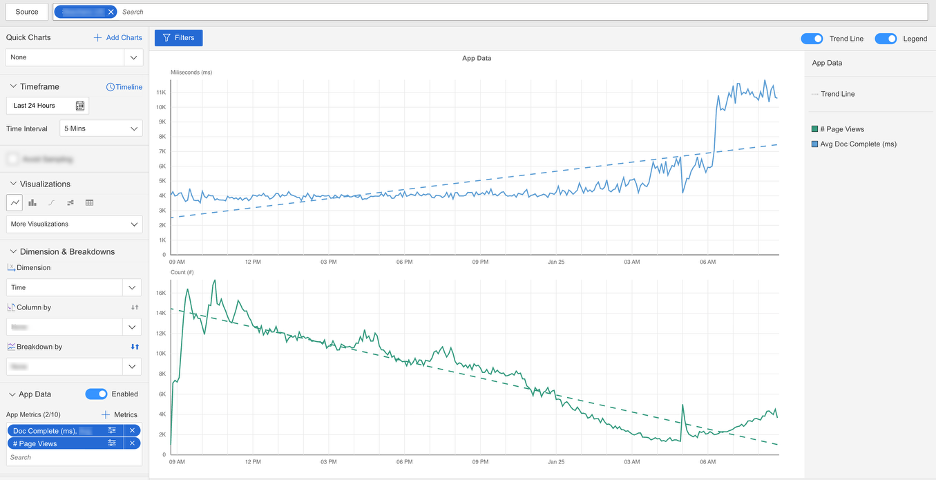

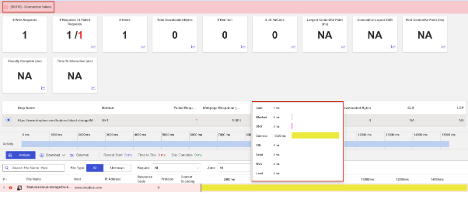

Catchpoint RUM data showed the real user impact clearly:

• 37% reduction in page views

• 24% increase in bounce rate

• Degradation across Core Web Vitals, driven entirely by third-party behavior

Takeaways

• Third-party scripts can slow down a site even when everything else is healthy.

• Synthetic and RUM monitoring help separate third-party problems from application or infrastructure issues.

• Monitoring the full Internet stack makes it clear where time is being lost, such as DNS, connection setup, or response delays.

• Internet resilience depends on limiting critical page load dependencies on external services and isolating analytics or marketing scripts when possible.

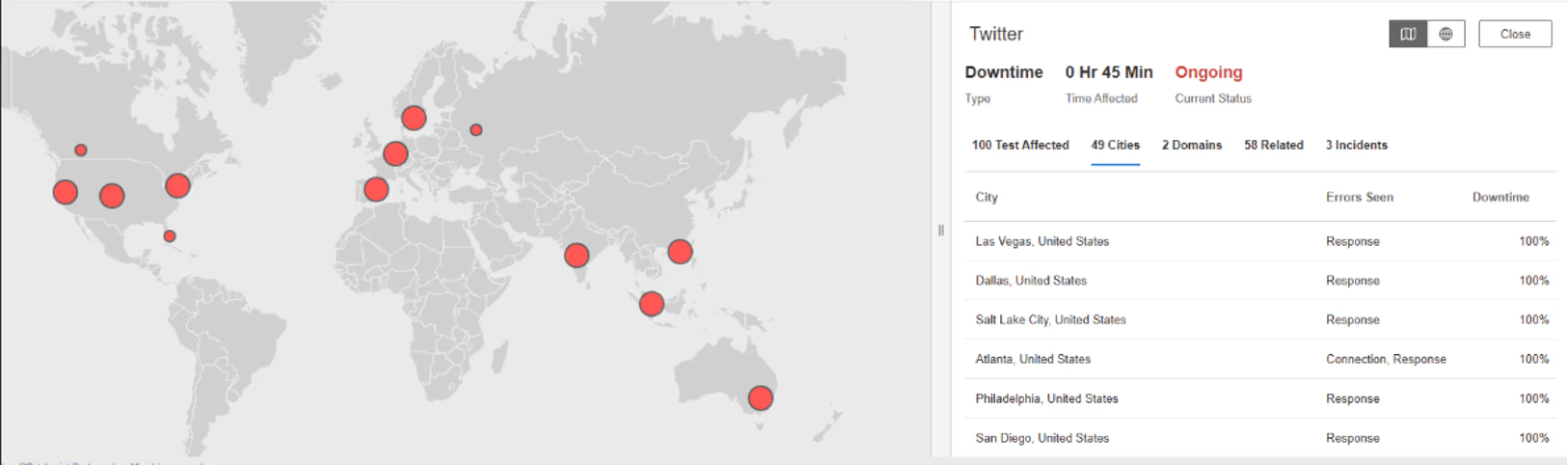

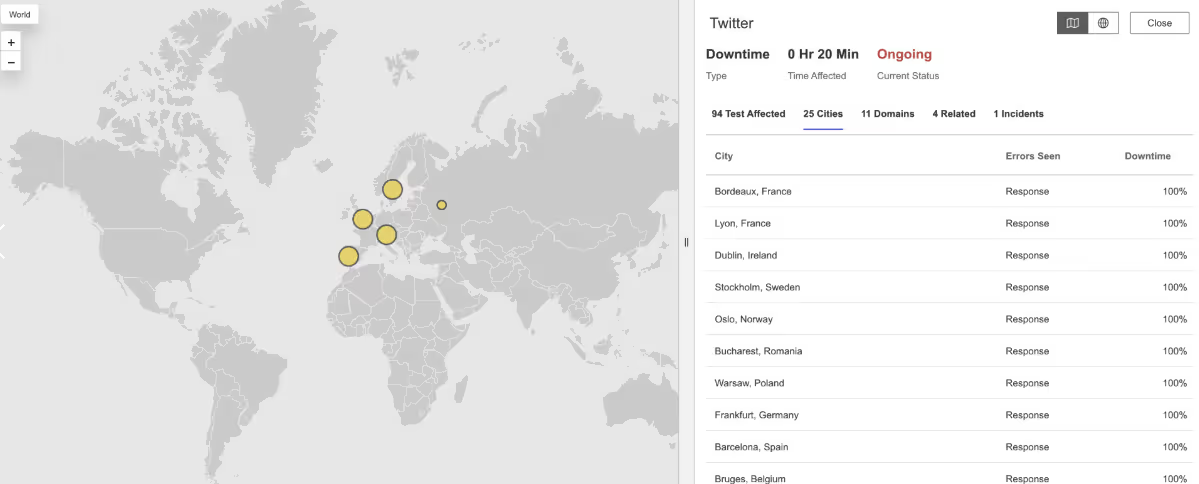

What Happened?

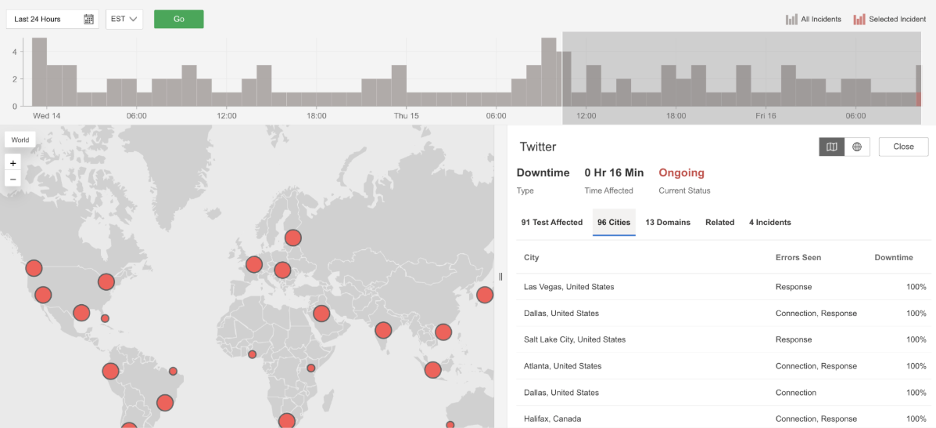

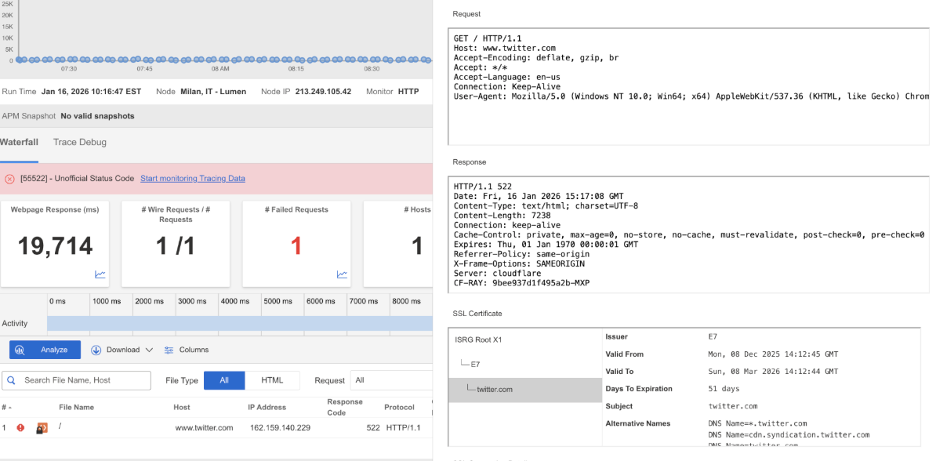

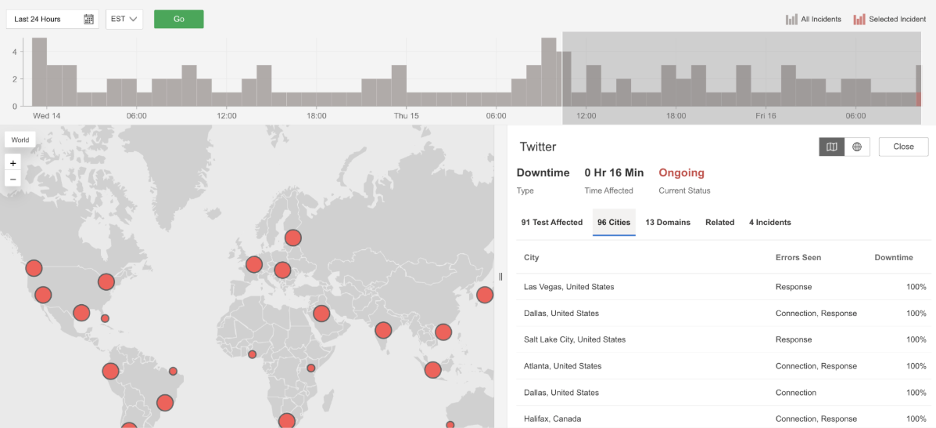

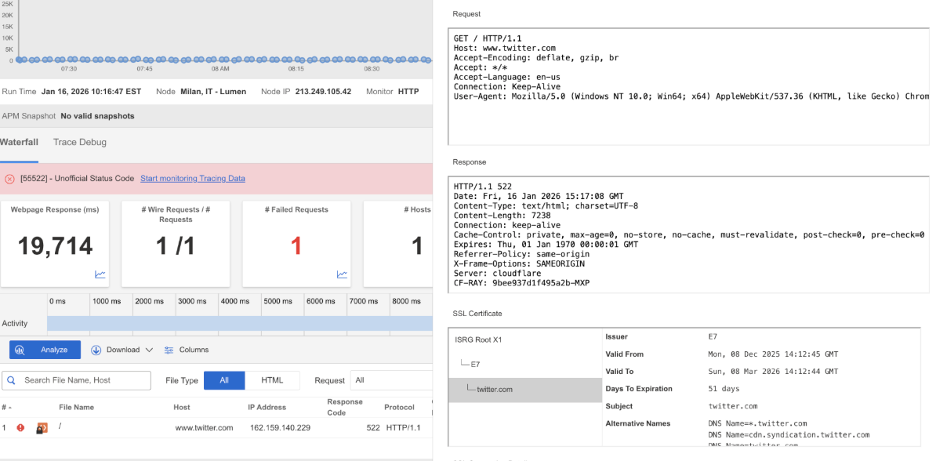

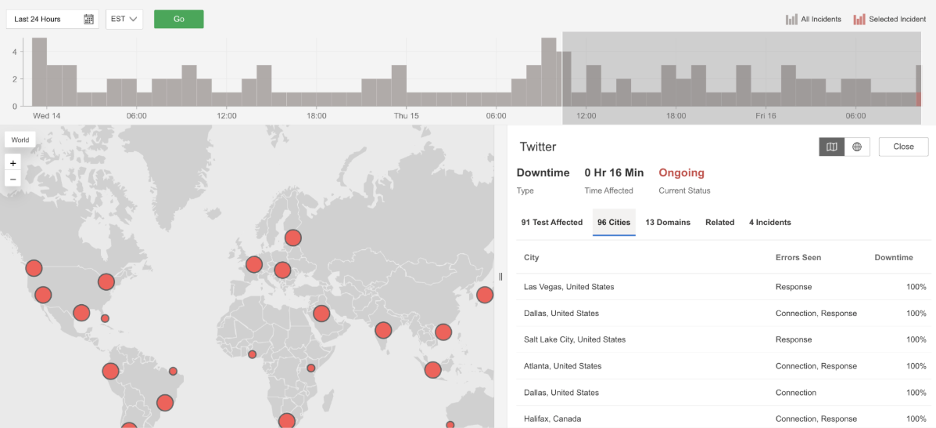

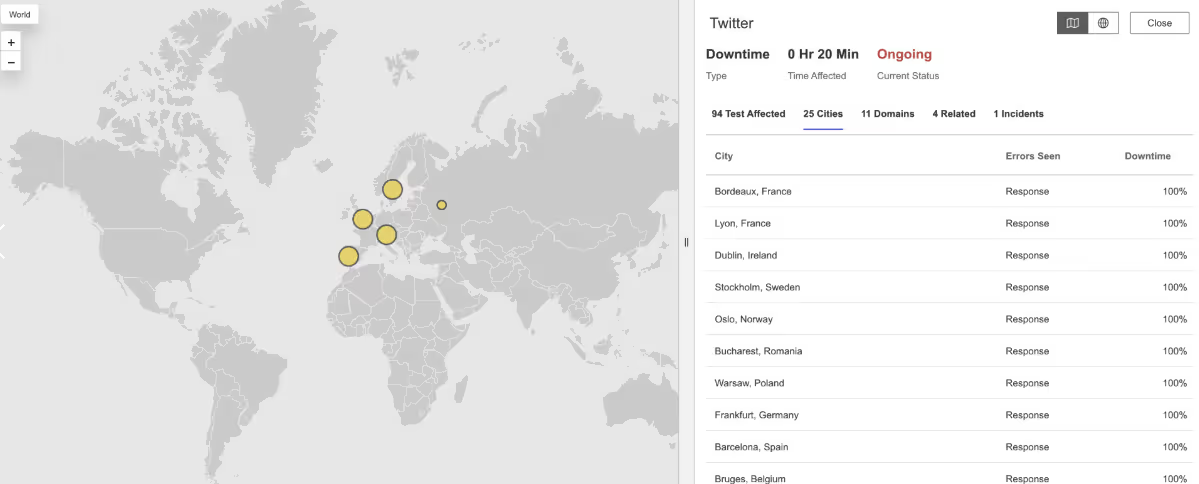

At 10:11 AM EDT, Twitter experienced a widespread service disruption affecting users across multiple regions. Many users were unable to load the platform or establish a connection at all. Requests failed with HTTP 522 (Connection Timed Out) errors, which means the network could not successfully connect to Twitter’s servers within the expected time. This pointed to a global connectivity or server-side issue rather than a problem limited to a single country or network.

Takeaways

Because connections to Twitter’s servers were timing out, users were unable to access timelines, post content, or refresh the service during the outage window. Large social platforms depend on reliable connectivity between users, networks, and backend infrastructure, and failures anywhere along that path can quickly affect millions of people. Independent, external monitoring across regions helps confirm when outages are truly global and provides visibility into whether issues stem from network routing, connectivity, or the application layer itself.

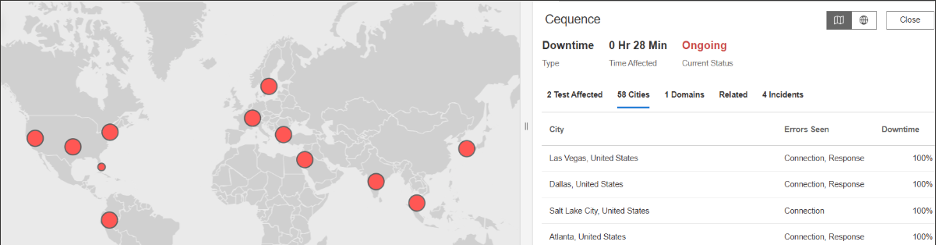

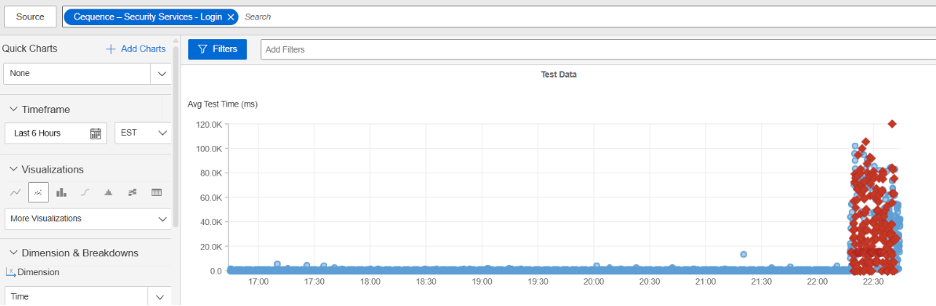

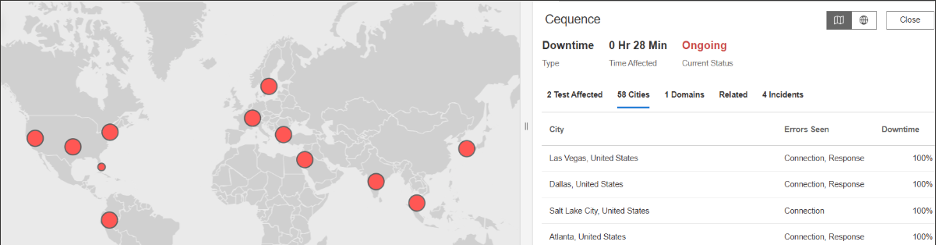

Cequence

What Happened?

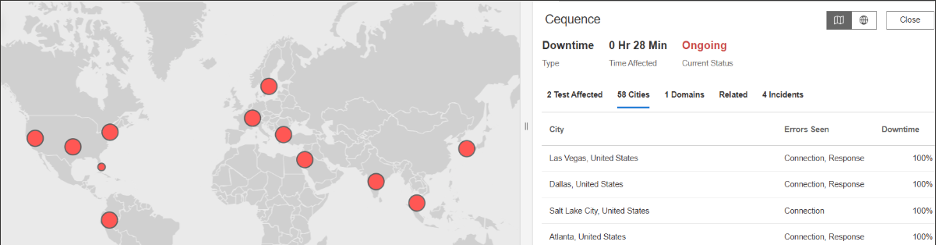

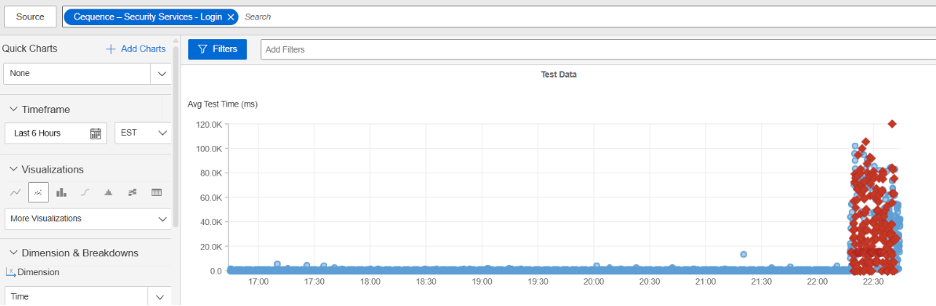

At approximately 10:17 PM EST, Cequence experienced a service disruption affecting users in multiple regions, including the United States, Poland, and France. Requests to Cequence services began failing with HTTP 504 (Gateway Timeout) errors. This means the service did not receive a response from an upstream system in time, causing requests to fail and users to experience unavailable or unresponsive services during the outage window.

Takeaways

Because Cequence relies on upstream systems to respond quickly, delays or failures in those dependencies can directly impact user access. Timeout-related outages highlight how issues in backend infrastructure or network paths can cascade into visible service failures. External, Internet Performance Monitoring (IPM) across regions helps confirm whether problems are localized or widespread and provides independent visibility into availability when internal systems are degraded.

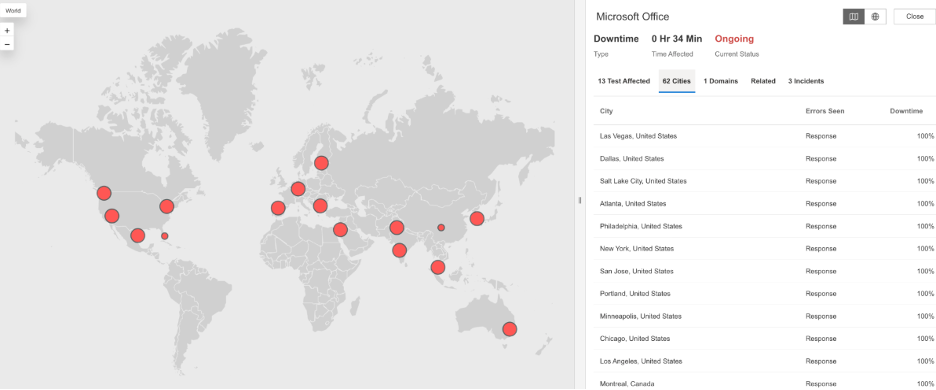

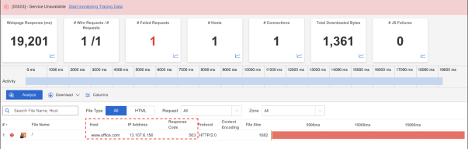

Microsoft Office

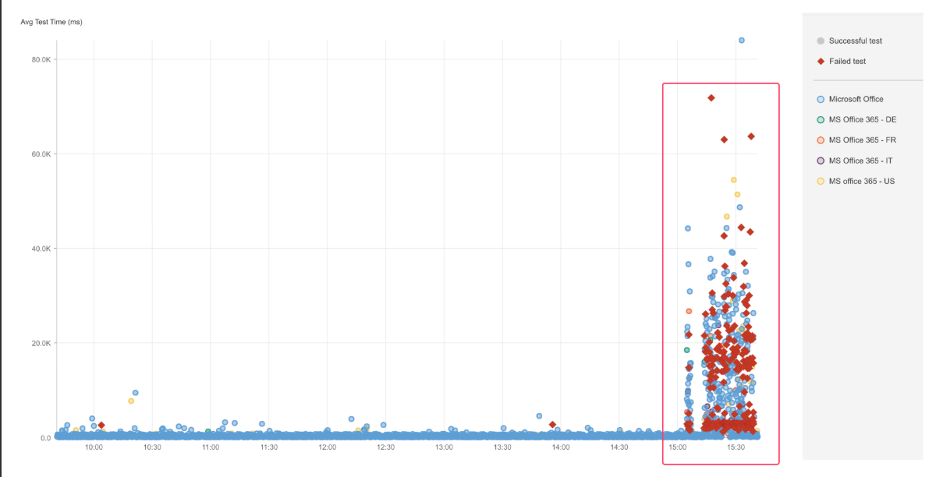

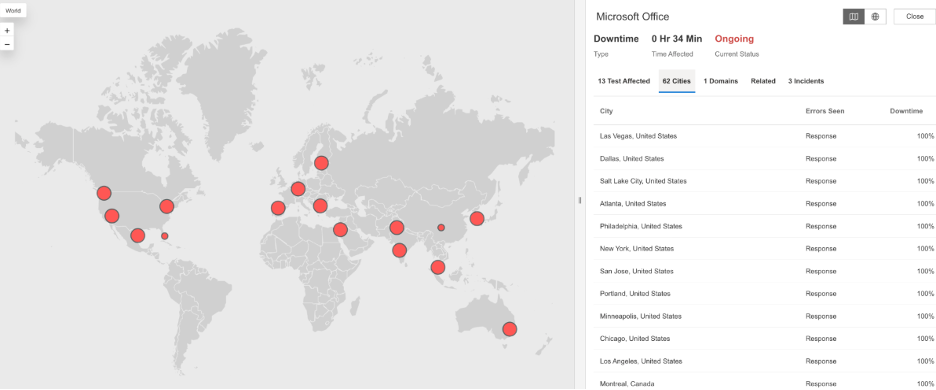

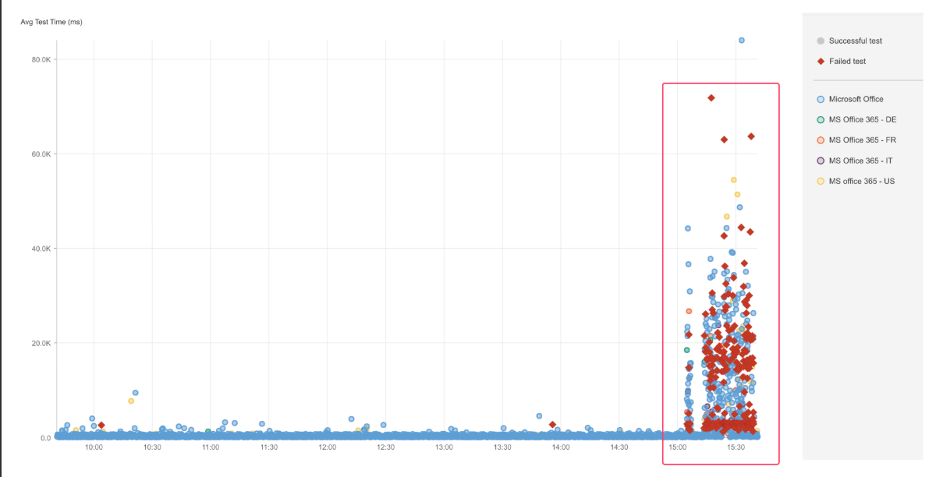

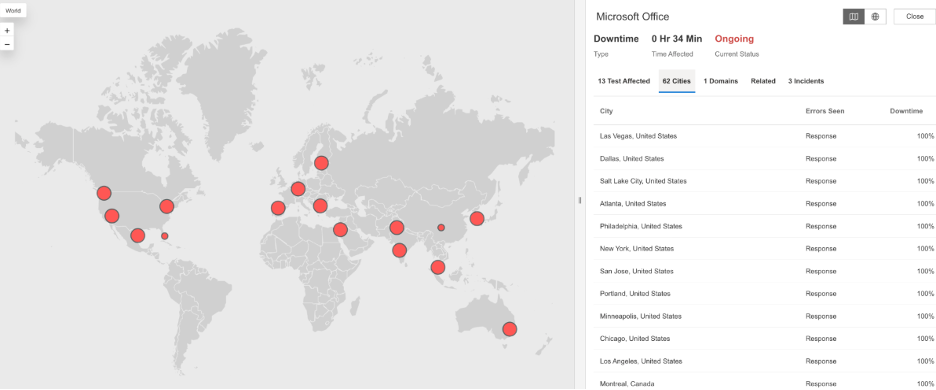

What Happened?

At 3:04 PM EST, Microsoft Office experienced a service disruption affecting users across multiple regions. Users attempting to access Office services encountered HTTP 503 (Service Unavailable) errors, which means the service was temporarily unable to handle requests. This indicated that Microsoft Office servers were either overloaded or unavailable during the outage window, preventing users from accessing Office applications and services.

Takeaways

Because Microsoft Office services were unavailable, users were unable to access productivity tools they rely on for daily work. Even short periods of unavailability can have outsized effects when widely used cloud applications are involved. Monitoring availability from multiple global locations helps confirm whether issues are regional or widespread, while visibility across the application and delivery layers helps teams understand whether failures stem from server capacity, upstream dependencies, or broader Internet connectivity problems.

Business Insider

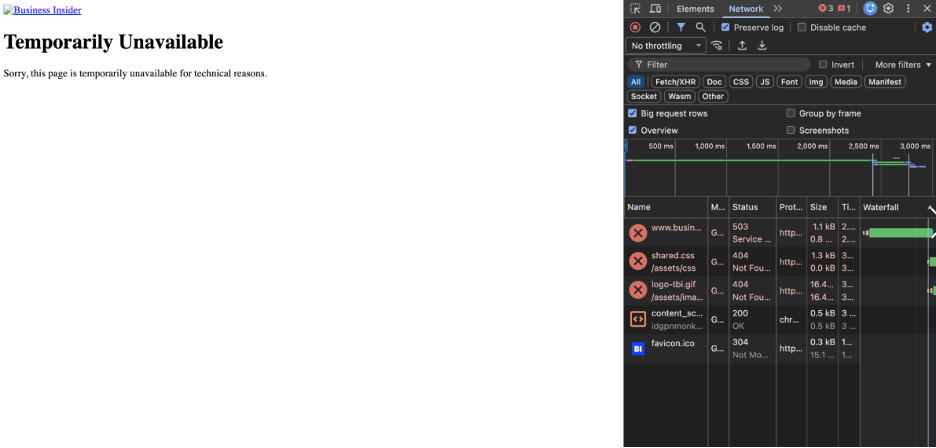

What Happened?

At 2:20 AM EST, Business Insider experienced a service disruption affecting users in North America. Users attempting to load articles were met with HTTP 503 (Service Unavailable) errors, which means the website’s servers were temporarily unable to handle requests. As a result, pages failed to load and the service was unavailable during the outage window.

Takeaways

Because Business Insider’s servers could not respond to requests, readers were unable to access news content when they needed it. For media and publishing sites, availability is critical, especially during breaking news cycles. External monitoring from multiple locations helps confirm when outages are affecting real users, while visibility into the application and delivery layers helps teams determine whether failures are caused by server capacity issues, backend dependencies, or broader connectivity problems.

Square

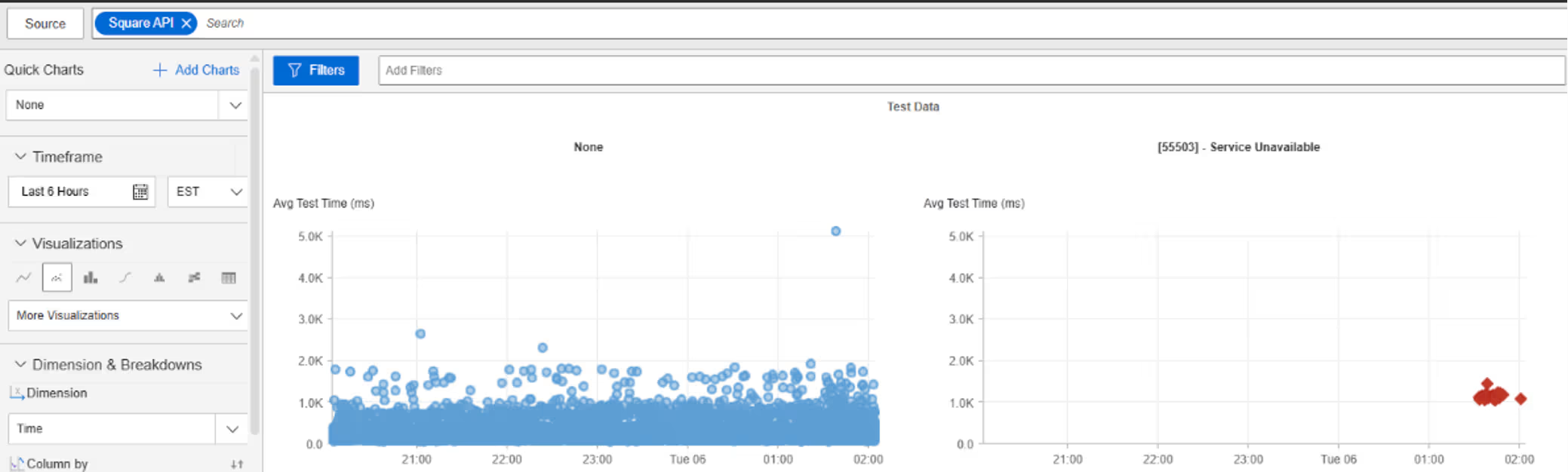

What Happened?

At around 1:33 AM EST, Square experienced a service disruption affecting users across several European countries. Users attempting to access Square services encountered HTTP 503 (Service Unavailable) errors, which means Square’s servers were temporarily unable to handle incoming requests. As a result, services were unavailable or unresponsive during the outage window.

Takeaways

Widespread HTTP 503 errors indicate that Square’s application layer was reachable but unable to serve requests, pointing to server-side capacity, internal failures, or upstream service dependencies rather than Internet reachability issues. For transaction-driven platforms, this underscores how failures within the application and dependency stack can immediately translate into user-visible downtime. From an SRE perspective, Internet Performance Monitoring (IPM) helps validate that the Internet path remains healthy while availability degrades, narrowing the blast radius to the service itself. Correlating regional error rates with latency and availability metrics helps teams confirm whether failures are caused by backend saturation, rollout issues, or cascading dependency failures, reducing time spent chasing non-relevant network or routing signals.

December

Traveltriangle

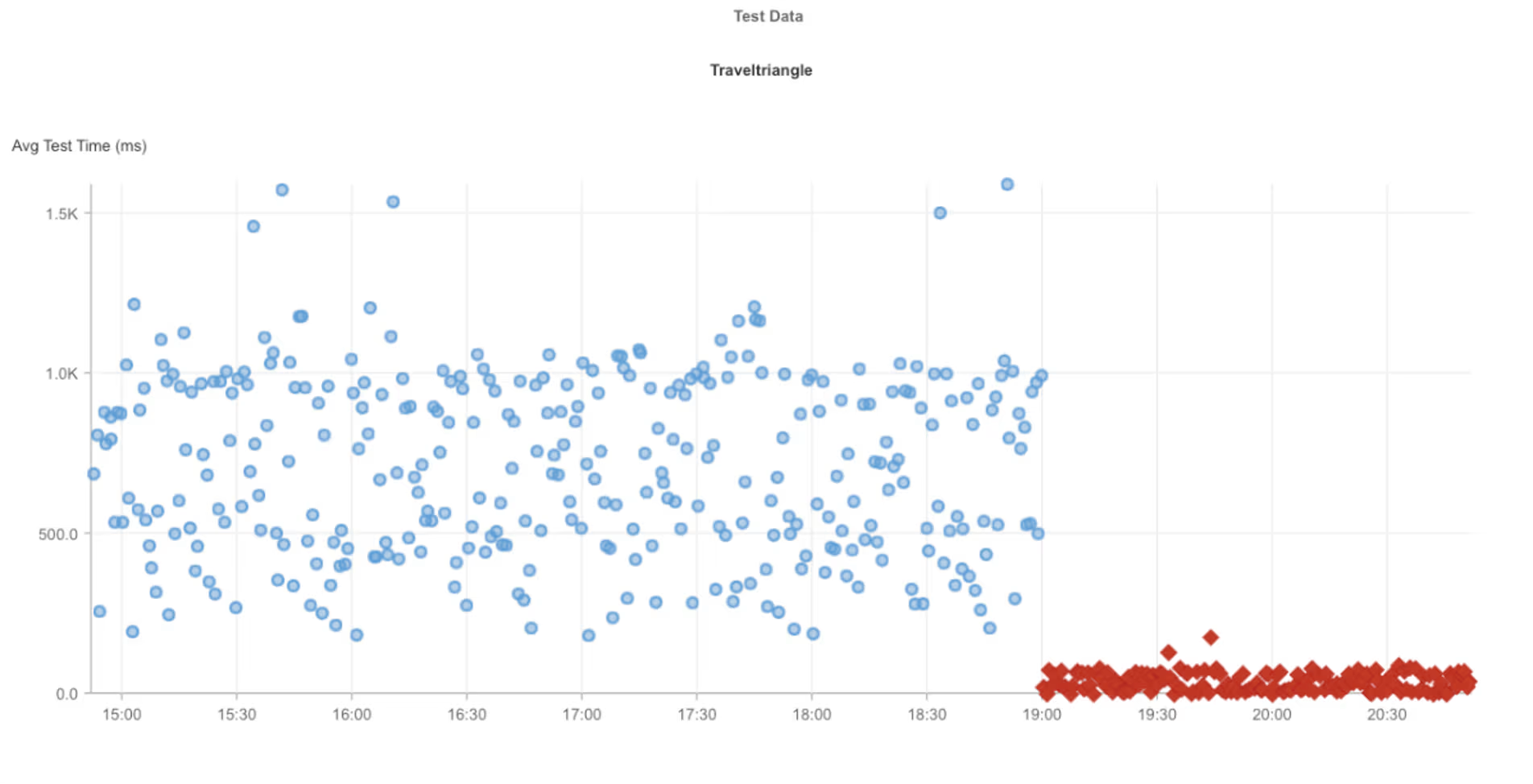

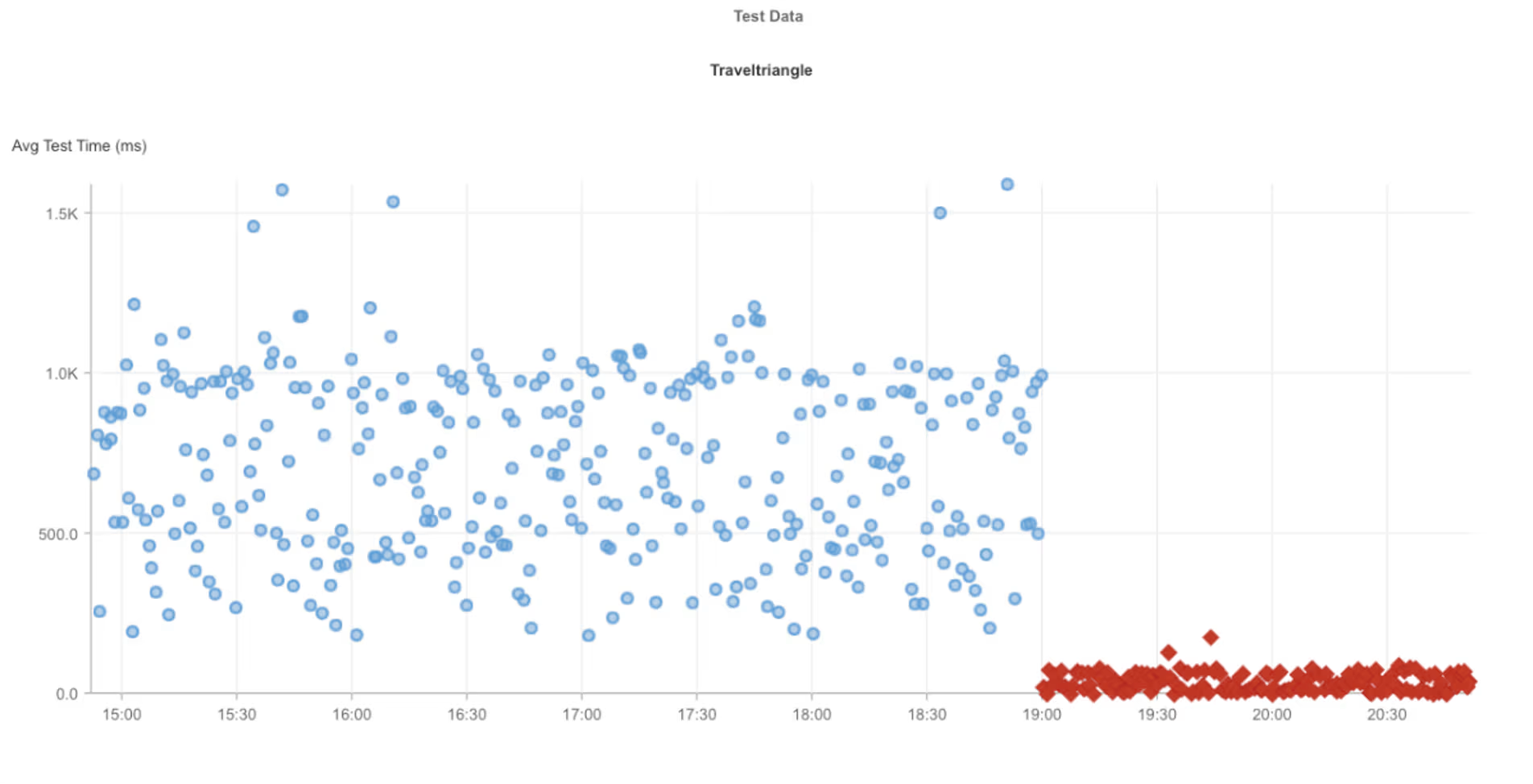

What Happened?

At around 7:00 PM EST, Traveltriangle experienced a service disruption affecting users in North America. Requests to the Traveltriangle website failed due to SSL certificate validation errors, caused by an expired SSL certificate. This means user browsers could not establish a secure HTTPS connection, resulting in blocked access and service unavailability during the outage window.

Takeaways

An expired SSL certificate is a single-point failure that can immediately render a service inaccessible, even when the underlying application and infrastructure are otherwise healthy. From an SRE perspective, this highlights the importance of monitoring TLS/SSL certificate validity as part of external availability checks, not just application uptime. Internet Performance Monitoring (IPM) helps confirm that failures occur during connection setup rather than deeper in the request lifecycle, allowing teams to quickly rule out application bugs or network path issues. Proactive certificate lifecycle monitoring and alerting are critical for preventing avoidable, user-visible outages caused by expiring security dependencies.

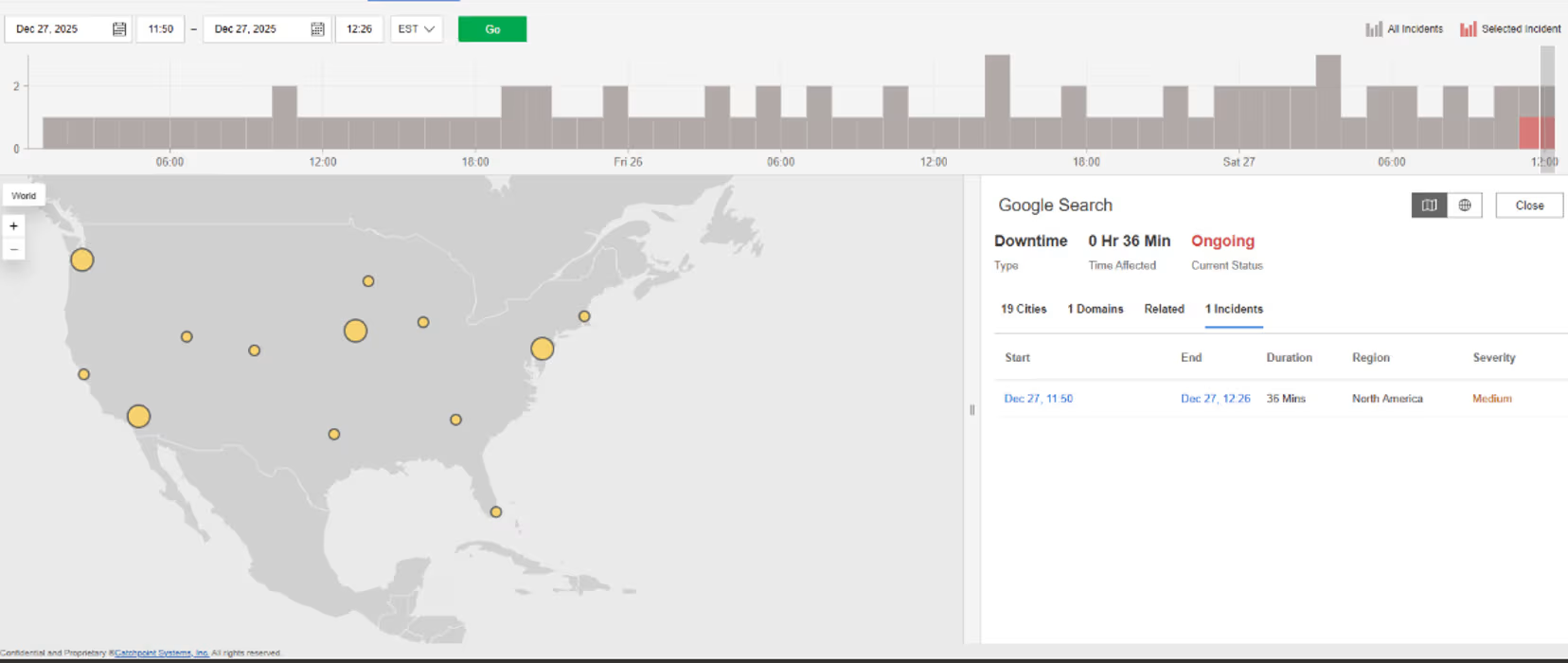

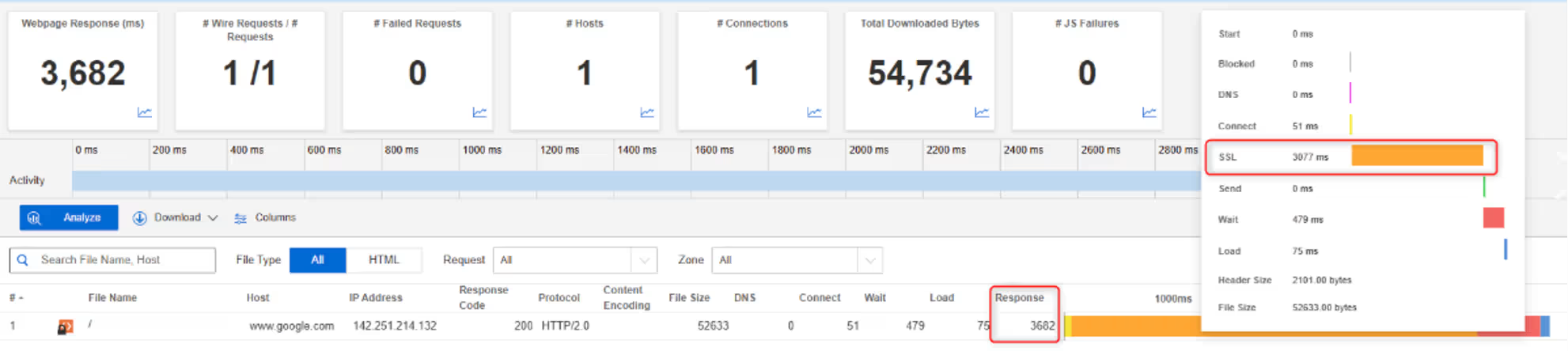

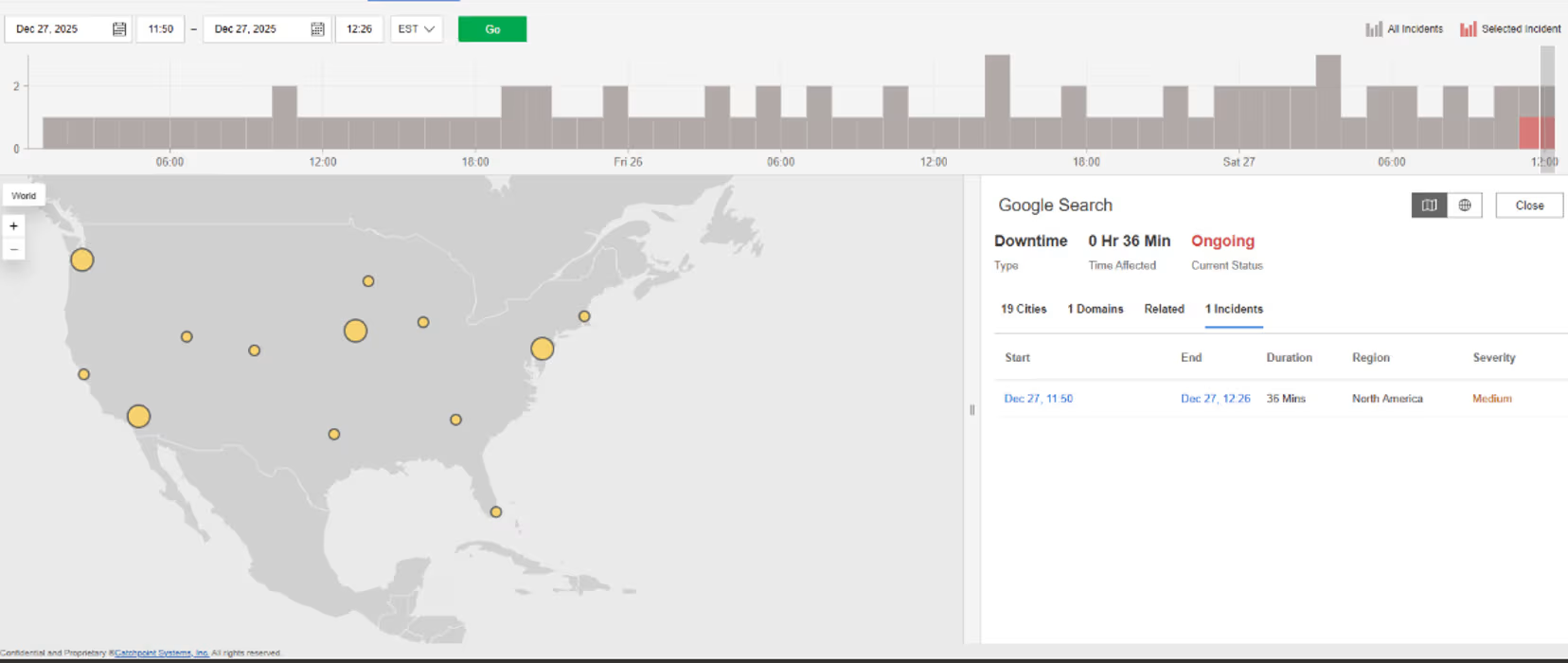

Google Search

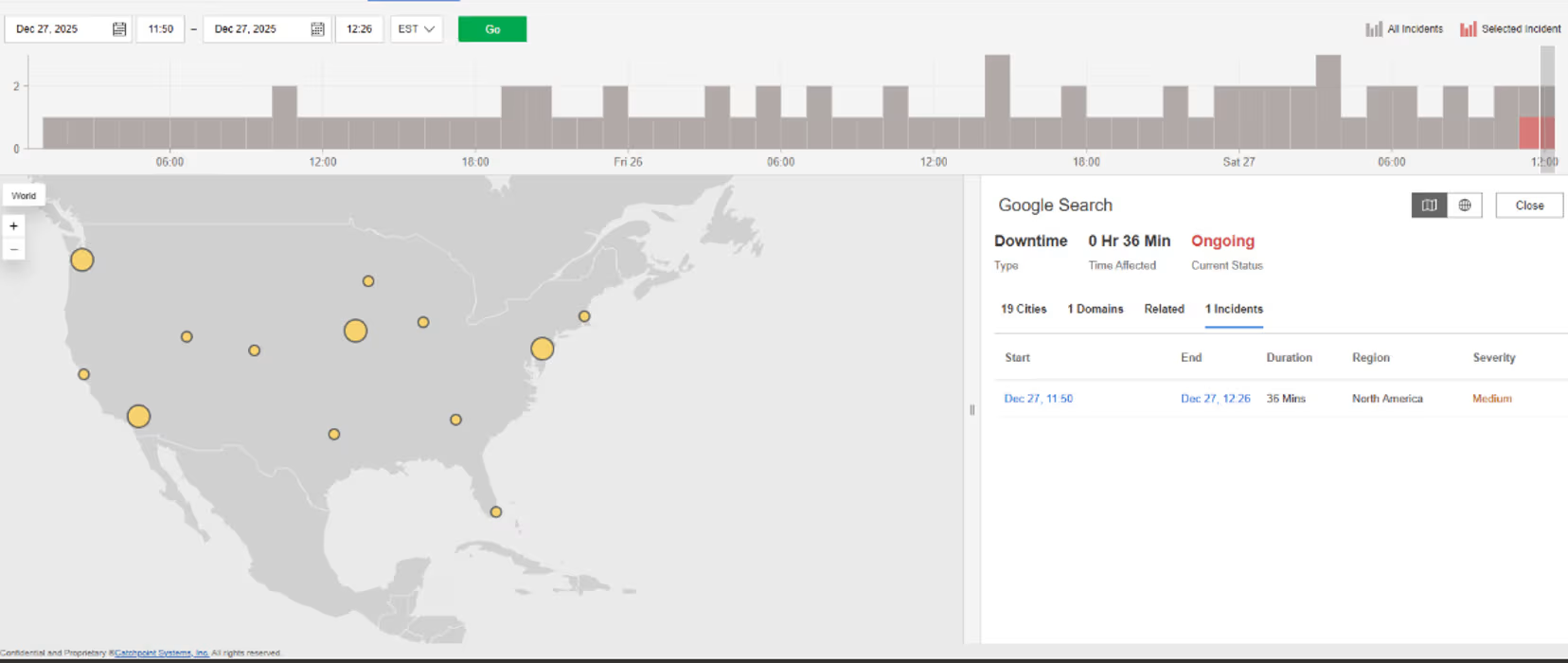

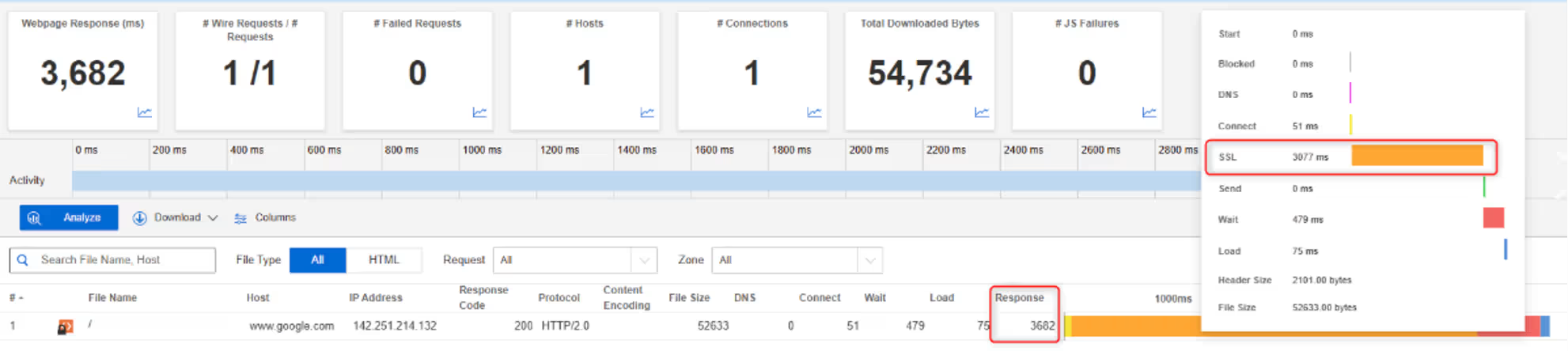

What Happened?

At around 11:50 AM EDT, Google Search experienced degraded performance affecting users across North America. Requests to Google Search did not fail outright but showed elevated response times, driven largely by SSL/TLS delays during connection setup. This means secure connections were taking significantly longer than normal to establish, resulting in slow search responses during the outage window.

Takeaways

When SSL/TLS negotiation becomes slow, users experience degraded performance even though the service remains technically available. This type of issue sits between network reachability and application execution, making it easy to misclassify without detailed visibility. From an SRE perspective, Internet Performance Monitoring (IPM) helps break down where time is spent in the request lifecycle, distinguishing TLS handshake delays from server processing time. Monitoring SSL performance alongside overall availability allows teams to detect security-layer bottlenecks early and avoid prolonged “brownout” conditions where services are up but feel slow or unreliable to users.

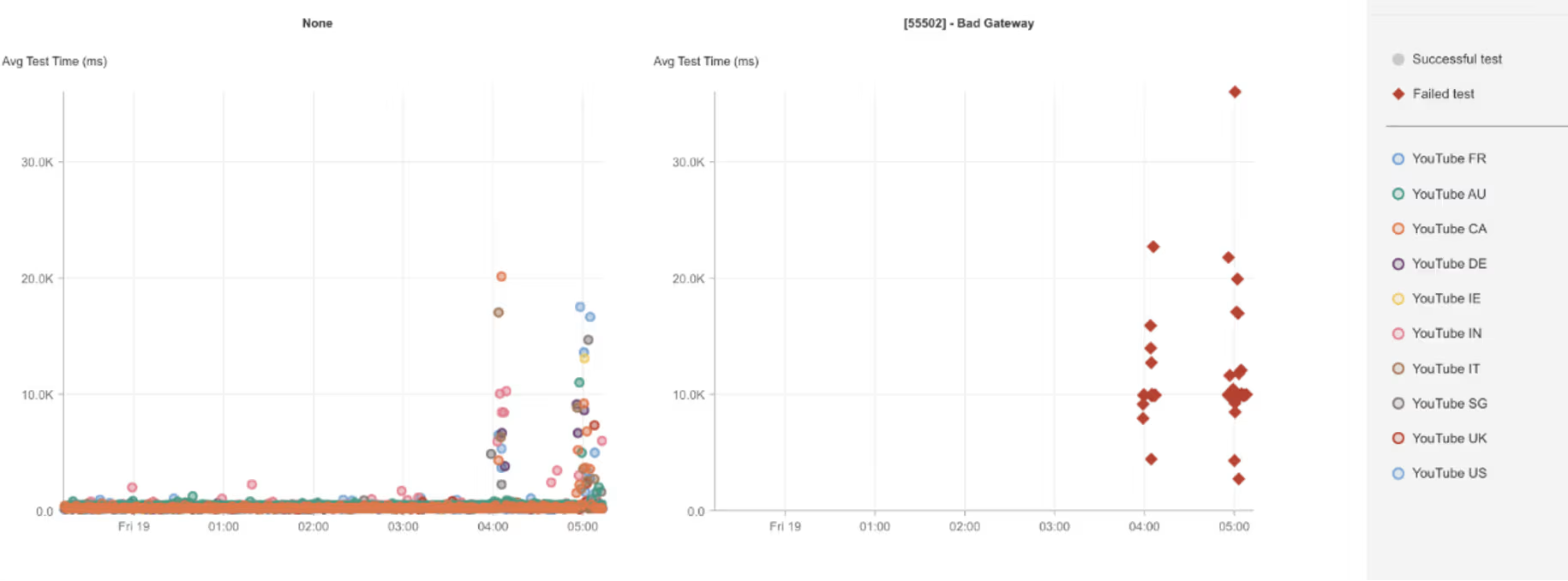

Google Maps & Google Search

What Happened?

At around 7:11 AM EST, Google experienced service disruptions affecting multiple consumer services. In North America, users of Google Maps and Google Search encountered degraded performance and request failures. Requests failed with HTTP 502 (Bad Gateway) errors, which means one service received an invalid response from an upstream system it depends on. This pointed to instability within Google’s internal service chain rather than a full loss of Internet connectivity.

Takeaways

HTTP 502 errors surfacing across multiple Google services suggest a failure within a shared backend dependency or control plane, rather than isolated application bugs. Even at Google’s scale, tight coupling between internal services can expand the blast radius when a core dependency becomes unstable. This incident illustrates how multi-tenant backend components can create correlated failures across products that appear independent at the user level. Tracking error type, timing, and geographic scope together helps distinguish edge-level issues from deeper dependency failures, and reinforces the value of understanding how shared internal services affect externally visible reliability.

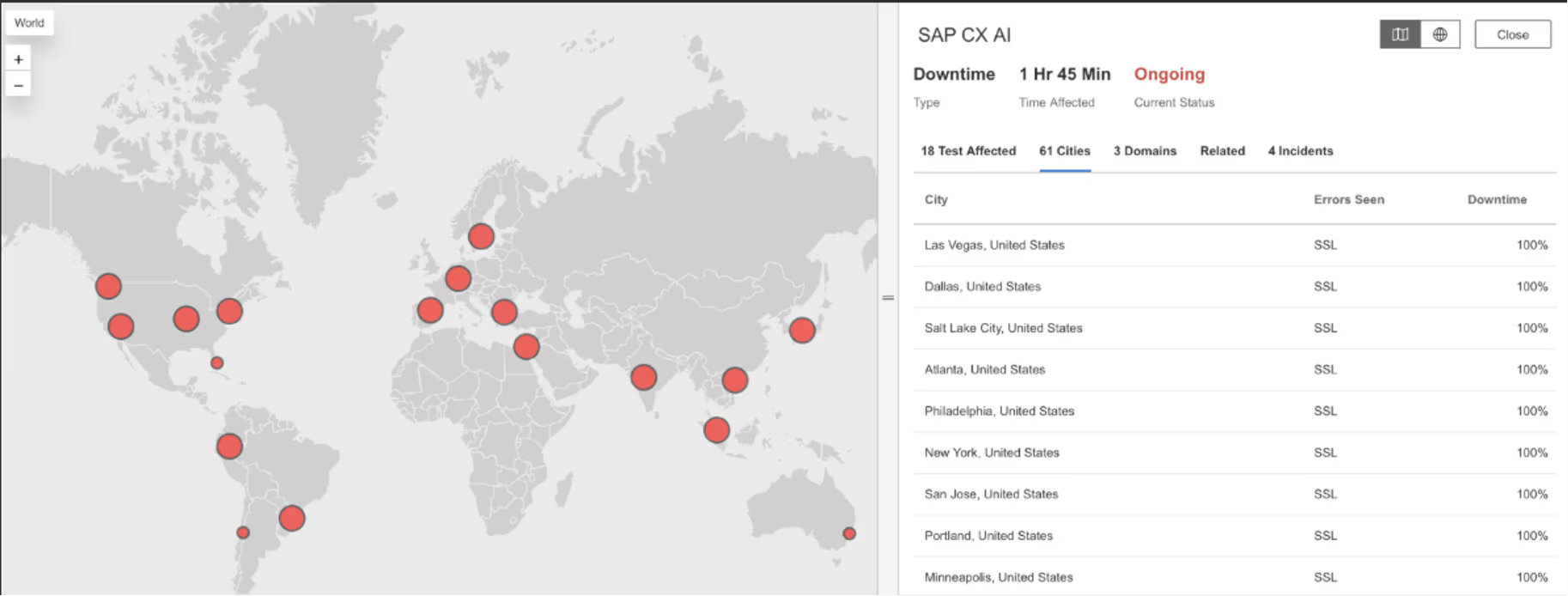

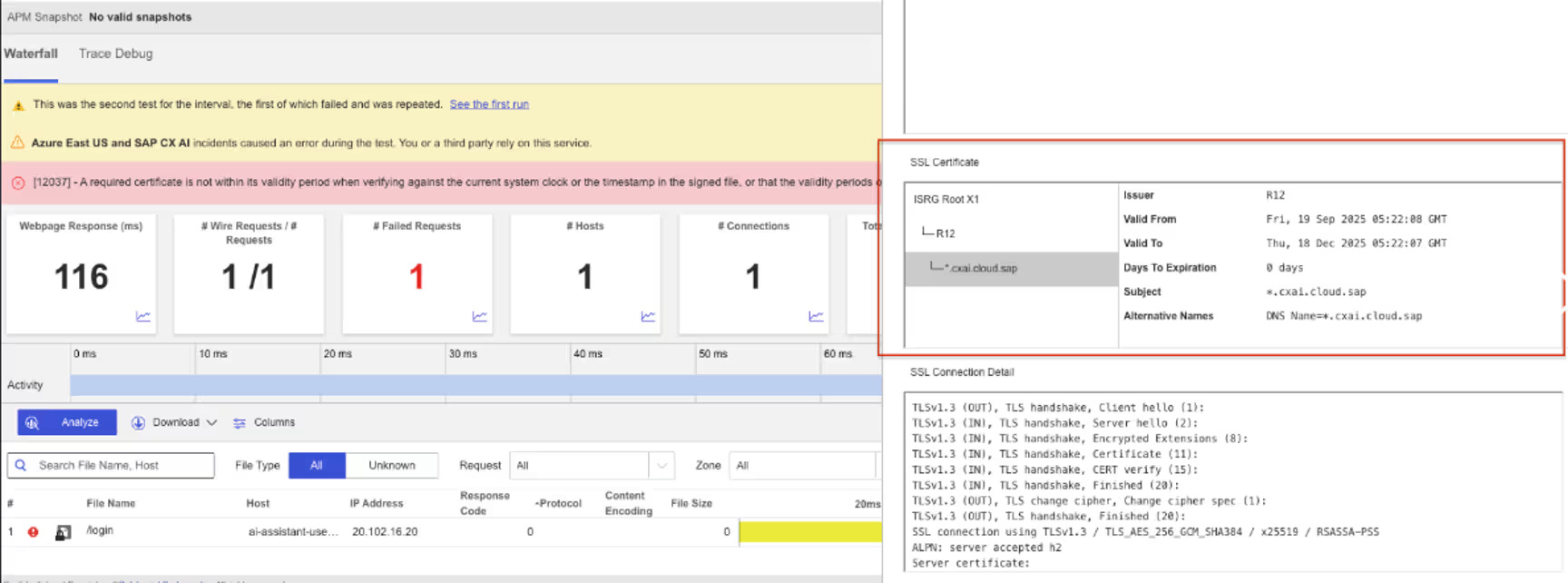

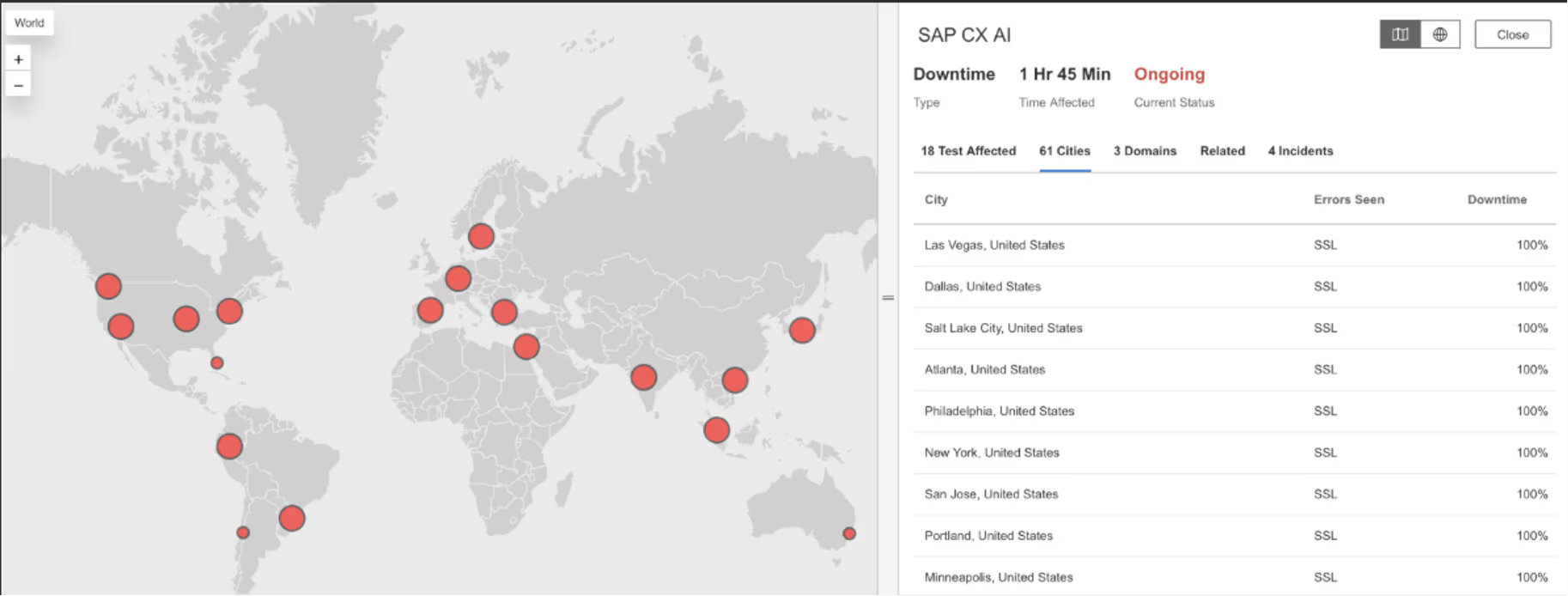

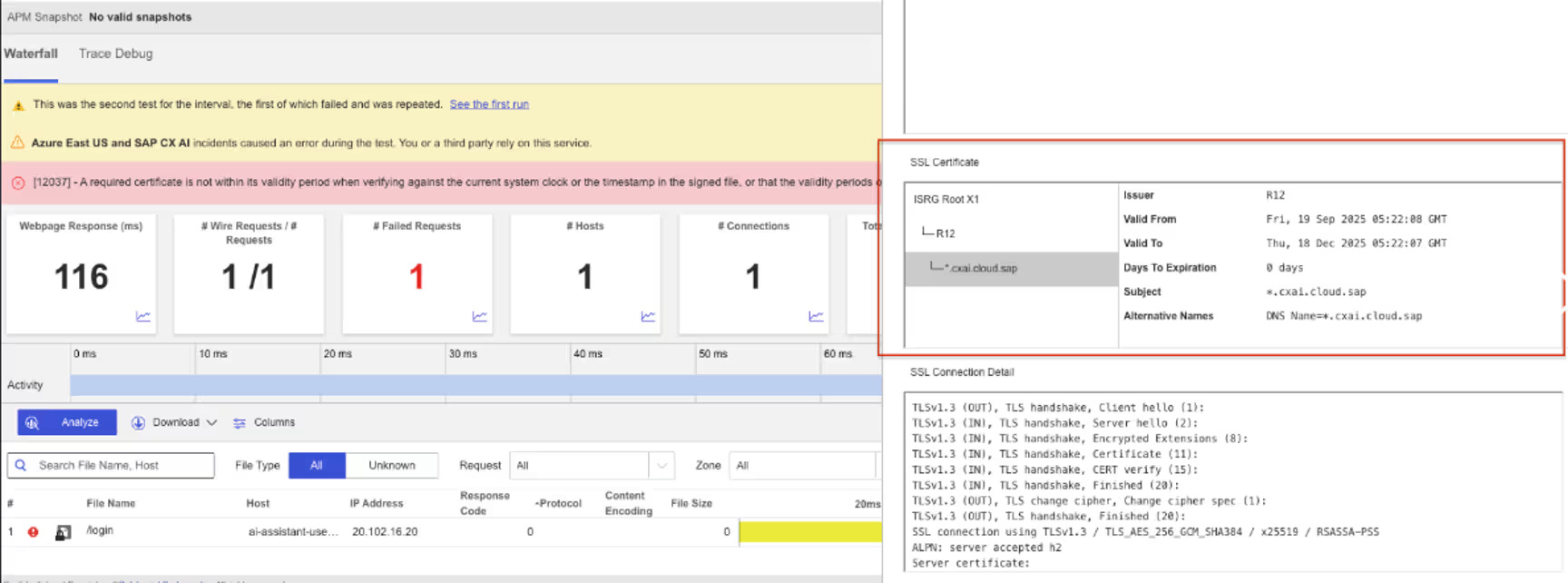

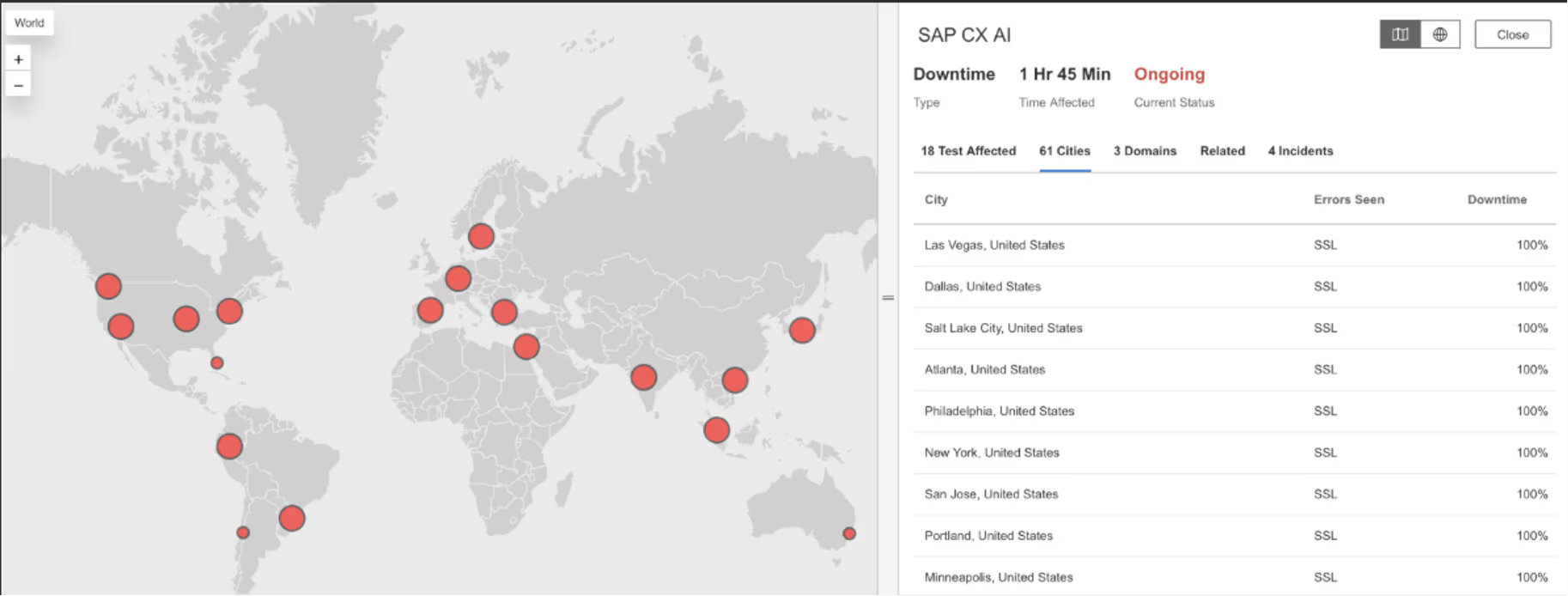

SAP CX AI

What Happened?

Between approximately 12:22 AM and 2:09 AM EST, SAP CX AI experienced a service disruption affecting users across multiple global regions. Requests to SAP CX AI services failed due to SSL/TLS errors, meaning secure connections could not be established successfully. The issue impacted multiple SAP CX AI service endpoints, resulting in widespread service unavailability during the outage window.

Takeaways

SSL/TLS failures can take down services instantly and globally, regardless of application health, because they occur before any request reaches the application layer. This incident highlights how certificate management and cryptographic dependencies represent high-impact, low-tolerance failure points in modern SaaS platforms. When multiple endpoints fail simultaneously due to SSL errors, it often indicates a shared certificate, trust chain, or configuration dependency, increasing blast radius across regions and services. Continuous validation of TLS handshakes and certificate expiry from outside the provider’s environment helps surface these issues early, before they block all user access and escalate into prolonged, global outages.

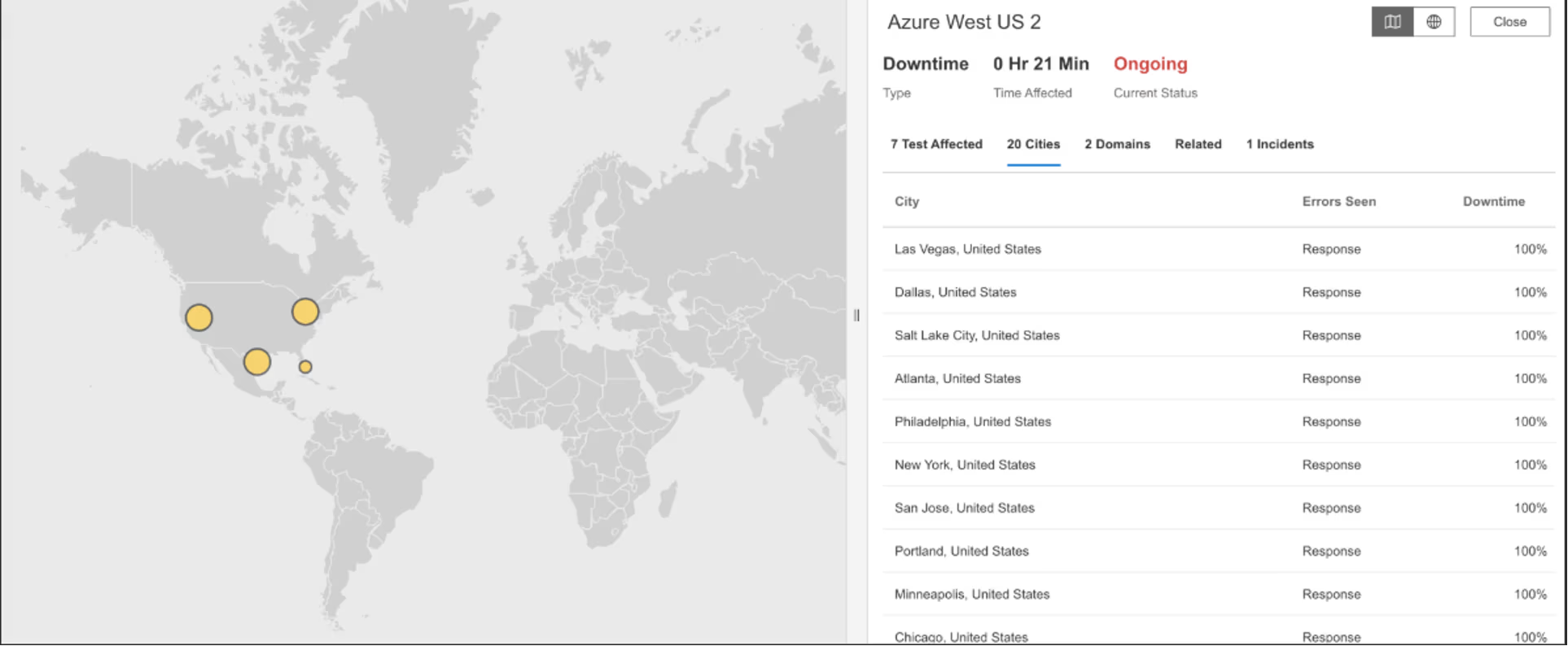

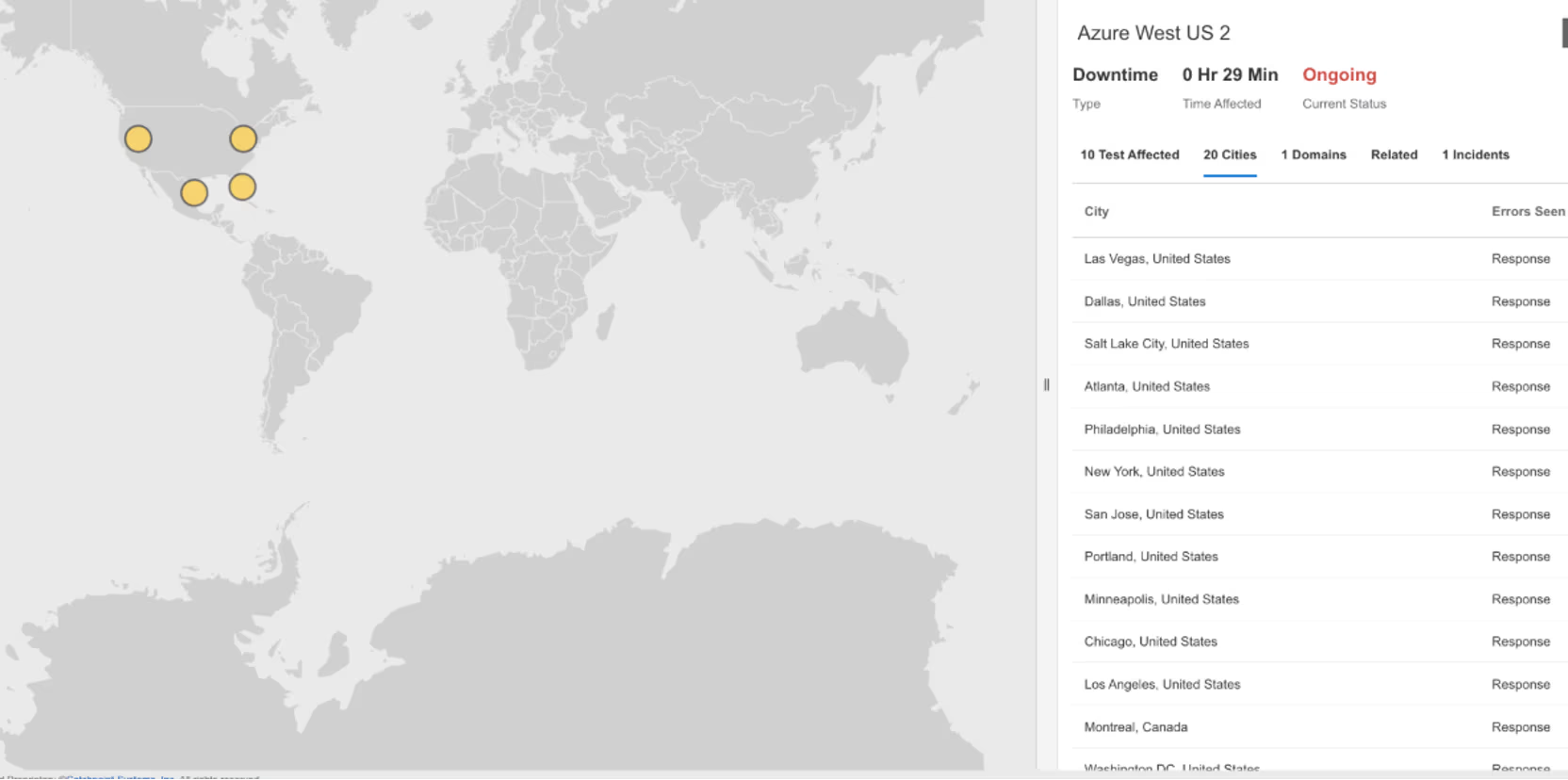

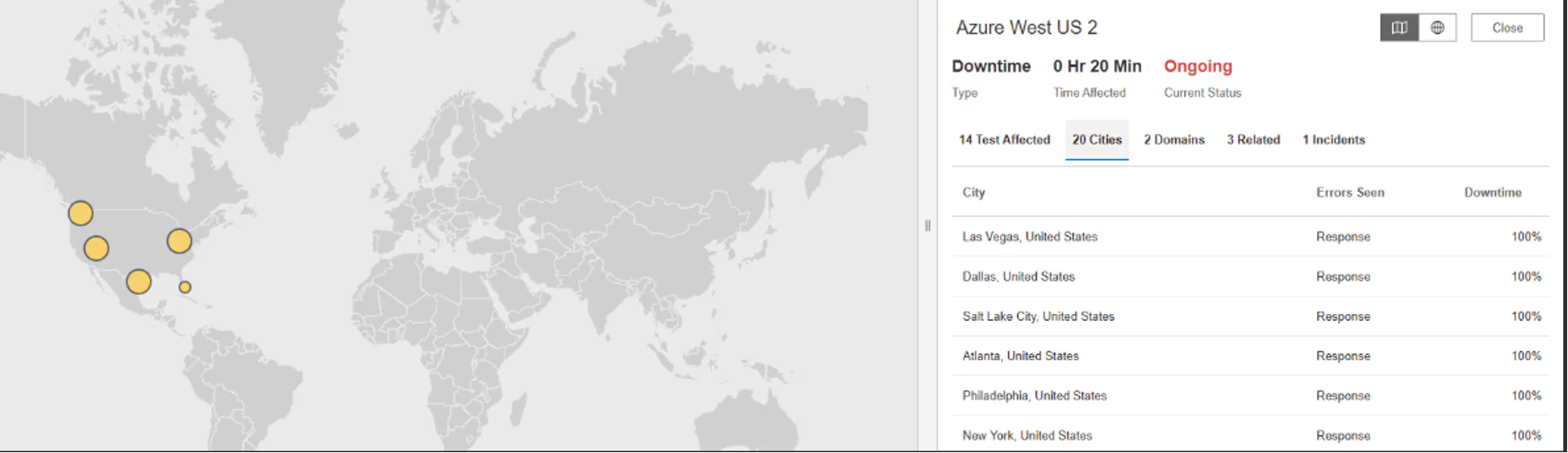

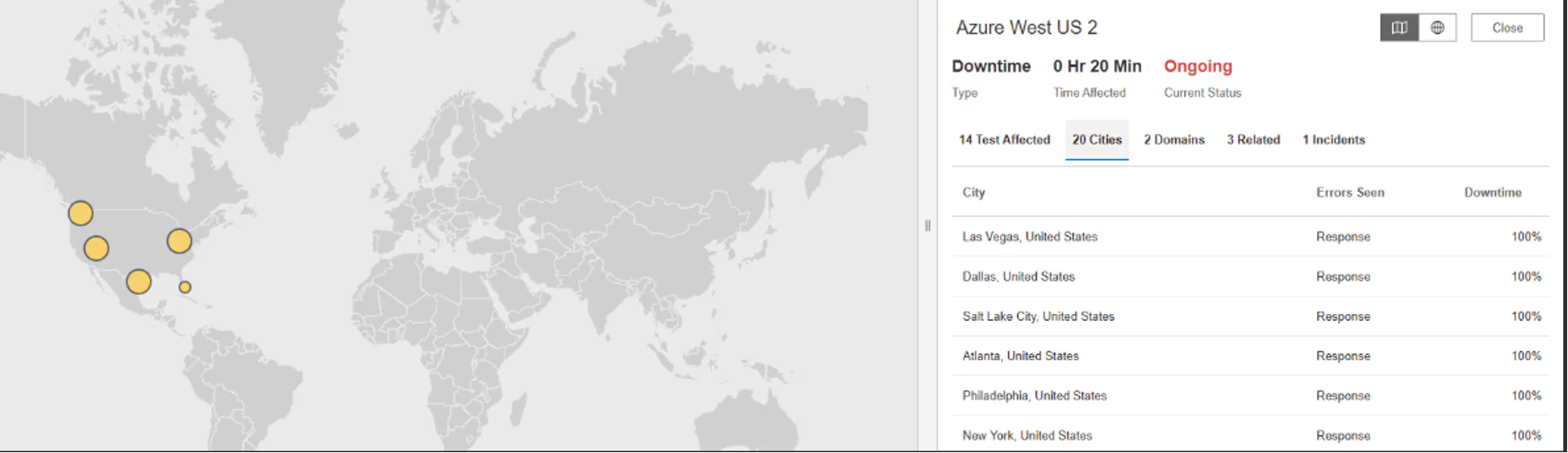

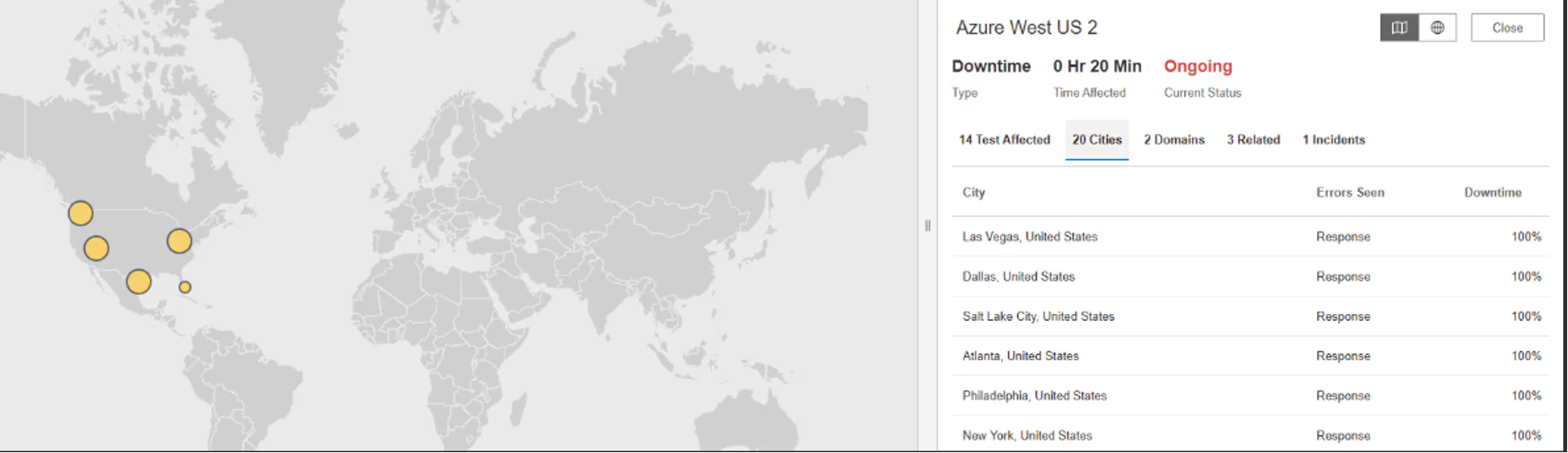

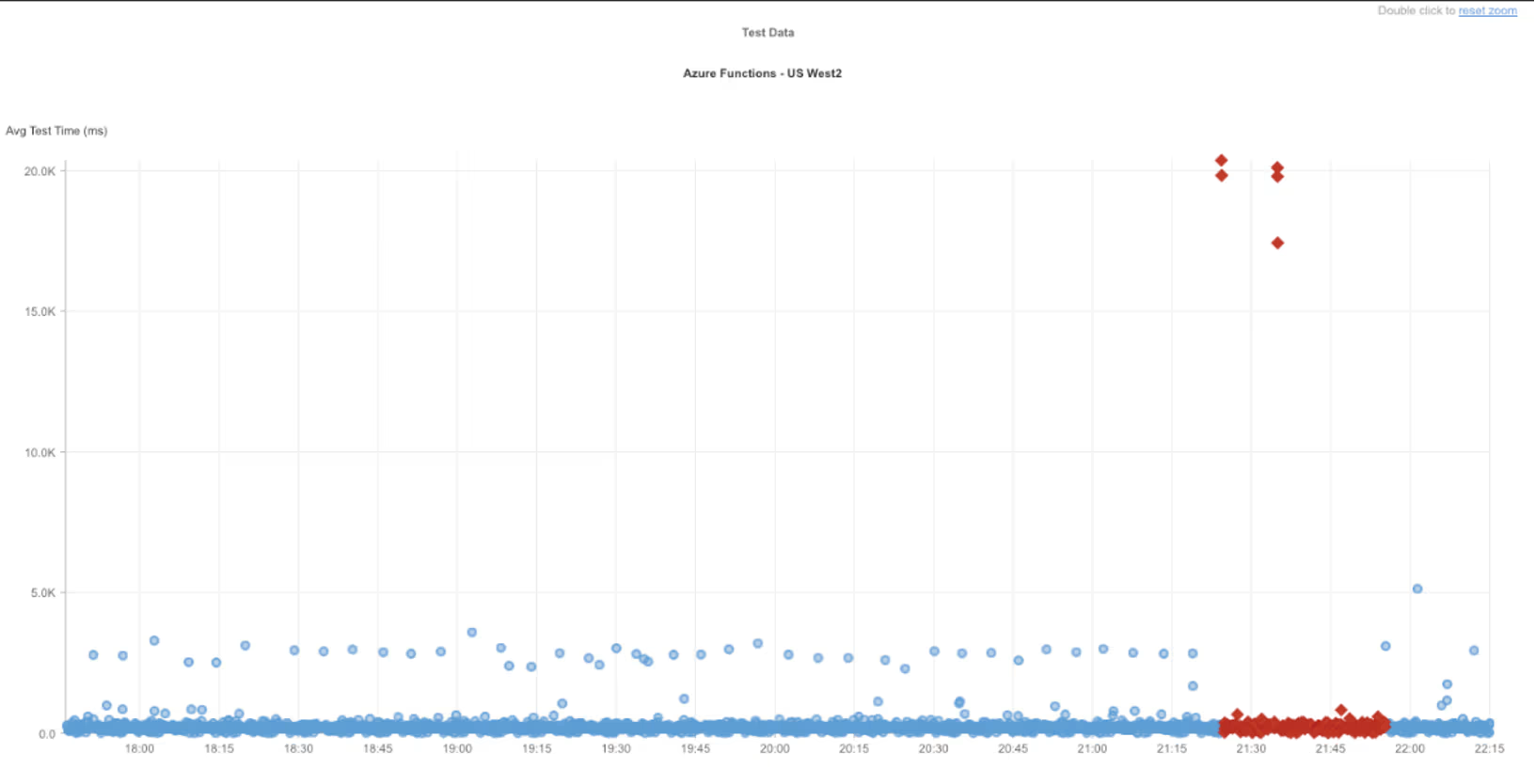

Azure West US 2

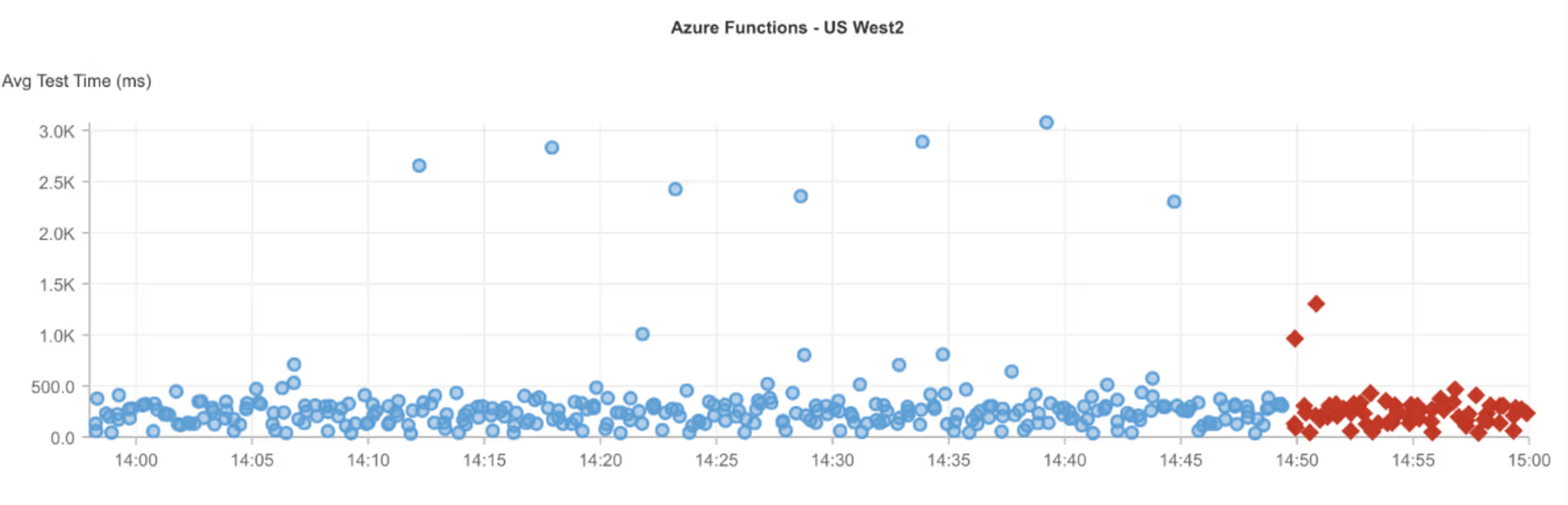

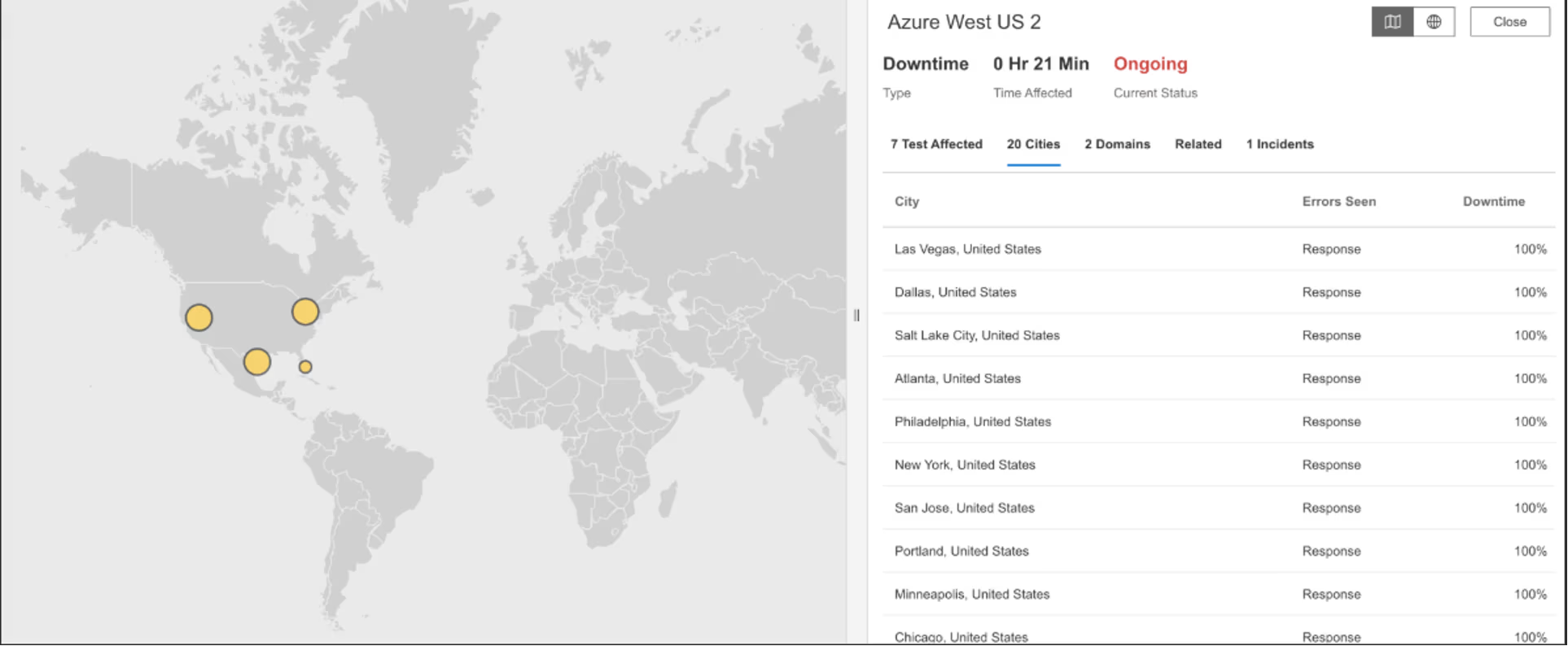

What Happened?

At around 2:49 PM EST, services hosted in the Azure West US 2 region experienced a disruption affecting users in North America. Requests to Azure-hosted applications began returning HTTP 503 (Service Unavailable) errors, which means the servers were temporarily unable to process requests. This indicated a regional service issue within Azure West US 2, resulting in reduced availability during the outage window.

Takeaways

Regional HTTP 503 errors highlight the risks of single-region dependency, even within highly resilient cloud platforms. When a cloud region experiences capacity pressure or internal service instability, workloads that are not actively distributed across regions can become unavailable despite the broader platform remaining healthy. This event underscores the importance of regional isolation strategies, such as multi-region deployments and failover testing, for applications with availability requirements. Observing failures confined to a single cloud region helps distinguish regional infrastructure issues from application bugs or Internet-wide problems, enabling faster scoping and response during cloud provider incidents.

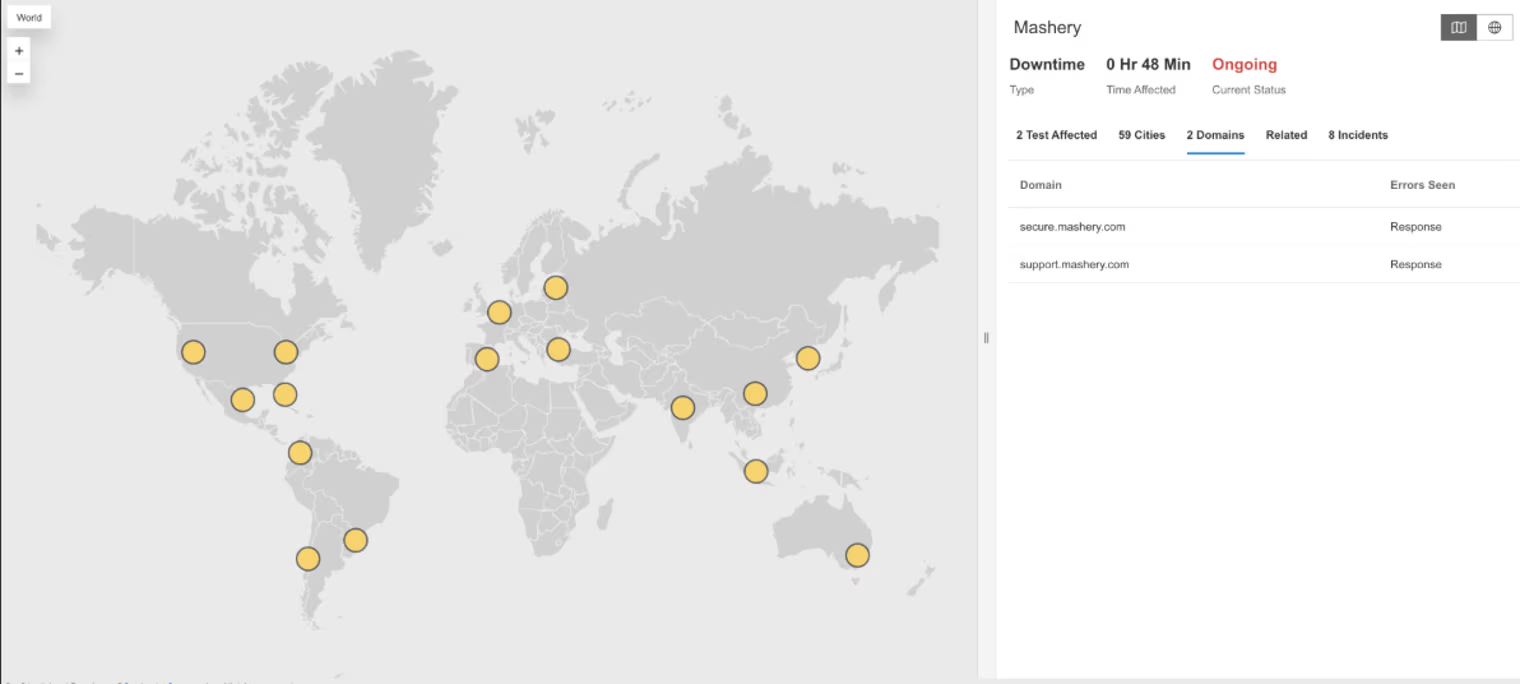

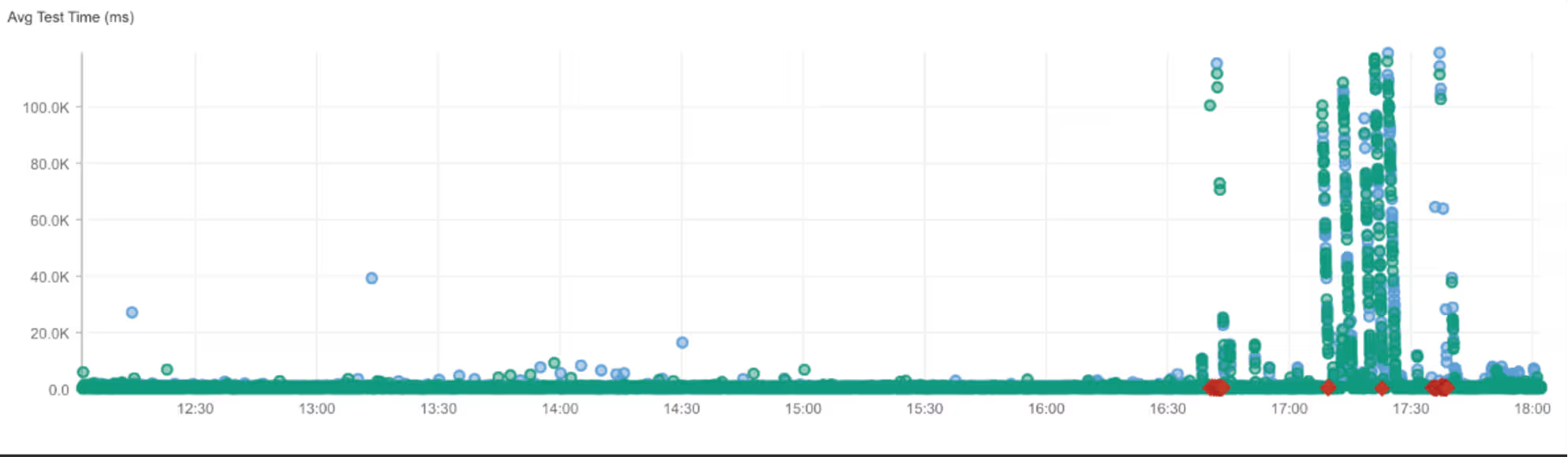

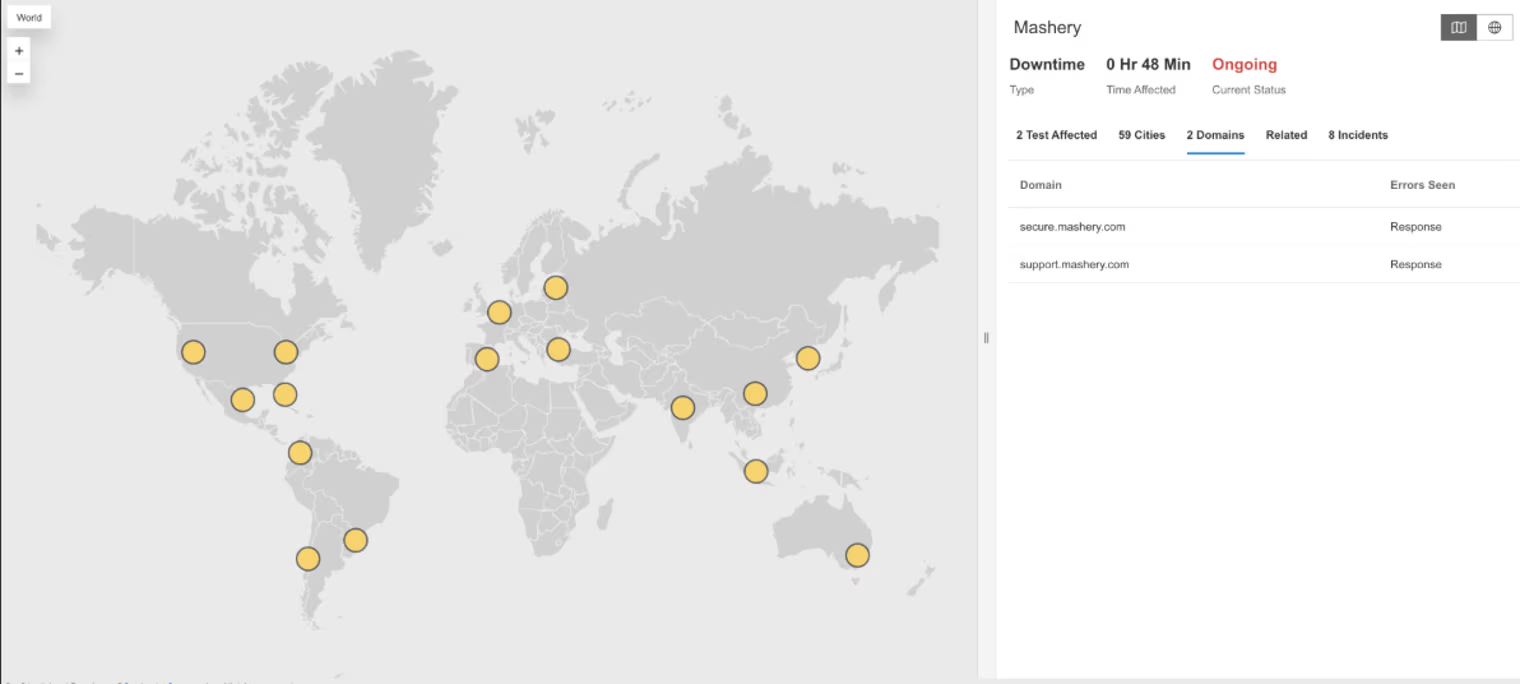

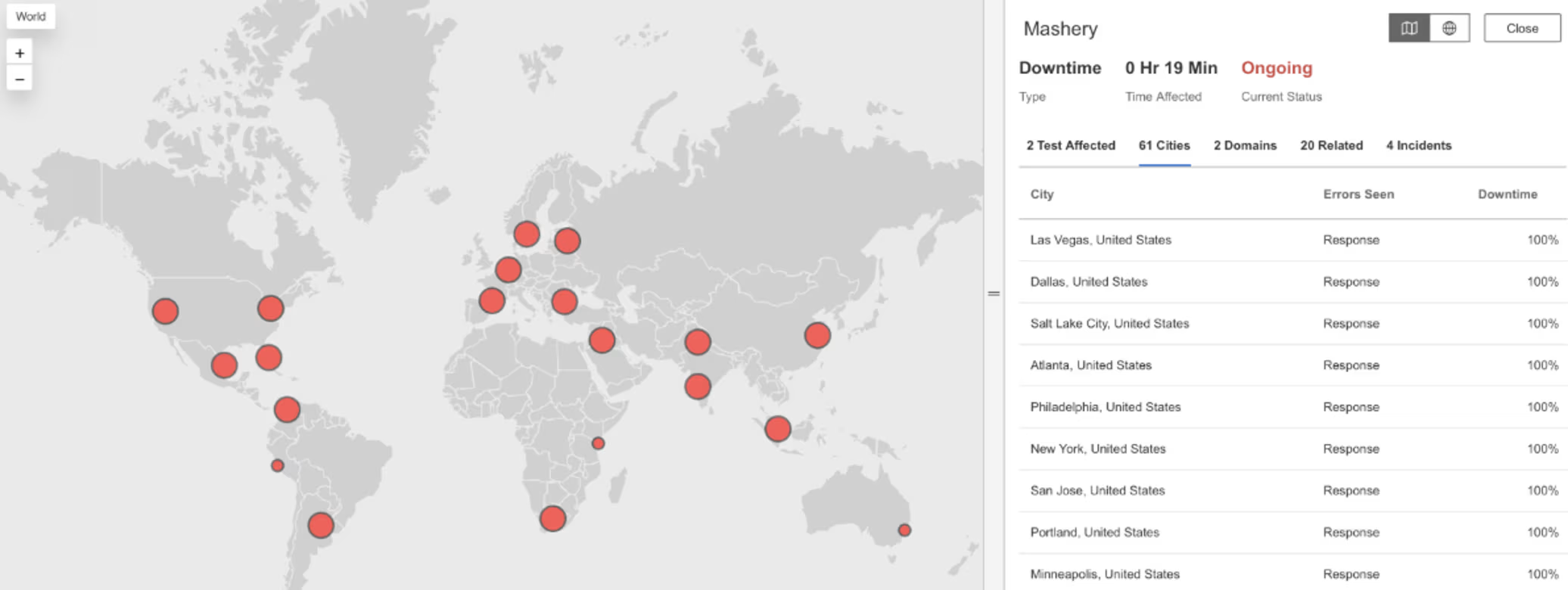

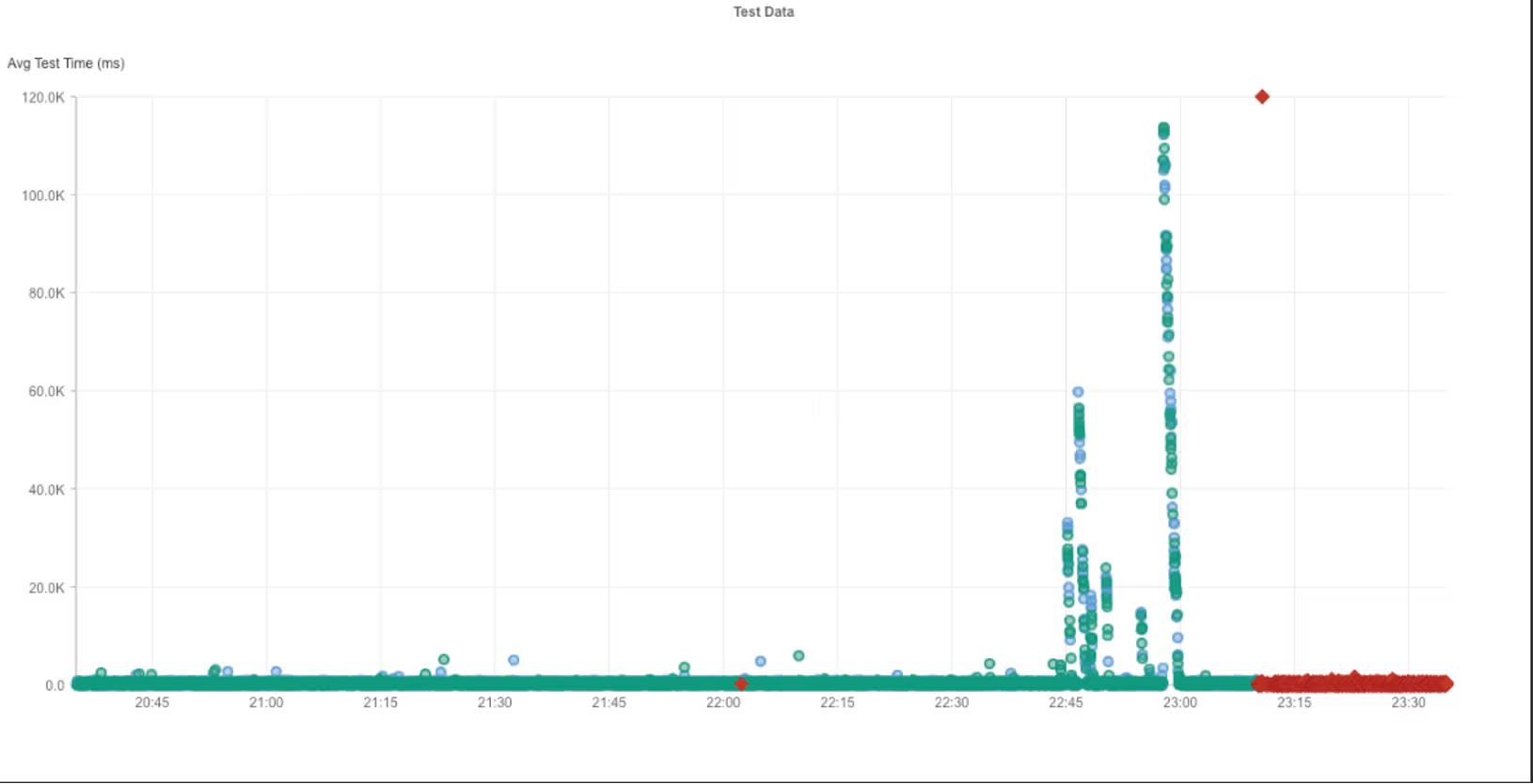

Mashery

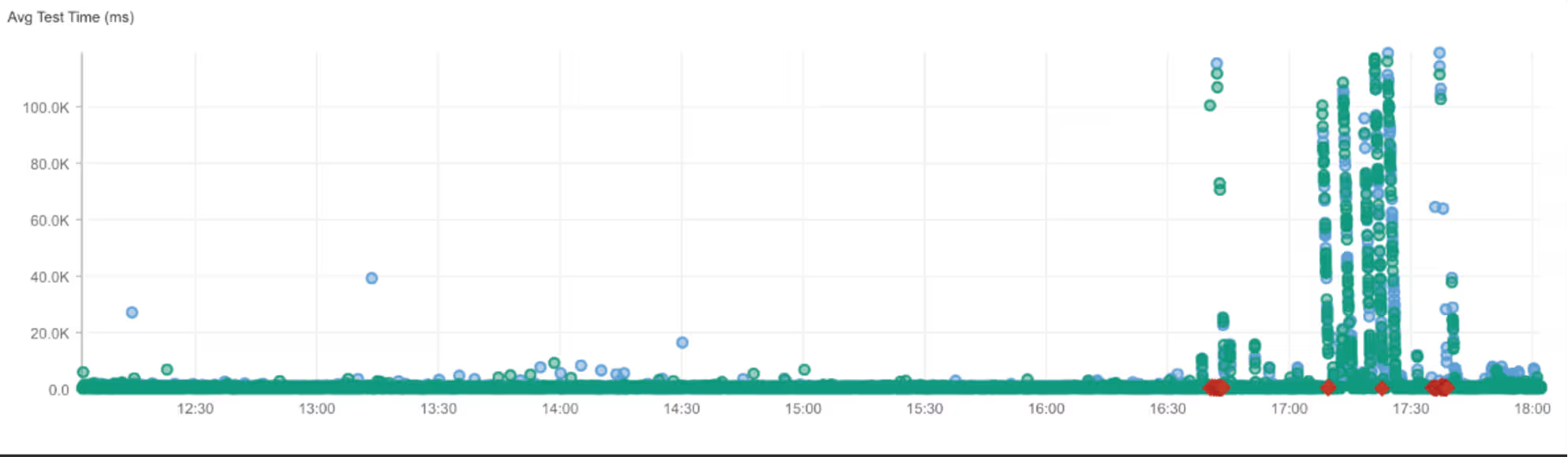

What Happened?

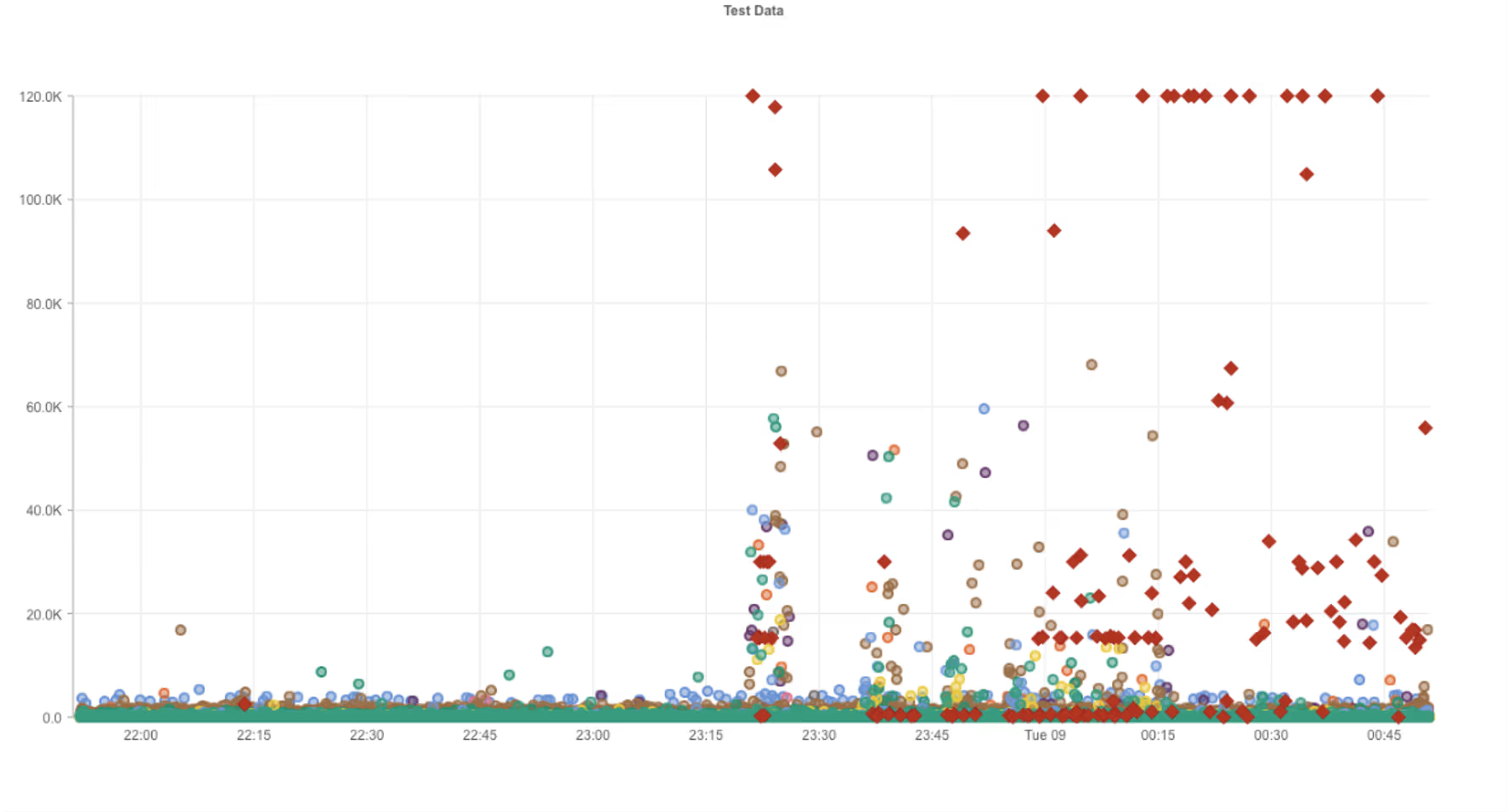

At around 4:40 PM EST, Mashery experienced a global service disruption affecting users across multiple regions. Requests to Mashery services began returning HTTP 503 (Service Unavailable) errors, meaning the servers were temporarily unable to handle incoming requests. Alongside these errors, request times increased sharply, with users experiencing long waits before failures occurred. This combination indicated degraded performance and reduced availability during the outage window.

Takeaways

For API management platforms, elevated latency followed by HTTP 503 errors often signals control-plane or gateway saturation, where traffic reaches the service but cannot be processed fast enough. The sharp rise in wait times shows how performance degradation can act as an early warning before full request failures become widespread. Because API gateways sit directly in the request path for many downstream services, instability at this layer can quickly cascade into customer-facing outages. Tracking latency distributions alongside error rates helps distinguish overload conditions from hard failures and provides earlier signals for mitigation before availability drops completely.

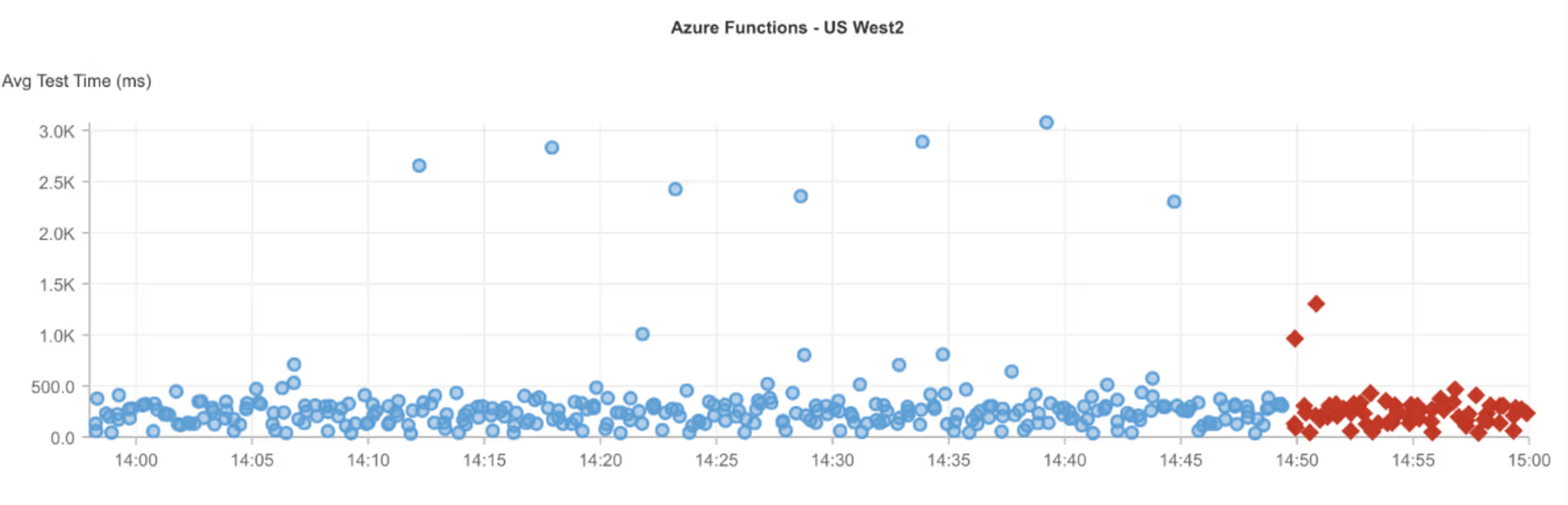

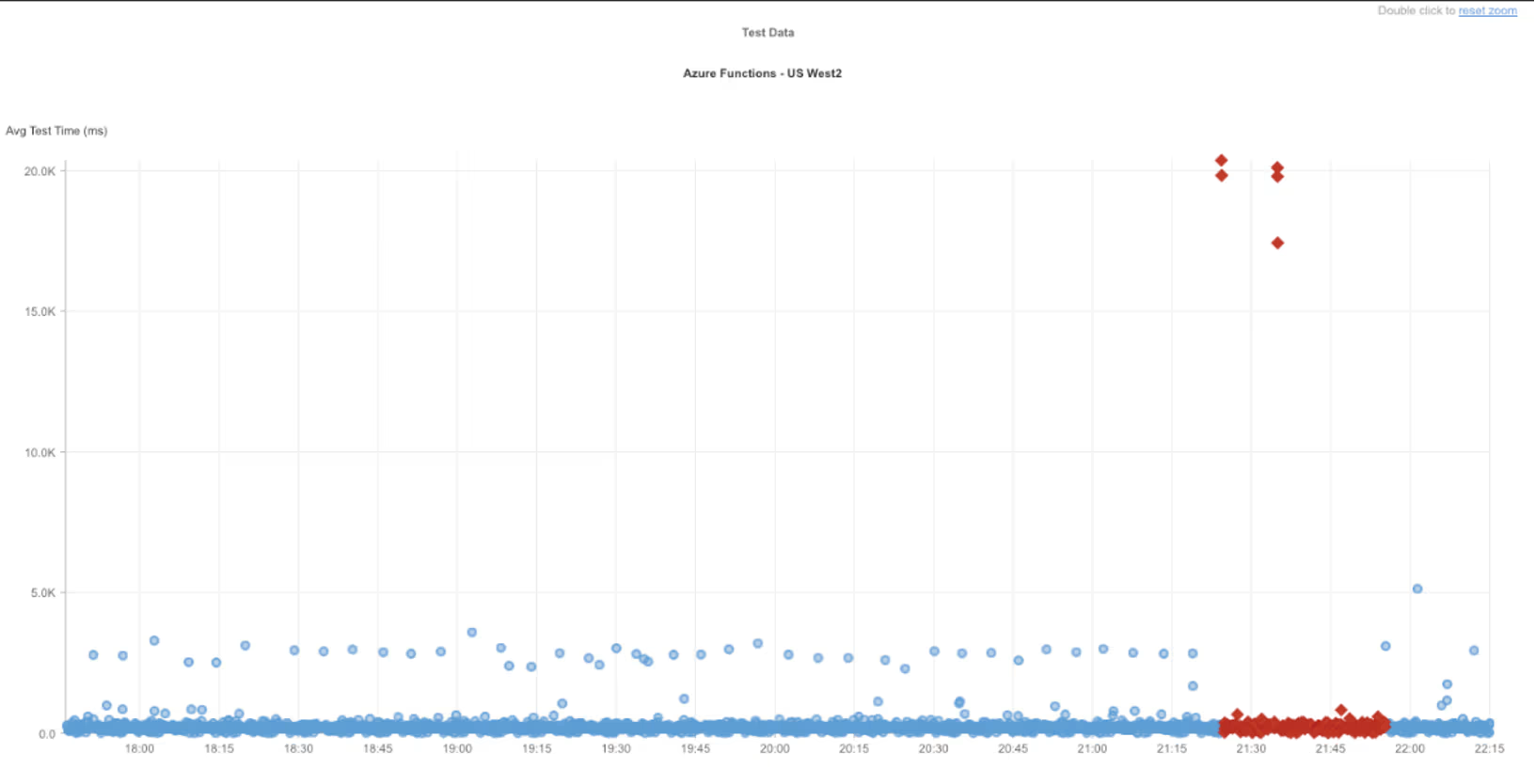

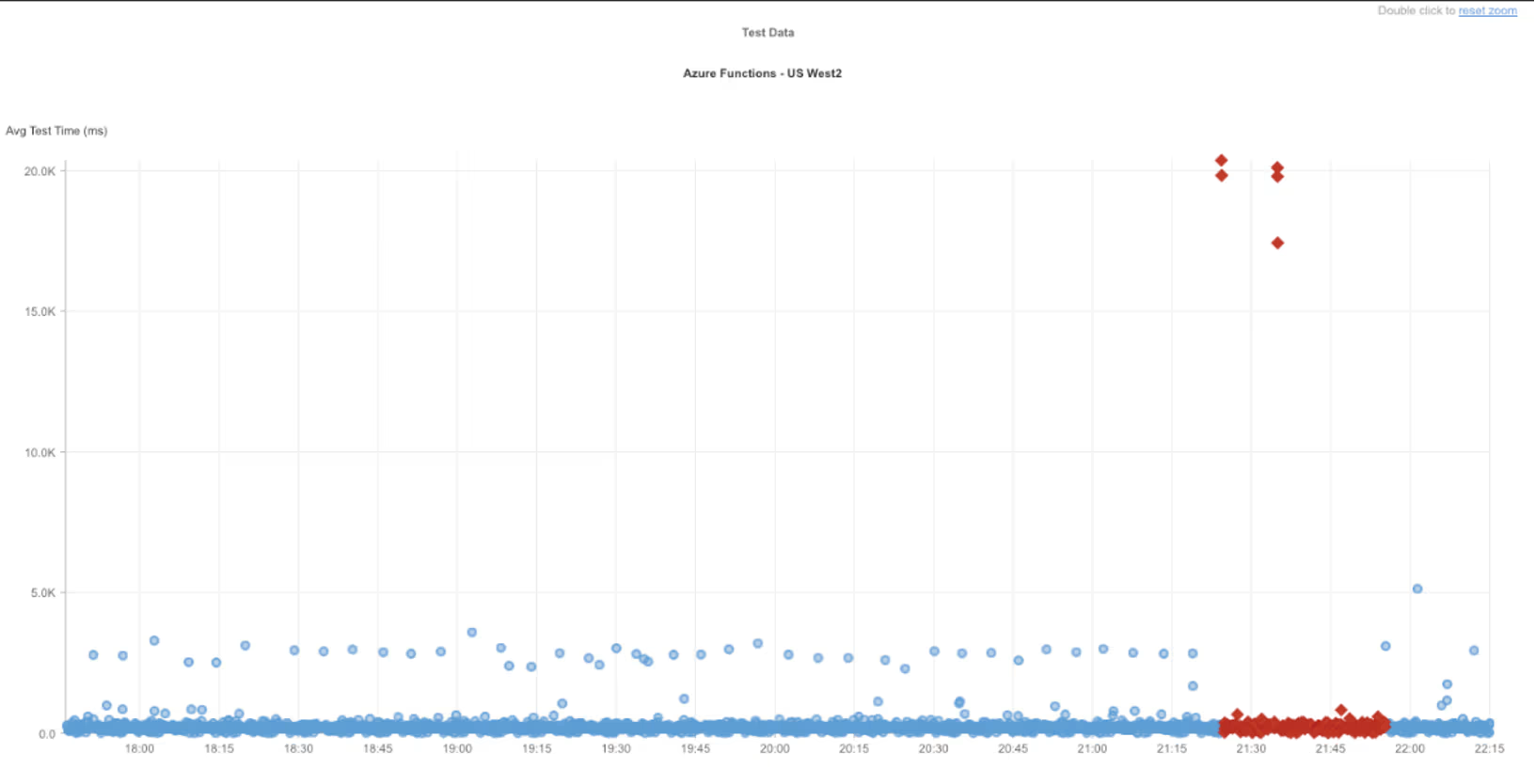

Azure West US 2

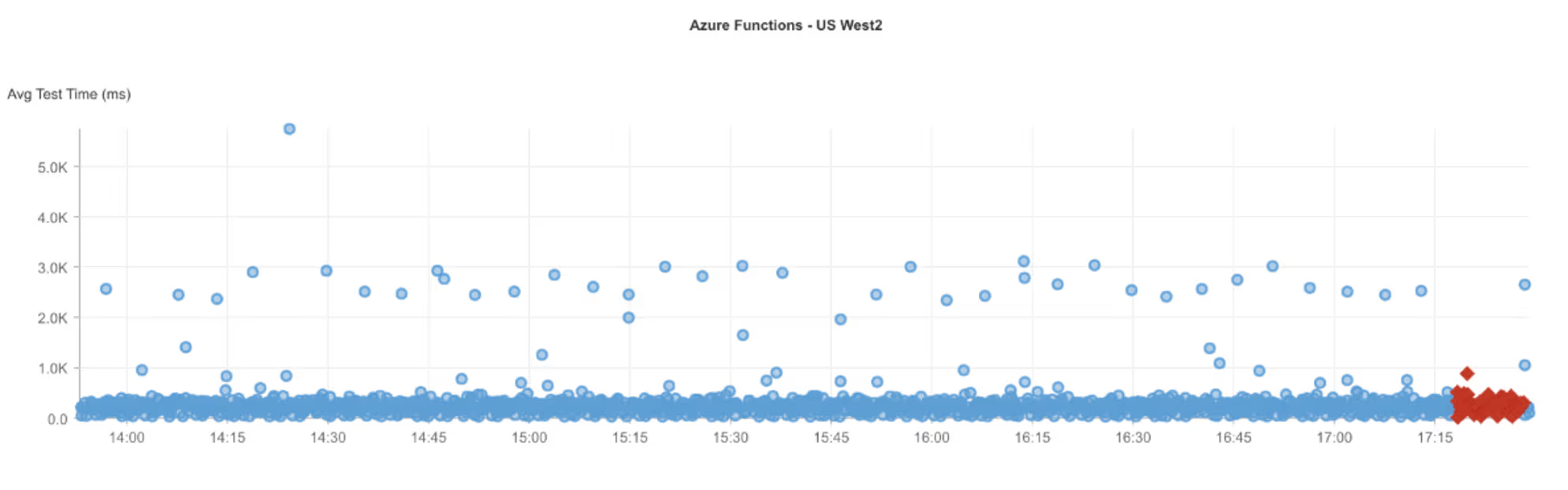

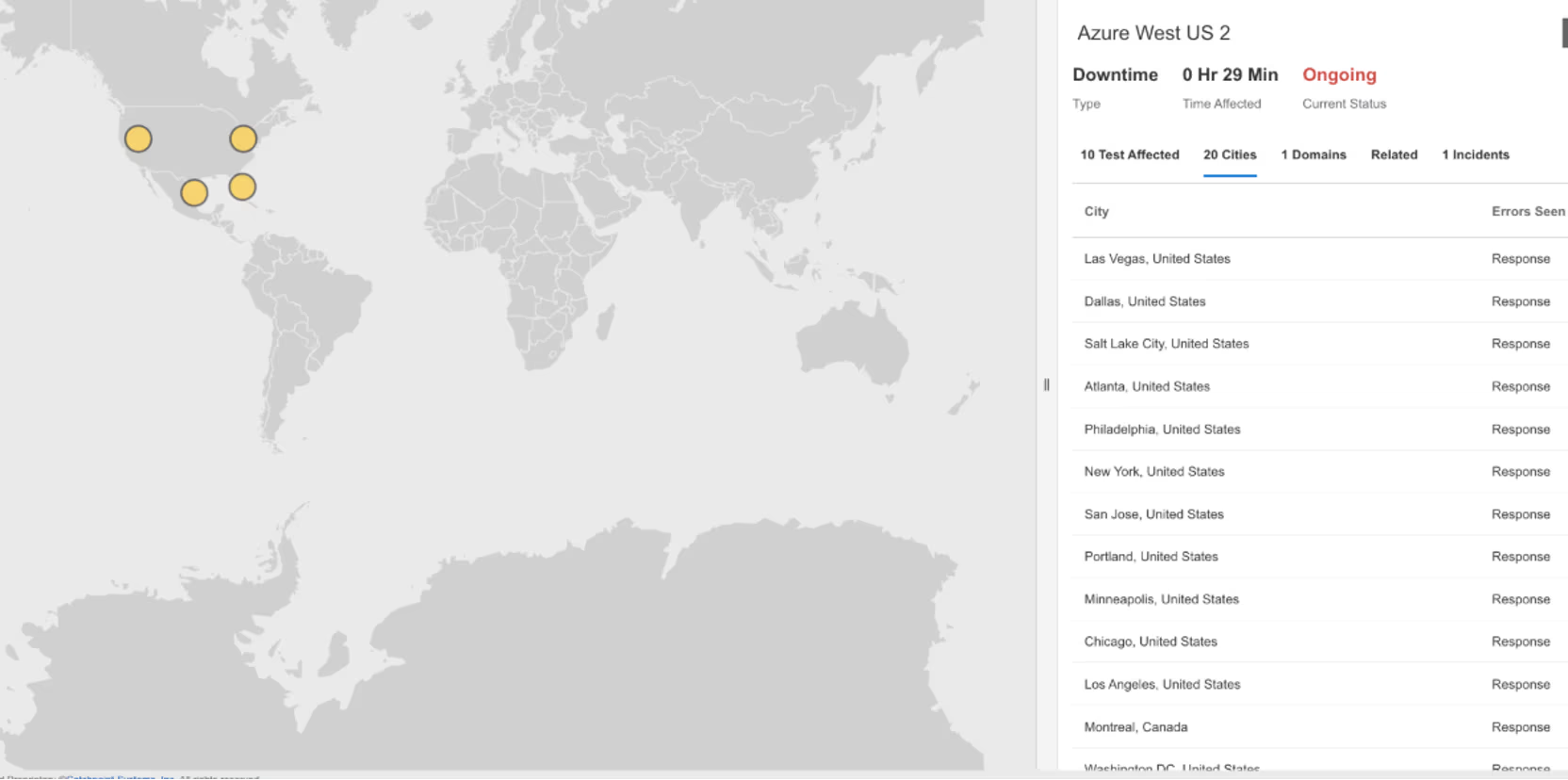

What Happened?

On December 11, 2025, at 17:18 EST, Internet Sonar detected an outage affecting Azure West US 2 across multiple regions, in North America. Requests to iw-west-us2.azurewebsites.net began returning HTTP 503 (Service Unavailable – the server is temporarily unable to handle requests), indicating a service disruption in the Azure West US 2.

Takeaways

Short bursts of HTTP 503 errors often reflect transient capacity pressure or internal service restarts rather than sustained regional failures. These events may only be visible externally for a narrow window but can still affect workloads that lack retries or traffic buffering. This incident highlights the importance of graceful degradation patterns, such as client-side retries with backoff and queue-based processing, to absorb brief platform-level disruptions. Even low-severity cloud incidents reinforce the need to design applications that tolerate momentary service unavailability without cascading user-facing failures.

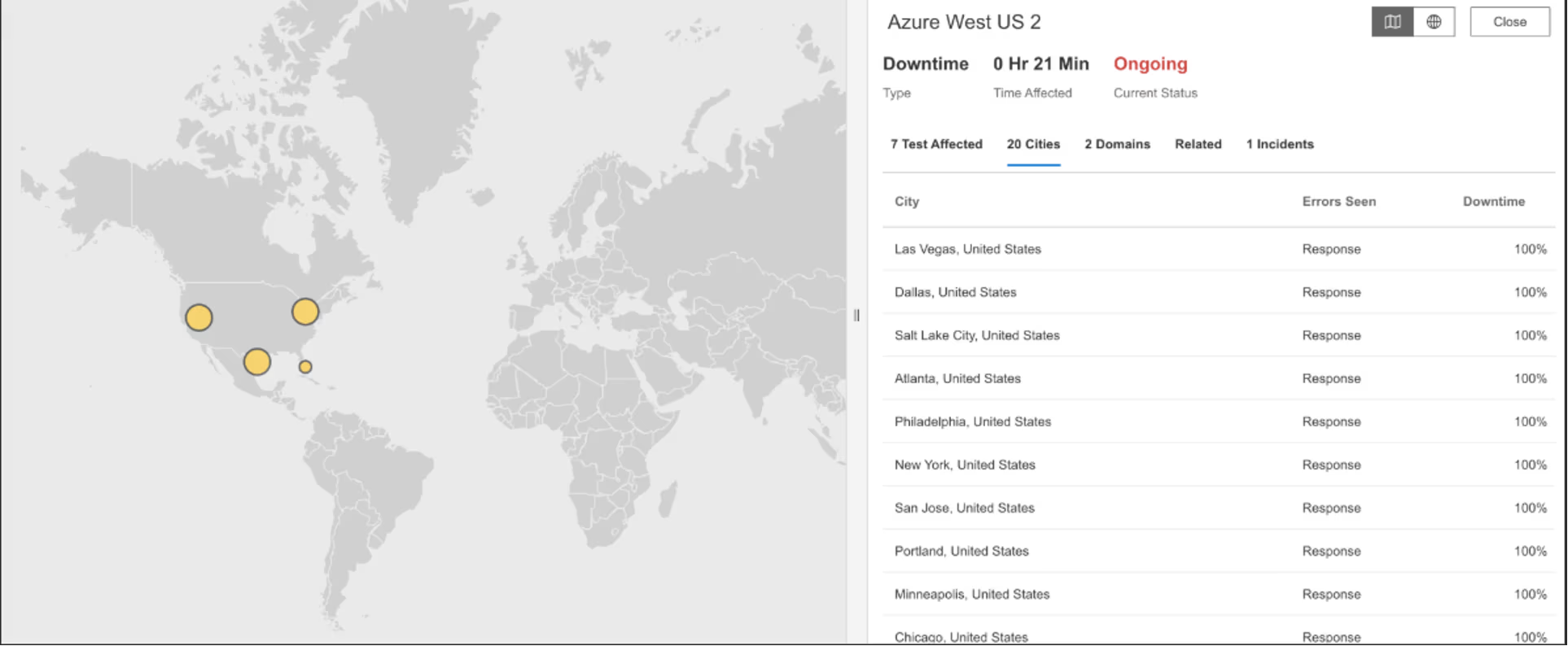

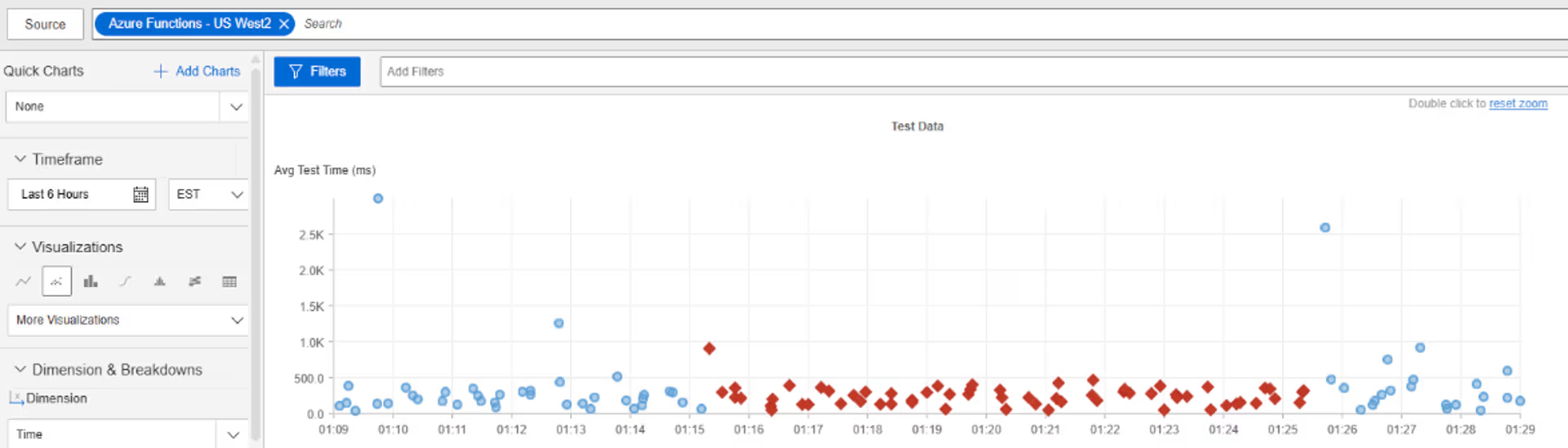

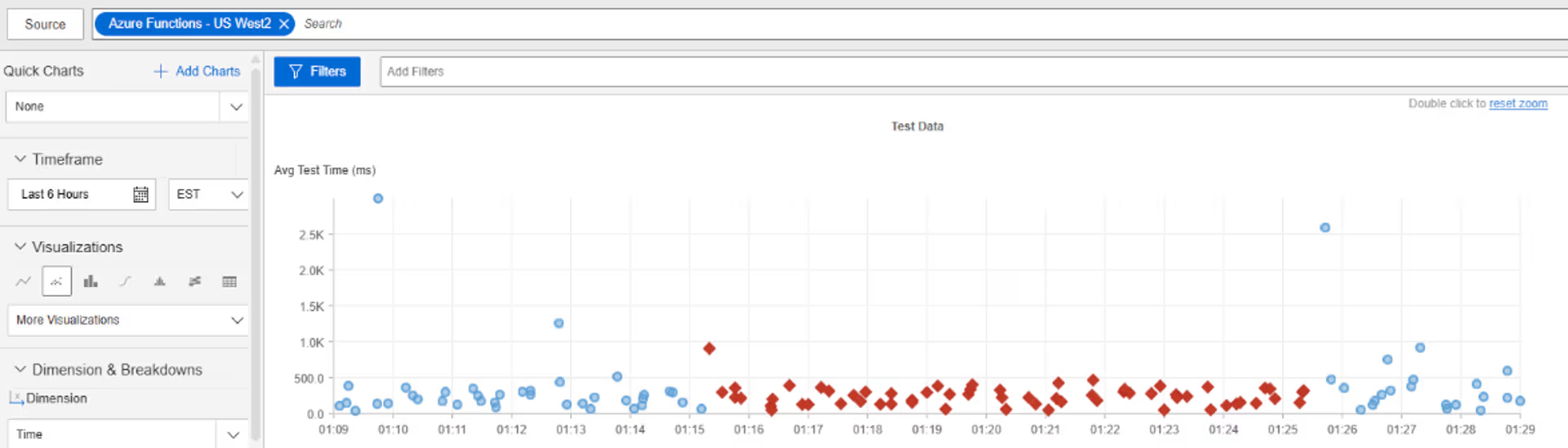

Azure West US 2

What Happened?

On December 10, 2025, from 01:15:20 to 01:25:21 EST, Internet Sonar detected an outage affecting Azure West US 2 across multiple regions, including the US and Canada. Requests to iw-west-us2.azurewebsites.net began returning HTTP 503 (Service Unavailable – the server is temporarily unable to handle requests) , indicating a brief service disruption in the Azure West US 2.

Takeaways

A short, well-defined window of HTTP 503 errors suggests a temporary loss of service readiness rather than a hard failure, such as components failing health checks during recovery or traffic being routed to instances not yet ready to serve. These events often occur during internal remediation, scaling actions, or dependency restarts, and can surface externally even when recovery is already underway. For consumers of cloud platforms, this highlights the importance of readiness probes, retry behavior, and circuit-breaking, since brief periods of partial unavailability can still translate into user-visible errors if clients treat 503s as terminal failures.

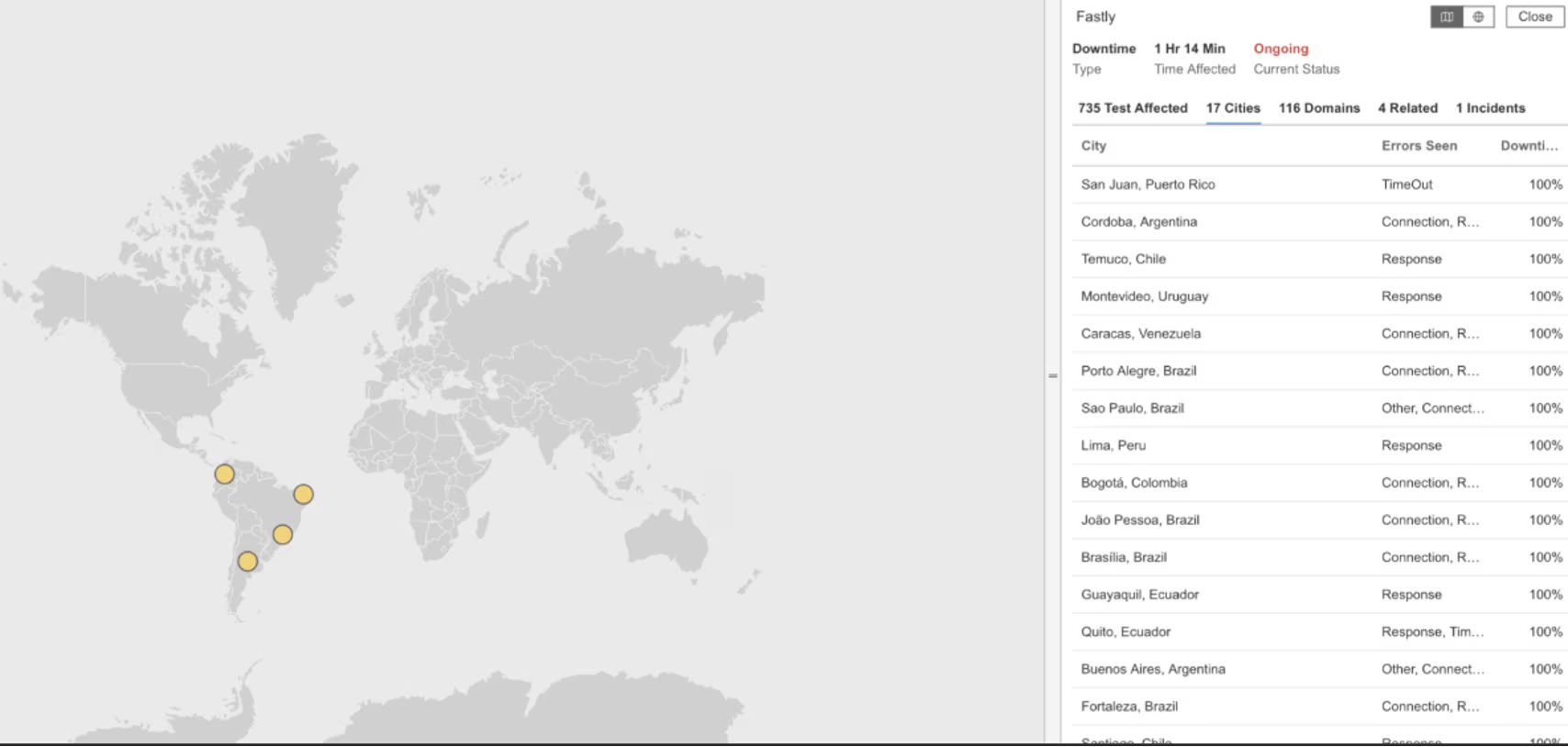

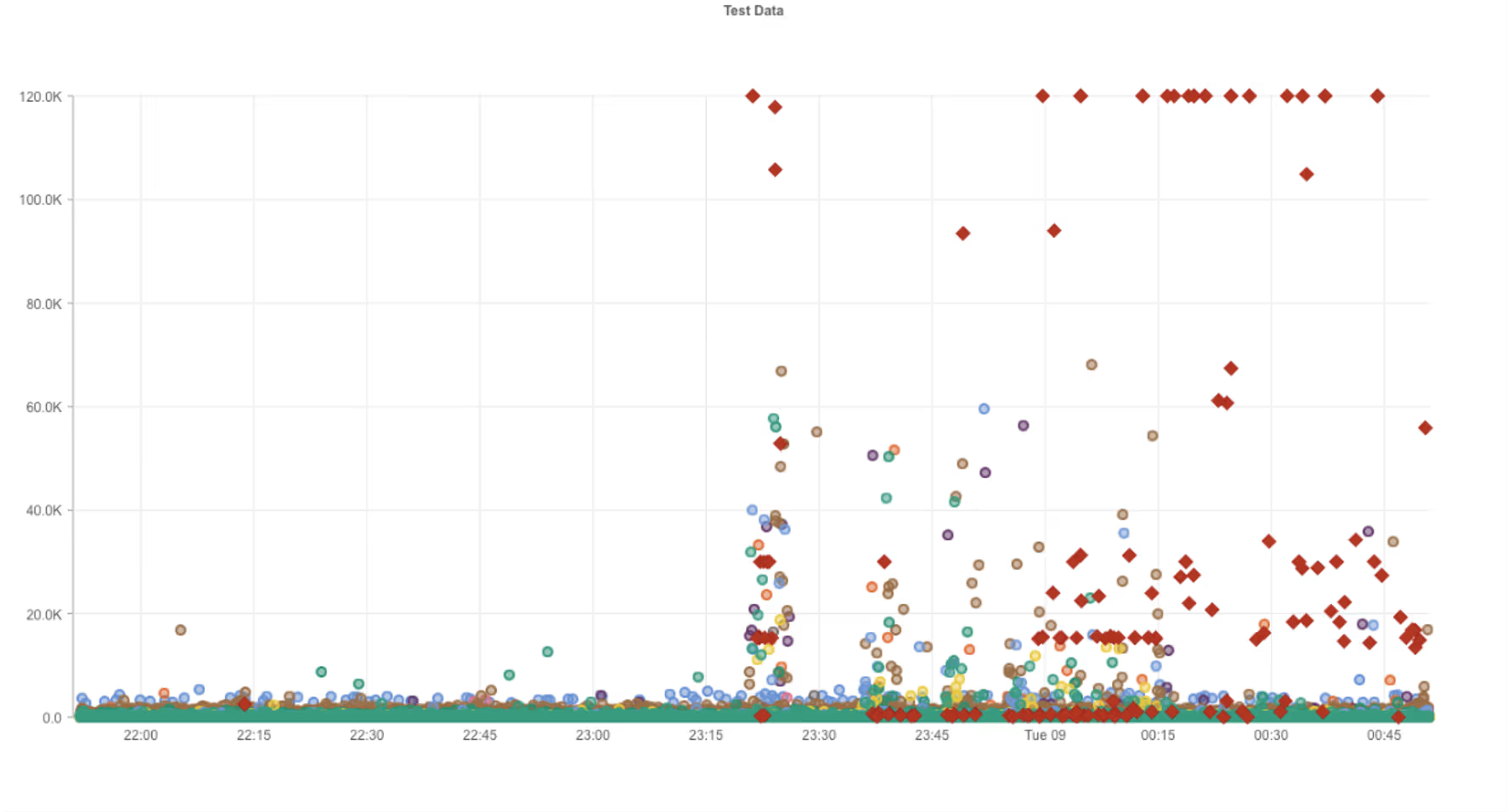

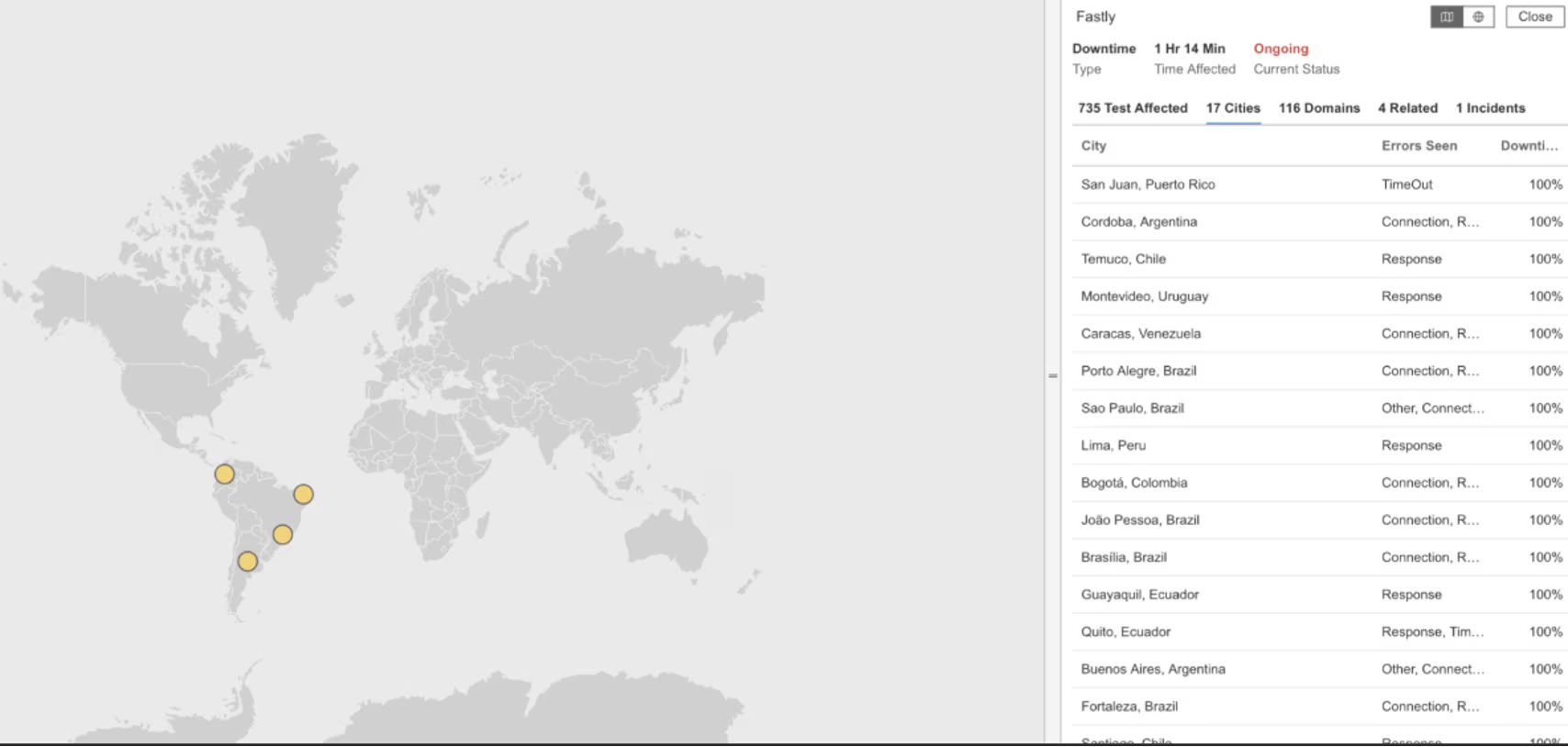

Fastly

What Happened?

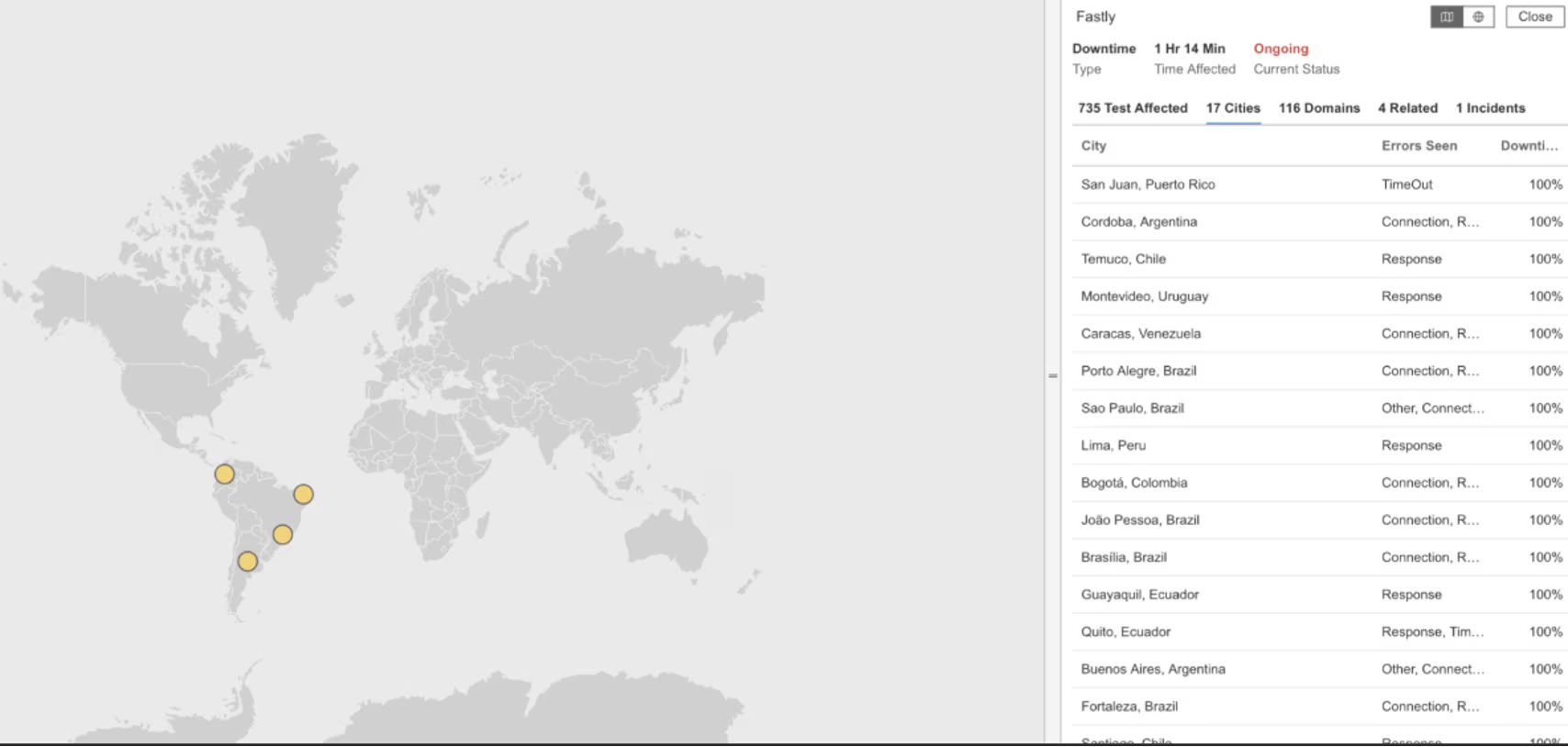

On December 8, 2025, at 23:21 EST, Internet Sonar detected an outage affecting Fastly in Latin America. Requests from multiple locations experienced high connect times and began returning HTTP 502 (Bad Gateway ) for several domains, including fastly.cedexis-test.com, forms.gle, cdn.evgnet.com, api.paypalworld.com, www.paypalobjects.com, and help.venmo.com, indicating Fastly-dependent services were impacted.

Takeaways

The combination of slow connection setup followed by HTTP 502 errors points to instability at the CDN edge or regional point-of-presence, rather than isolated application failures. When a CDN encounters issues in a specific geography, the impact can cascade quickly across many unrelated services that share the same delivery layer. This incident highlights how regional CDN degradation can amplify blast radius, even when origin services remain healthy elsewhere. Observing where latency increases before errors appear helps distinguish edge instability from origin failures and underscores the importance of regional visibility when relying on shared Internet delivery infrastructure.

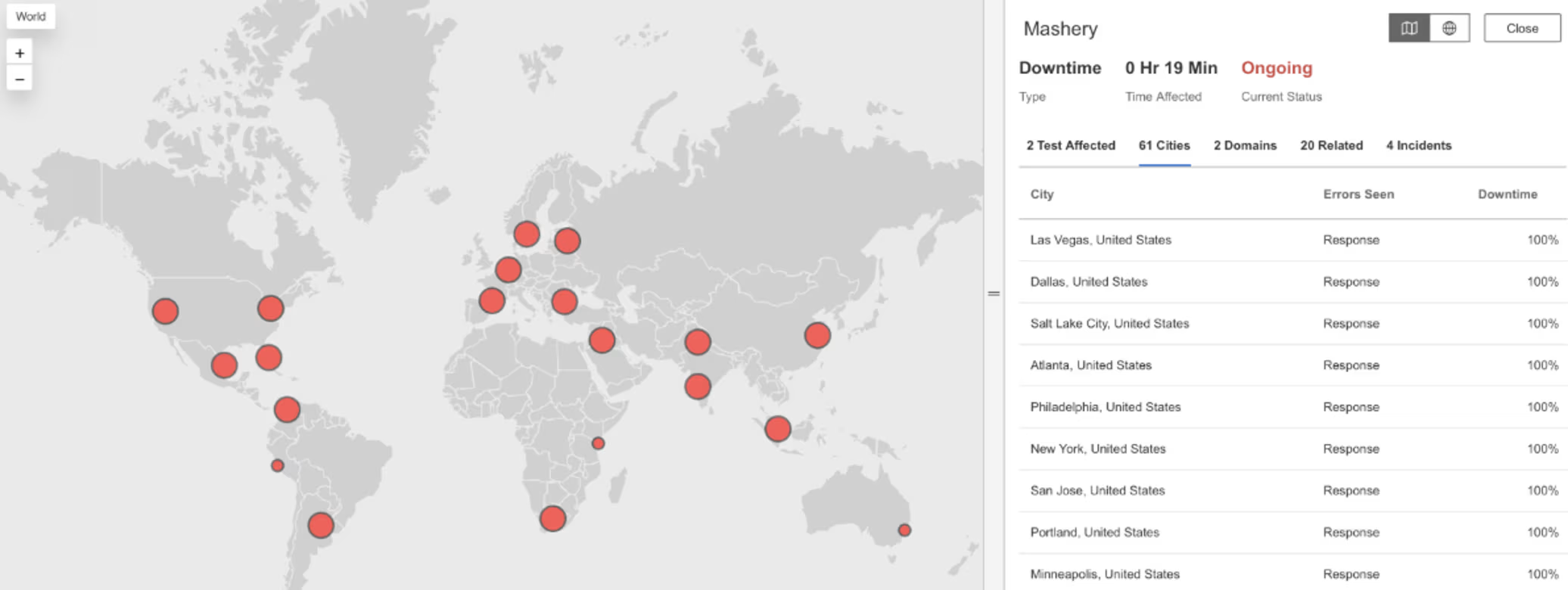

Mashery

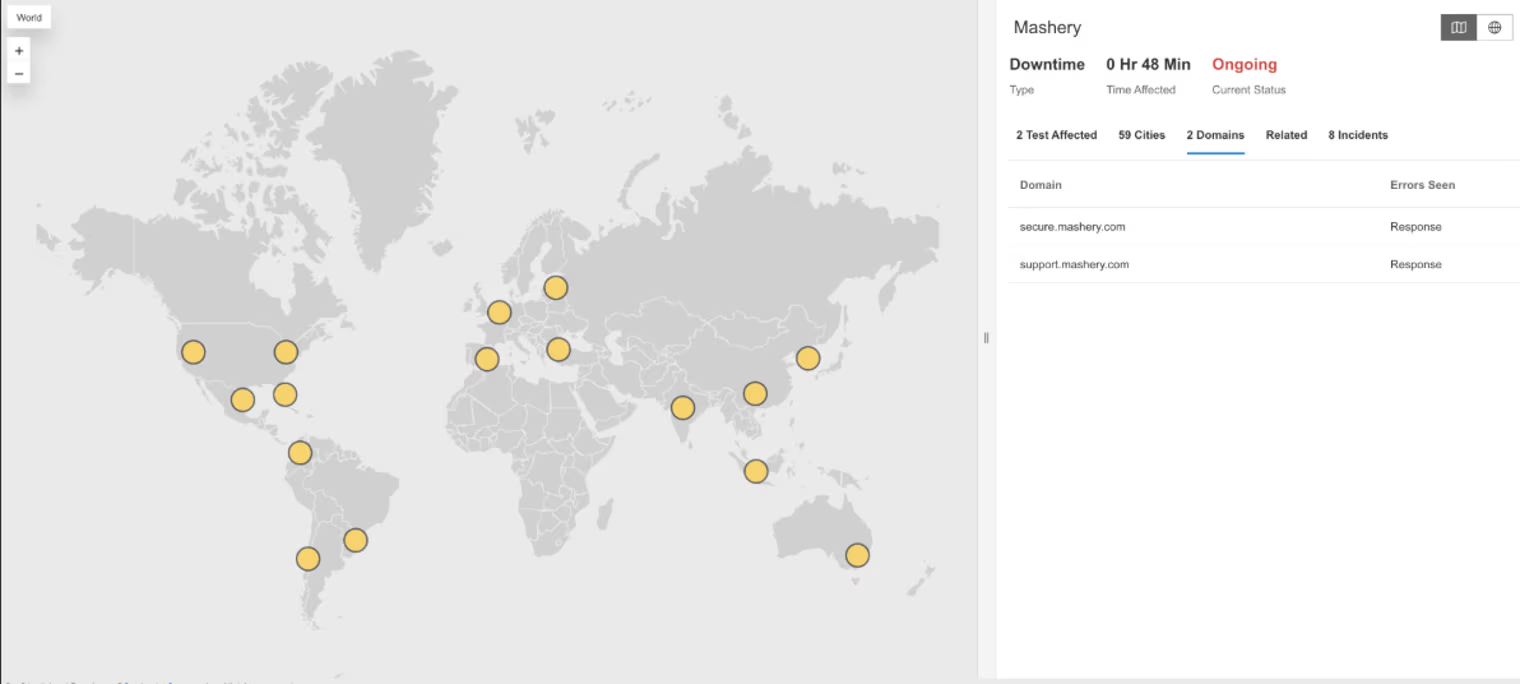

What Happened?

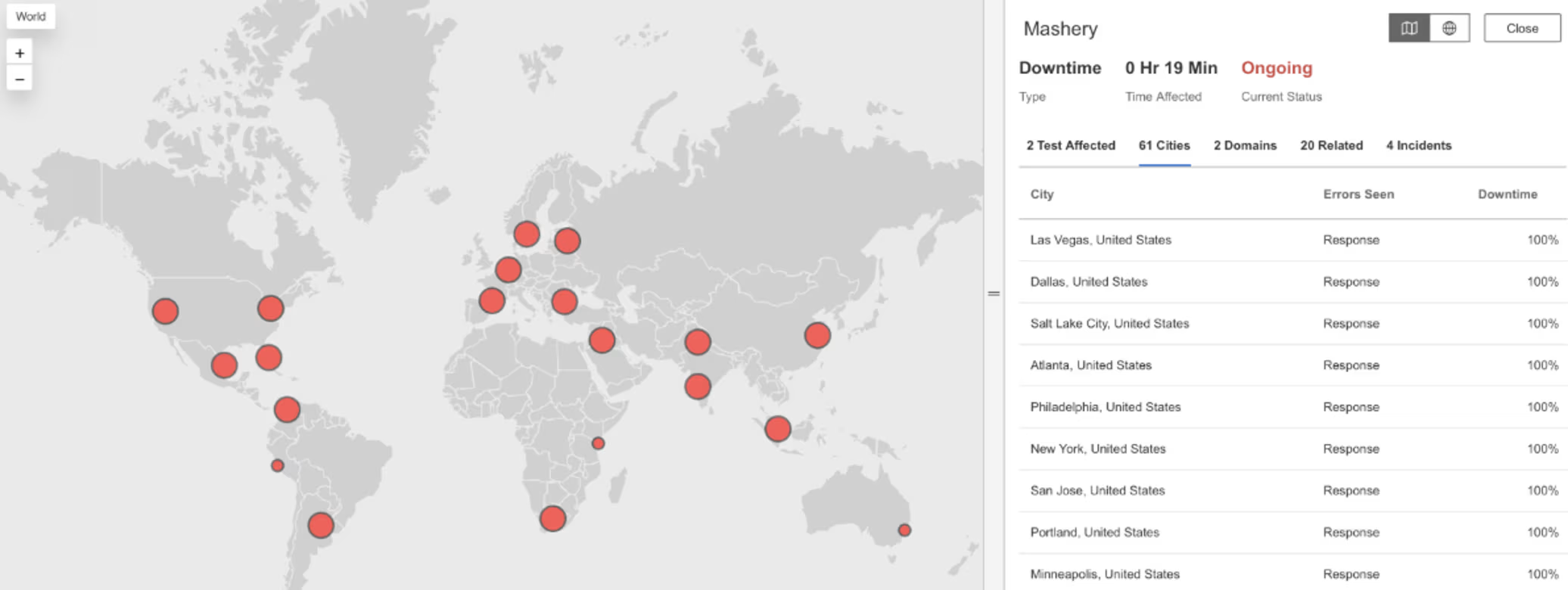

On December 4, 2025, at 23:10:14 EST, Internet Sonar detected an outage affecting Mashery across multiple regions, Requests to secure.mashery.com and support.mashery.com began returning HTTP 503 (Service Unavailable – the server is temporarily unable to handle requests) indicating a service disruption impacting Mashery availability.

Takeaways

A near-simultaneous rise in HTTP 503 errors across regions suggests stress or failure in a shared control plane, rather than independent regional overloads. For globally distributed API platforms, this type of failure often points to centralized components such as authentication, configuration distribution, or traffic management becoming unavailable. The sharp increase in response times before failures indicates queue buildup and backpressure, where requests are accepted but stall before being rejected. This pattern reinforces the importance of monitoring latency distributions alongside error rates to identify early signs of systemic saturation before full global unavailability occurs.

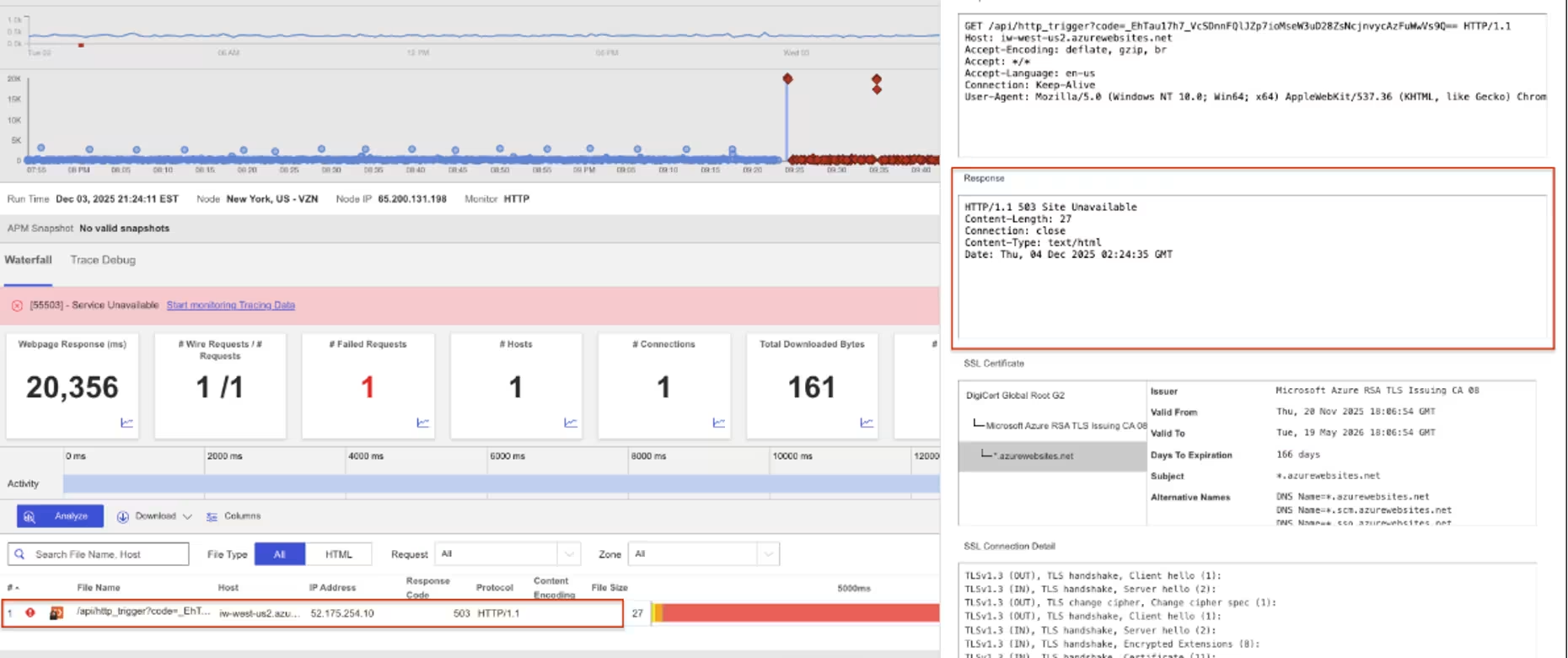

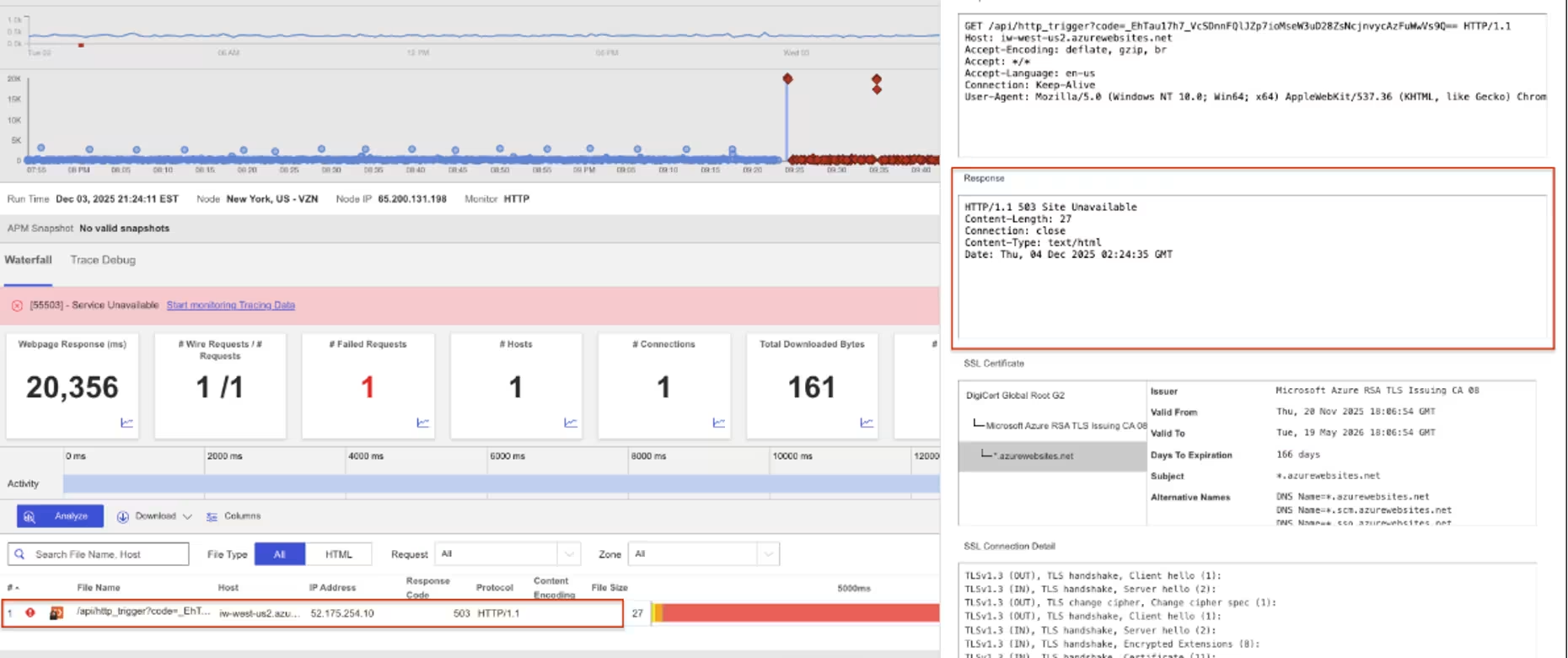

Azure West US 2

What Happened?

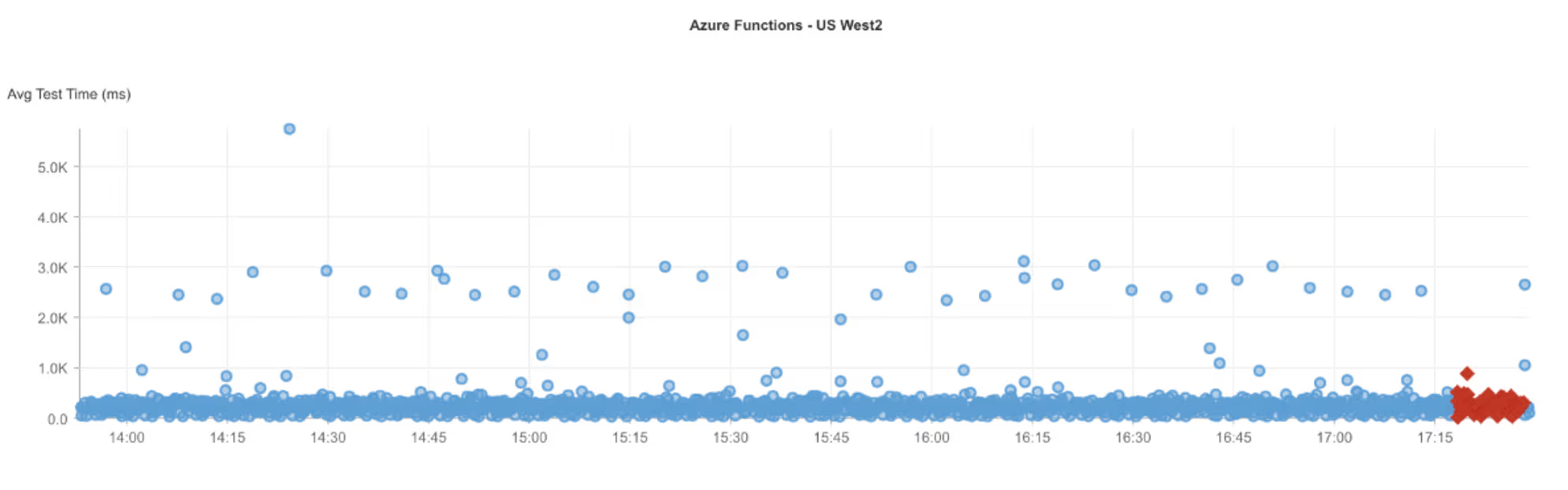

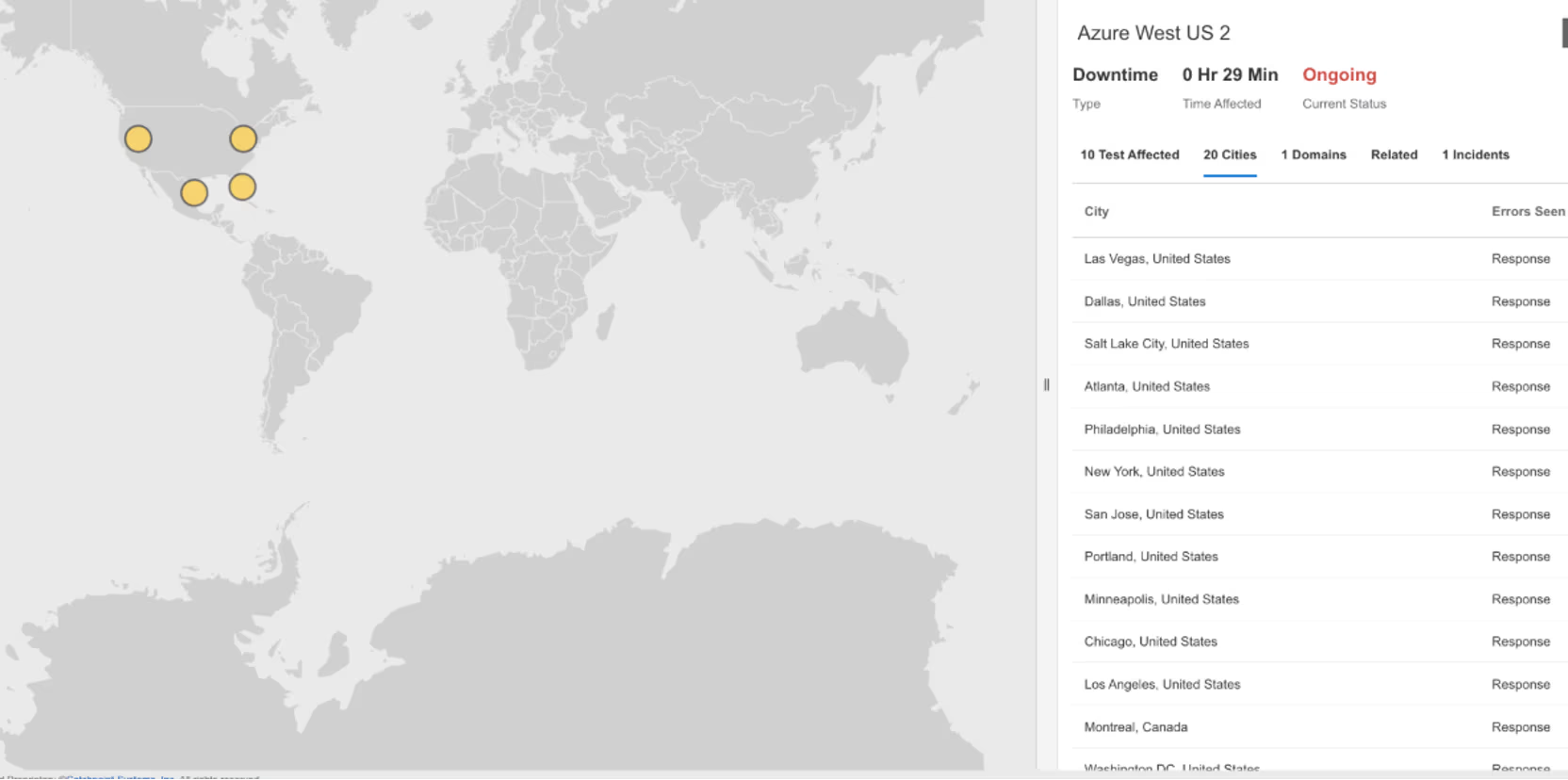

On December 3, 2025, from 21:24:11 to 21:54:58 EST, Internet Sonar detected an outage affecting Azure West US 2 across multiple locations in North America, with requests to iw-west-us2.azurewebsites.net returning HTTP 503 (Service Unavailable – the server is temporarily unable to handle requests).

Takeaways

A sustained window of HTTP 503 errors followed by a clean recovery suggests a stabilization phase, where services gradually return to a healthy state after an internal fault rather than failing and recovering abruptly. These patterns are often associated with dependency warm-up, traffic rebalancing, or gradual restoration of service readiness across a region. Even when recovery is underway, users may continue to see failures until all components re-enter a healthy state. Measuring time-to-stability, not just time-to-first-success, is critical for understanding real user impact during cloud-region incidents and for validating whether recovery actions fully restored service health.

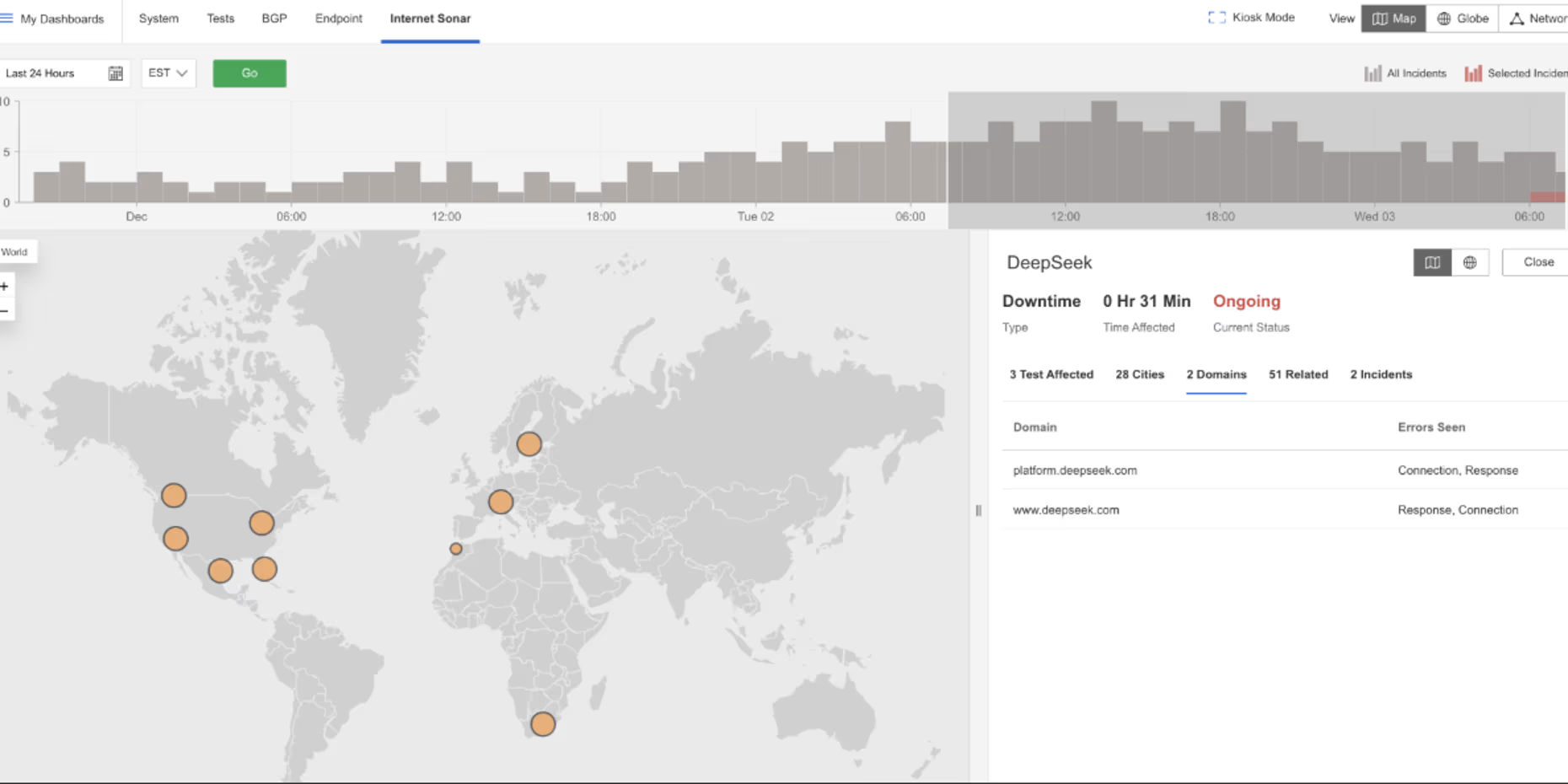

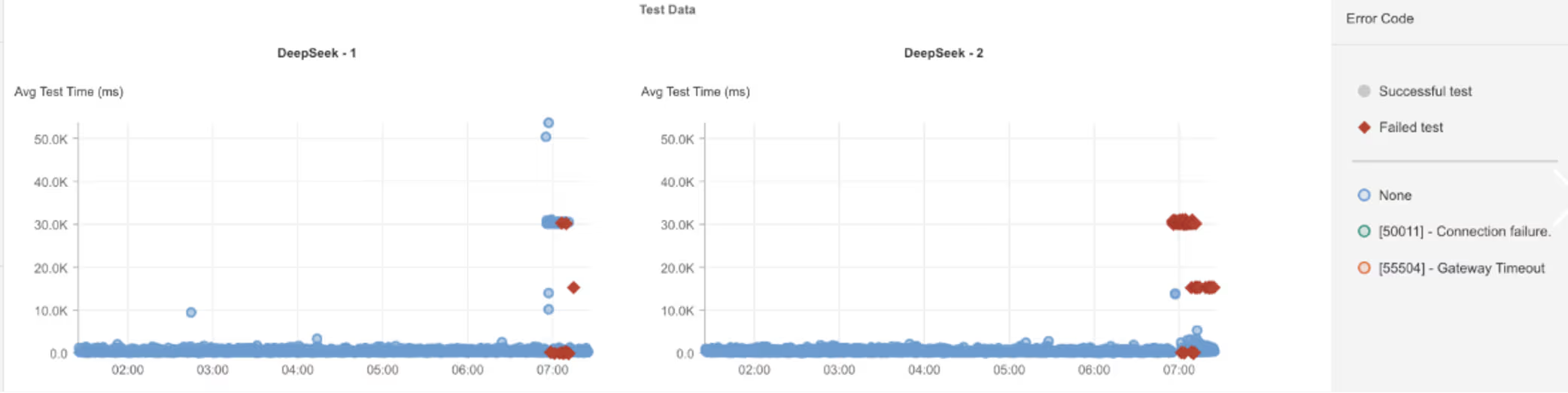

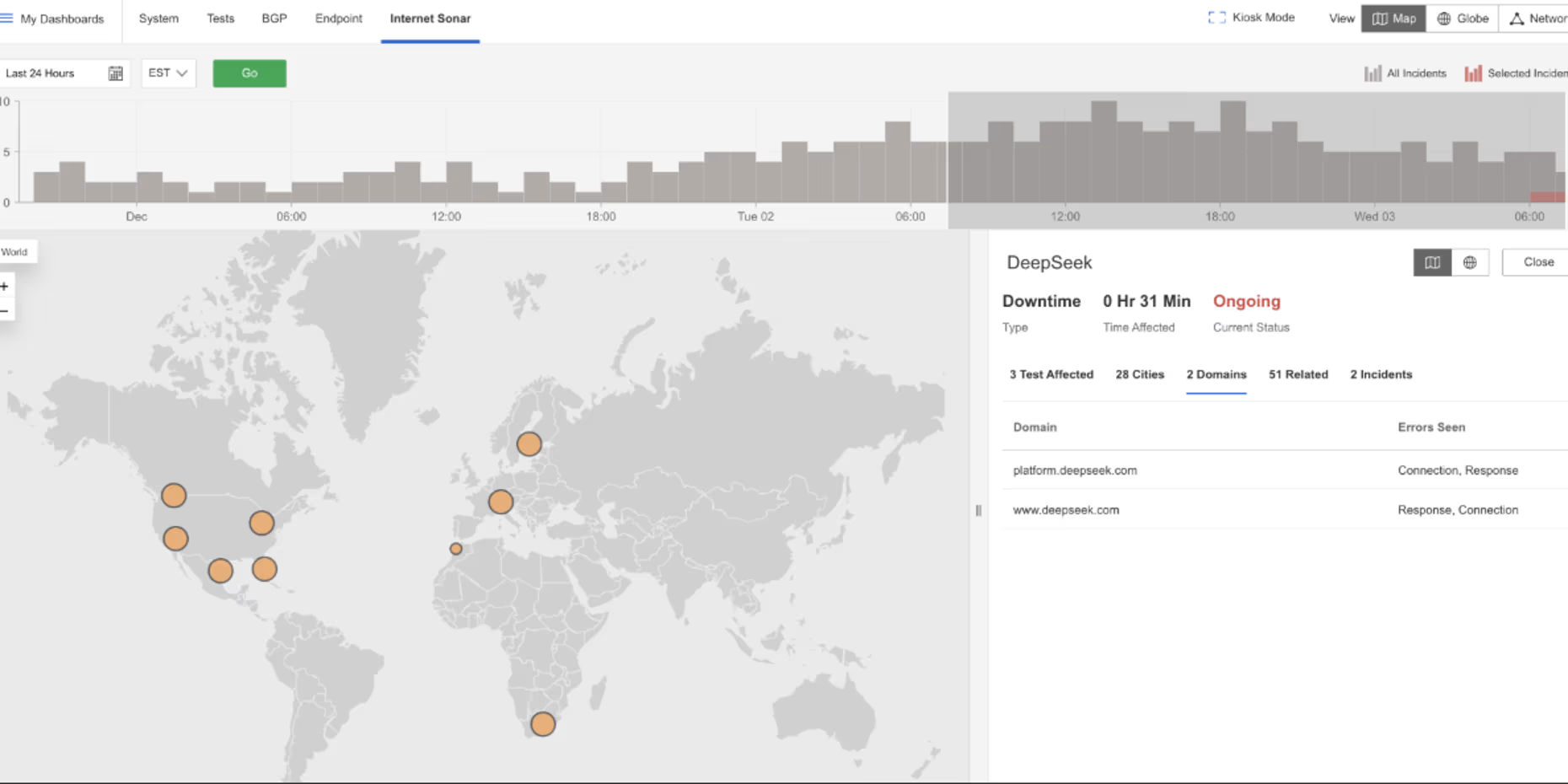

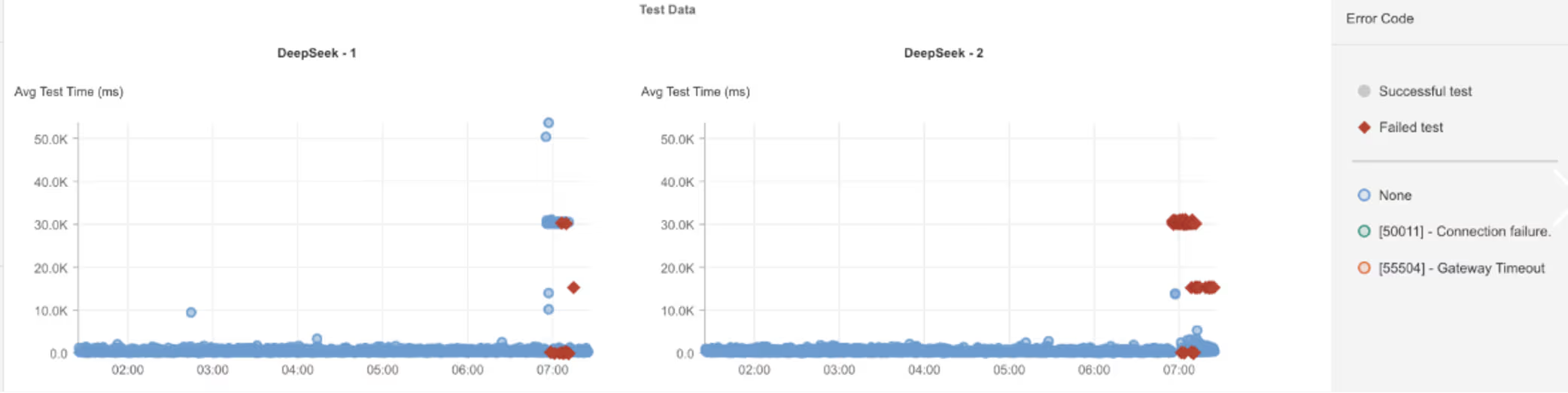

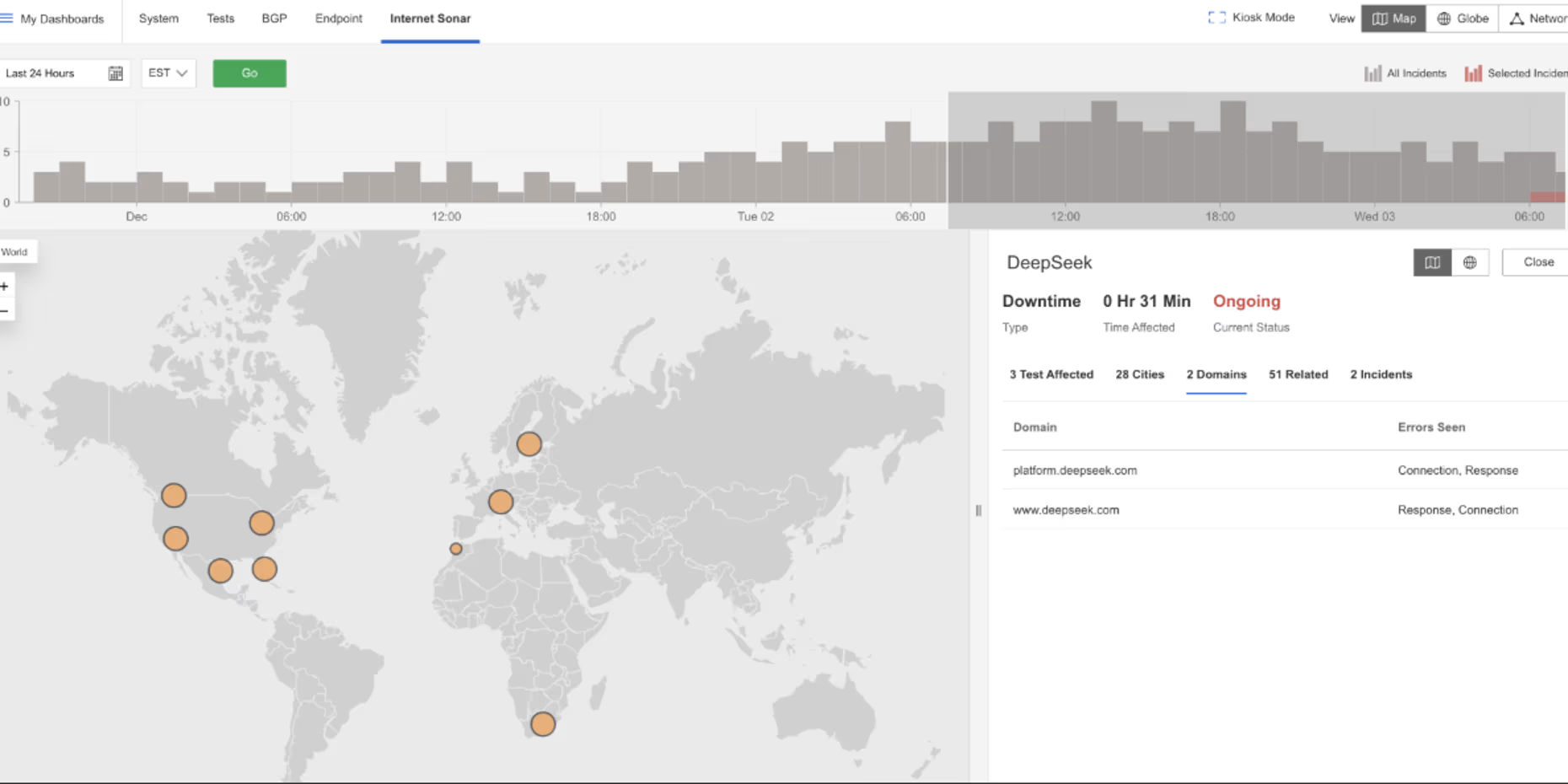

DeepSeek

What Happened?

On December 3, 2025, at 06:55 EST, Internet Sonar detected an outage affecting DeepSeek services across multiple countries, including the US, Canada, India, and Germany, with requests to https://platform.deepseek.com/ and https://www.deepseek.com/ experiencing high wait times and returning HTTP 504 (Gateway Timeout – the server did not receive a timely response from an upstream server).

Takeaways

HTTP 504 errors combined with rising wait times typically indicate upstream dependency saturation or responsiveness issues, rather than failures at the service edge. This pattern suggests that DeepSeek’s front-end remained reachable while downstream components—such as model inference backends, data services, or internal APIs—were unable to respond within expected time limits. For AI-driven platforms, where request processing can be compute-intensive, these timeouts highlight the risk of queue buildup and cascading latency under load. Monitoring request duration distributions alongside timeout errors helps distinguish capacity exhaustion from hard failures and provides early signals before dependency delays turn into widespread availability loss.

November

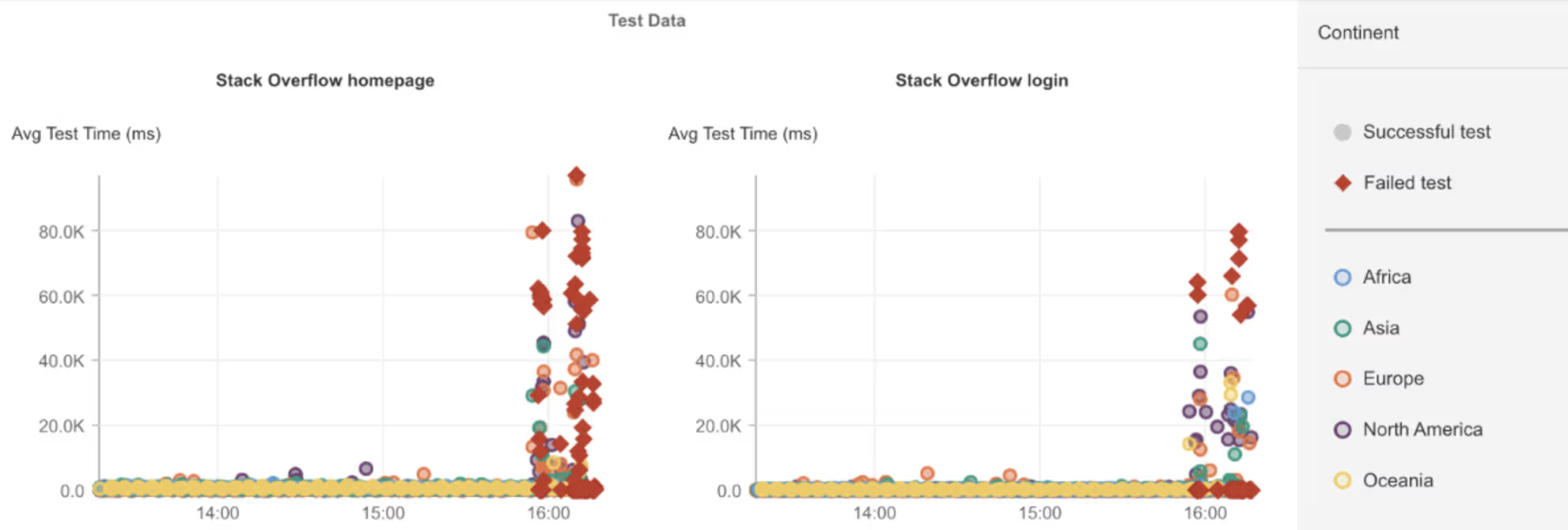

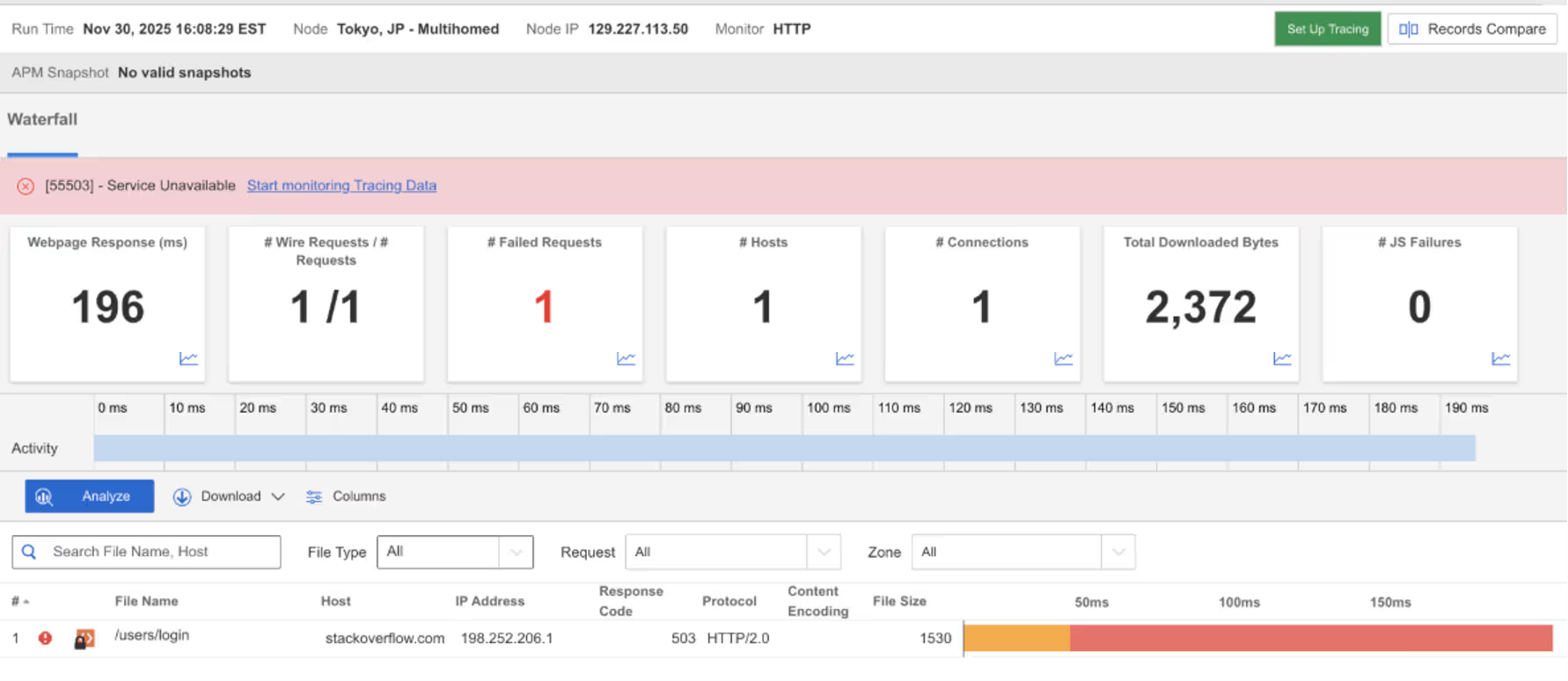

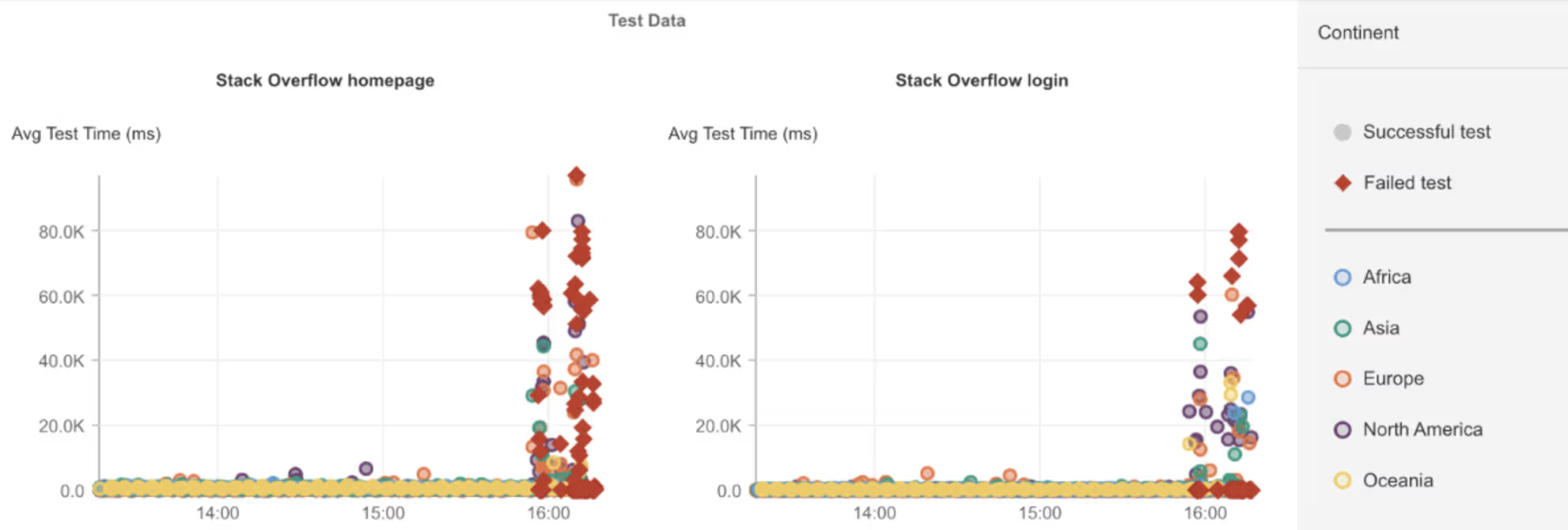

Stack Overflow

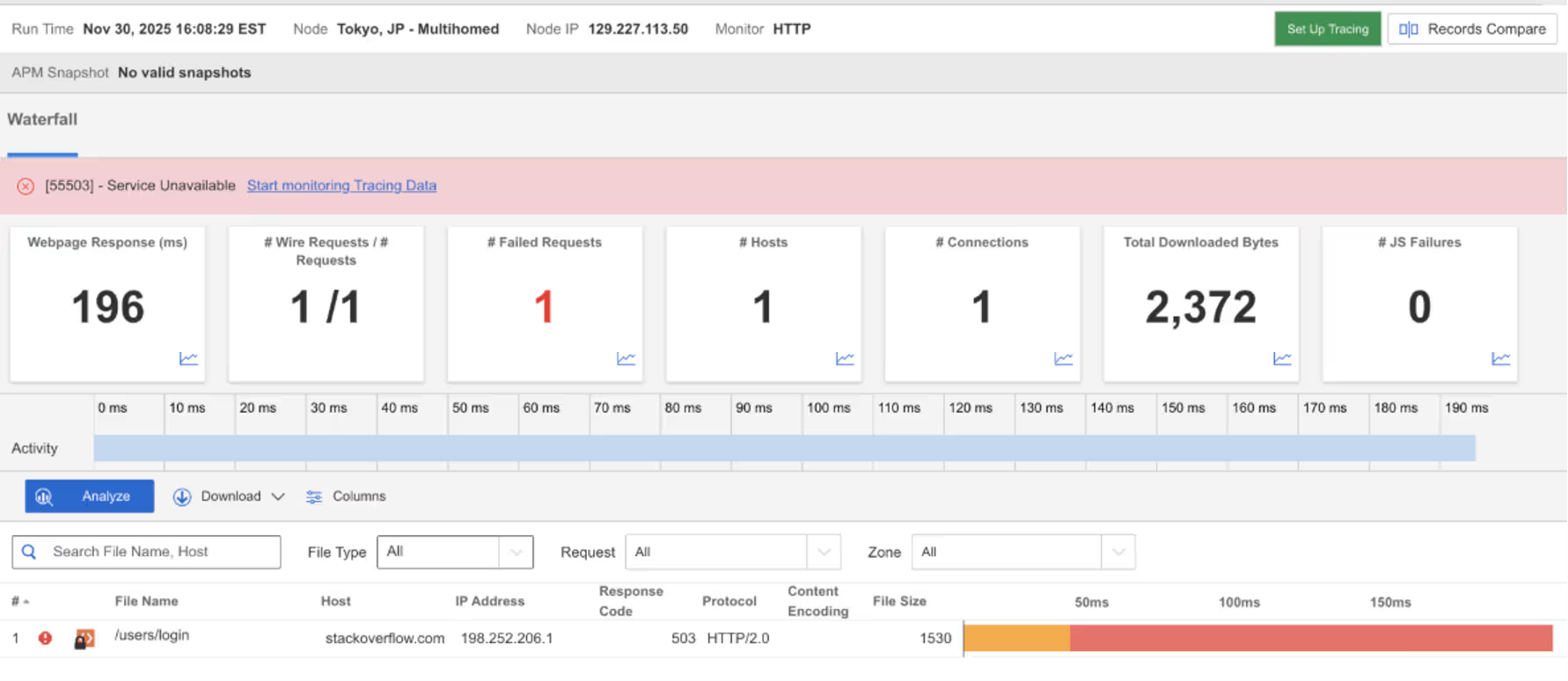

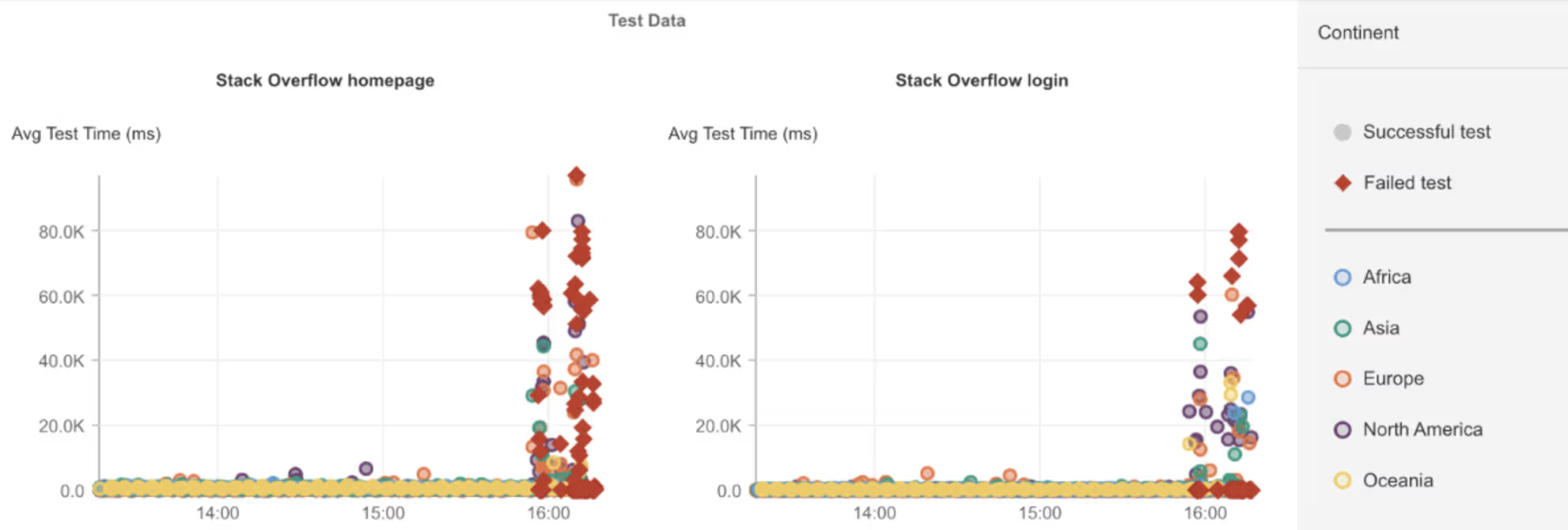

What Happened?

On November 30, 2025, at 15:55 EST, Internet Sonar detected an outage affecting Stack Overflow across multiple countries, with requests to https://stackoverflow.com and https://stackoverflow.com/users/login returning HTTP 503 (Service Unavailable – the server is temporarily unable to handle requests).

Takeaways

Simultaneous failures on the homepage and login path point to an issue in a shared application dependency, rather than a problem isolated to authentication or user sessions alone. When core services such as request routing, configuration, or internal APIs become unavailable, they can block both read-only and authenticated traffic at the same time. This incident highlights how foundational application components can become single points of failure even in otherwise modular architectures. Observing which user journeys fail together helps narrow root cause quickly and avoid misattributing issues solely to auth systems or user-specific services when the underlying failure is broader.

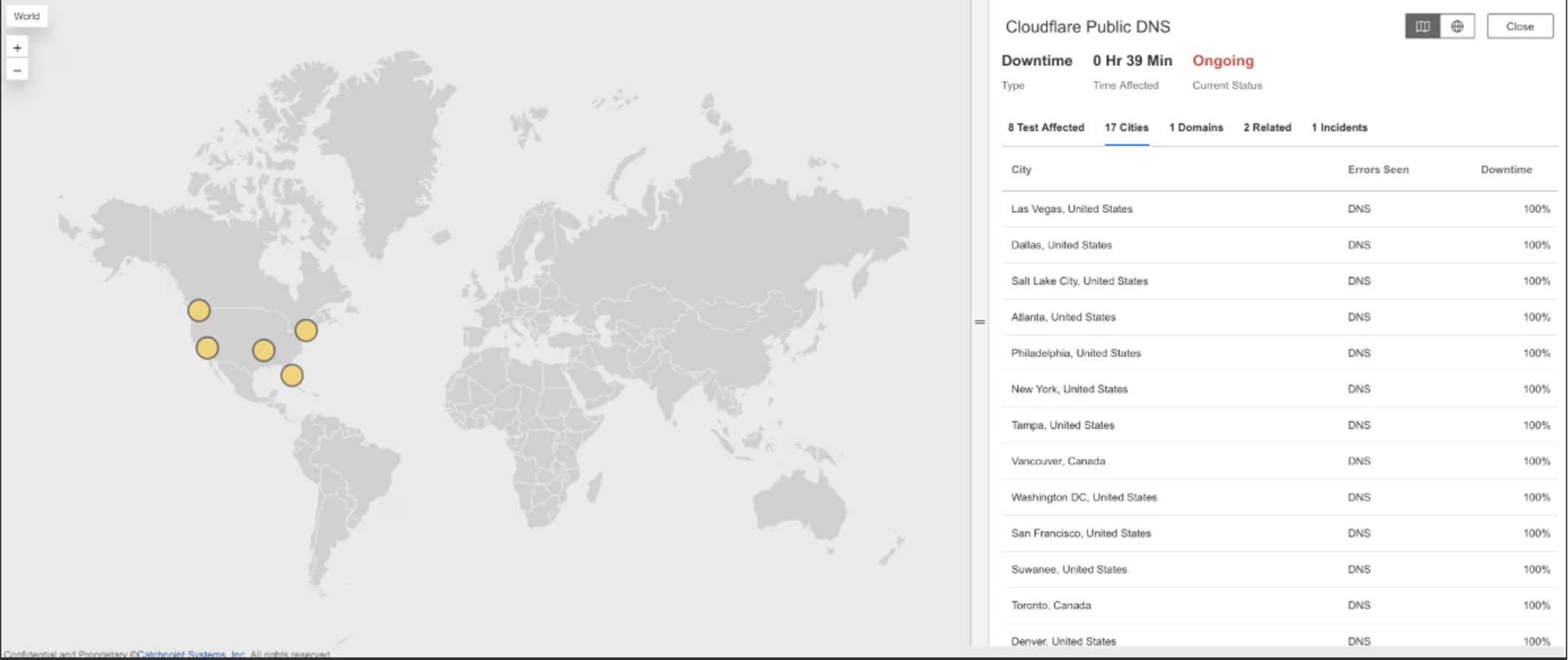

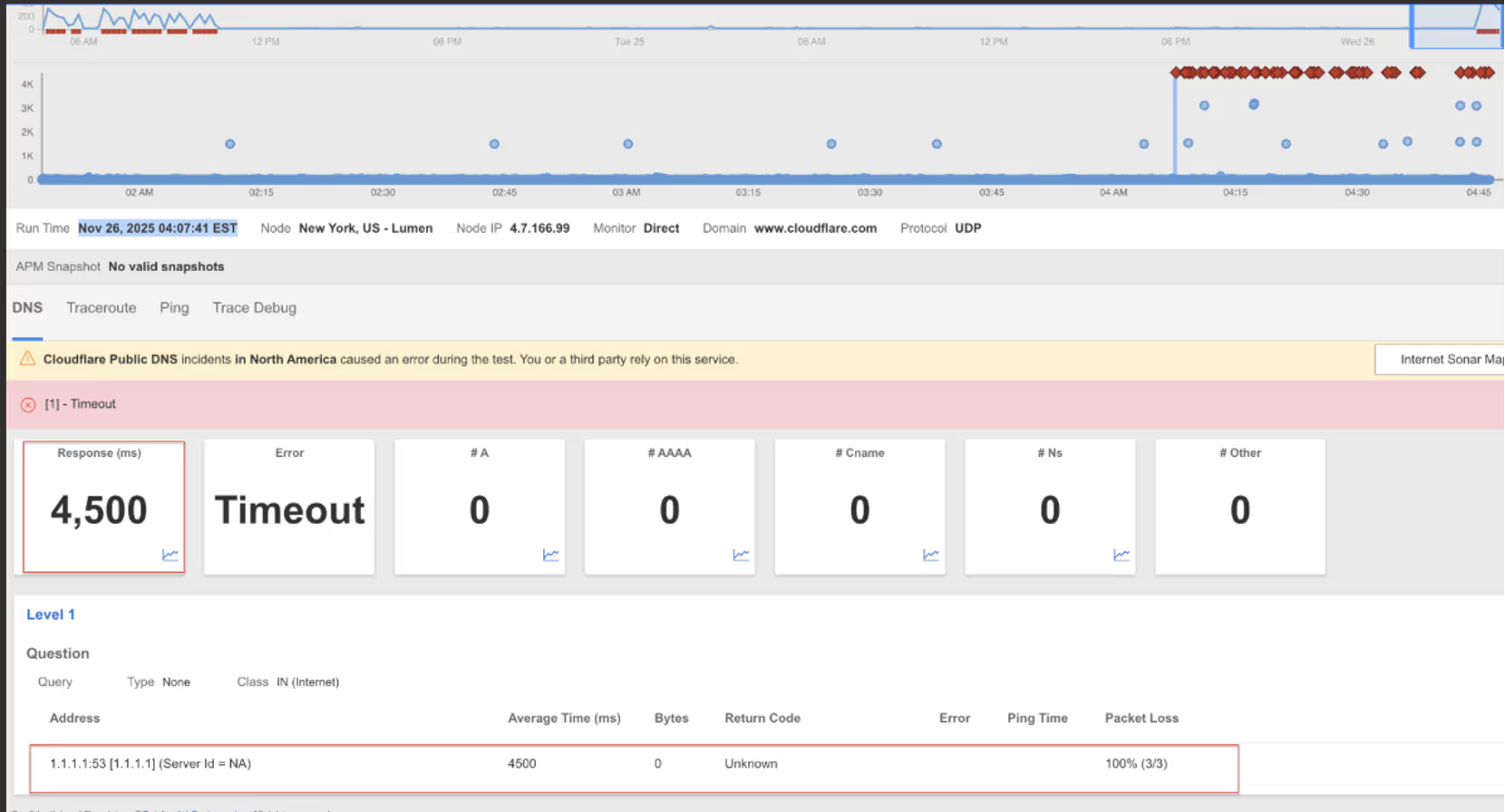

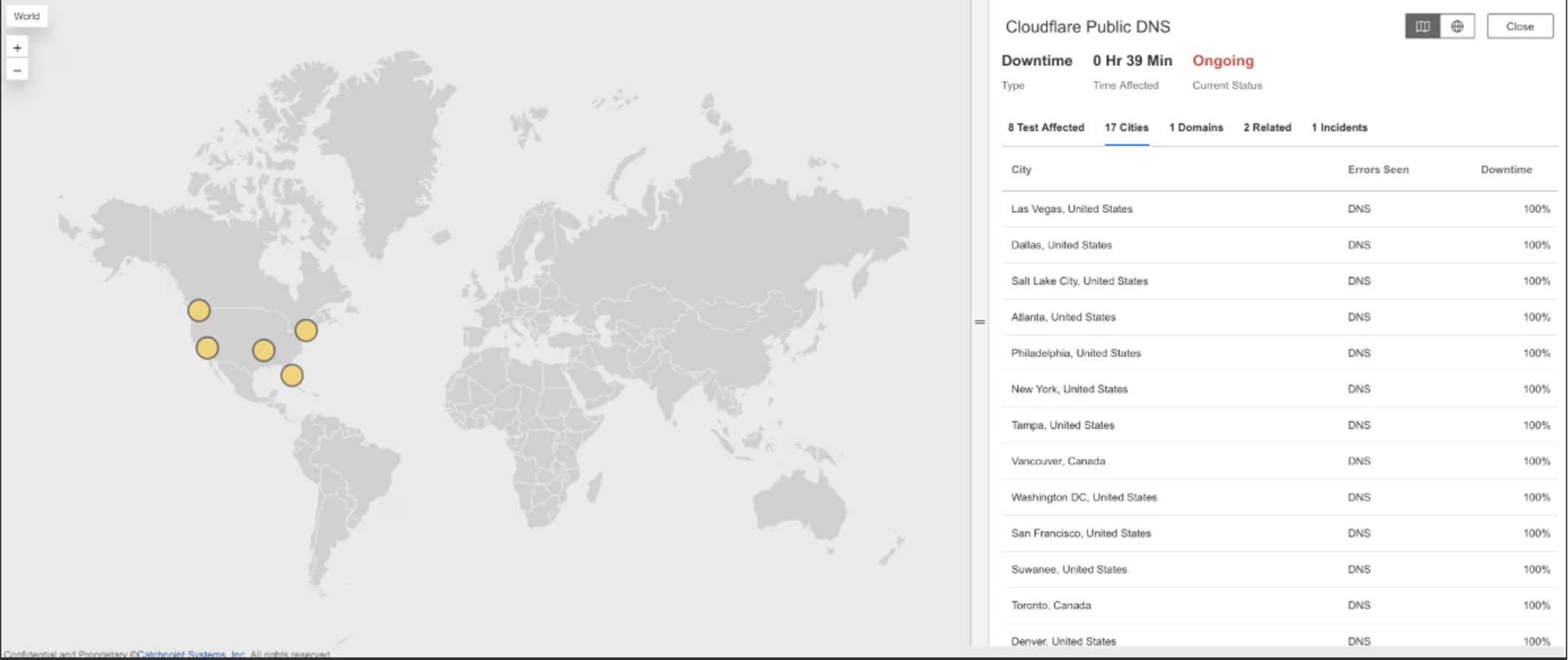

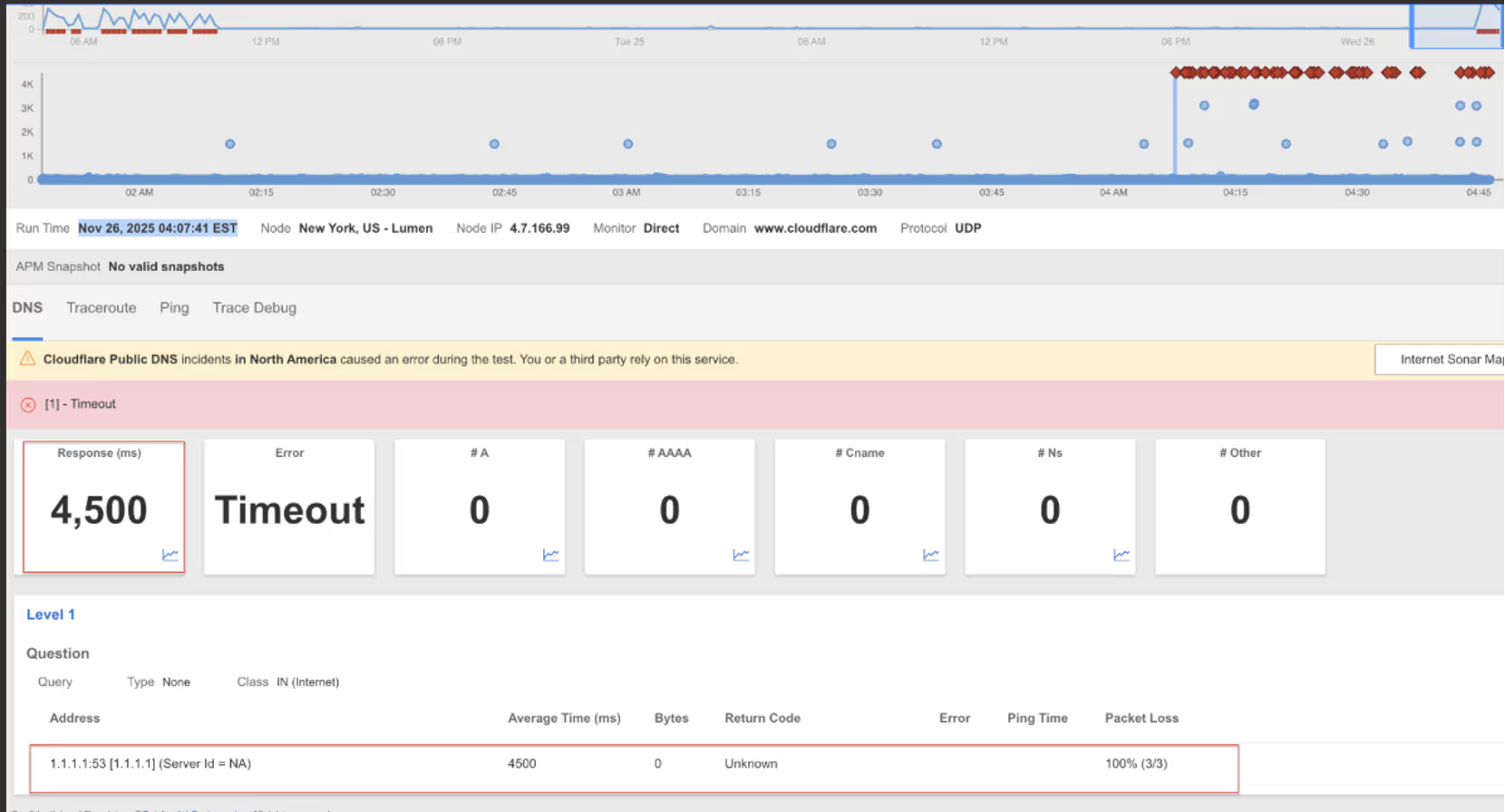

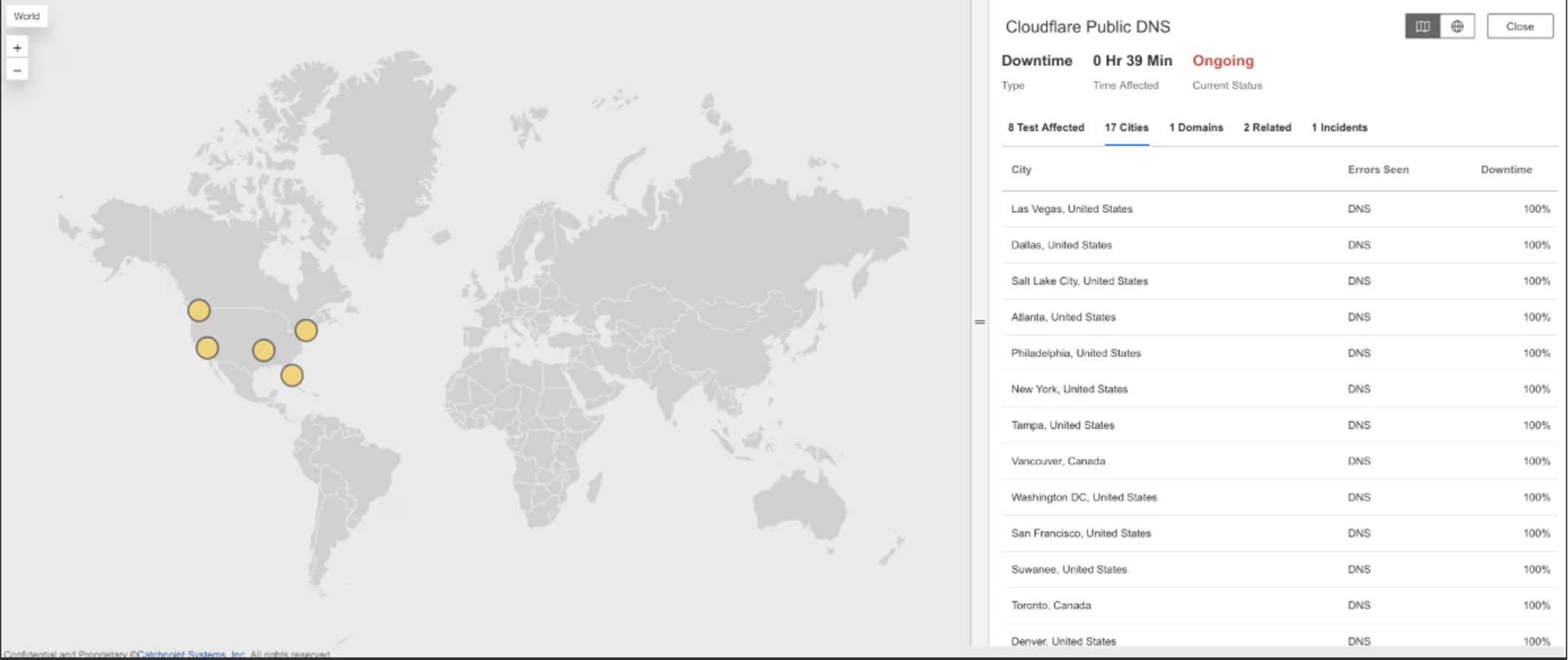

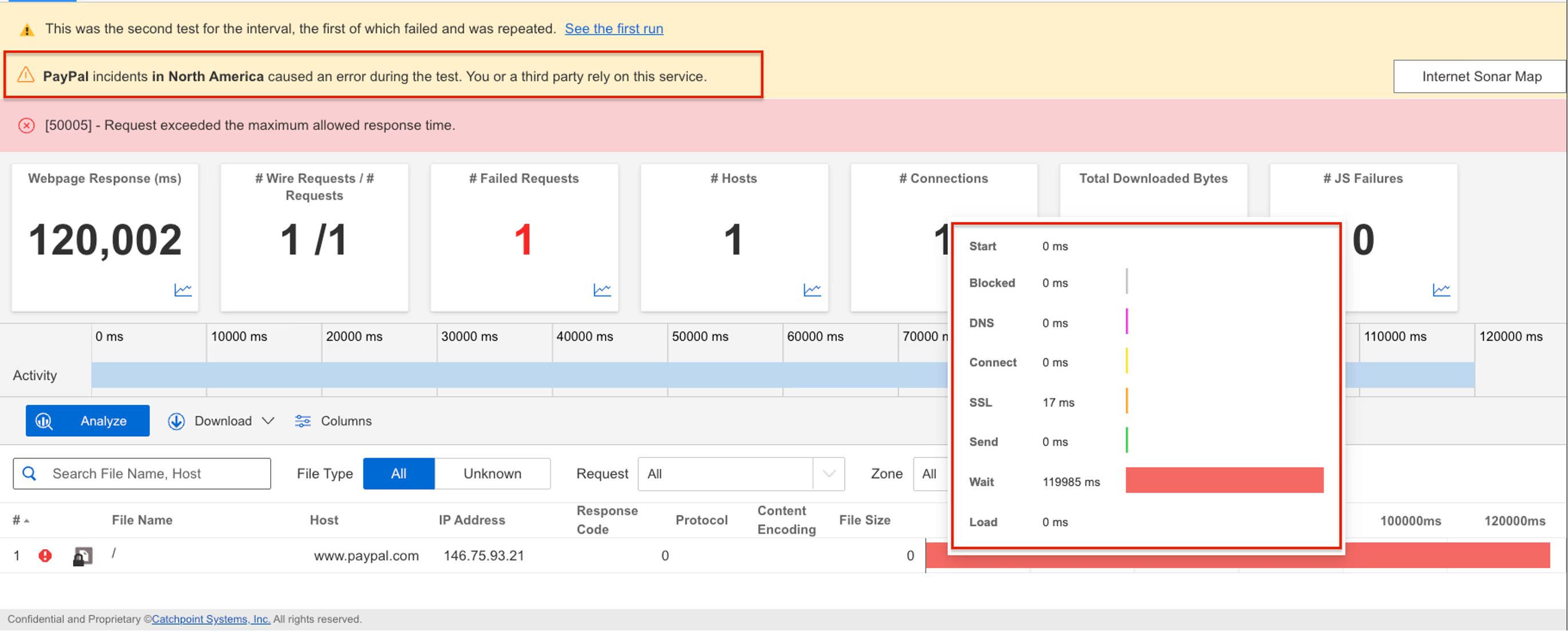

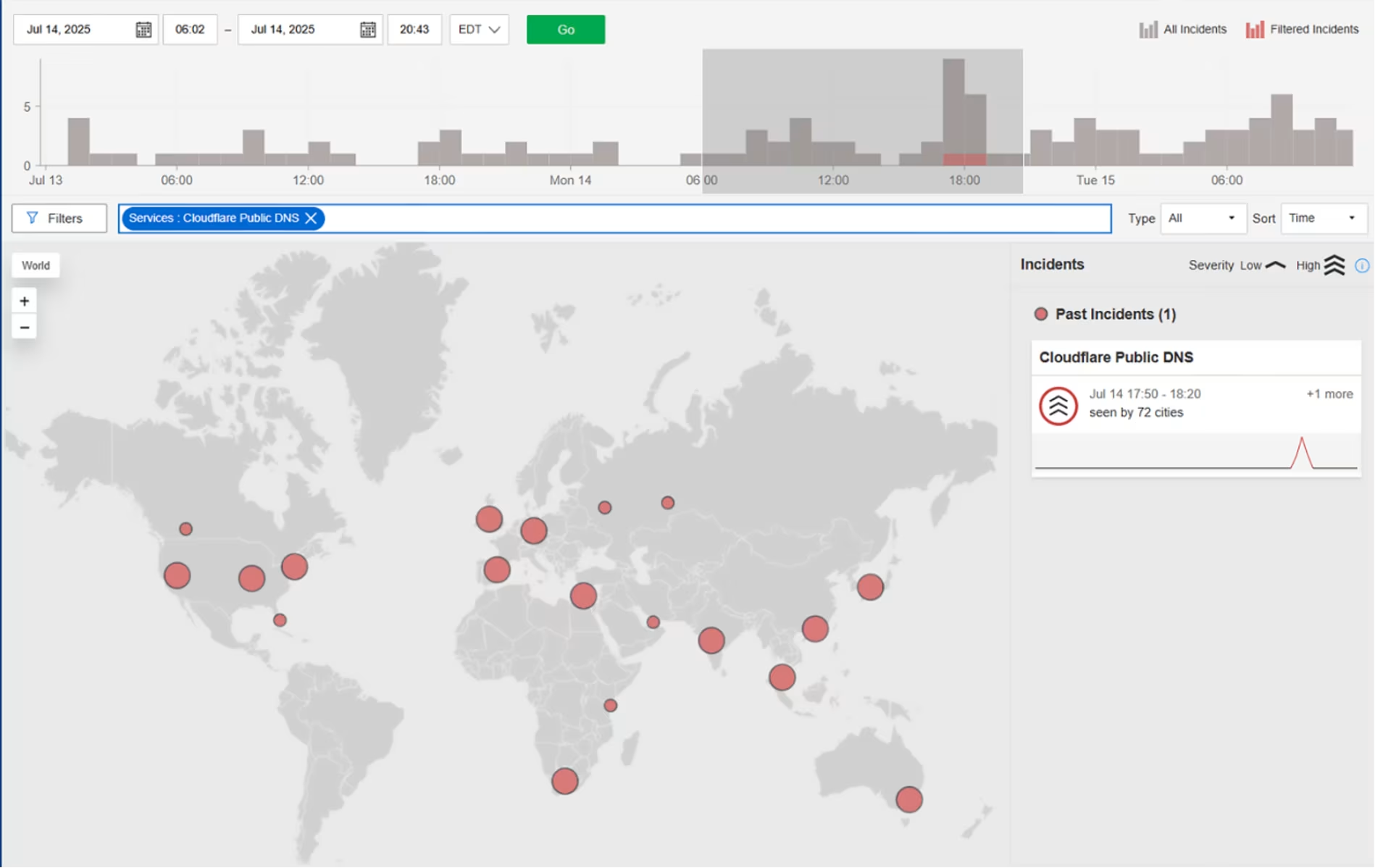

Cloudflare Public DNS 1.1.1.1

What Happened?

On November 26, 2025, at 00:28:20 EST, Internet Sonar detected an outage affecting Cloudflare Public DNS 1.1.1.1 across multiple regions, including the US, Canada, Chile, Germany, Italy, Netherlands, Peru, and Spain, timeout error for queries from Cloudflare Public DNS 1.1.1.1 resolver End users relying on Cloudflare’s 1.1.1.1 resolver may experience slowed or failed website and application lookups due to DNS queries timing out.

Takeaways

DNS timeouts are particularly disruptive because they prevent connections from starting at all, even when networks and applications are otherwise healthy. Unlike application-layer errors, DNS failures often manifest as broad, ambiguous connectivity problems across many unrelated services at once. This incident highlights how recursive resolvers act as a critical shared dependency, where localized resolver instability can cascade into widespread user-visible failures. Monitoring DNS query success rates and response times independently of application health is essential for quickly distinguishing name-resolution failures from routing, TLS, or server-side issues when large portions of the Internet appear unreachable at the same time.

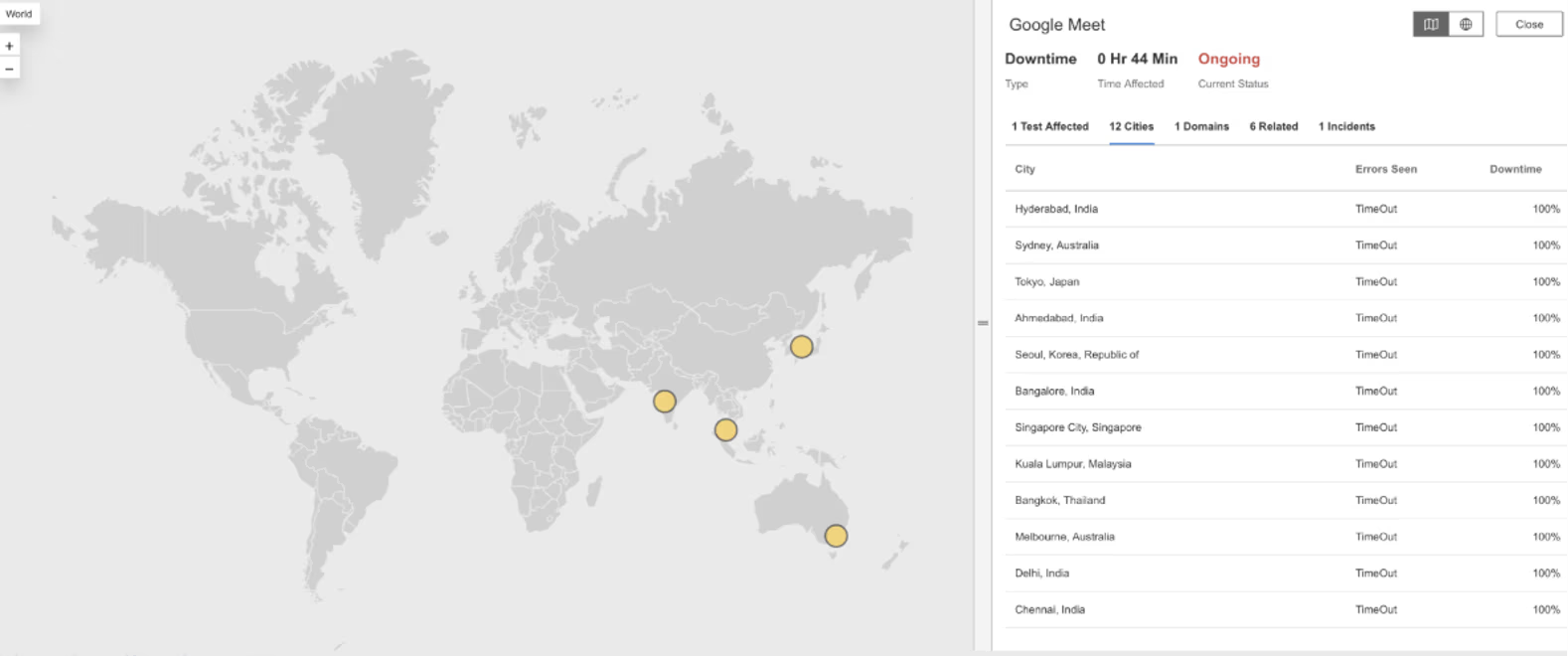

Google Meet

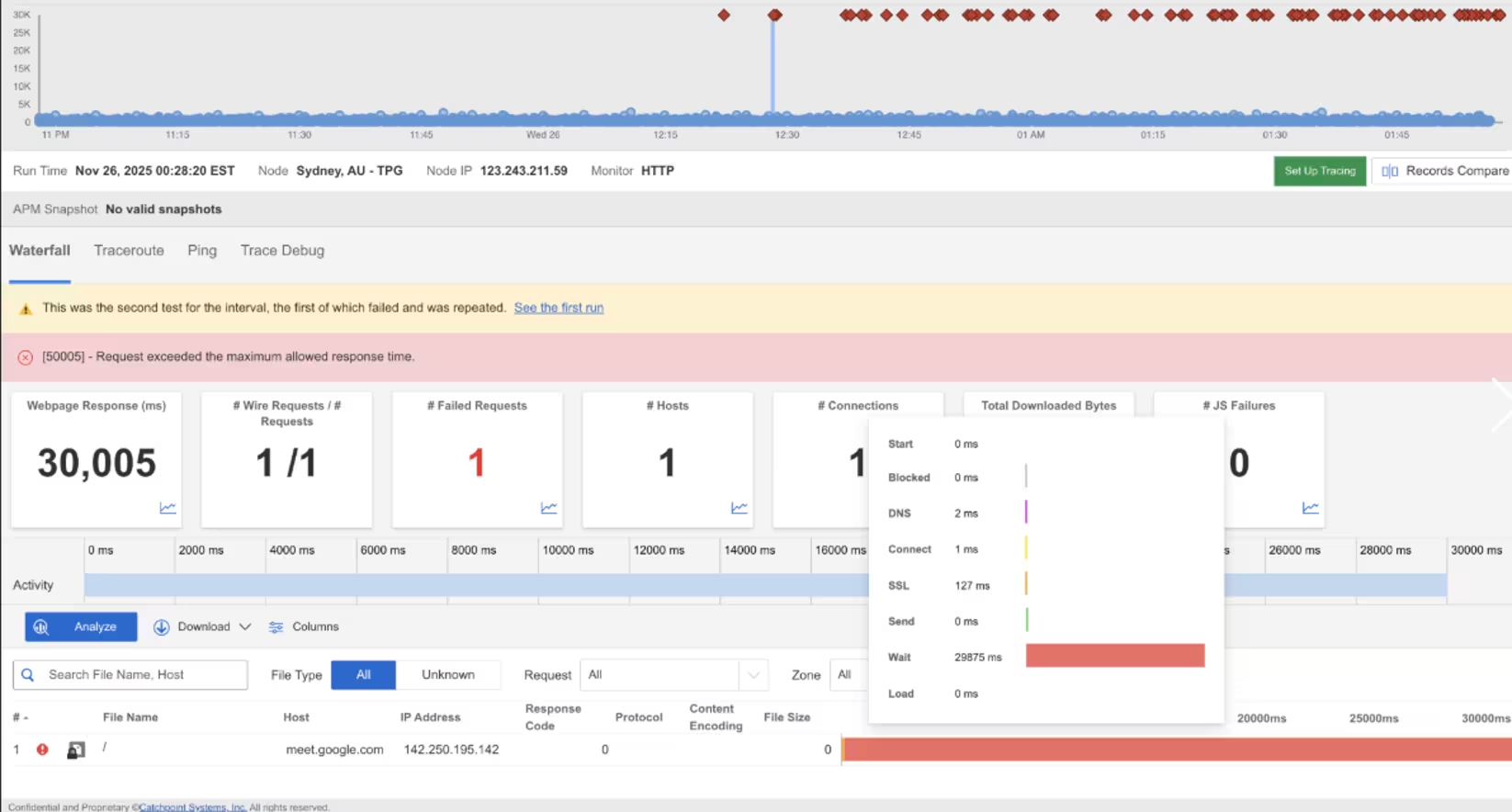

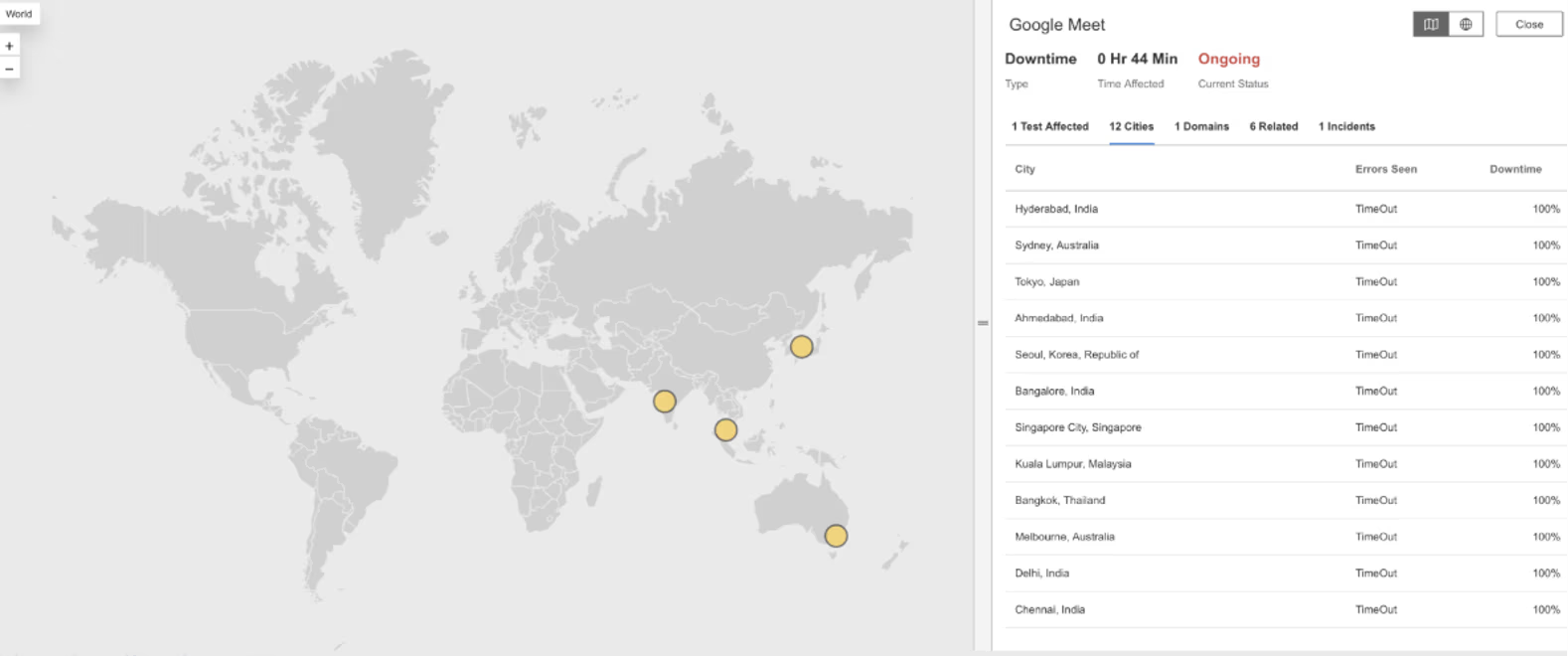

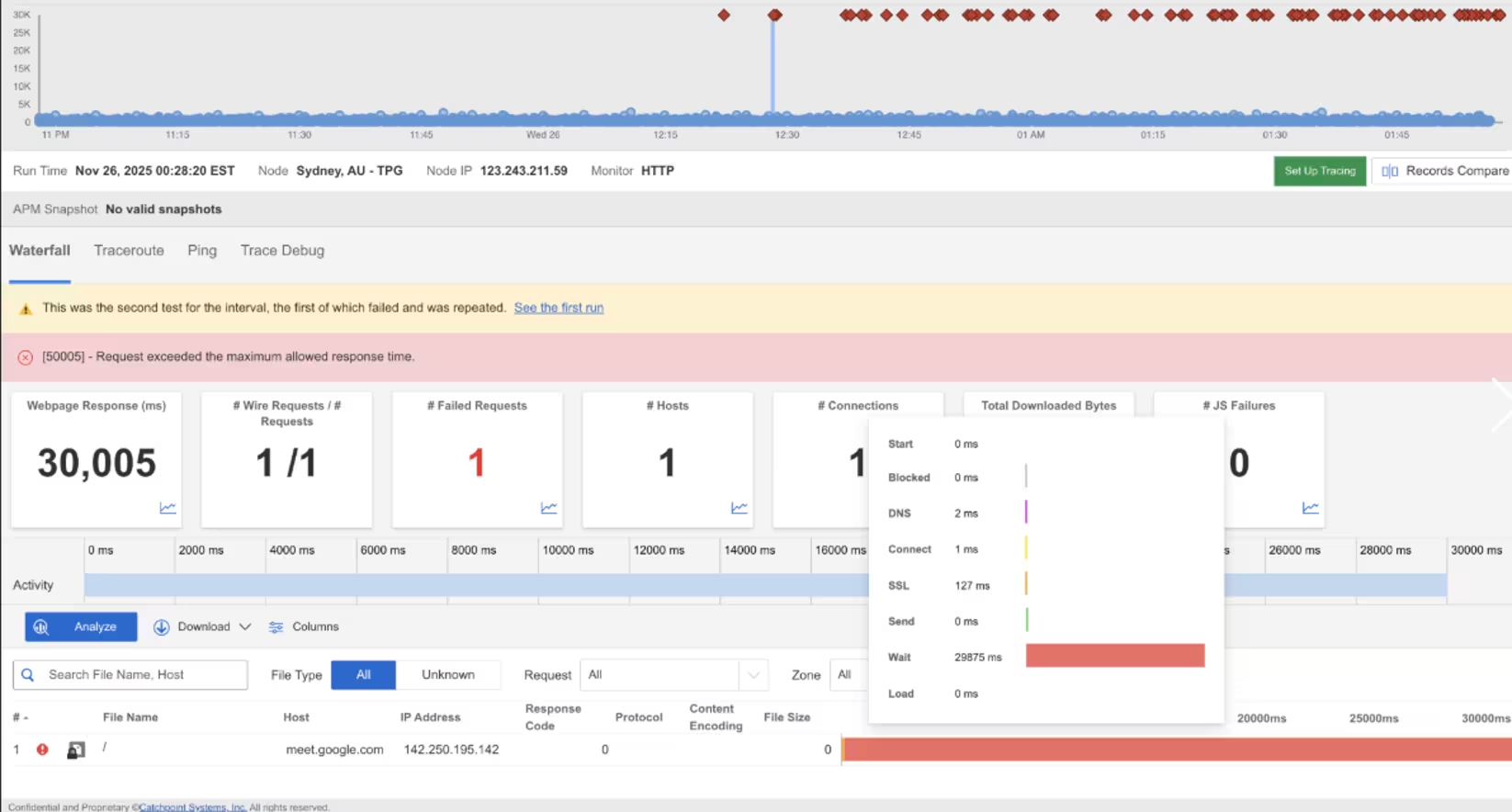

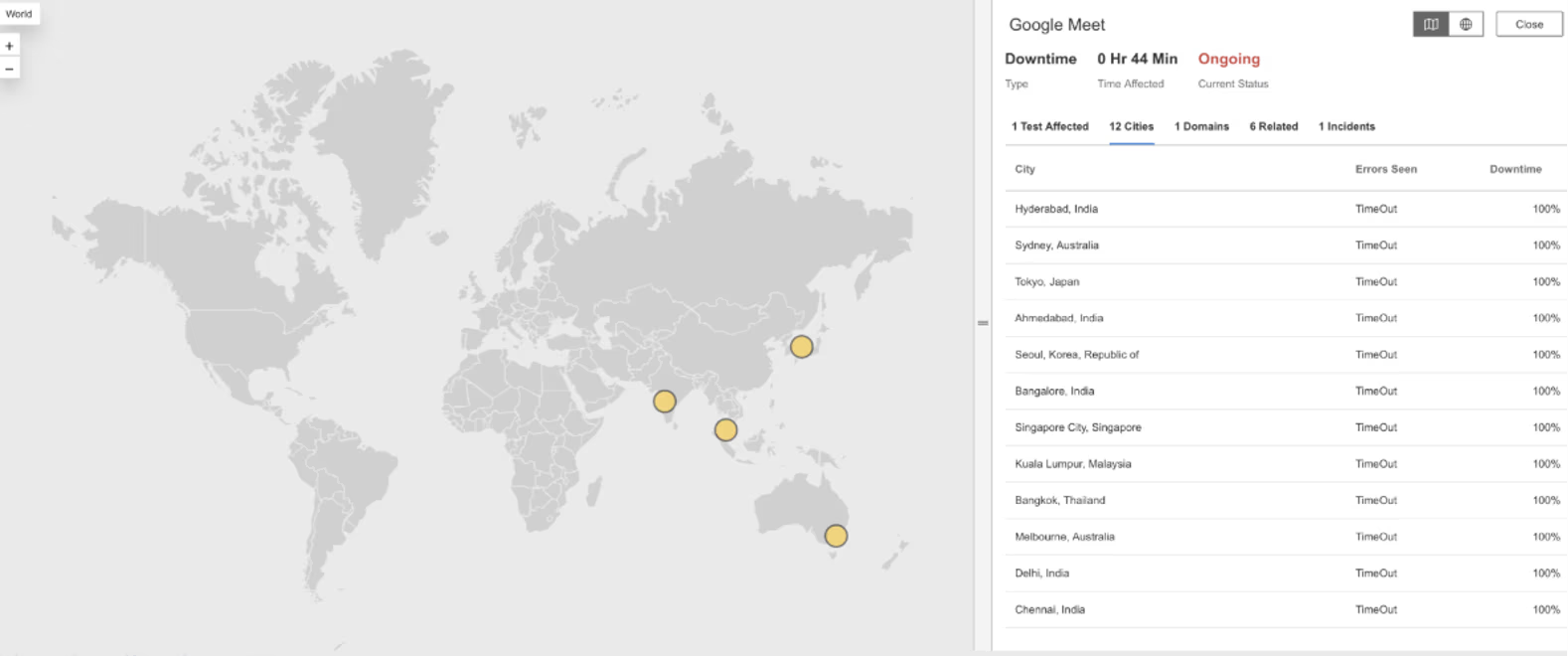

What Happened?

On November 26, 2025, at 00:28:20 EST, Internet Sonar detected an outage affecting Google Meet across multiple regions, including Australia, India, Japan, Korea, Malaysia, Singapore, and Thailand, with requests to https://meet.google.com/ experiencing high wait times from multiple locations.

Takeaways

For real-time collaboration tools, latency is as impactful as outright failure. Even when services remain technically available, delays in connection setup or signaling can disrupt meetings, audio, and video quality. This incident illustrates how regional performance degradation can disproportionately affect interactive applications compared to traditional web workloads. Monitoring latency distributions and connection setup times by region is critical for detecting these “brownout” conditions early, especially for real-time services where user tolerance for delay is extremely low and performance issues surface immediately as usability problems.

Granify

What Happened?

On November 18, 2025, at 19:12:42 EST, Internet Sonar detected an outage affecting Granify across multiple regions, including the US, UK, Canada, Australia, and many others, with requests to matching.granify.com returning HTTP 502 (Bad Gateway – the server received an invalid response from an upstream server) from multiple locations.

Takeaways

HTTP 502 errors appearing simultaneously across regions indicate a failure between service layers, where Granify’s front-facing systems remained reachable but could not successfully communicate with upstream dependencies. This pattern often points to instability in shared backend services, partner integrations, or origin systems rather than edge connectivity issues. Because these failures surface at the gateway boundary, they can affect all regions at once even if the underlying problem originates in a single dependency. Tracking where errors occur in the request chain helps distinguish upstream dependency failures from application bugs and highlights how tightly coupled integrations can amplify blast radius during global incidents.

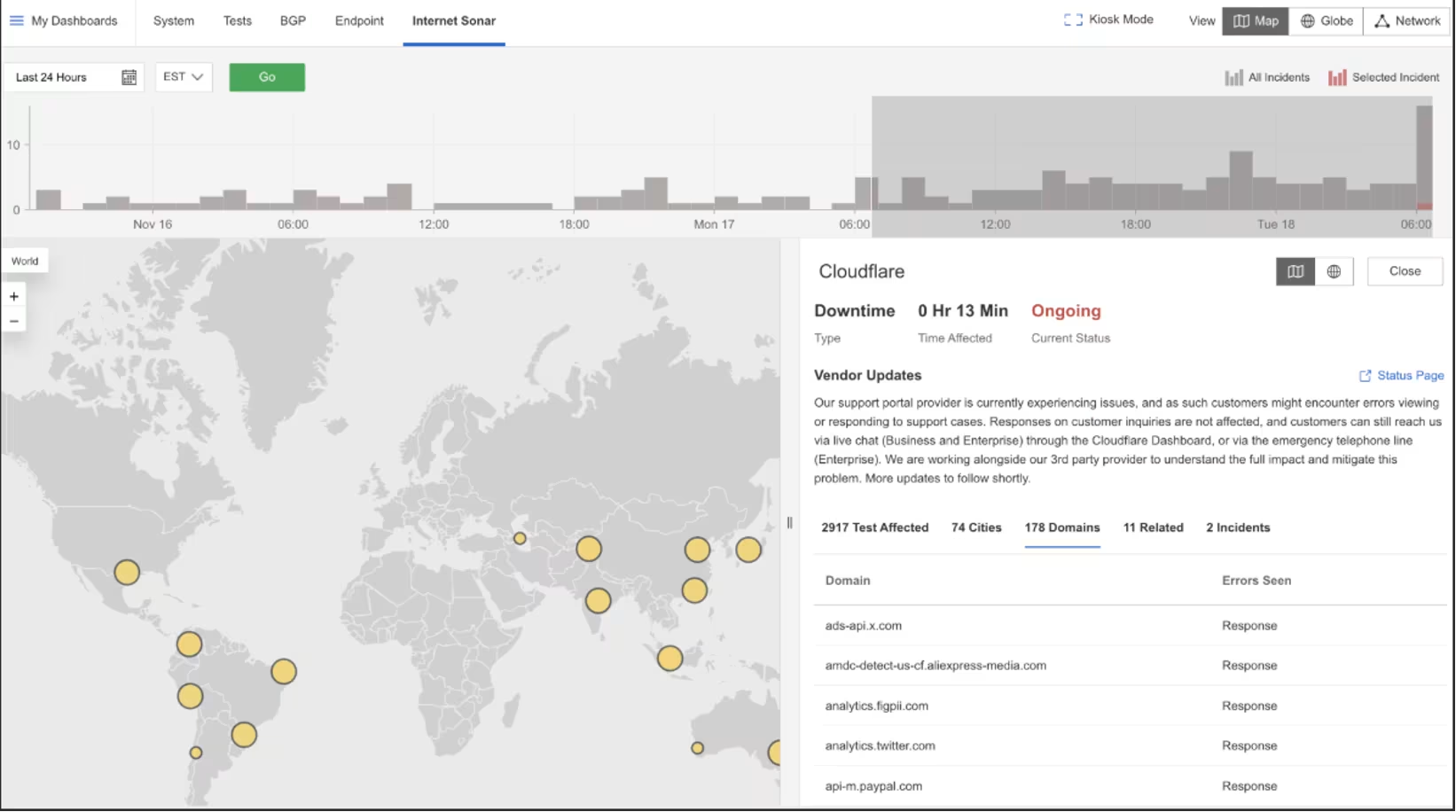

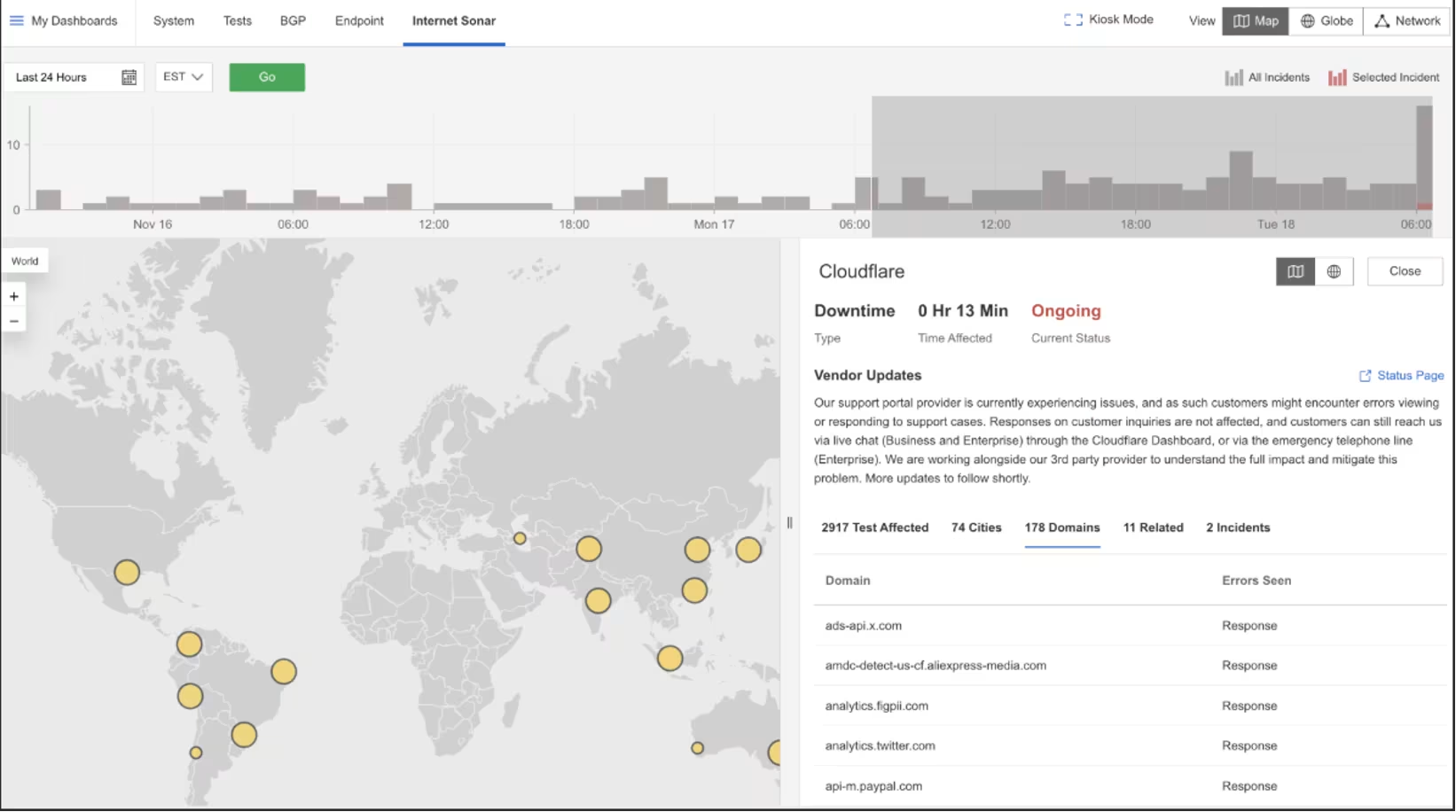

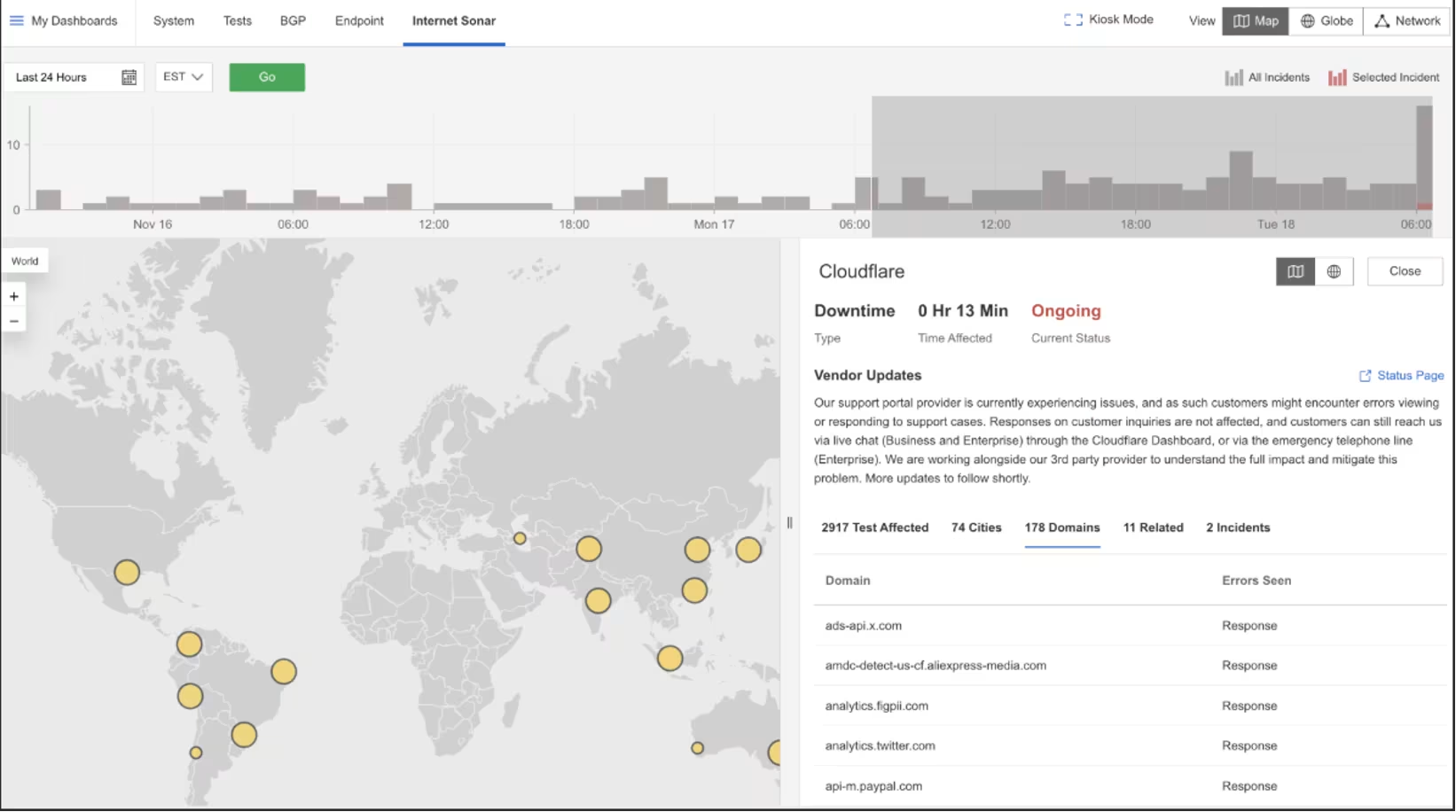

Cloudflare

What Happened?

On November 18, 2025, at 06:30:40 EST, Internet Sonar detected an ongoing outage affecting Cloudflare globally, with multiple domains returning HTTP 500 (internal server error – the server encountered an unexpected condition preventing it from fulfilling the request).

Takeaways

HTTP 500 errors at global scale typically point to failures within a provider’s internal control plane or shared service logic, rather than connectivity, routing, or origin reachability problems. When a core internal component fails, edge locations may remain reachable but still be unable to serve traffic correctly. This incident highlights how control-plane instability can surface externally as widespread application errors, even when network paths and customer origins are healthy. Distinguishing 500-level errors from 502/503 responses is critical, as they signal fundamentally different failure modes and help teams avoid misattributing global platform issues to customer infrastructure or Internet routing problems.

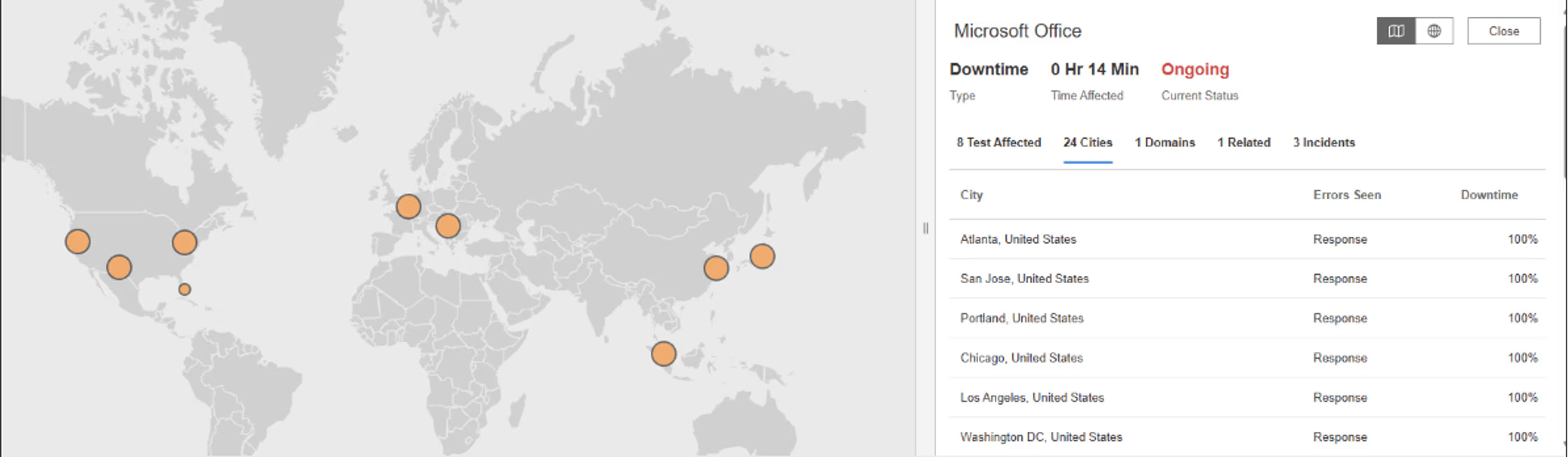

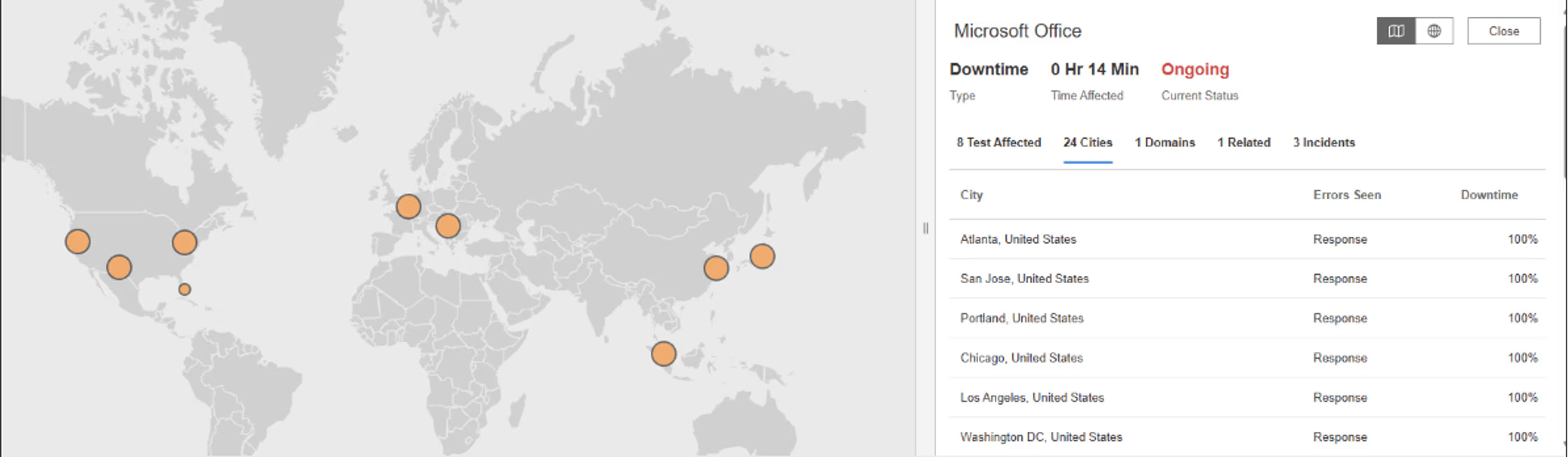

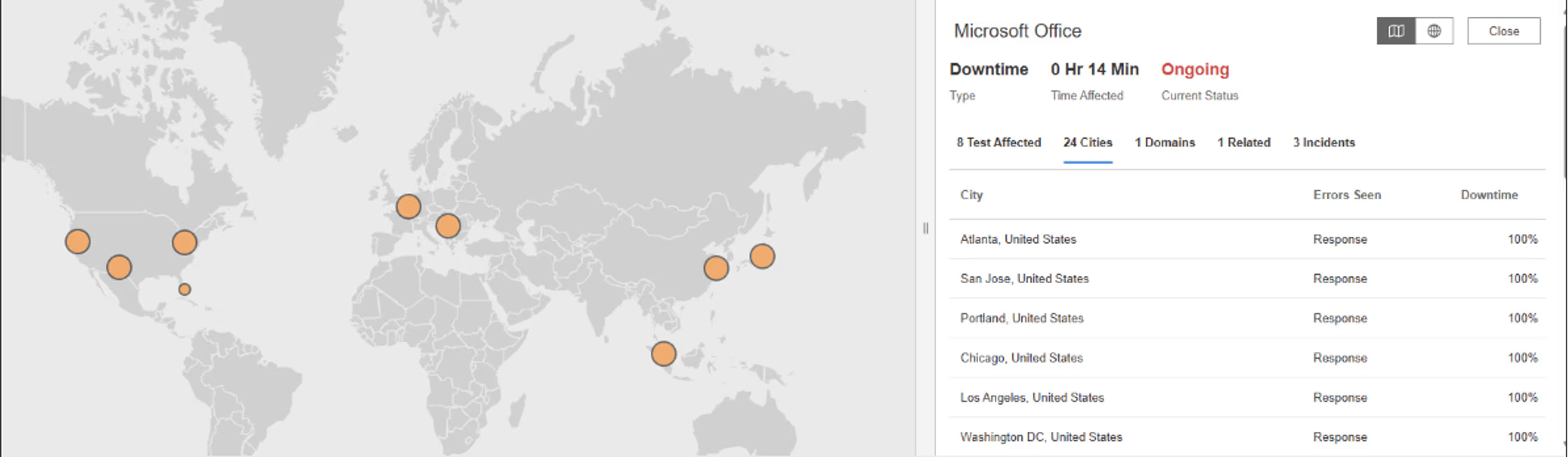

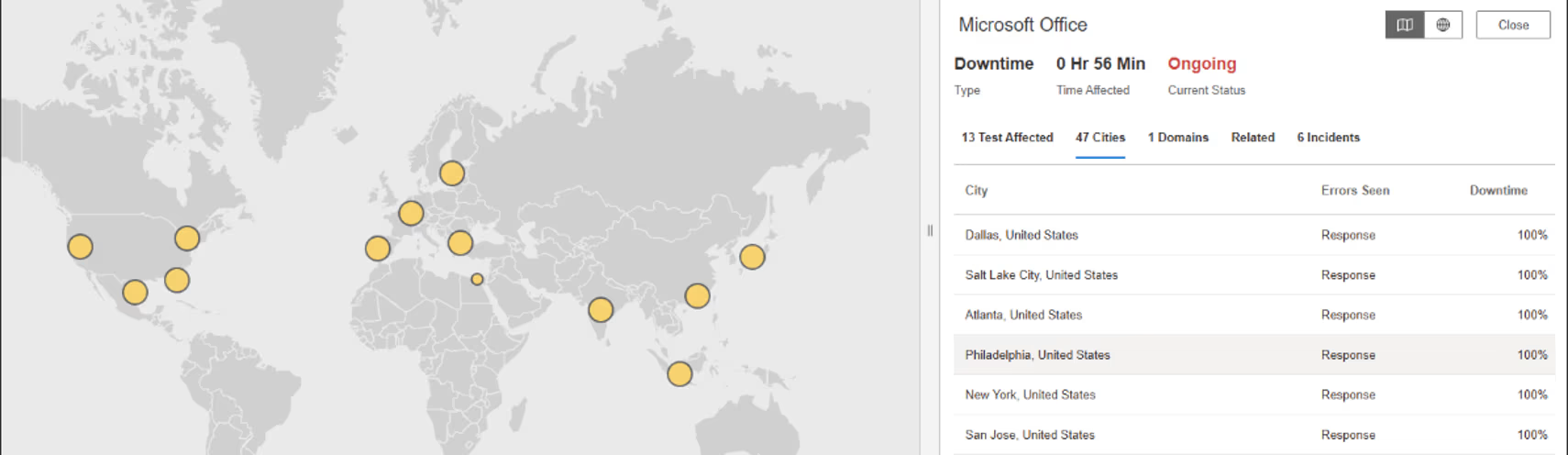

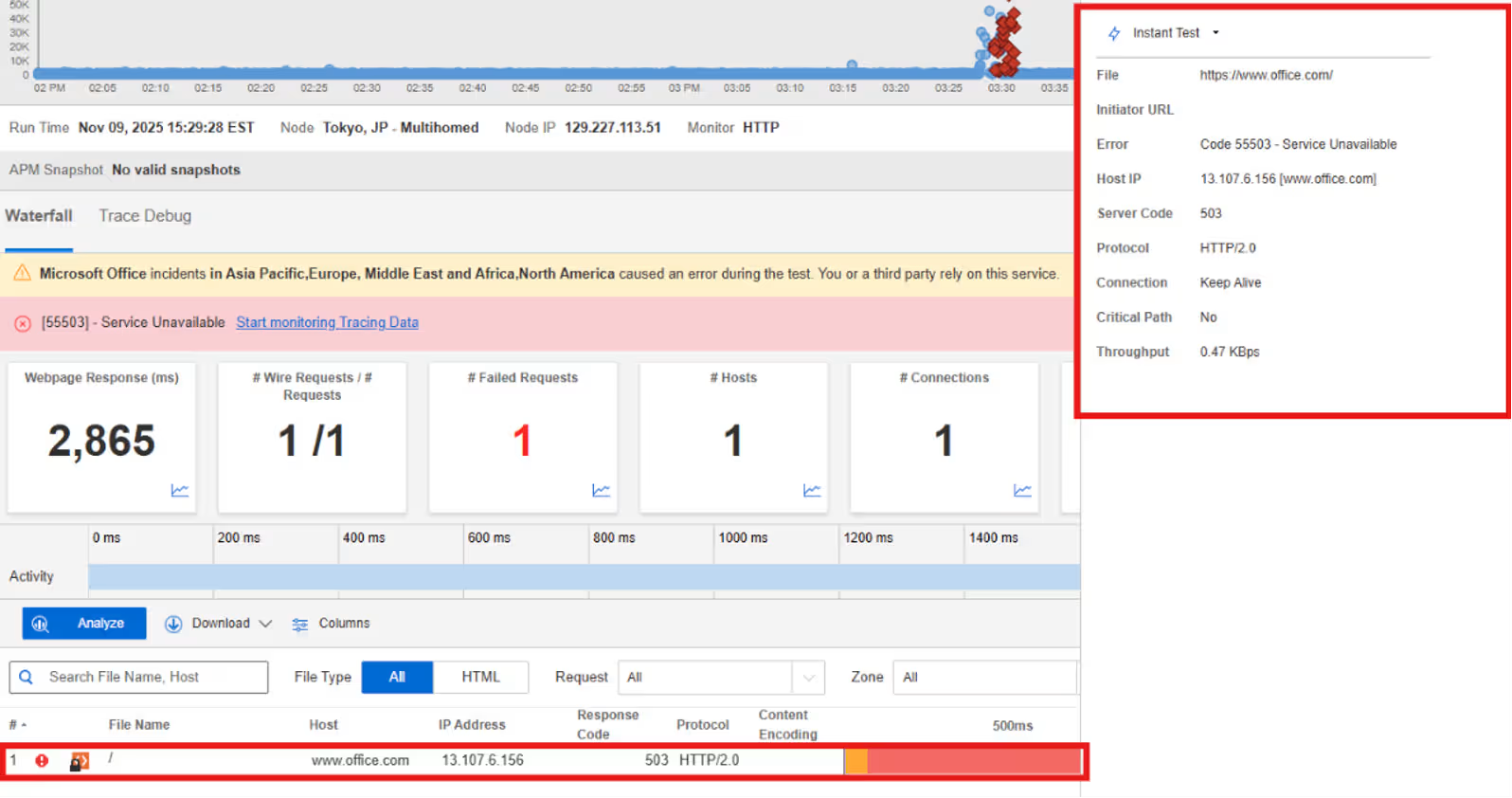

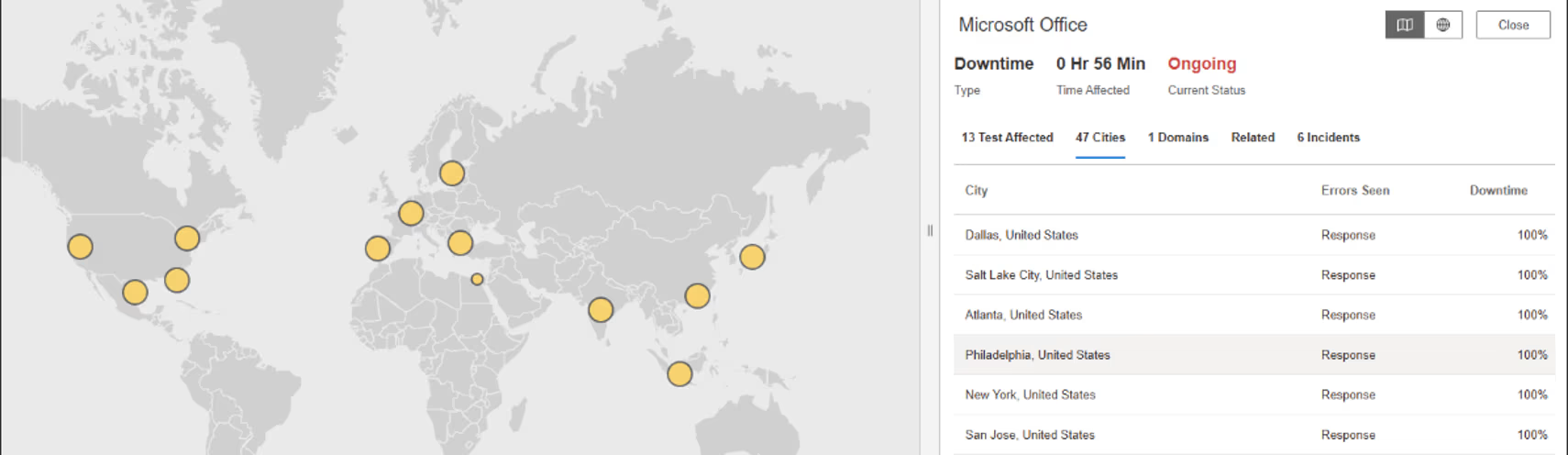

Microsoft Office

What Happened?

On November 18, 2025, at 01:43:53 EST, Internet Sonar detected an outage affecting Microsoft Office across multiple regions, including the US, Canada, Japan, and China. Requests to www.office.com began returning HTTP 503 (service unavailable response code – server temporarily unable to handle requests) from multiple locations.

Takeaways

Simultaneous HTTP 503 errors across multiple regions suggest a failure or overload in a shared service layer rather than isolated regional incidents. For large SaaS platforms, this often points to dependencies such as authentication, configuration services, or internal APIs that gate access to many front-end workloads at once. Even when infrastructure remains online, loss of readiness in these shared components can block user access globally. This incident highlights how global capacity management and dependency health are critical to preventing broad availability drops, and why understanding which shared services sit on the critical path is essential for limiting blast radius during platform-wide events.

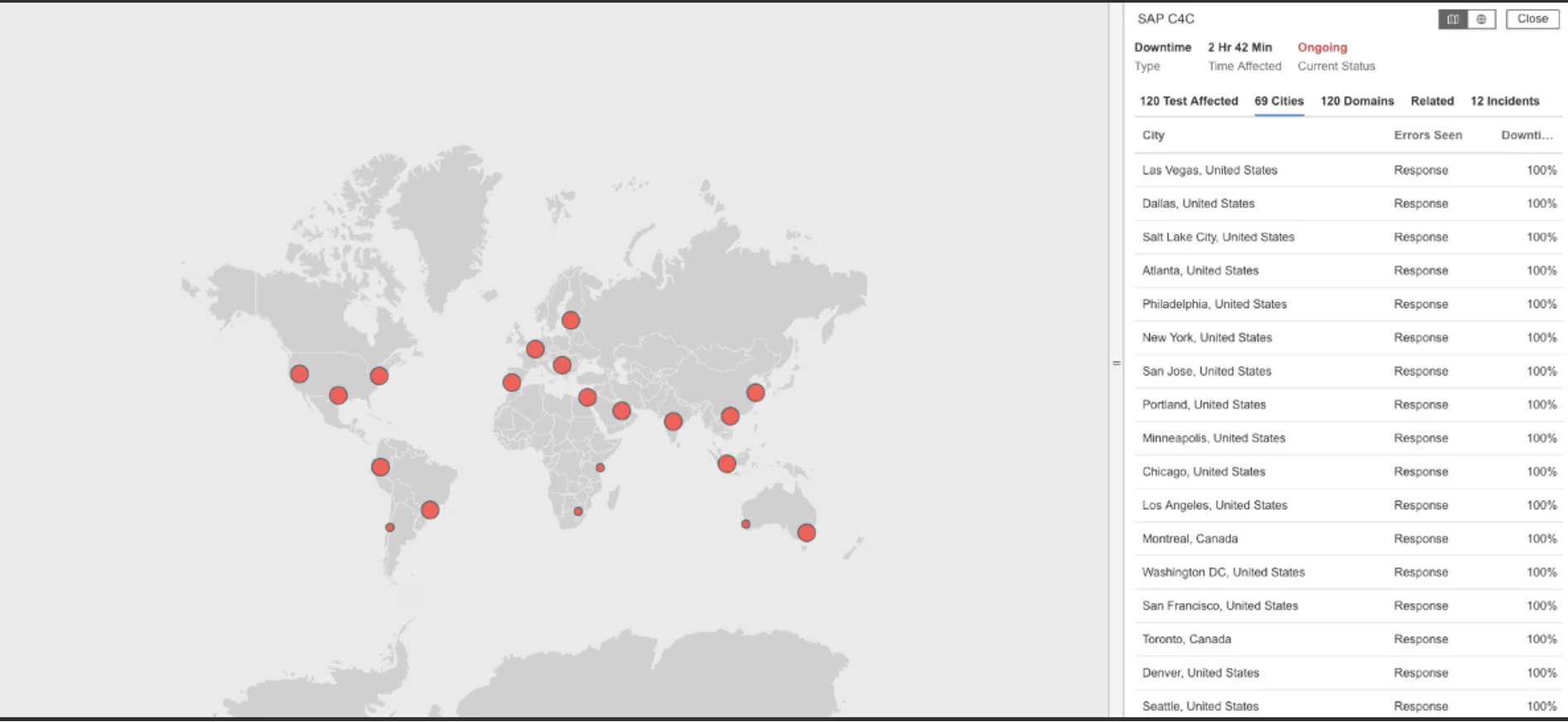

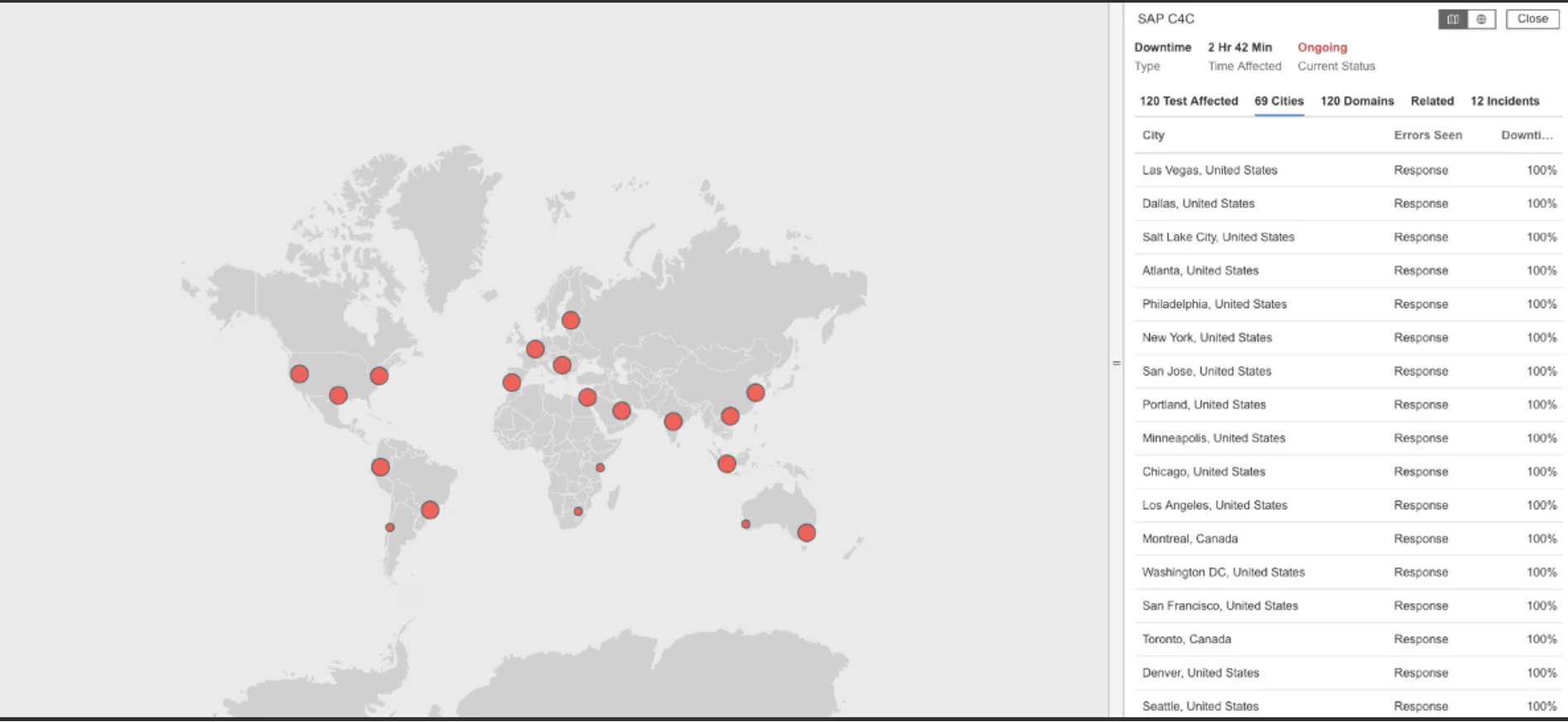

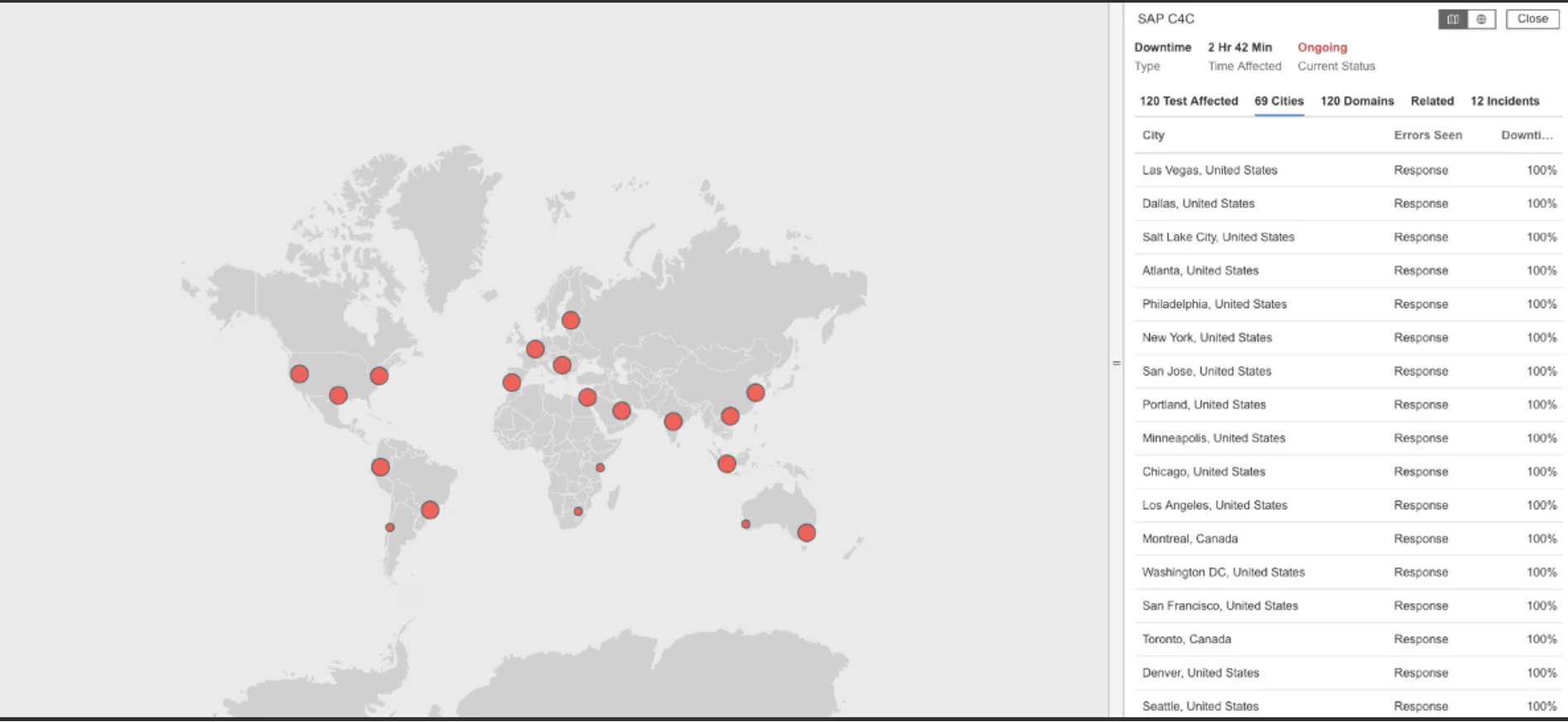

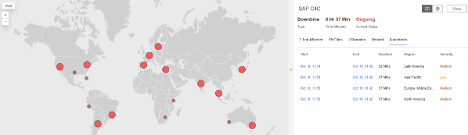

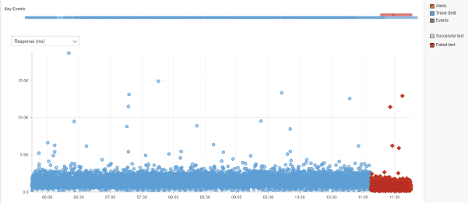

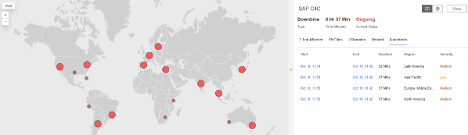

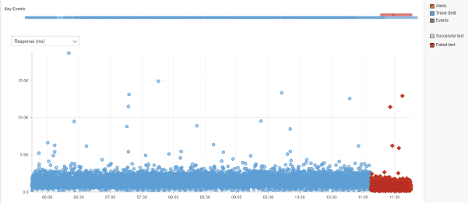

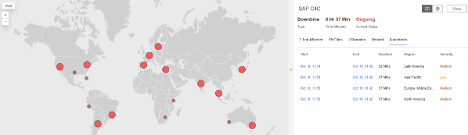

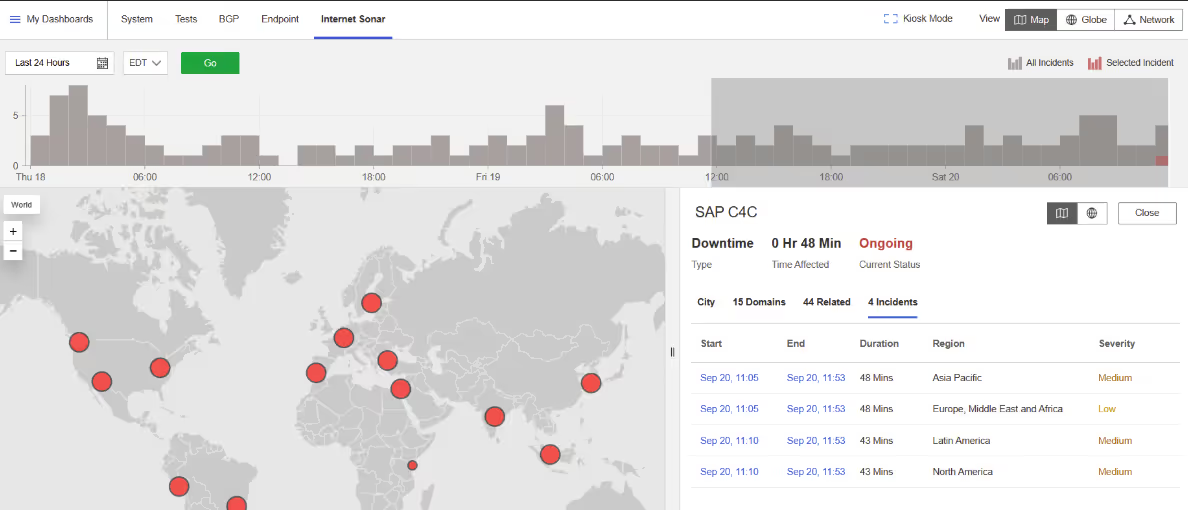

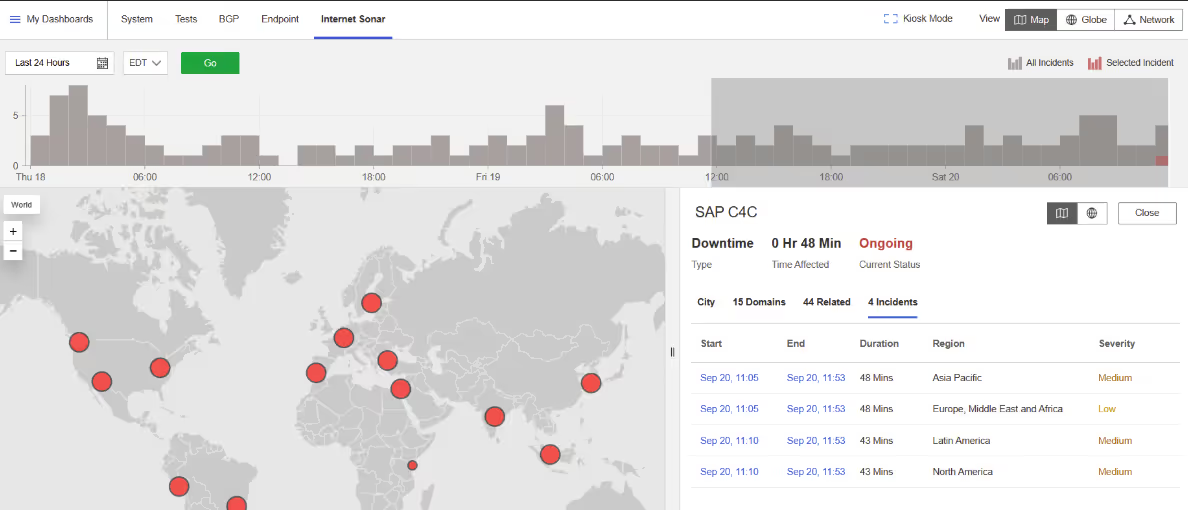

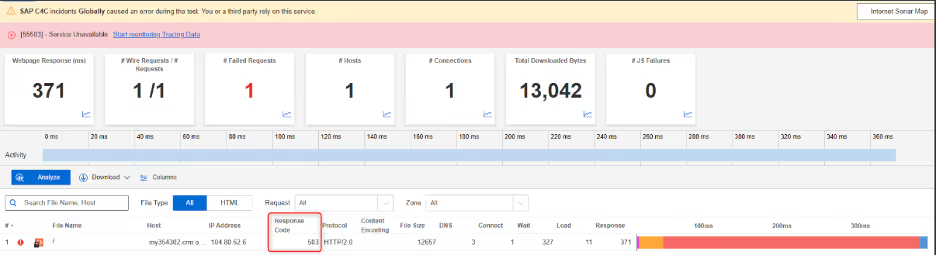

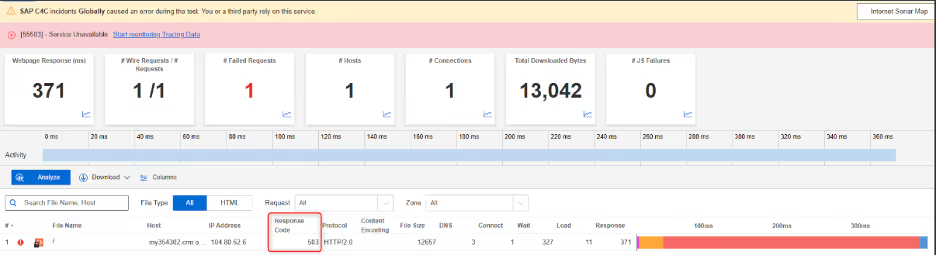

SAP C4C

What Happened?

On November 15, 2025, at 08:05:49 EST, Internet Sonar detected a global outage affecting SAP C4C across multiple regions. Requests to several crm.ondemand.com domains began returning HTTP 503 (service unavailable response code – server temporarily unable to handle requests) from multiple locations, preventing users from logging in to sap service.

Takeaways

Login failures caused by HTTP 503 errors often point to issues in authentication or session-establishment services, which act as hard gates to the rest of the application. Even when core CRM functionality may still be operational, loss of the login path effectively renders the platform unusable. This incident highlights how authentication services represent high-blast-radius dependencies in SaaS platforms, where a single failure can block all user access globally. Tracking availability separately for login flows versus post-login application paths helps distinguish authentication-layer outages from broader application failures and speeds up root cause isolation when users report being “locked out” rather than seeing functional errors.

Microsoft Office

What Happened?

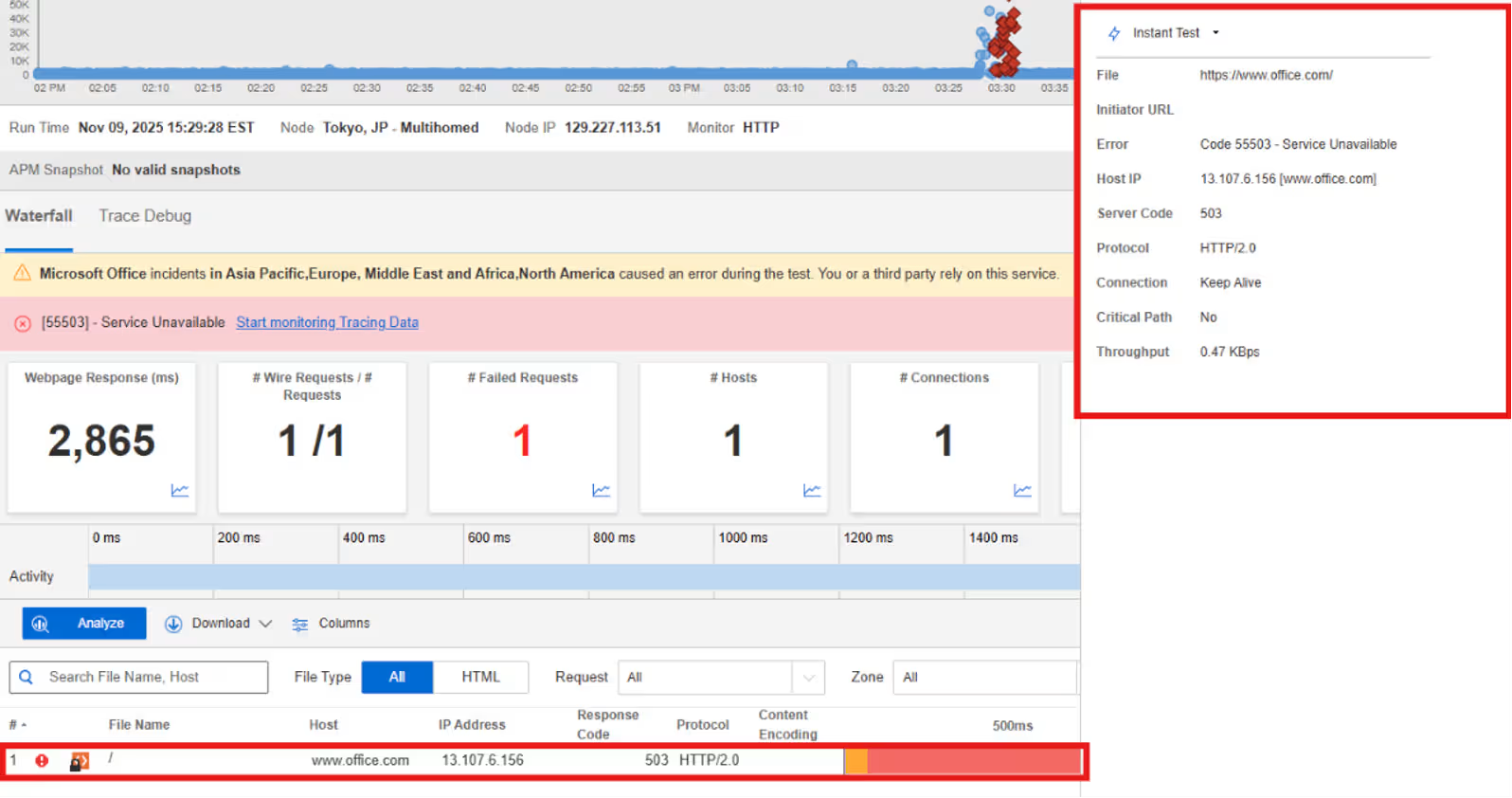

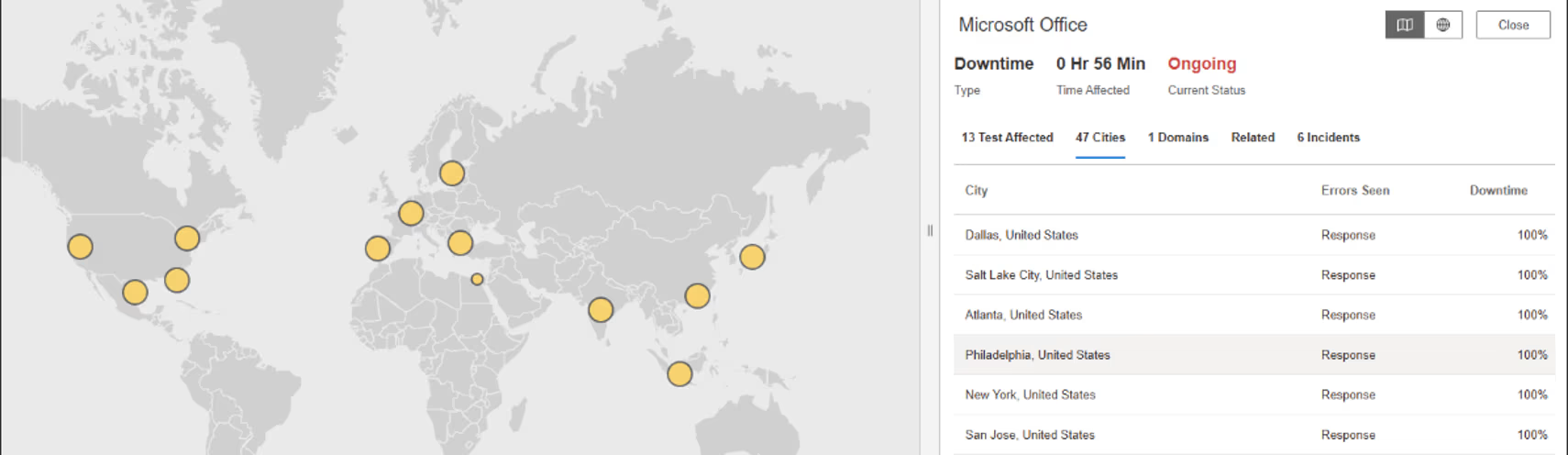

On November 9, 2025, at 15:29:28 EST, Internet Sonar detected an outage affecting Microsoft Office across multiple regions, including the US, Canada, Sweden, Norway, Poland, the UK, and France. Requests to www.office.com began returning HTTP 503 (service unavailable response code – server temporarily unable to handle requests)

Takeaways

A sudden wave of HTTP 503 errors across geographies often reflects systems hitting readiness or admission limits, where traffic arrives successfully but cannot be safely accepted. In large productivity platforms, this can be triggered by demand spikes, backend throttling, or protective load-shedding mechanisms designed to prevent deeper failures. While these safeguards help preserve overall platform stability, they surface externally as user-facing downtime. This incident highlights the importance of understanding how and when services shed load, and how traffic patterns can push global platforms past readiness thresholds even when infrastructure remains online.

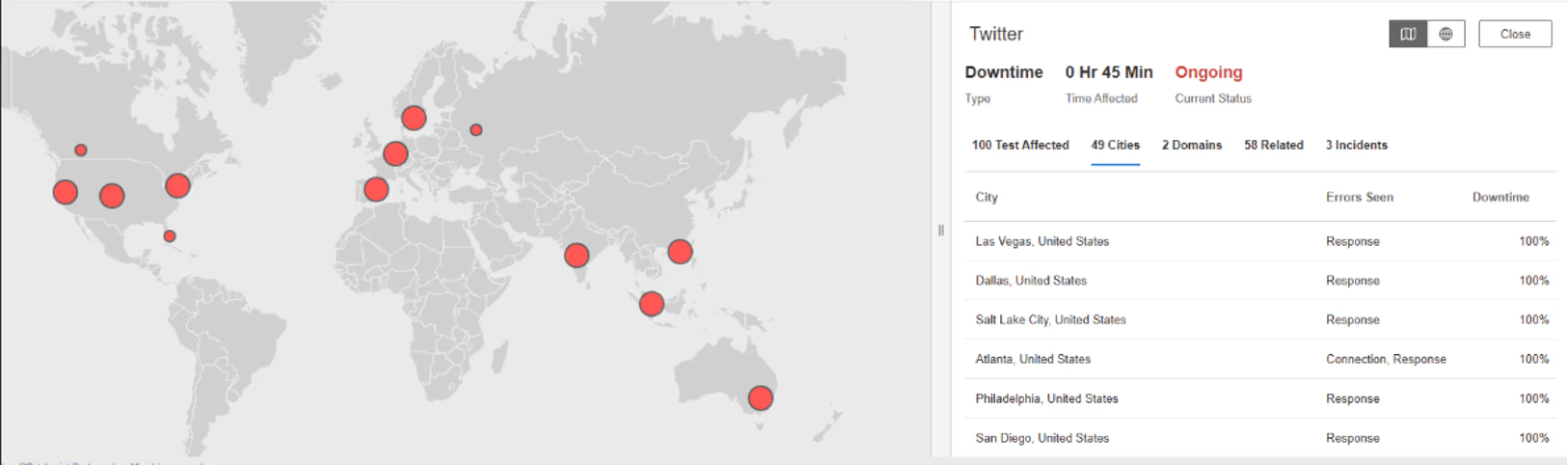

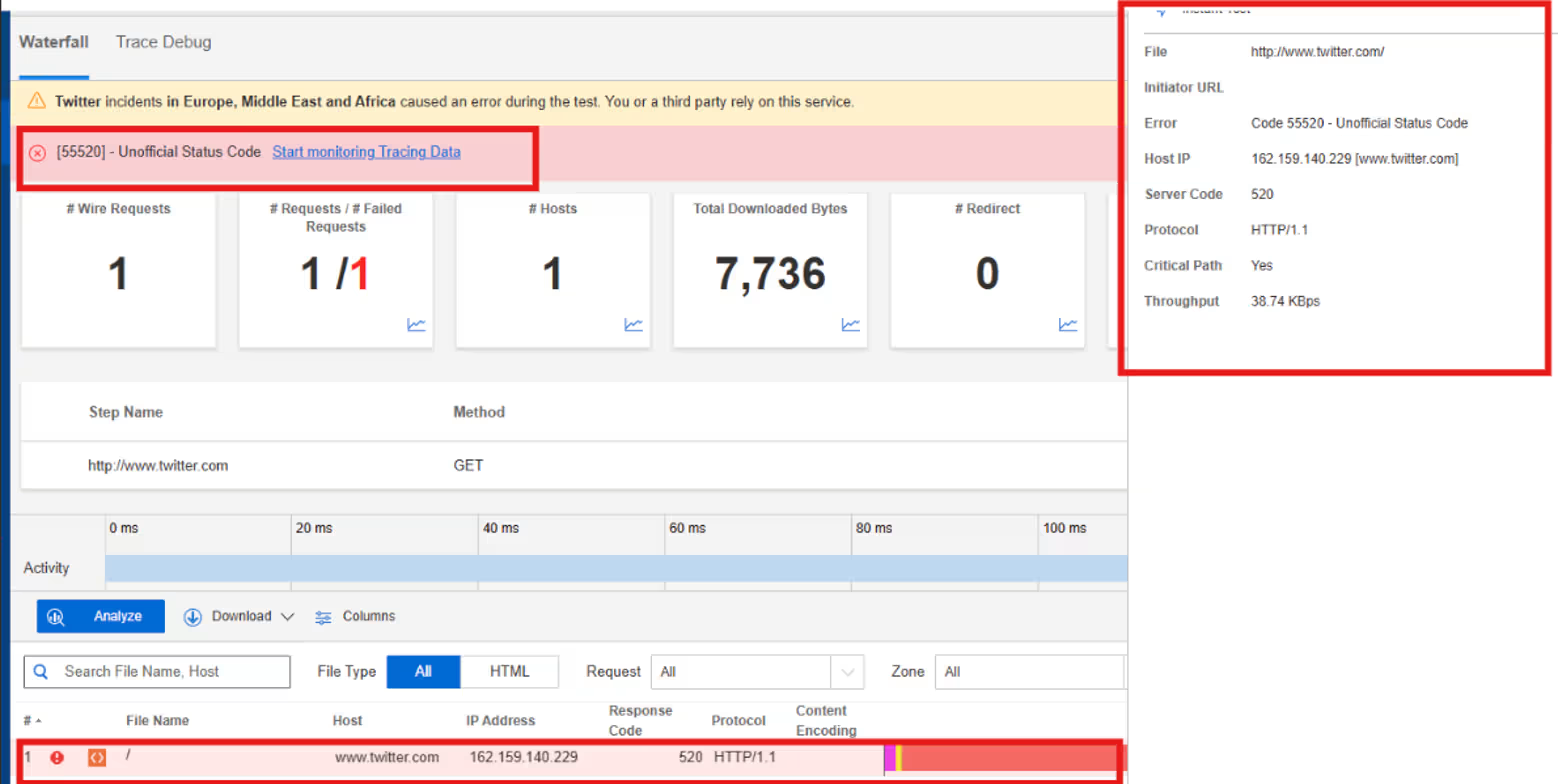

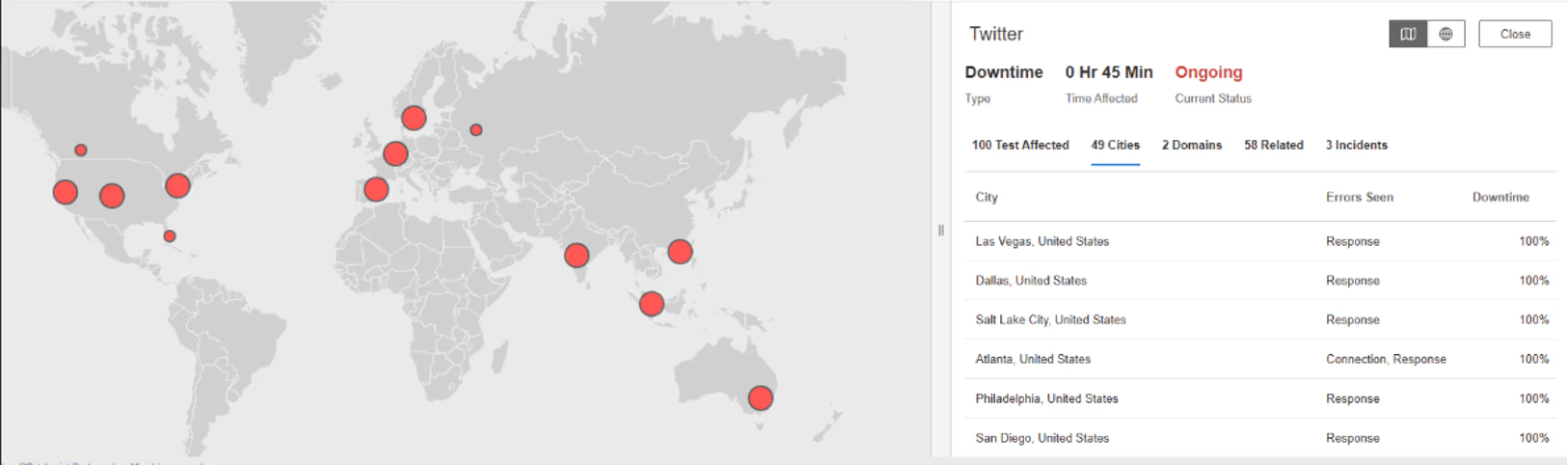

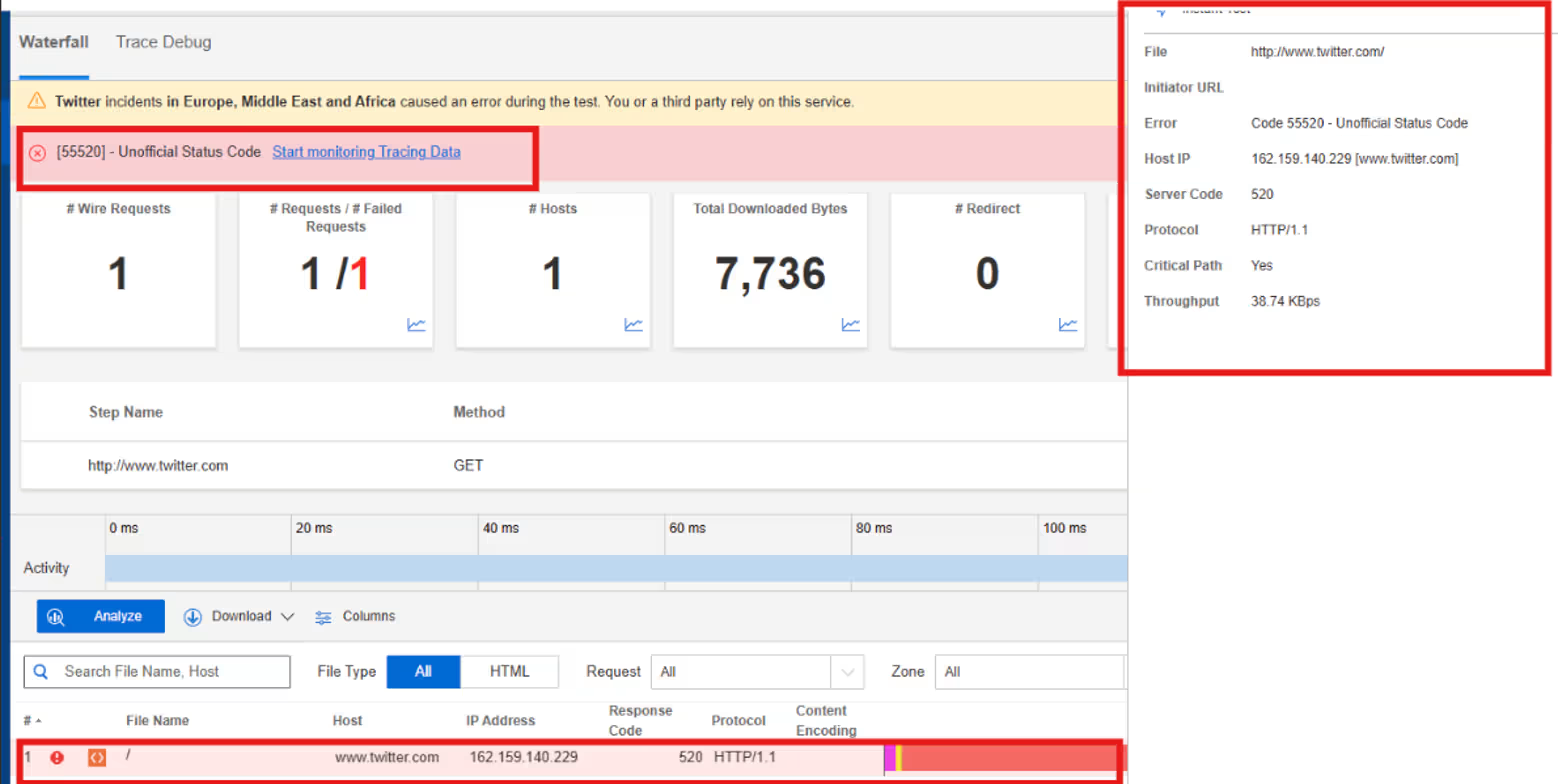

X Corp. (Twitter)

What Happened?

On November 6, 2025, at 01:56:11 EST, Internet Sonar detected an outage affecting X across multiple regions, including the US, France, UK, Germany, Singapore, Ireland, and Australia. Requests to X.com began returning HTTP 520 (a server error returned when the origin gives an unexpected or invalid response) from multiple locations.

Takeaways

HTTP 520 errors sit at the boundary between edge infrastructure and origin services, signaling failures that don’t cleanly map to standard application or server error codes. This type of error often appears when origin servers crash mid-response, return malformed data, or reset connections unexpectedly. Because the edge remains reachable, failures can surface globally and simultaneously, even if the underlying issue is confined to a subset of origin systems. This incident highlights how edge–origin contract violations can produce opaque errors that are difficult to diagnose without visibility into both sides of the delivery path, and why tracking error semantics is critical for distinguishing protocol-level failures from pure application or capacity issues.

October

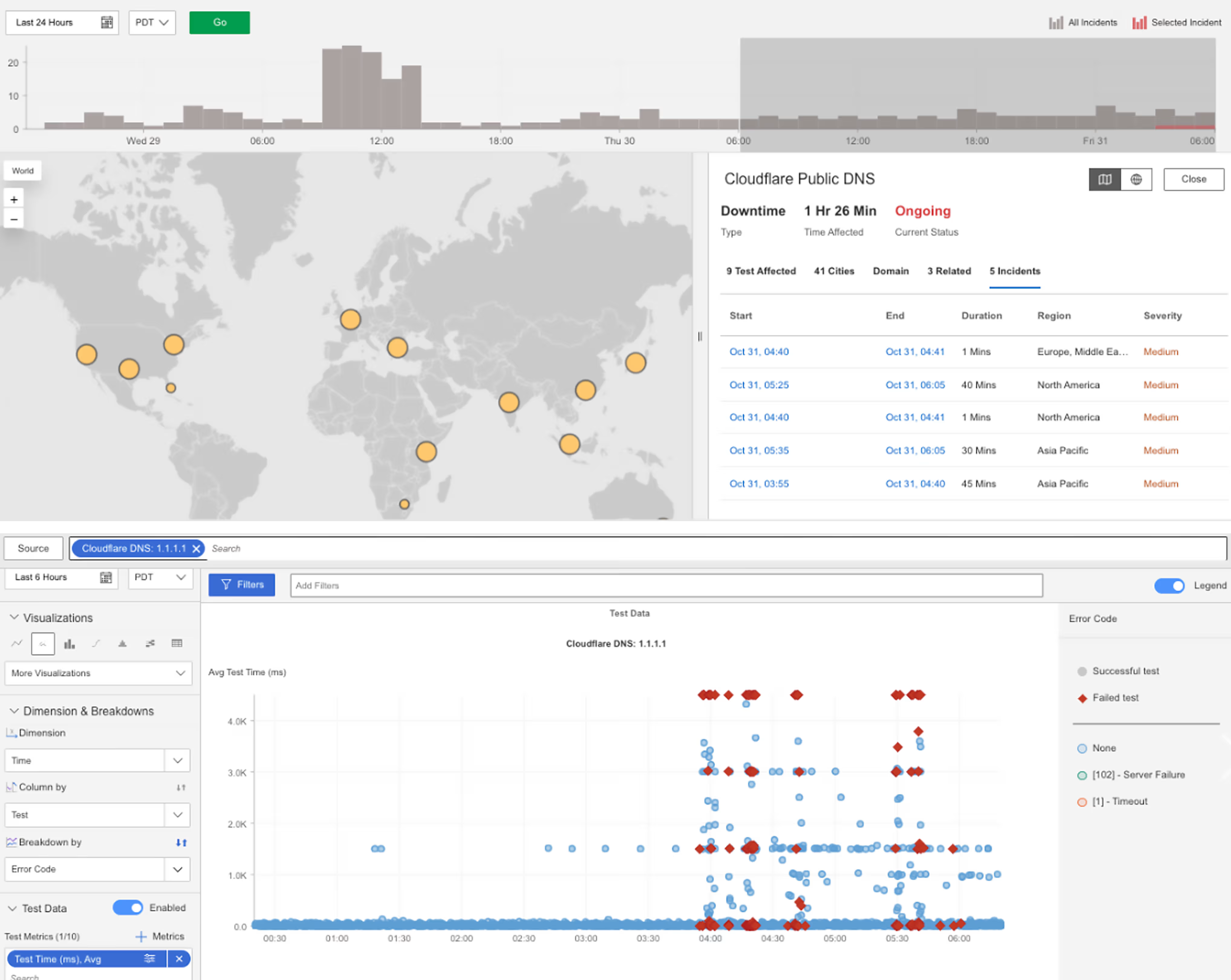

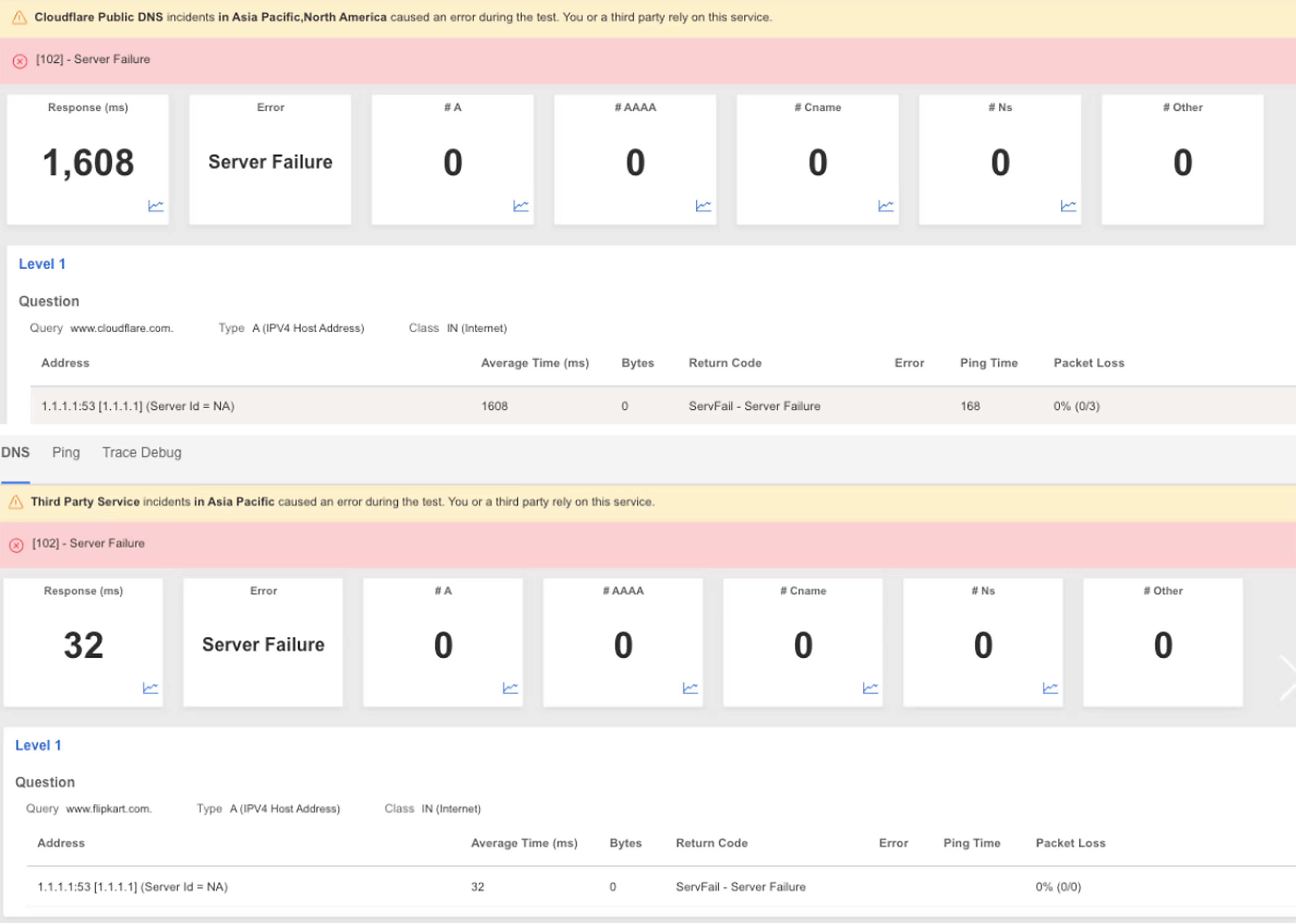

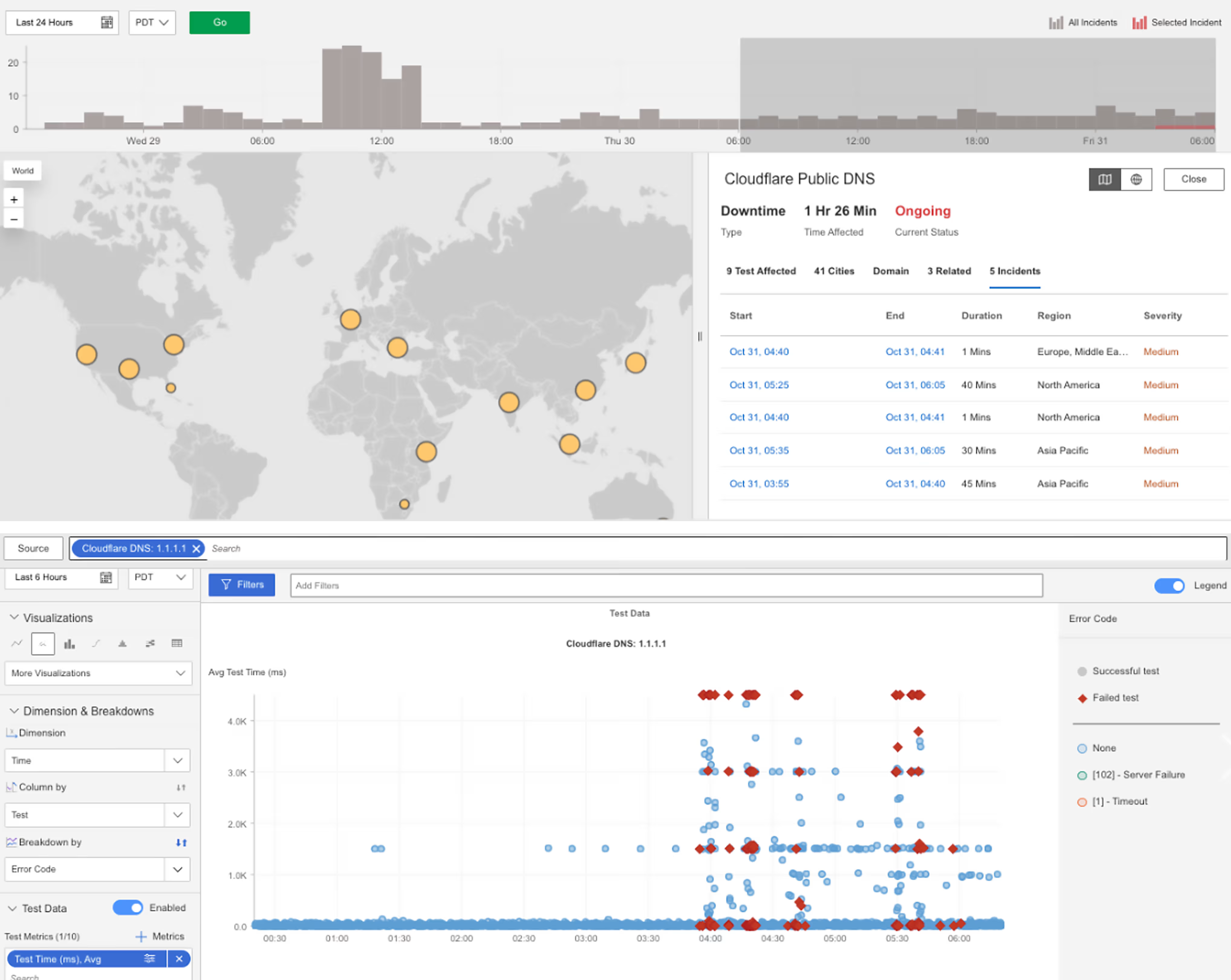

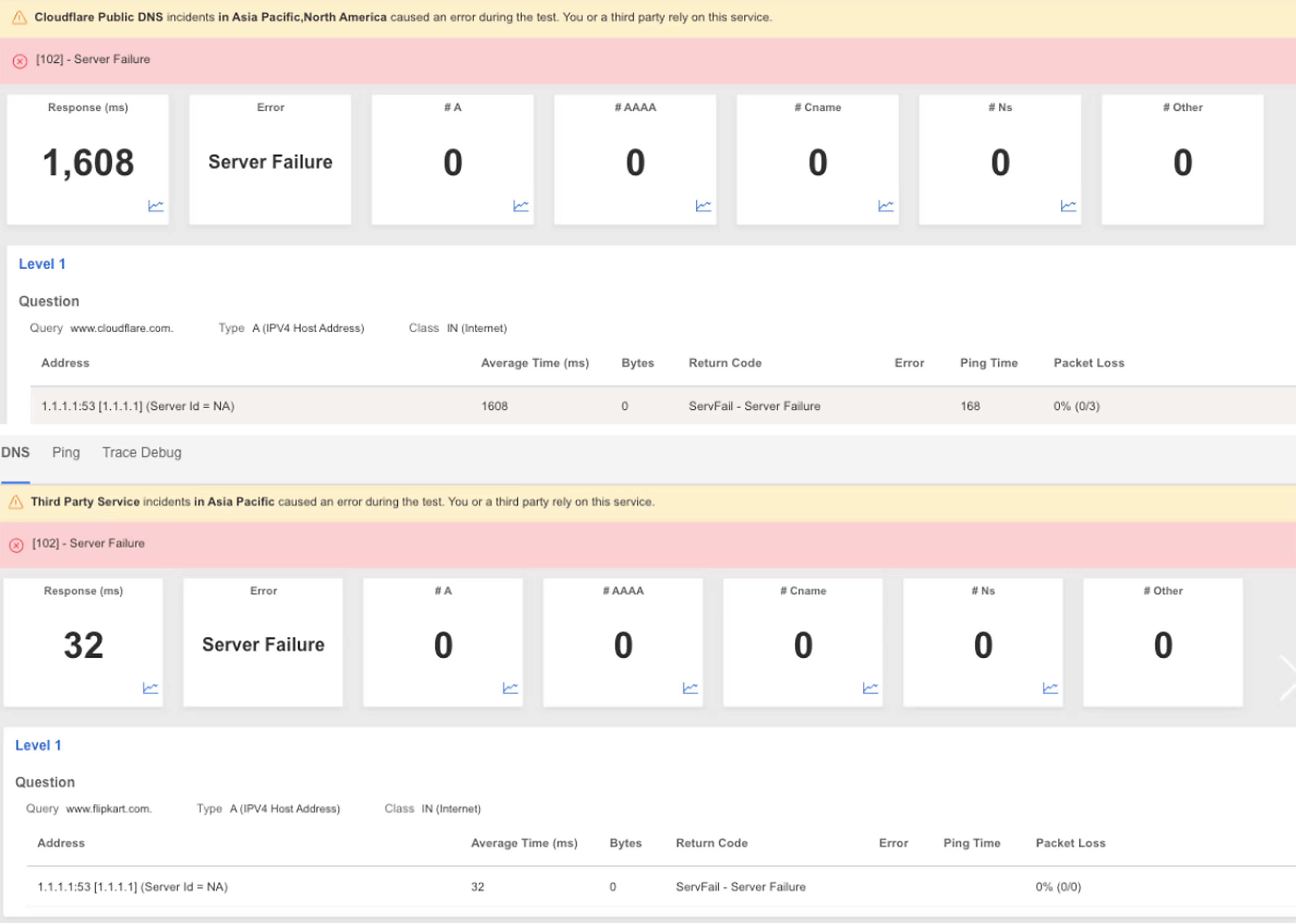

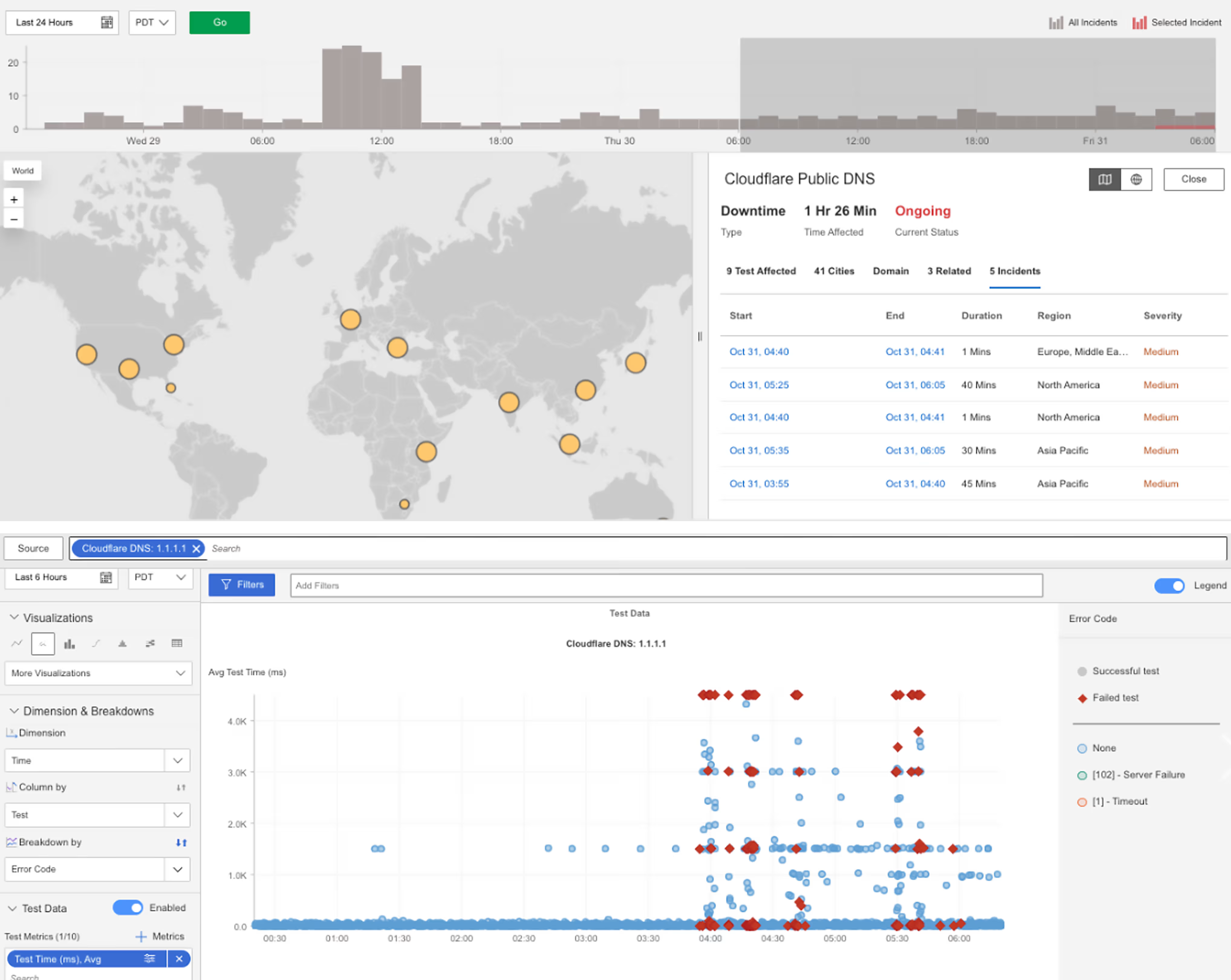

Cloudflare Public DNS

What Happened?

On October 31, 2025, at 03:54 PDT, Internet Sonar detected an ongoing outage affecting the Cloudflare Public DNS resolver (1.1.1.1). The issue is impacting multiple clients globally, and investigations show timeouts and server failures.

Takeaways

Server failures at the recursive resolver layer are especially disruptive because they block the very first step of Internet communication. Unlike latency spikes or partial application errors, DNS resolver failures cause broad, cross-service impact that can appear as “the Internet is down” to end users. This incident underscores how public recursive DNS services represent a shared, high-blast-radius dependency, where instability immediately affects many unrelated applications at once. Distinguishing between resolver timeouts and explicit server failures is important, as they point to different failure modes—overload versus internal resolver faults—and help narrow whether issues originate in capacity constraints, software defects, or upstream dependency breakdowns.

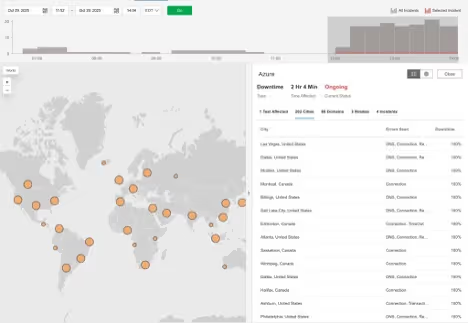

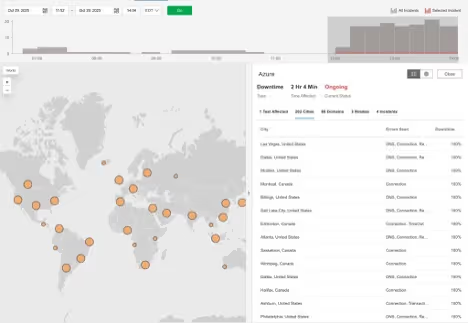

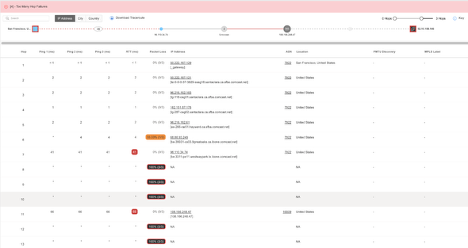

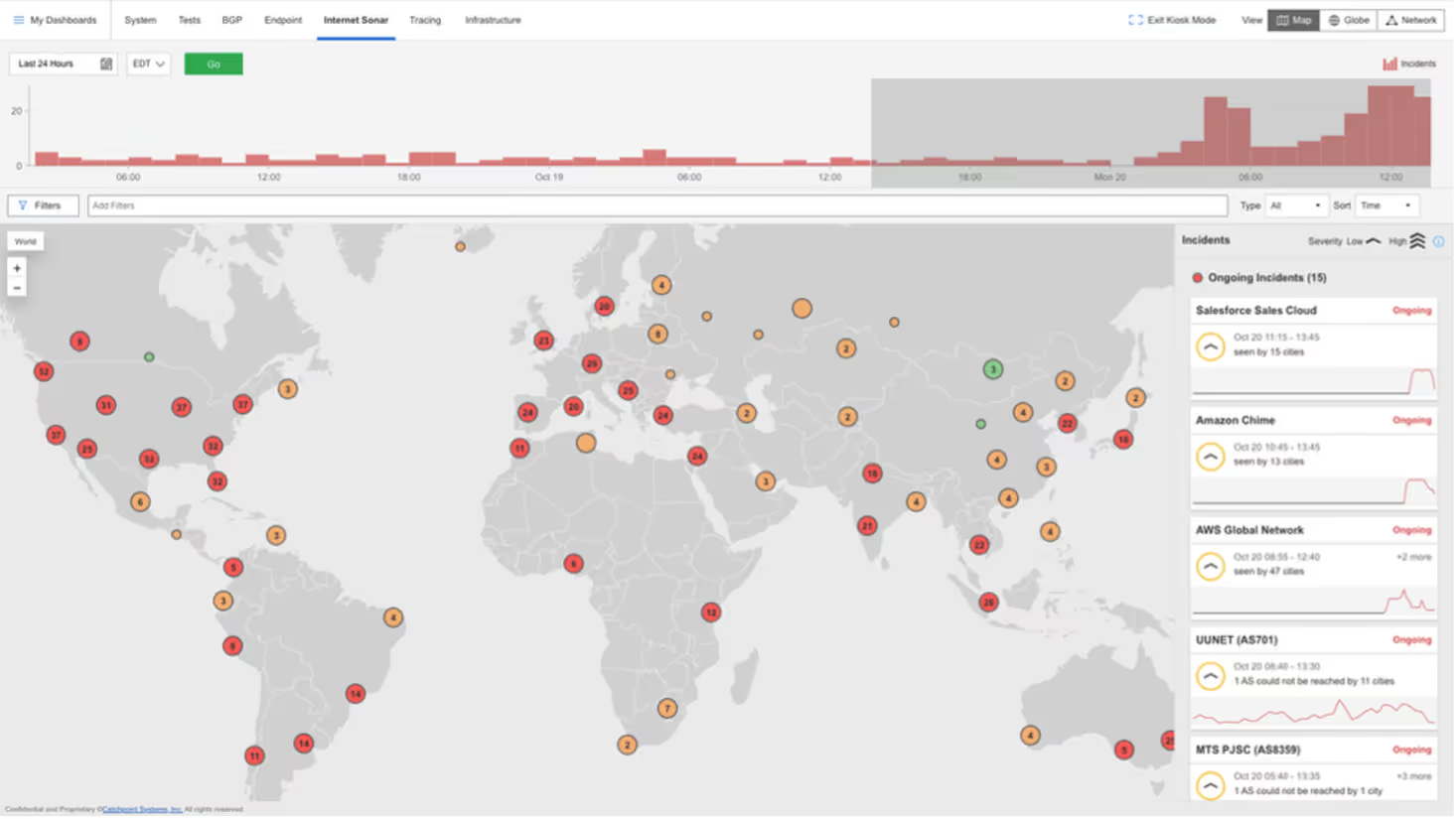

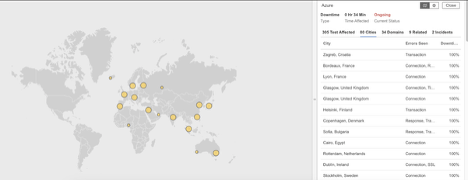

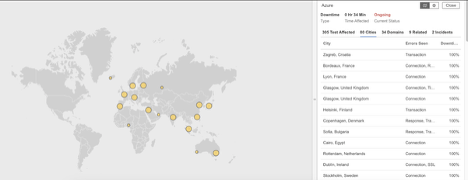

Azure

What Happened?

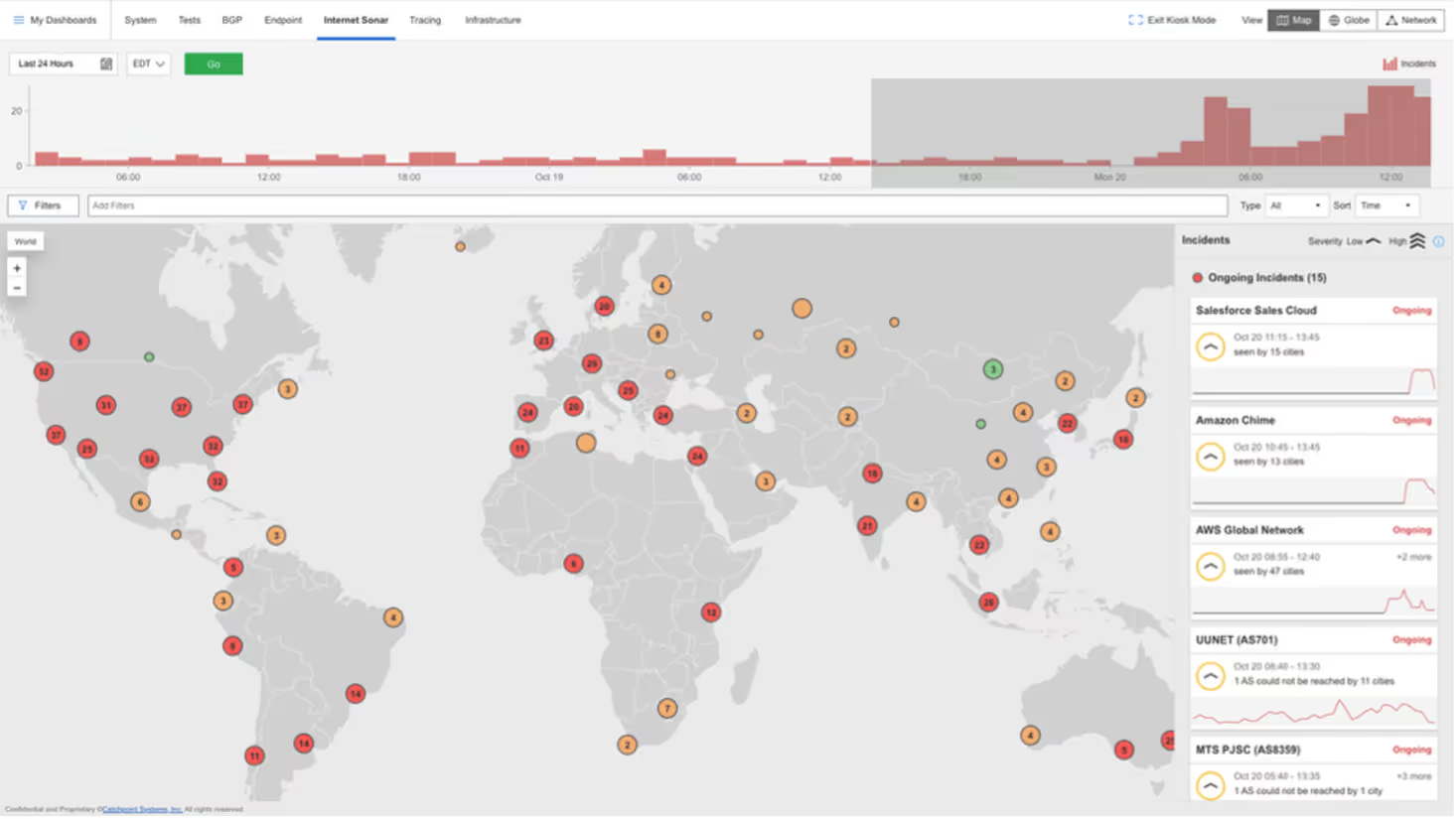

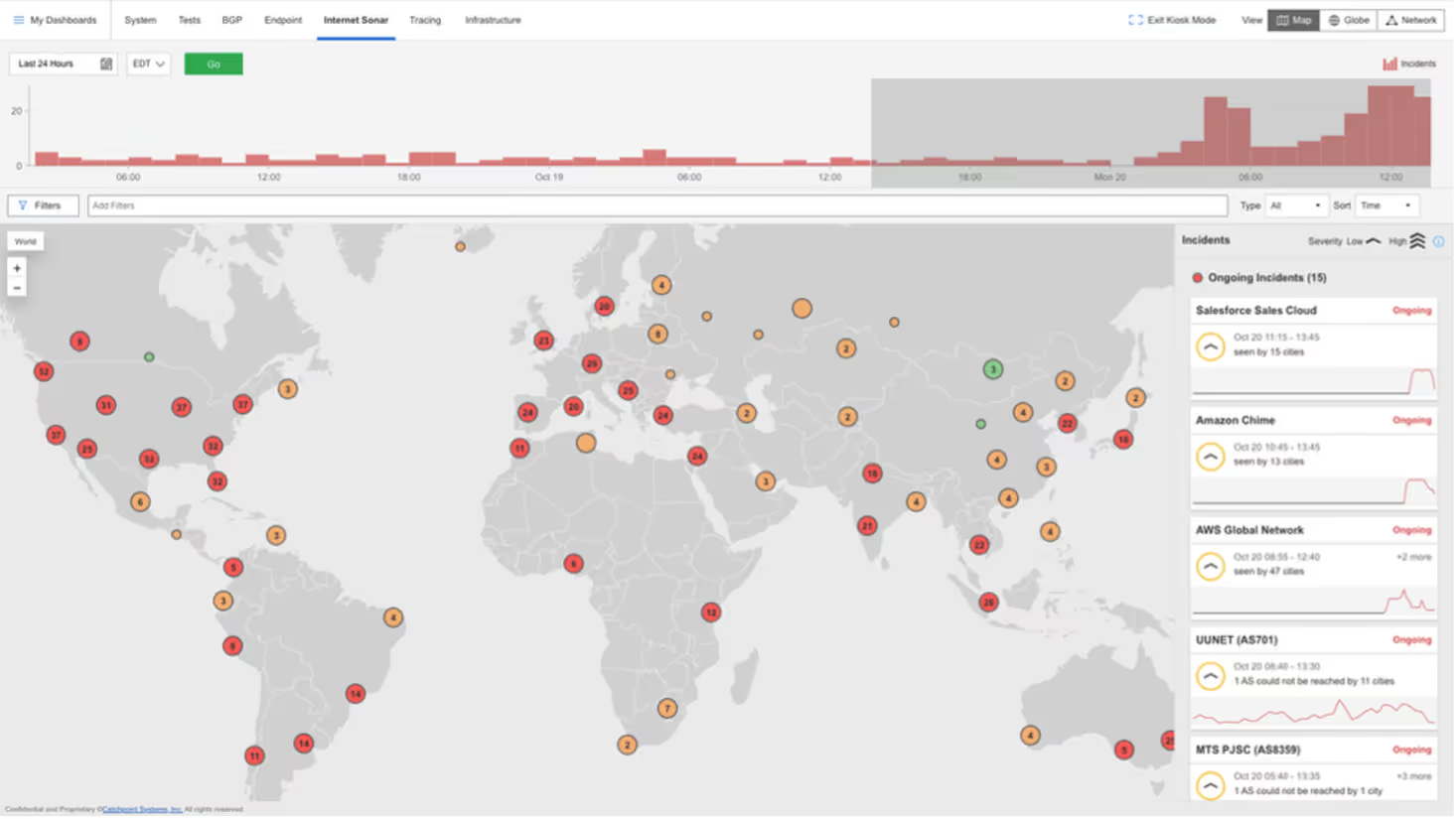

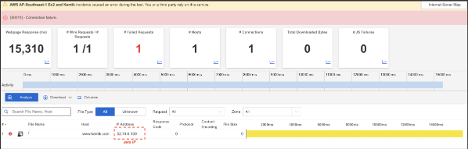

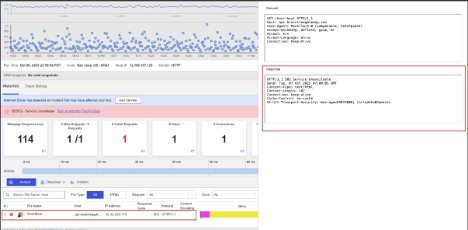

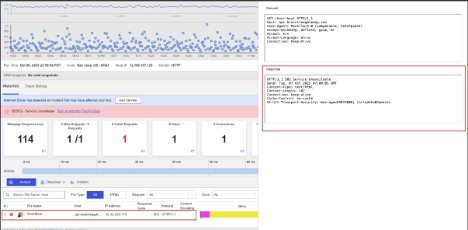

At approximately 11:41 AM EDT, Catchpoint’s Internet Sonar detected a widespread outage affecting Microsoft Azure services. The disruption caused elevated DNS and connection failures in Azure Front Door (AFD) availability tests across more than 200 cities worldwide. Users and applications relying on Azure experienced slow response times, failed DNS lookups, and connection timeouts when attempting to reach cloud-hosted resources.

Analysis from multiple vantage points indicated reachability incidents to Microsoft’s Autonomous System (AS), pointing to a control-plane or edge networking issue within Azure’s global infrastructure rather than a DNS resolution failure. The outage resulted in significant connectivity degradation for enterprise services, APIs, and web applications dependent on Azure’s cloud backbone.

Takeaways

This incident follows hot on the heels of AWS’s disruption, highlighting how fragile modern cloud ecosystems remain and how essential independent, global observability is for understanding and mitigating Internet-scale outages in real time.

Azure’s outage reinforces that even top-tier cloud providers are vulnerable to network-level disruptions. Continuous monitoring of the full Internet stack, spanning DNS, BGP routing, and application performance, is crucial for detecting and diagnosing failures beyond the provider’s own status updates. With independent, real-time visibility, organizations can identify whether connectivity issues stem from edge networks, control-plane errors, or global routing anomalies, reducing downtime and improving service resilience.

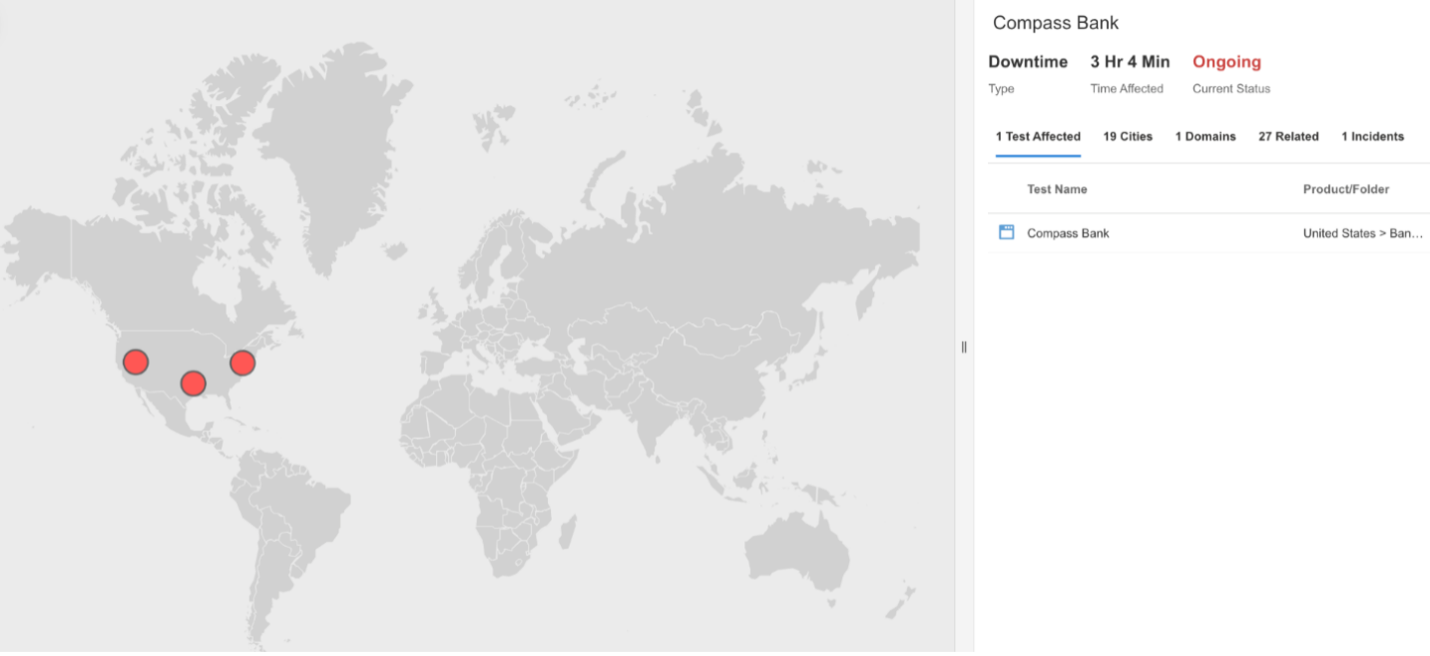

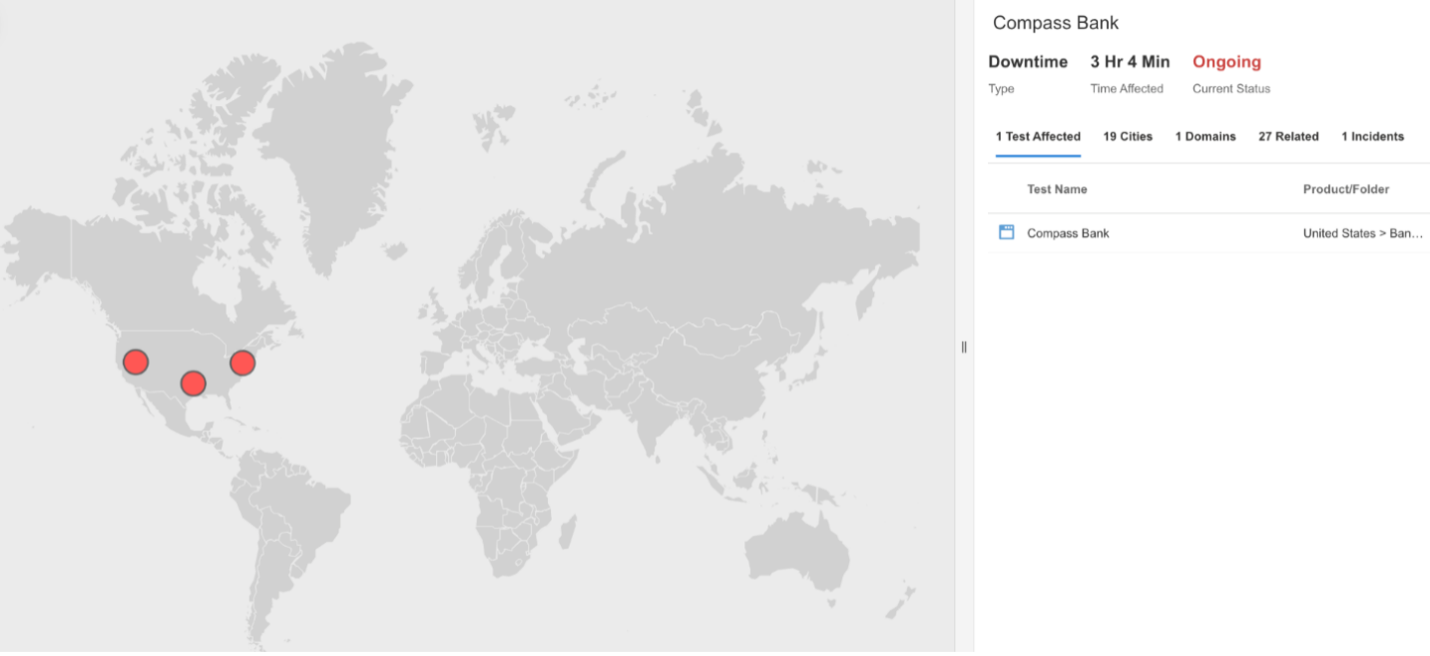

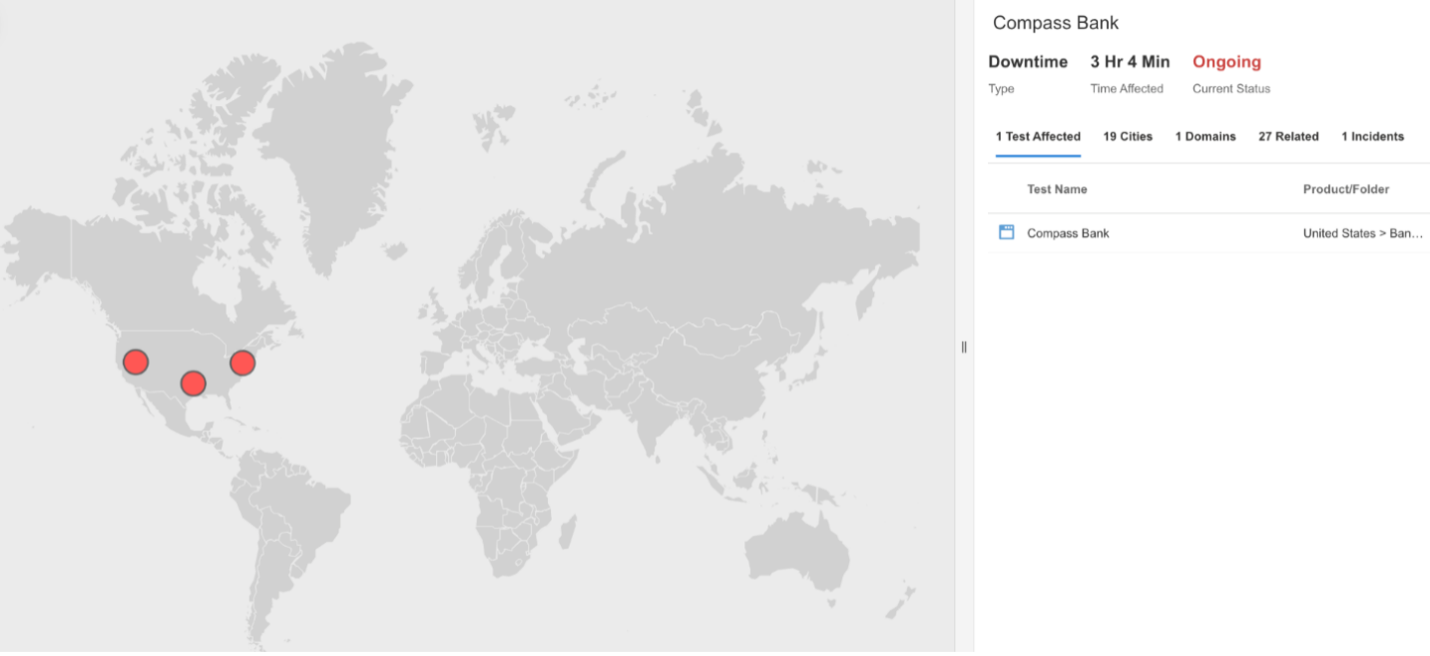

Compass Bank

What Happened?

At approximately 1:28 PM EDT, Compass Bank experienced an outage that made its main website temporarily inaccessible. During the incident, users were unable to connect to the Compass Bank site due to connection failures, suggesting that the servers were unreachable because of network or infrastructure issues. The disruption prevented customers from accessing online banking features such as account management, bill payments, and transaction viewing until service was restored.

Takeaways

For financial institutions, even short outages can significantly impact customer trust and access to essential services. Monitoring both application availability and underlying network connectivity helps determine whether disruptions arise from local routing issues, server downtime, or data center outages. Continuous Internet stack visibility, from DNS to application endpoints, enables faster detection, clearer root cause identification, and improved service resilience for critical banking operations.

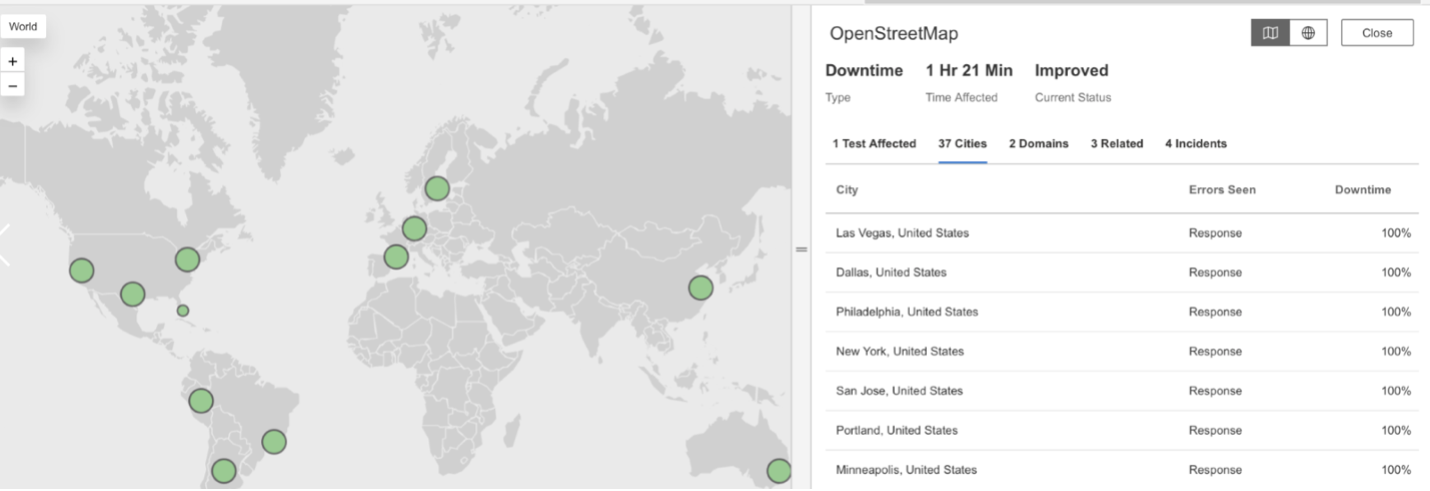

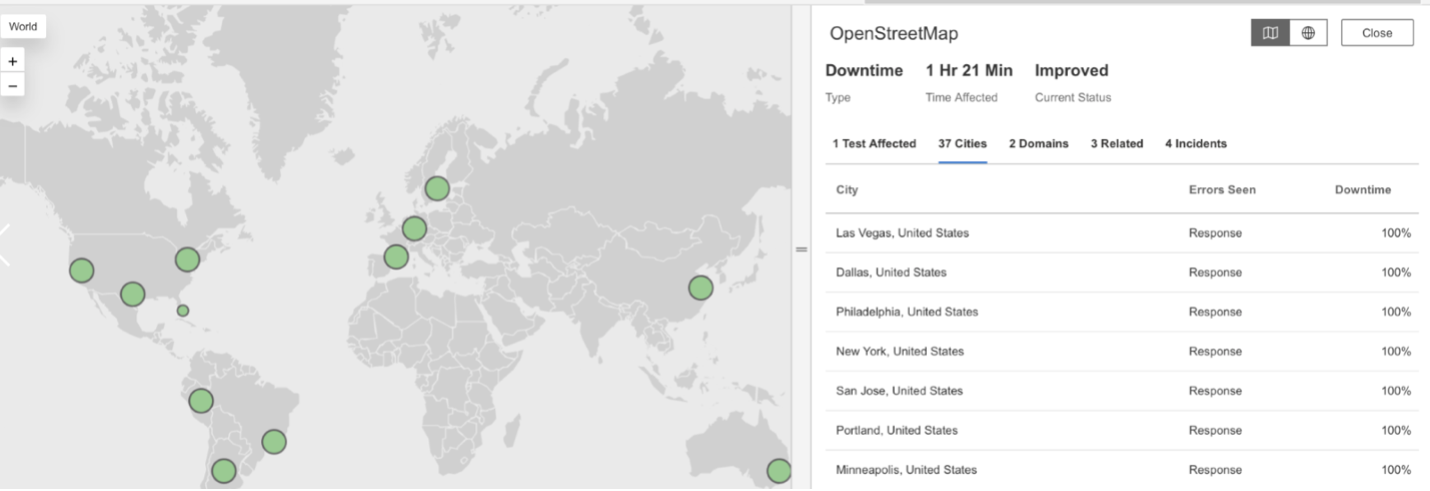

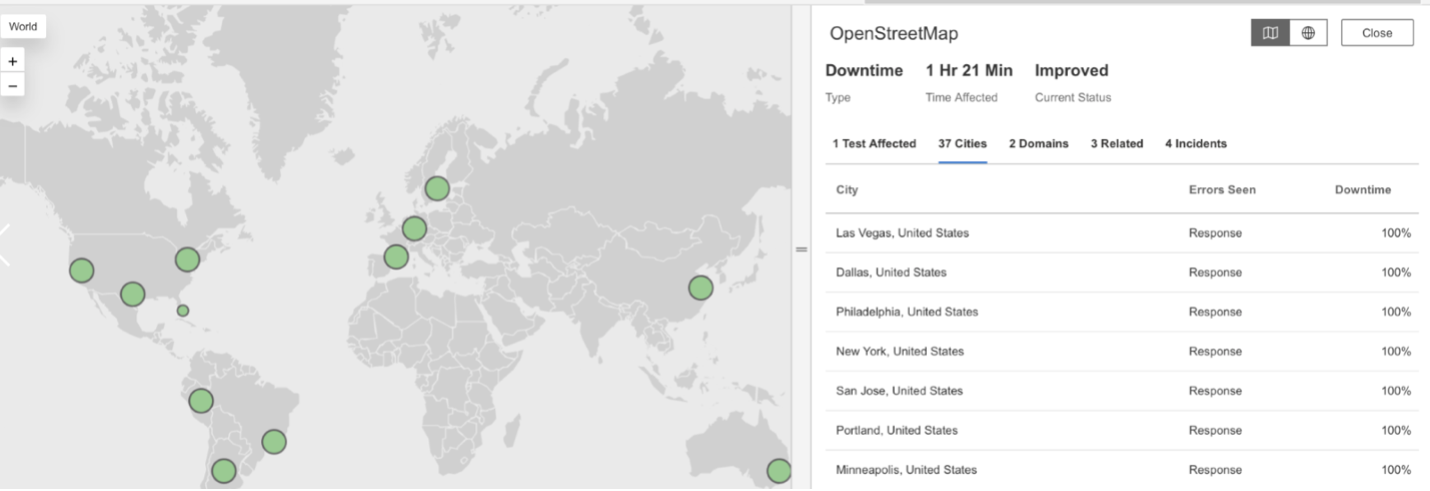

OpenStreetMap

What Happened?

OpenStreetMap experienced two separate service disruptions—first on October 21, 2025, at 8:00 PM EDT, and again on October 23, 2025, at 4:09 PM EDT. During both incidents, requests to OpenStreetMap services returned HTTP 503 (Service Unavailable) responses, indicating that the servers were temporarily unable to process incoming traffic. Users likely encountered slow map loading times or were unable to access geographic data during the outages.

Takeaways

Repeated 503 errors over a short period can suggest server strain or resource exhaustion due to high user demand or maintenance activities. Continuous global monitoring helps determine whether such failures stem from traffic overload, capacity limits, or upstream infrastructure issues. For widely used mapping and open data platforms like OpenStreetMap, maintaining visibility into server health and request handling is essential to minimize downtime and preserve reliability for developers and users alike.

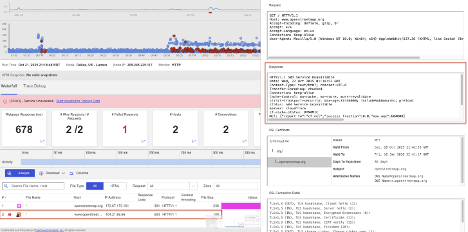

AWS

What Happened?

At approximately 06:55 AM UTC, Catchpoint’s Internet Sonar detected a large-scale outage impacting AWS infrastructure, 16 minutes before AWS officially updated its status page at 07:11 AM UTC. During the incident, multiple services hosted on AWS—including several Autodesk environments—returned HTTP 500 (Internal Server Error) and HTTP 502 (Bad Gateway) responses.

Takeaways

This outage highlights how even the most resilient cloud ecosystems can experience cascading failures. Independent global monitoring provided a 16-minute early detection window before AWS’s own acknowledgment, proving the importance of external visibility. By continuously observing the full Internet stack, teams can pinpoint whether service failures originate from infrastructure layers, network routes, or upstream dependencies, ensuring faster detection and mitigation during large-scale incidents.

SAP C4C

What Happened?

SAP C4C services experienced a medium-severity outage impacting users across multiple continents. During the incident, requests to the service returned HTTP 503 (Service Unavailable) responses, an error indicating that the servers were either overloaded or temporarily offline. The disruption likely affected access to CRM tools, sales management dashboards, and customer engagement applications that rely on SAP’s cloud infrastructure.

Takeaways

Service Unavailable errors across global regions suggest issues within centralized infrastructure or high service load. Continuous global monitoring can help distinguish between localized congestion and platform-wide server overloads. Tracking application health and response codes across distributed endpoints enables quicker identification of root causes and supports greater Internet and cloud service resilience.

AWS

What Happened?

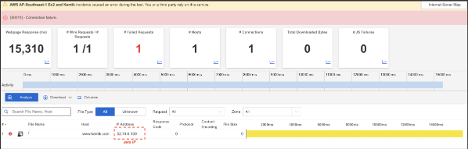

At approximately 4:02 PM EDT, AWS experienced an outage affecting the AP-Southeast-1 (Singapore) region, disrupting EC2 (Elastic Compute Cloud) services. The incident impacted multiple dependent platforms, including Kentik, Kasada, and Flowise. During the outage, affected systems returned a mix of HTTP 502 (Bad Gateway), HTTP 504 (Gateway Timeout), and HTTP 500 (Internal Server Error) responses—indicating failed communication between services, unresponsive servers, and internal processing errors. Users experienced connection failures and slow response times until normal service was restored.

Takeaways

This event illustrates how regional cloud outages can ripple across multiple dependent applications. Monitoring at both the cloud infrastructure and application layers helps distinguish whether disruptions stem from compute instance failures, overloaded gateways, or upstream service dependencies. Full Internet-stack visibility ensures faster diagnosis during multi-service incidents, improving resilience and minimizing downtime for platforms hosted on large-scale cloud providers like AWS.

Azure

What Happened?

At approximately 3:45 AM EDT, Microsoft Azure experienced an outage that affected access to multiple services across several regions. During the event, requests to Azure content delivery and edge network endpoints, such as azureedge.net and azurefd.net, failed to respond properly. The disruption likely impacted applications relying on Azure Front Door and CDN services, leading to slow loading times or unavailable web resources.

Takeaways

Outages at the edge layer highlight how failures in global content delivery or traffic routing can disrupt dependent cloud applications. Monitoring the full Internet delivery chain, from DNS resolution and CDN behavior to backend responses, helps pinpoint whether the issue lies in edge caching, upstream servers, or network routing. Maintaining end-to-end visibility into multi-region cloud infrastructure ensures quicker detection, accurate diagnosis, and faster recovery when outages occur.

Microsoft Office

What Happened?

At approximately 5:21 PM EDT, Microsoft Office experienced a widespread outage affecting users across multiple continents. During the incident, requests to Office services returned HTTP 503 (Service Unavailable) responses, which occur when servers are too busy to handle new requests or are temporarily offline. The issue likely disrupted access to key productivity tools such as document editing, email, and cloud file storage.

Takeaways

Service Unavailable errors often indicate capacity or maintenance-related problems in large-scale distributed systems. Continuous global monitoring can help distinguish whether 503 responses stem from overloaded application servers, misconfigured load balancers, or temporary service throttling. Monitoring the full Internet delivery path—from the client through DNS and cloud infrastructure—provides essential insight into performance degradation and helps teams restore availability more quickly.

X Corp. (Twitter)

What Happened?

At approximately 4:10 AM EDT, X/Twitter experienced a brief service disruption impacting users across the EMEA region. During the outage, requests to the platform timed out due to high wait times and a lack of server responses. As a result, users encountered delays in loading feeds or were temporarily unable to access the site until normal operations resumed.

Takeaways

Timeout-related issues often point to network congestion or unresponsive backend servers. Monitoring end-to-end connection health, from DNS resolution through to application response, helps detect where latency builds up in the delivery chain. For global platforms like X, continuous visibility across multiple geographies ensures that localized disruptions can be quickly identified and isolated before they affect a broader user base.

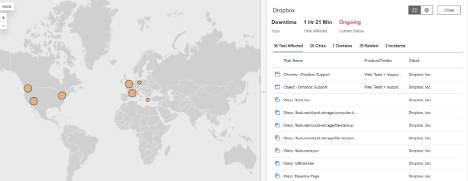

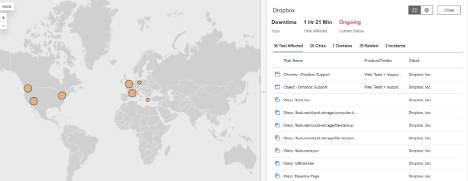

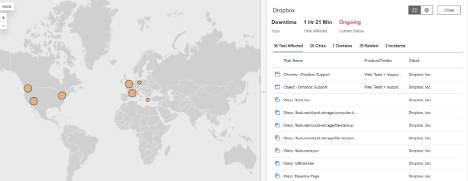

Dropbox

What Happened?

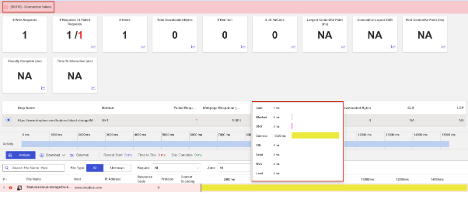

At approximately 2:45 AM EDT, Dropbox experienced a minor service disruption impacting users across multiple regions. During the incident, connections to Dropbox’s main service endpoint failed due to high connect times, meaning users’ devices took too long to establish a stable connection with Dropbox servers. The issue likely caused short delays or temporary inaccessibility for file uploads, downloads, and account access.

Takeaways

Even low-severity outages caused by elevated connection times can affect user experience, particularly for services handling large data transfers. Continuous monitoring of network latency and connection performance helps identify whether delays stem from local congestion, ISP routing, or upstream infrastructure issues. Having visibility across global endpoints ensures teams can detect and resolve small issues before they escalate into widespread disruptions.

Braintree

What Happened?

At around 8:00 PM EDT, Braintree experienced a service outage that affected payment processing operations across North America. During the incident, requests to Braintree’s web and API endpoints returned HTTP 503 (Service Unavailable) errors, indicating that the servers were either overloaded or temporarily taken offline for maintenance. This disruption likely prevented merchants from processing transactions or accessing their dashboards during the event.

Takeaways

Payment systems depend on continuous uptime to maintain customer trust and transaction flow. Monitoring both API availability and response times helps detect early signs of overloads or maintenance misconfigurations before they cause service-wide failures. Internet Performance Monitoring, spanning DNS, application servers, and network connectivity, can reveal where in the chain performance degrades, helping teams minimize downtime and protect critical financial operations.

Cequence

What Happened?

At approximately 11:20 PM EDT, Cequence experienced a global outage that affected user access across multiple continents. During the incident, requests to Cequence login services returned HTTP 504 (Gateway Timeout) errors—meaning that the gateway or proxy server did not receive a timely response from an upstream system. The issue was linked to high connection times, causing requests to fail. The disruption lasted about 30 minutes, and normal functionality resumed by 11:50 PM EDT.

Takeaways

Global outages like this highlight how latency and timeout issues in upstream systems can cascade across regions. Monitoring connection times and response behavior across the Internet stack, from client to application, helps identify where delays occur and which systems are most affected. Comprehensive visibility enables teams to distinguish between server-side slowness, network congestion, and external dependencies, improving overall service resilience.

Meetup

What Happened?

At around 5:39 PM EDT, Meetup experienced a major outage affecting users in the United States. During the incident, requests to the service returned HTTP 503 (Service Unavailable) errors, which occur when a server is temporarily unable to handle requests—often due to overload or maintenance. The disruption lasted roughly 20 minutes, with normal access restored by 5:59 PM EDT. Users were unable to view or manage events, RSVP, or log into their accounts during this period.

Takeaways

Short but high-impact outages like this demonstrate how quickly application-level failures can affect user trust and engagement. Synthetic monitoring across multiple locations can help confirm whether 503 errors stem from overloaded servers, failed backend dependencies, or temporary maintenance issues. Maintaining visibility into server health and response behavior supports faster remediation and stronger Internet resilience for community-driven platforms like Meetup.

LaunchDarkly

What Happened?

At approximately 10:55 AM EDT, LaunchDarkly experienced a multi-region outage that disrupted access to key services. Users encountered a mix of Connection Timeout, HTTP 502 (Bad Gateway), and HTTP 504 (Gateway Timeout) errors—indicating that the servers either failed to respond in time or returned invalid responses. This affected the platform’s ability to deliver real-time feature flag updates and event tracking, impacting software teams relying on LaunchDarkly for continuous deployment and feature control.

Takeaways

This outage highlights the importance of monitoring both application endpoints and their supporting network paths. When multiple error types appear simultaneously, it often points to issues between load balancers, upstream servers, or edge locations. End-to-end Internet visibility helps identify whether slow responses, timeouts, or upstream failures originate within the provider’s infrastructure or across the wider Internet, improving the speed of root cause analysis and recovery.

September

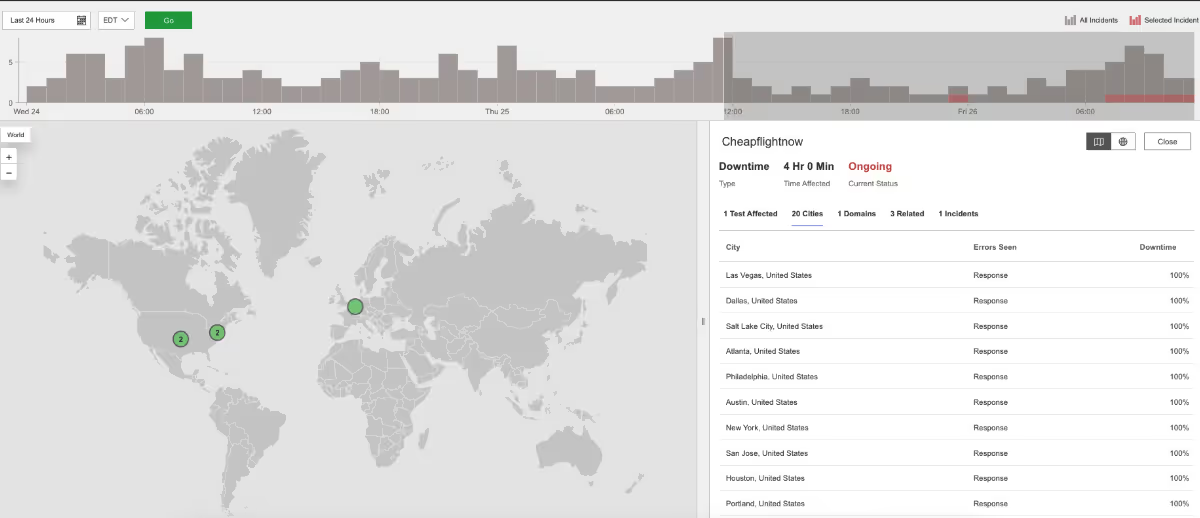

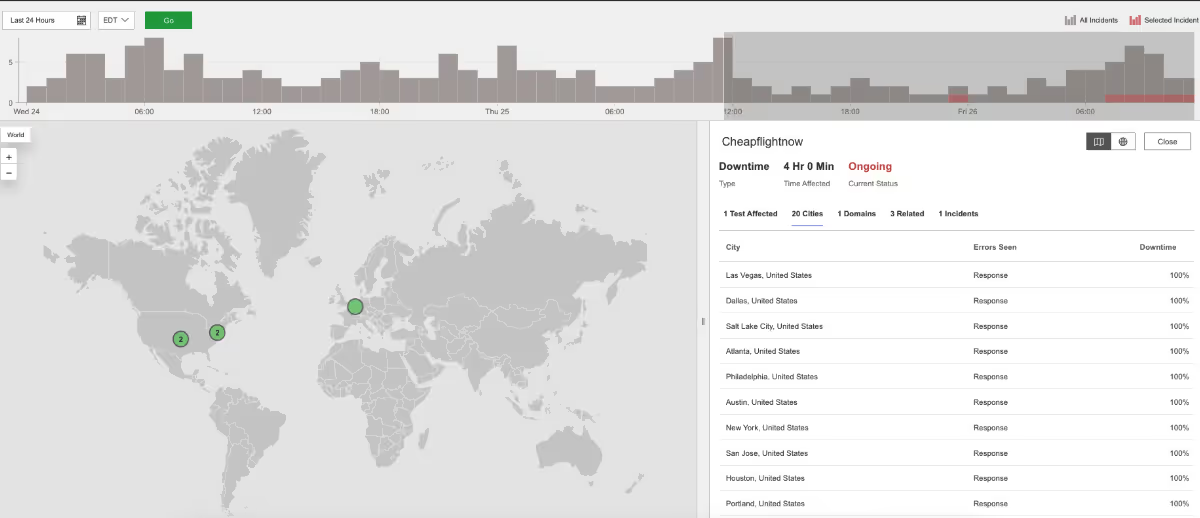

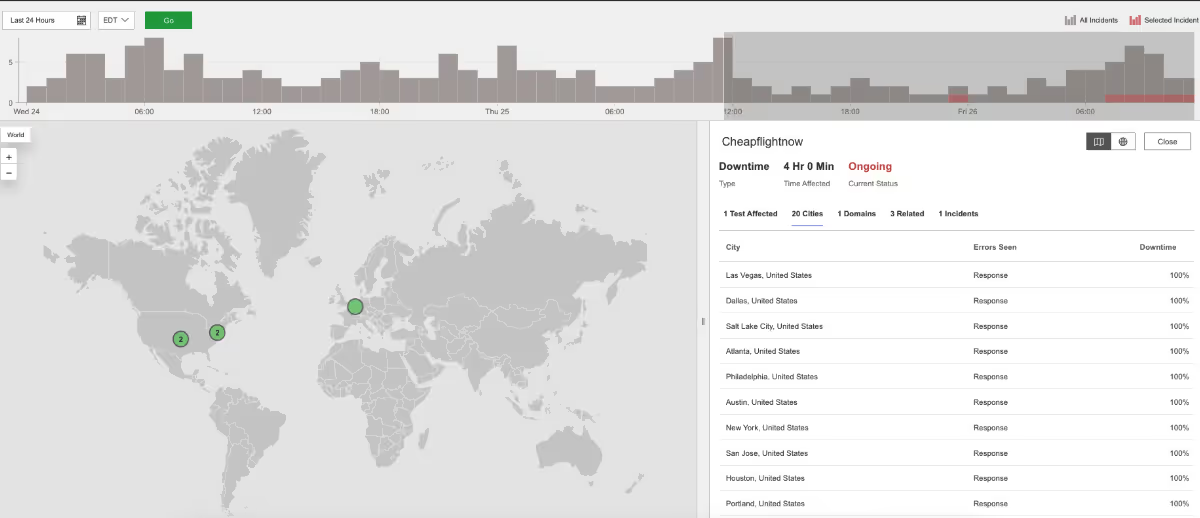

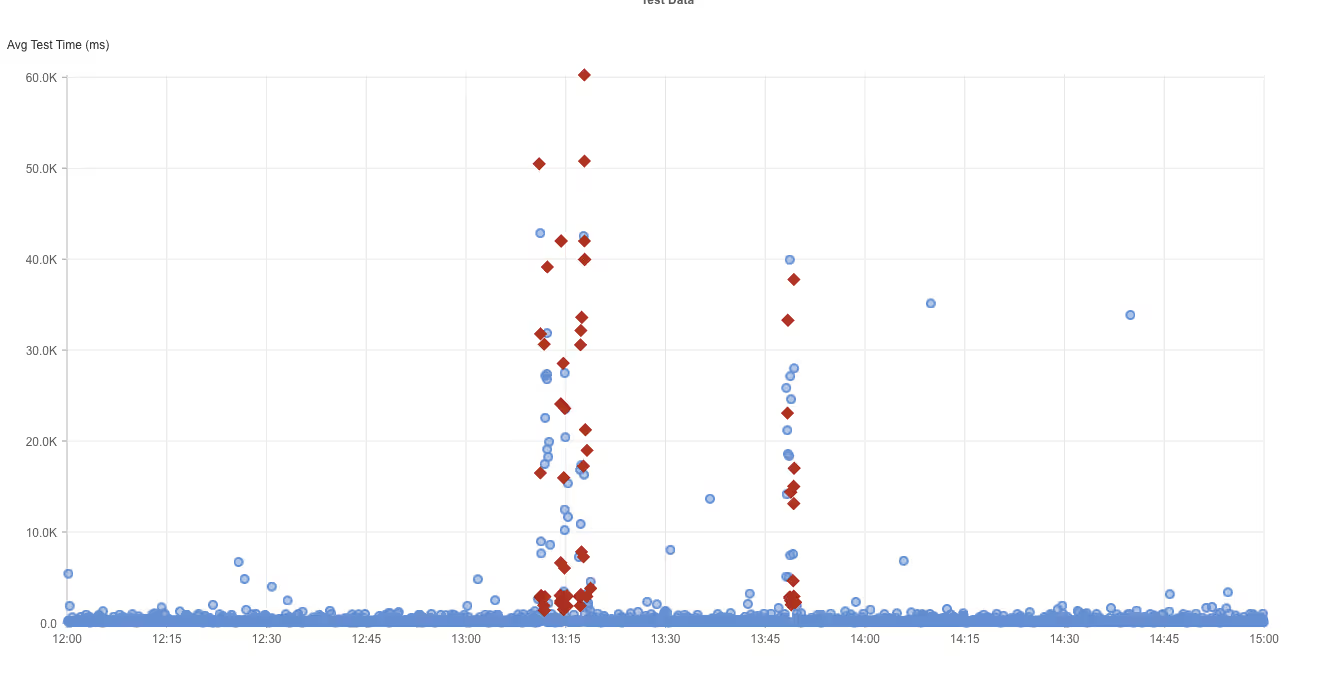

Cheapflightnow

What Happened?

At 7:34 AM EDT, Cheapflightnow’s website stopped working across parts of the U.S. Visitors saw HTTP 522 errors, which is a Cloudflare-specific error. This means Cloudflare was working fine, but it couldn’t connect to Cheapflightnow’s own servers — either they were down or too slow to respond.

Takeaways

Cloudflare’s global network stayed up, but because Cheapflightnow’s own servers weren’t answering, users still experienced outages. To prevent this, companies often set up backup origin servers (extra copies of their main servers) so if one fails, traffic can be rerouted to another. The outage also shows how dependencies between CDNs and origin servers can create weak links. By monitoring the full Internet stack, from DNS to CDN to application servers, companies can quickly see where the chain breaks and reduce downtime.

Alaska Airlines

What Happened?

At 10:27 PM EDT, Alaska Airlines’ main website www.alaskaair.com became unavailable across many major U.S. cities. People saw HTTP 503 Service Unavailable and HTTP 500 Internal Server Error messages. A 503 error means the server is too busy or down for maintenance, while a 500 error is a general “something went wrong” message inside the system.

Takeaways

When both 500 and 503 errors appear together, it often means the problem isn’t just a single overloaded server, but a deeper system-wide issue. For airlines, outages can delay flight bookings and check-ins, so implementing proactive Internet Performance Monitoring (IPM) and building strong backup systems is critical to keep operations running smoothly.

Microsoft Office

What Happened?

Between 1:10 PM and 1:51 PM EDT, the Microsoft Office website www.office.com stopped working in several countries. During the outage, requests returned HTTP 503 (Service Unavailable) responses.

Takeaways

This outage was likely caused by temporary server overload or a configuration mistake. The quick recovery suggests Microsoft’s backup systems kicked in and restored service. The issue here is that Microsoft Office is used by millions. Having proactive Internet Performance Monitoring (IPM) ensures even brief disruptions are detected, measured, and understood, helping IT teams validate resilience and improve user experience.

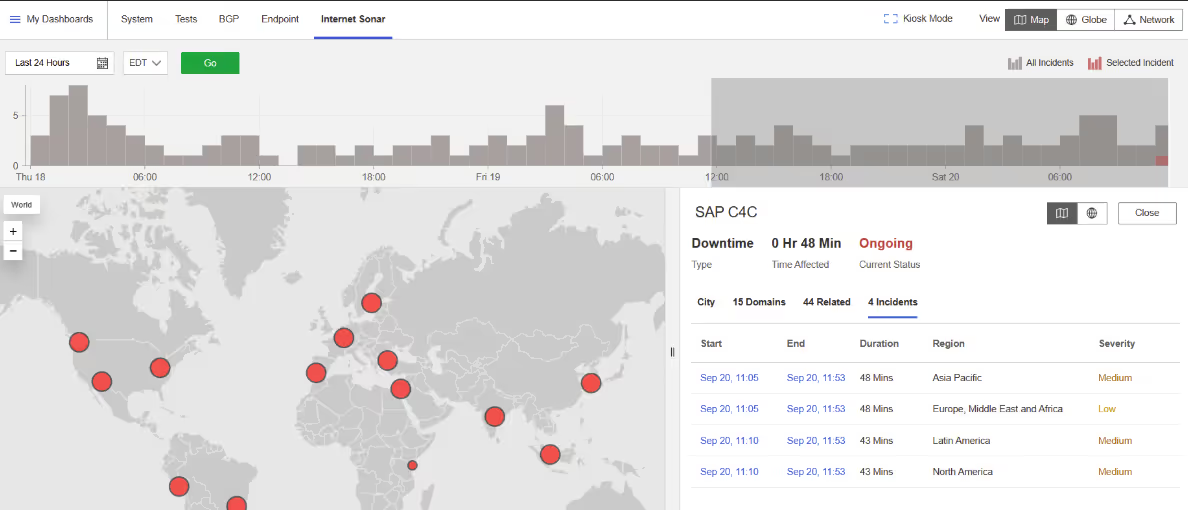

SAP C4C

What Happened?

At 11:08 AM EDT, people using SAP C4C (a cloud-based customer management tool) were unable to access services worldwide. Requests to ondemand.com showed HTTP 503 Service Unavailable errors, meaning the servers were not able to handle the traffic.

Takeaways

Because the outage struck so many regions at once, it likely stemmed from a central cloud infrastructure issue. Global SaaS services rely on load balancing to distribute traffic and keep performance stable. With synthetic monitoring across multiple geographies, businesses can confirm availability worldwide and ensure their customers are not locked out.

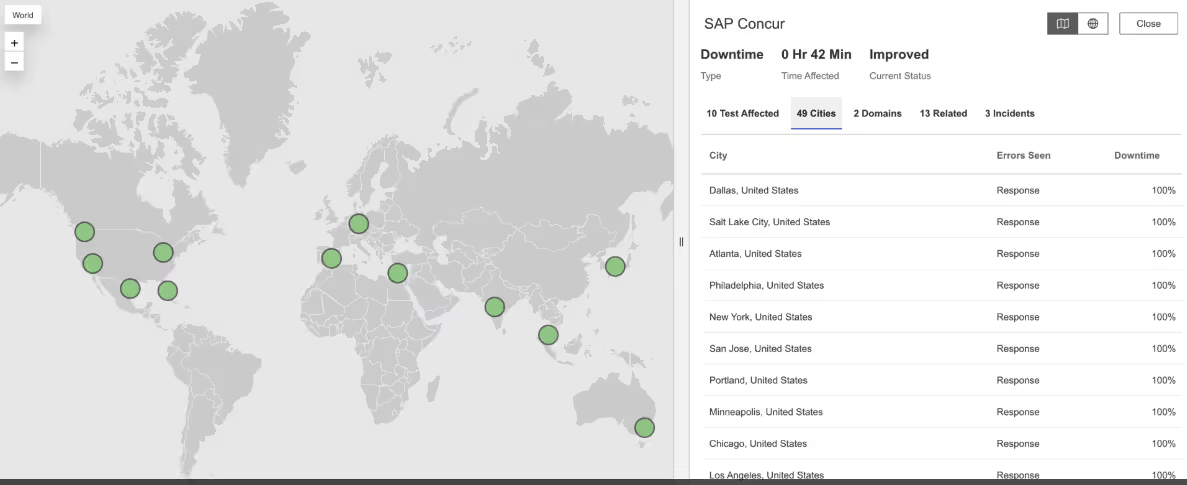

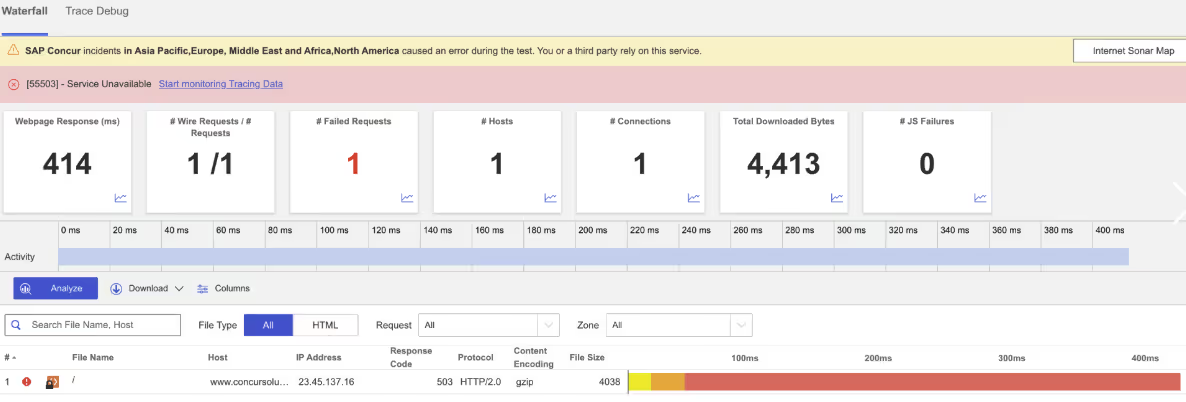

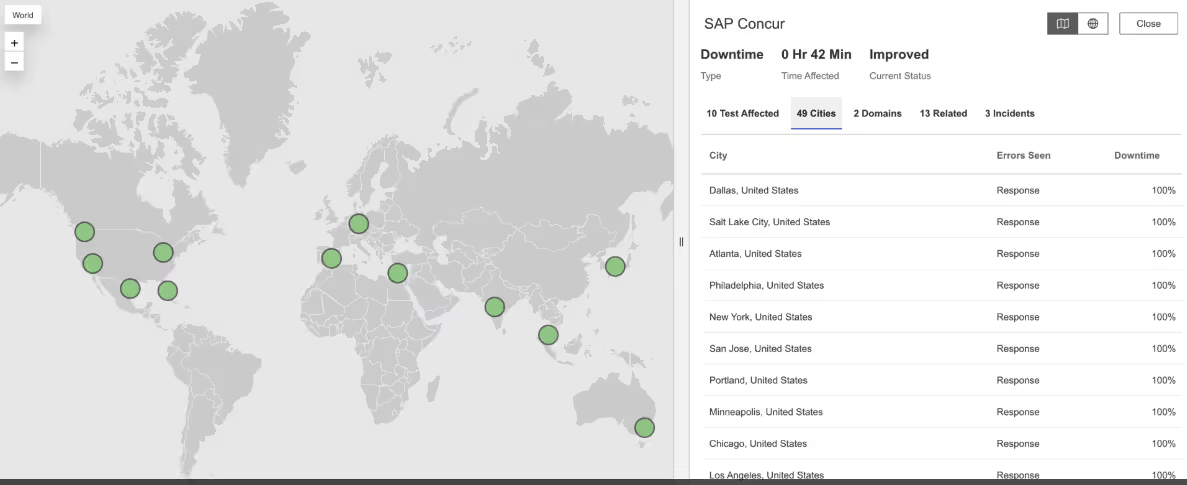

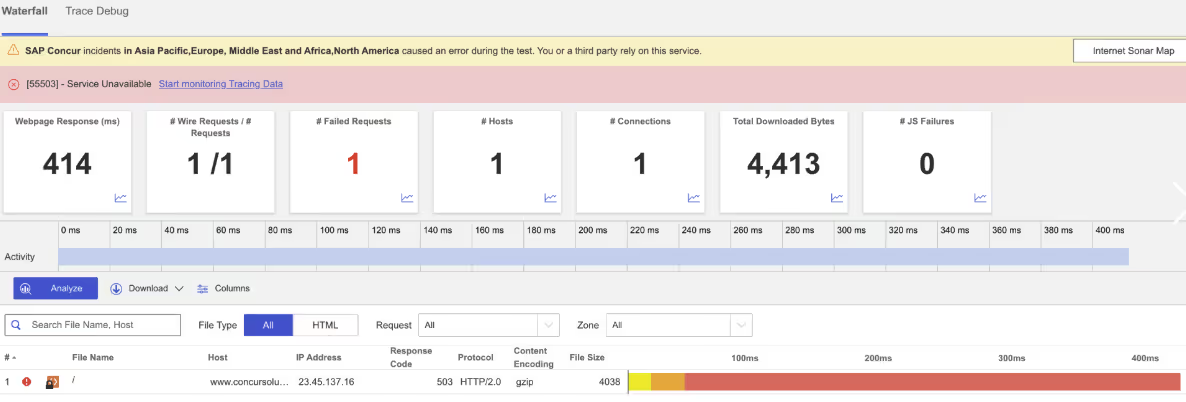

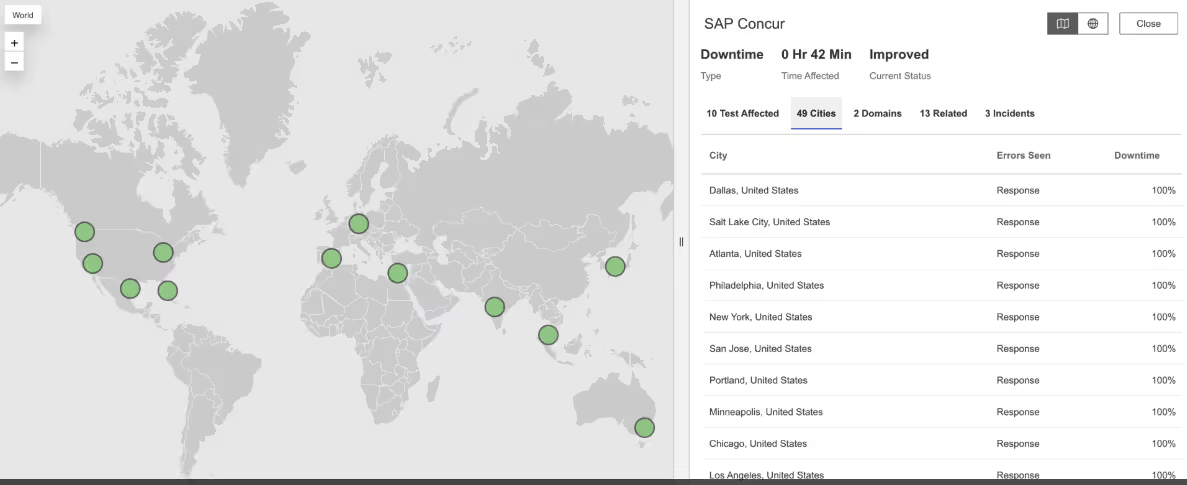

SAP Concur

What Happened?

From 3:39 PM to 3:51 PM EDT, SAP Concur — used for business travel and expense management — went down in multiple regions. Attempts to connect to www.concursolutions.com returned HTTP 503 Service Unavailable errors.

Takeaways

Even though this outage was brief, 503 errors meant the servers couldn’t handle requests. For enterprise apps like Concur, even minutes of downtime can disrupt financial operations. End-to-end monitoring, from DNS resolution to application response, helps companies verify reliability and spot weak points before they cause visible failures.

Aleph Alpha

What Happened?

At 4:20 AM EDT, Aleph Alpha’s website had problems in several countries. Users faced connection failures and very slow load times, meaning their browsers couldn’t establish a stable link to the servers.

Takeaways

Slow connections and failures can point to DNS issues, routing problems, or server overloads. For AI providers, these disruptions damage reliability. Monitoring DNS and BGP (the routing system of the Internet) can quickly pinpoint whether failures come from the network layer or the servers themselves, supporting faster fixes and better resilience.

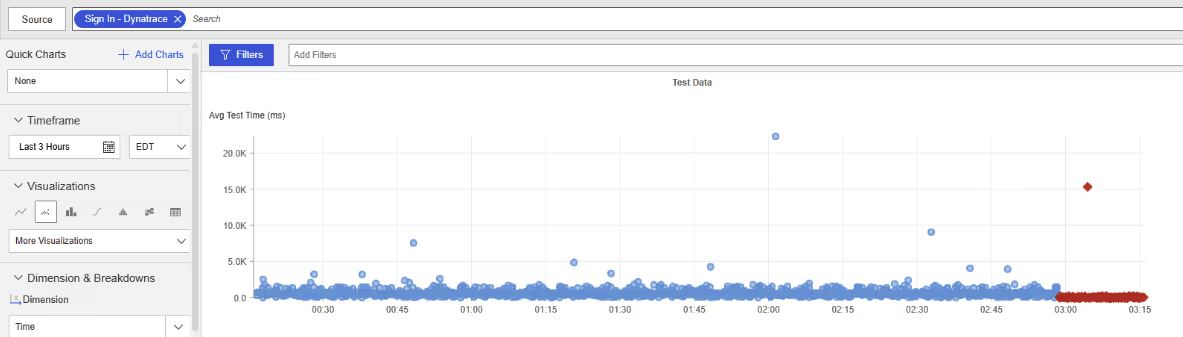

Dynatrace

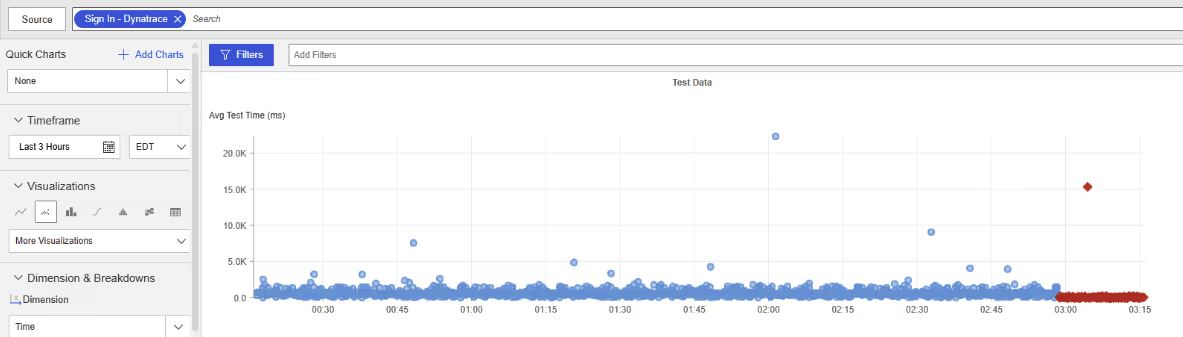

What Happened?

At 2:58 AM EDT, Dynatrace’s login service stopped working for users in multiple countries including the United Kingdom, Romania, Serbia, the Netherlands, and South Africa. People trying to sign in faced connection failures, meaning their devices couldn’t reach the login servers at all.

Takeaways

Because the login service failed, users couldn’t access Dynatrace even though the rest of the platform may have been running. This highlights a unique challenge: monitoring tools themselves depend on the same Internet stack they measure. Outages in DNS, routing (BGP), or authentication layers can ripple into monitoring platforms. Independent, external monitoring provides a safety net — essentially, “monitoring the monitors” — to ensure visibility doesn’t disappear when the tools themselves are impacted.

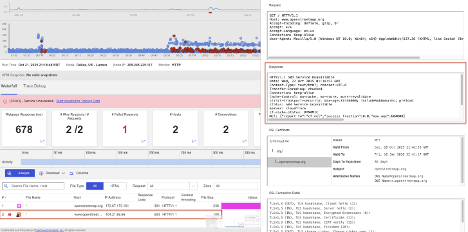

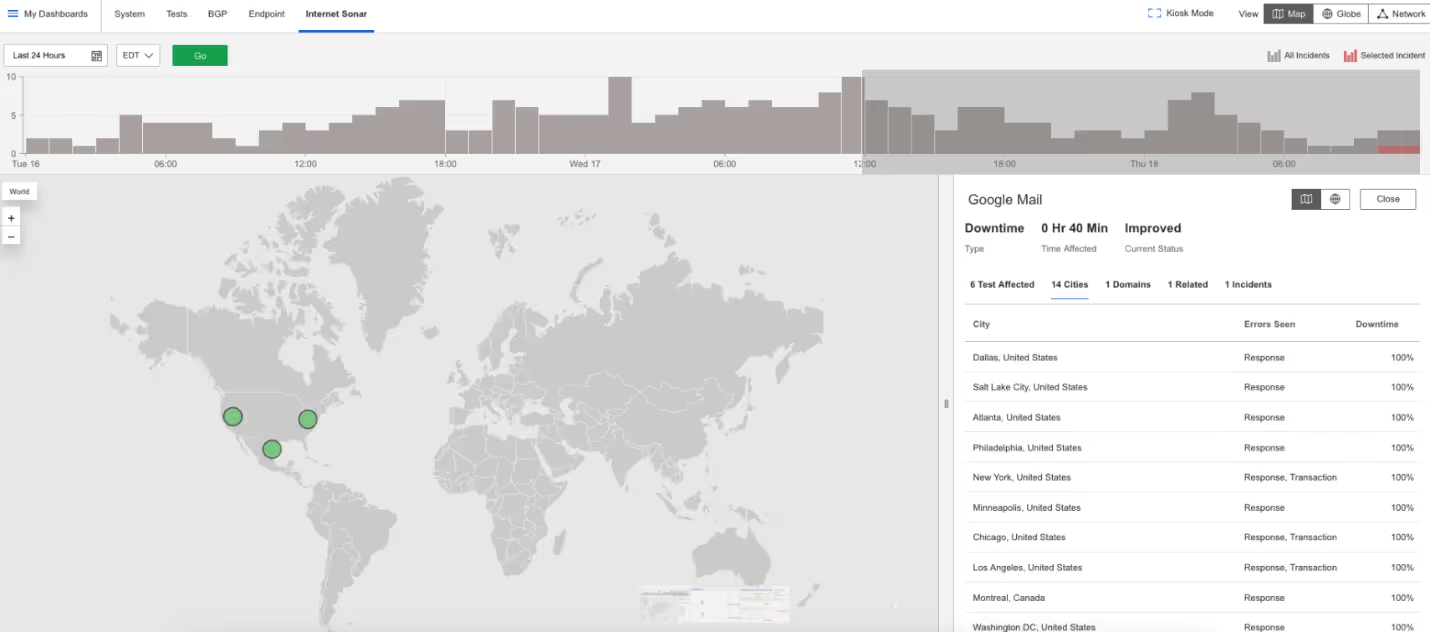

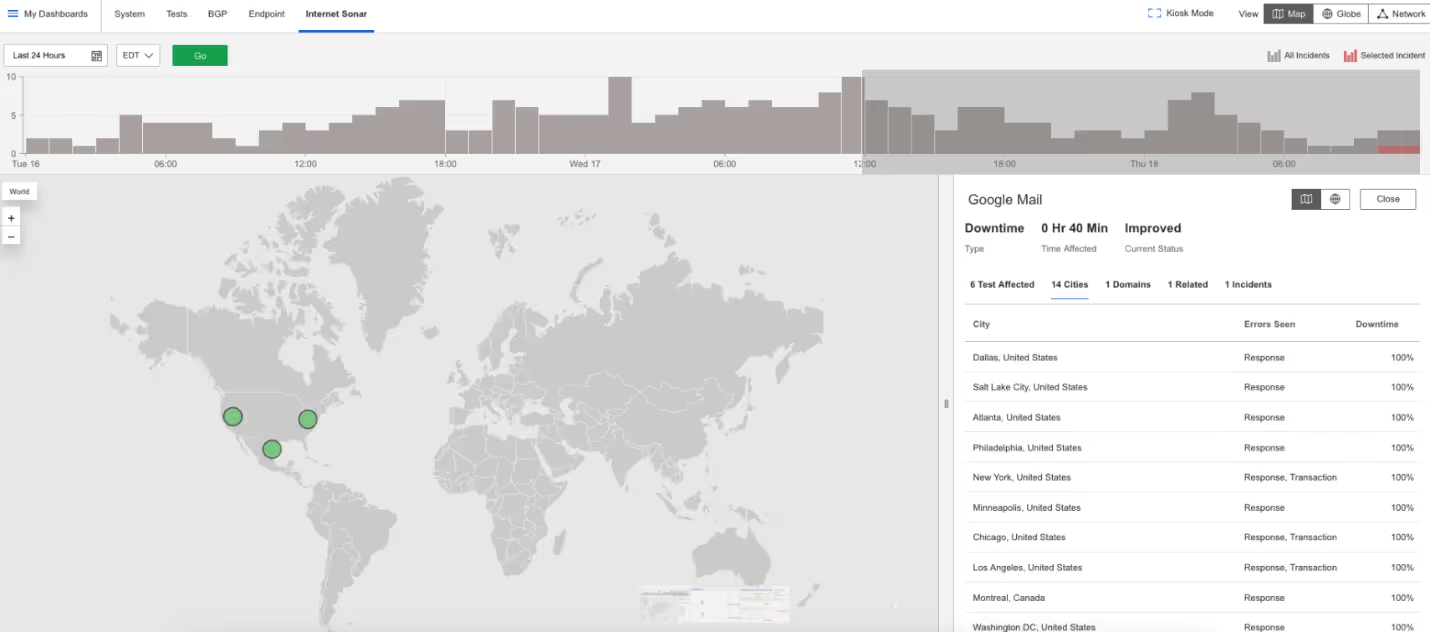

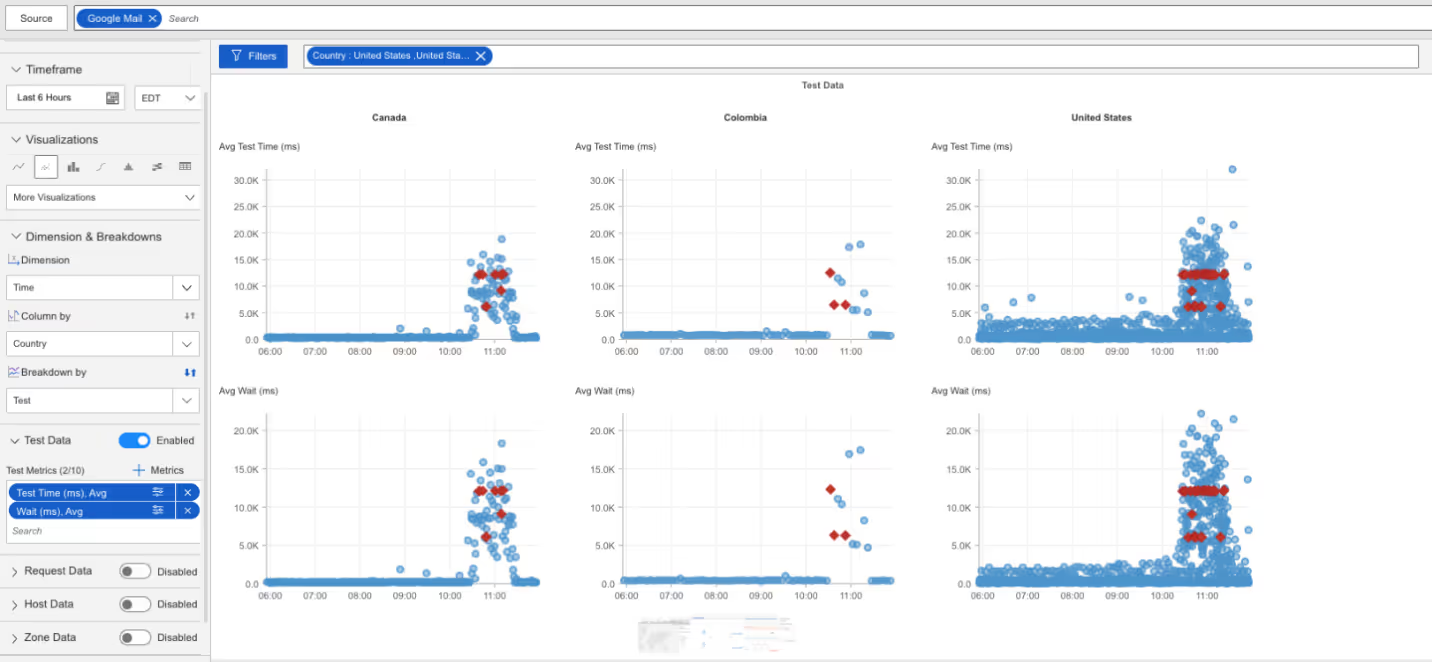

Google Mail

What Happened?

From 10:40 to 11:20 AM EDT, Gmail users couldn’t log in. Attempts to access the login page returned HTTP 502 Bad Gateway errors, which means one server received an invalid response from another. Users also saw slower load times beginning at 10:26 AM EDT.

Takeaways

Login failures are especially disruptive because they block access even when the mail servers are fine. By monitoring full user journeys, from login through inbox, with synthetic monitoring, companies can catch these issues early and strengthen Internet resilience.

NS1

What Happened?

Between 7:08 and 7:32 AM EDT, NS1’s DNS services failed in multiple regions. DNS timeouts (when the system that translates website names into IP addresses doesn’t respond in time) disrupted access to many customer websites, including Pinterest.

Takeaways

When DNS fails, websites become unreachable even if their servers are healthy. Because NS1 underpins many services, its outages ripple widely. Independent monitoring of DNS health and Internet routing (BGP) is key to detecting failures quickly and confirming their scope.

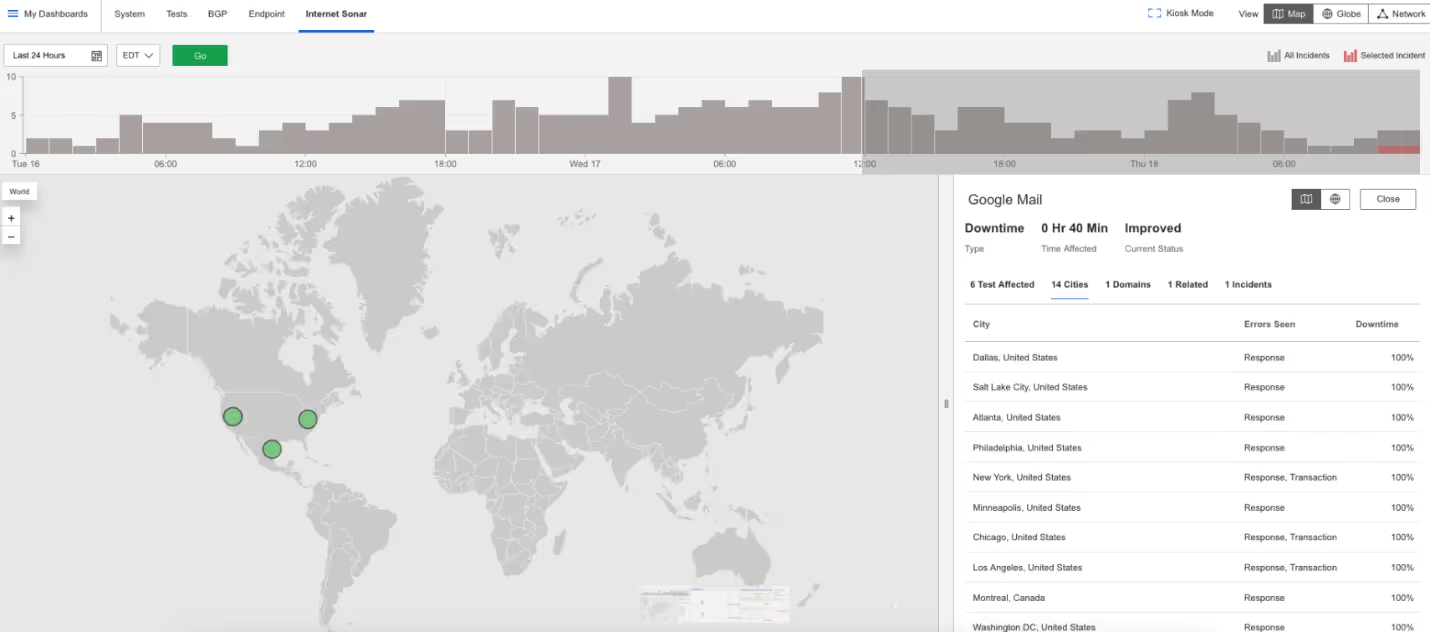

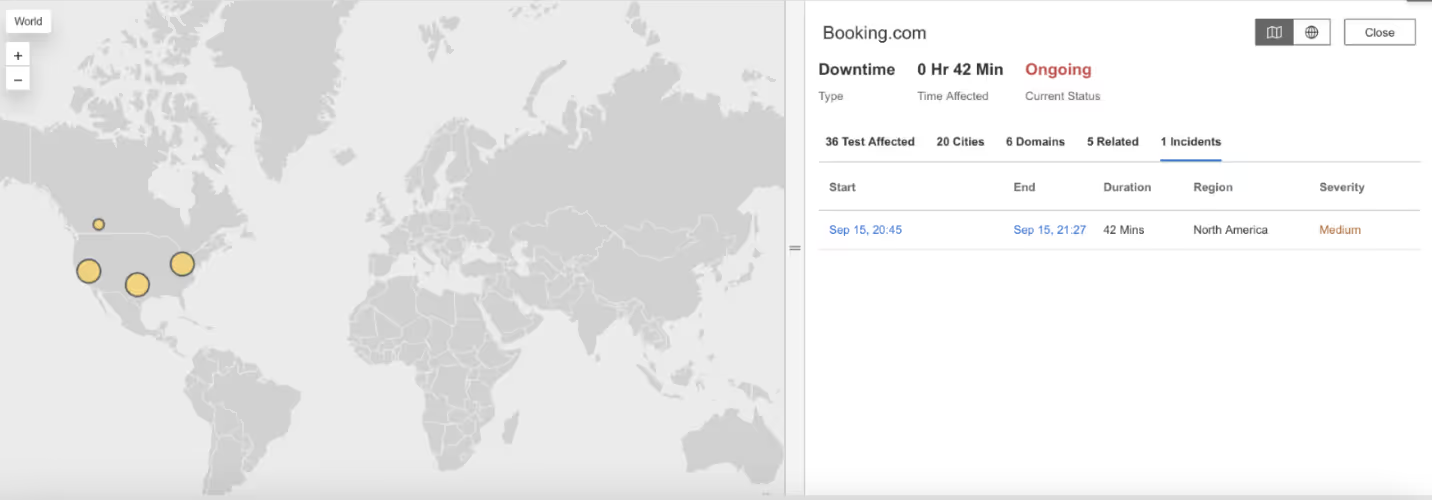

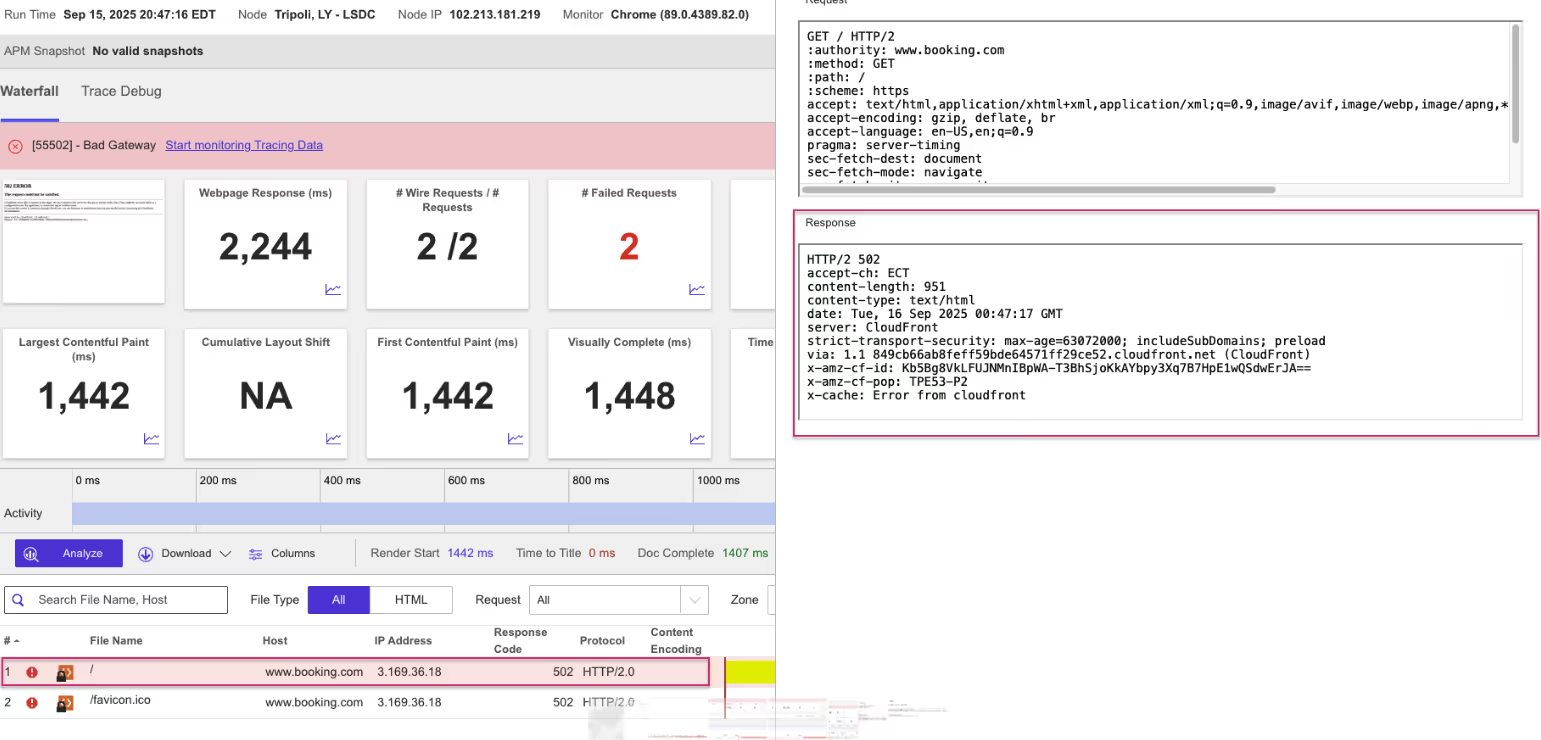

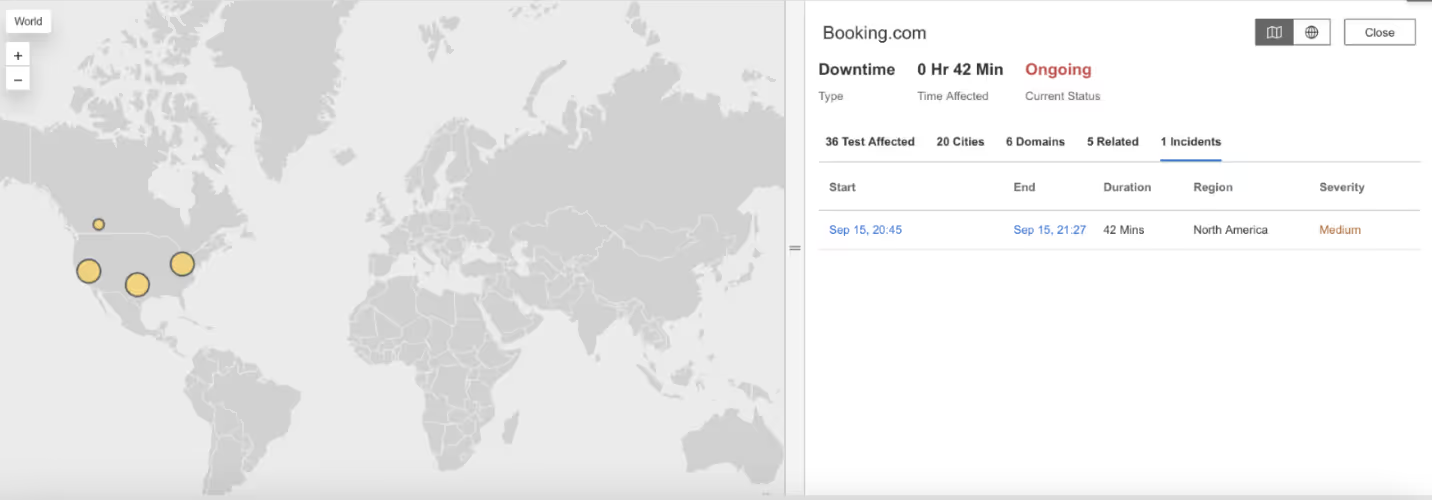

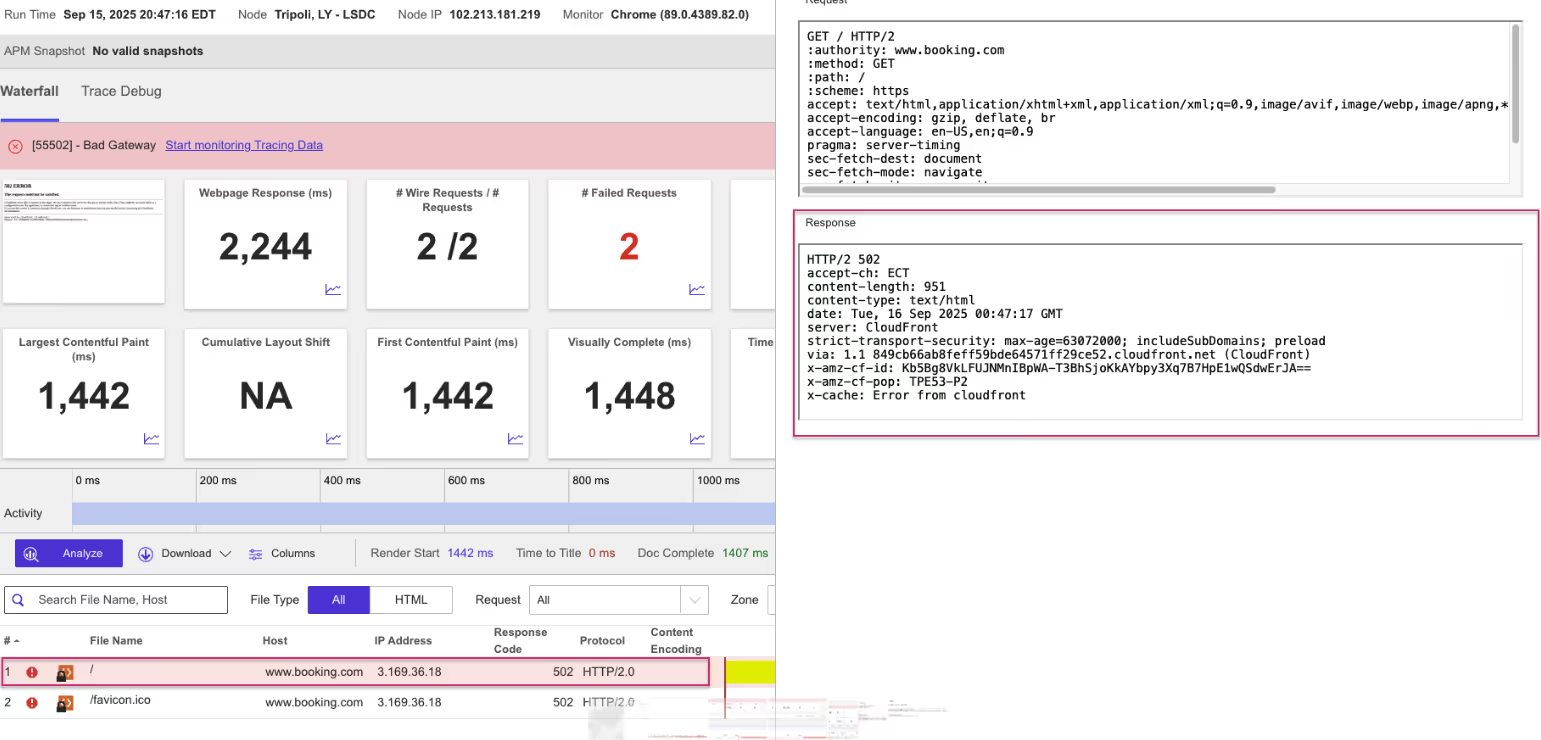

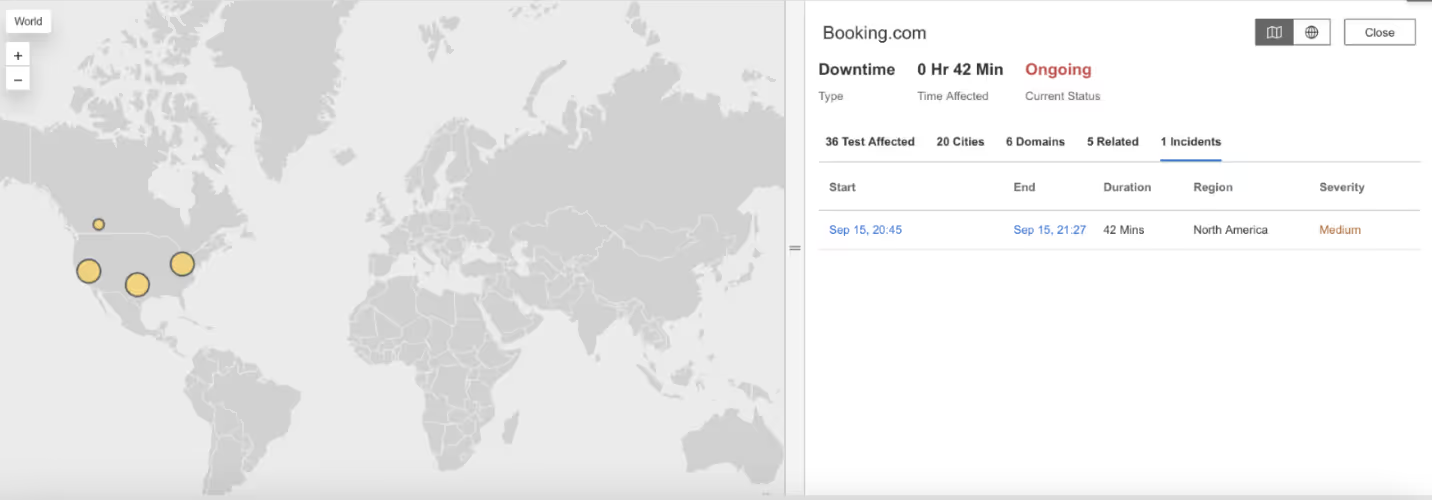

Booking.com

What Happened?

At 8:00 PM EDT, Booking.com services went down across multiple cities. Users received HTTP 502 Bad Gateway errors, meaning the servers handling traffic couldn’t reach the systems behind them.

Takeaways

For travel platforms, outages block reservations and damage trust. A 502 error often points to failures between load balancers and application servers. Synthetic monitoring of APIs and user transactions helps detect these failures early and show exactly where they occur in the service chain.

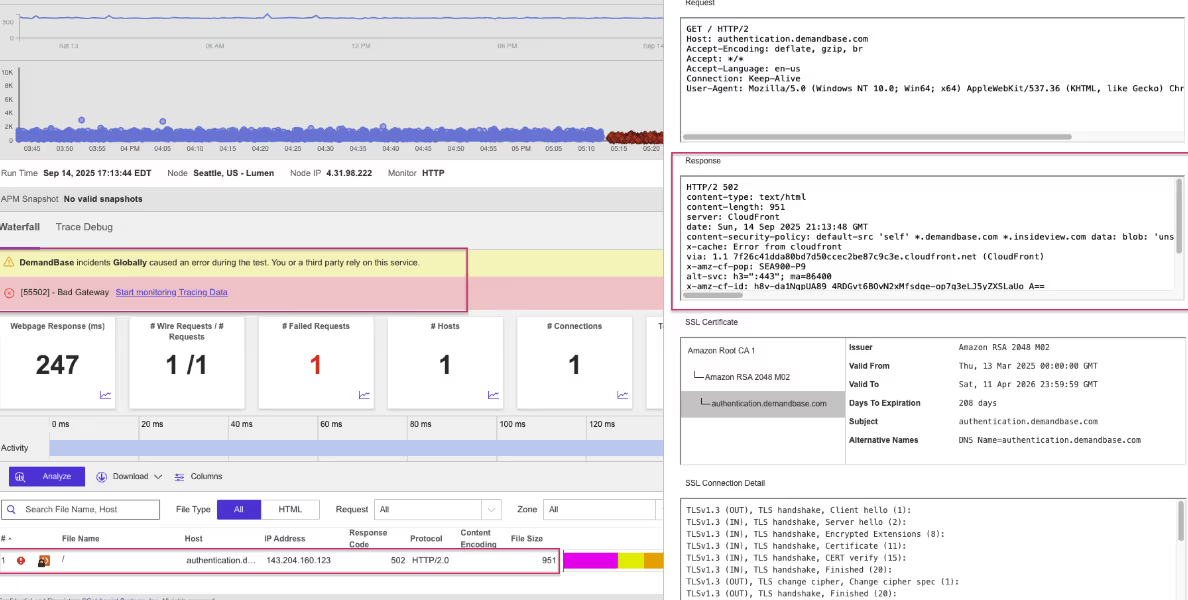

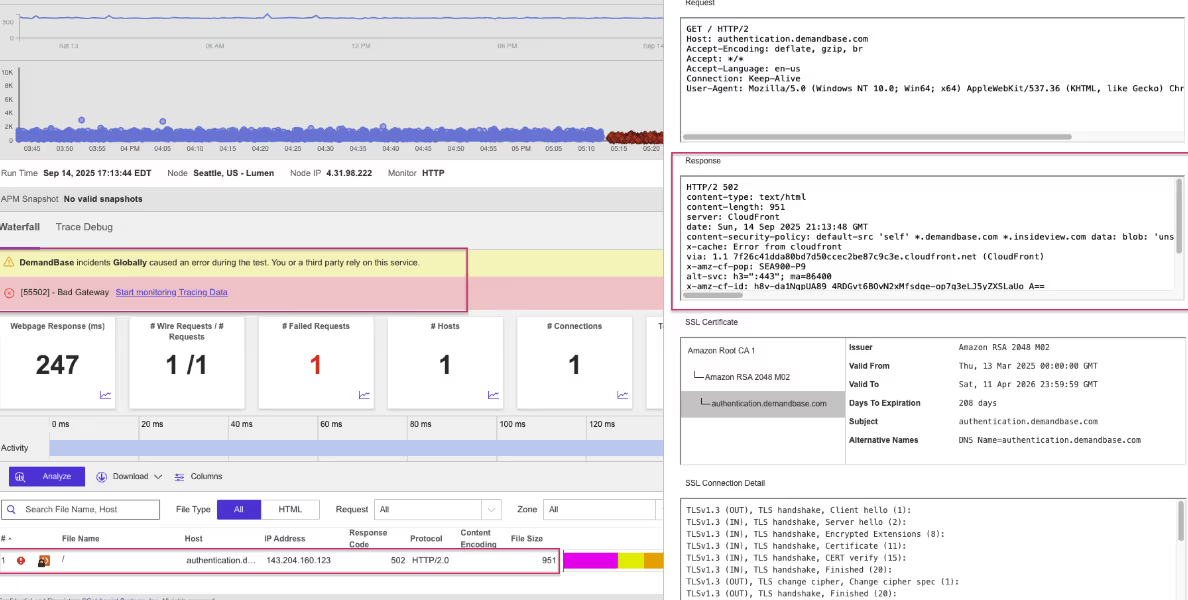

DemandBase

What Happened?

From 5:13 to 6:55 PM EDT, DemandBase experienced a global outage. Users faced HTTP 502 Bad Gateway errors, and later an SSL certificate error that blocked secure connections.

Takeaways

This outage combined server connection problems with a security misconfiguration. Since SSL certificates are required for encrypted access, an expired or invalid certificate can shut users out entirely. Monitoring of SSL health alongside DNS and application performance helps prevent small oversights from becoming major global failures.

Azure

What Happened?

At 3:33 PM EDT, Microsoft’s Azure cloud platform went down across multiple regions. Users saw HTTP 500 Internal Server Errors and HTTP 503 Service Unavailable responses. A 500 error means the server malfunctioned, while a 503 error means it was too busy or unavailable.

Takeaways

Azure is critical infrastructure for enterprises, so outages affect countless dependent services. Monitoring across the full Internet stack, from cloud infrastructure to DNS and CDNs, helps organizations understand whether the issue lies with the cloud provider or external

Microsoft Outlook

What Happened?

At 3:38 AM EDT, Outlook suffered an outage across North America. Users received HTTP 500 Internal Server Error responses, showing the problem was inside Microsoft’s servers.

Takeaways

Email is mission-critical for both business and government. Even short outages disrupt communication. Synthetic monitoring of SaaS services gives enterprises an independent way to detect disruptions early and confirm whether problems are with the provider or the Internet itself.

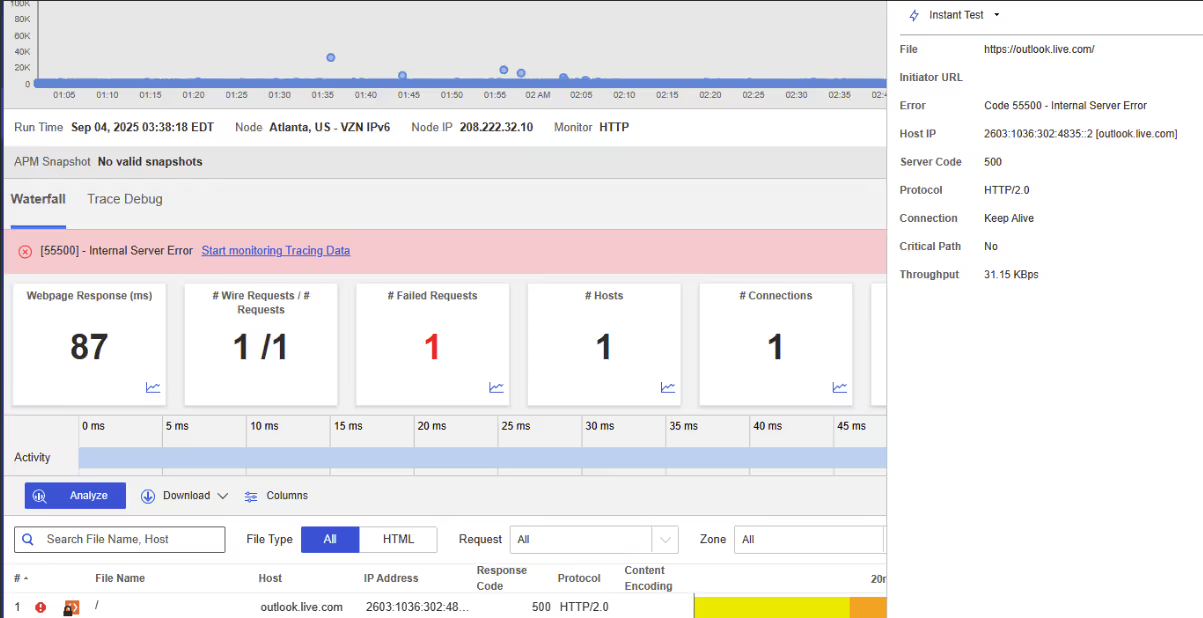

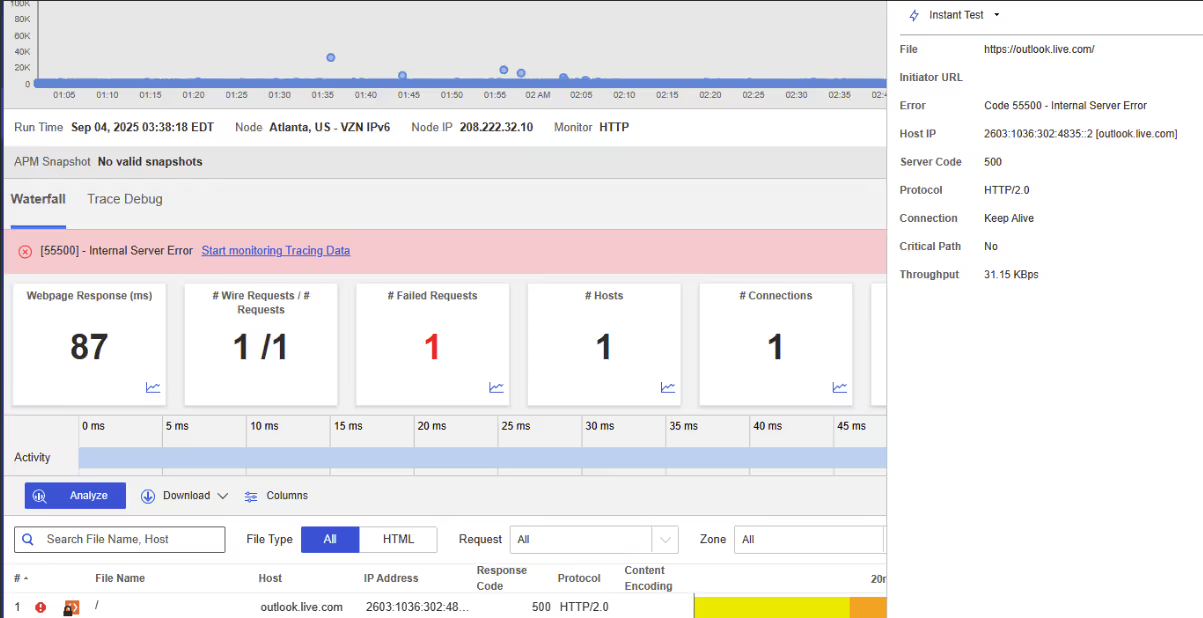

What Happened?

At 5:33 PM EDT, Twitter went down across multiple countries. Users saw HTTP 500 Internal Server Errors, meaning requests reached Twitter’s servers but failed due to internal issues.

Takeaways

Social media outages are highly visible. Internal server errors often stem from backend failures or overloads. Monitoring from global vantage points is critical to confirm whether an outage is regional or global, which helps providers respond faster.

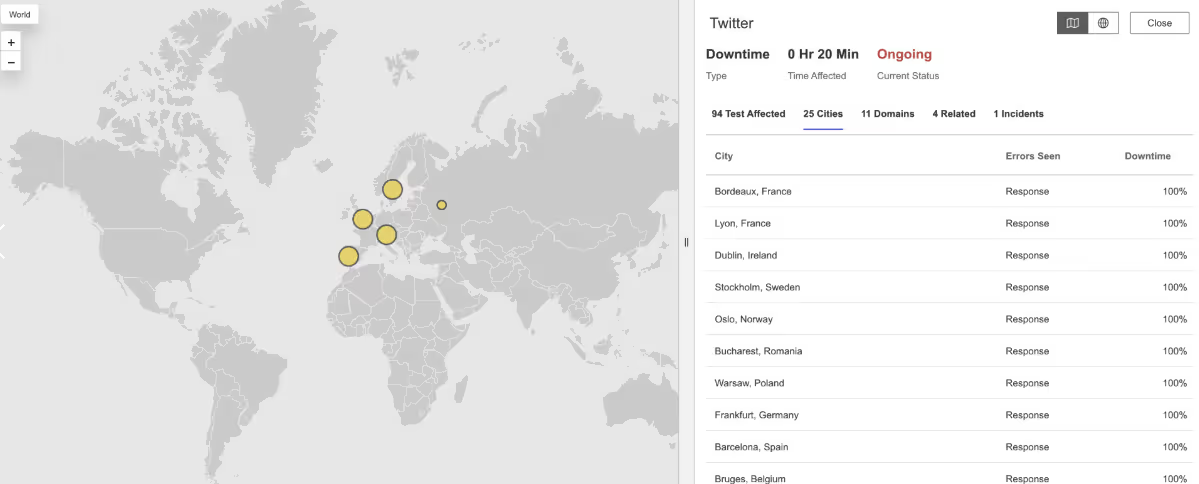

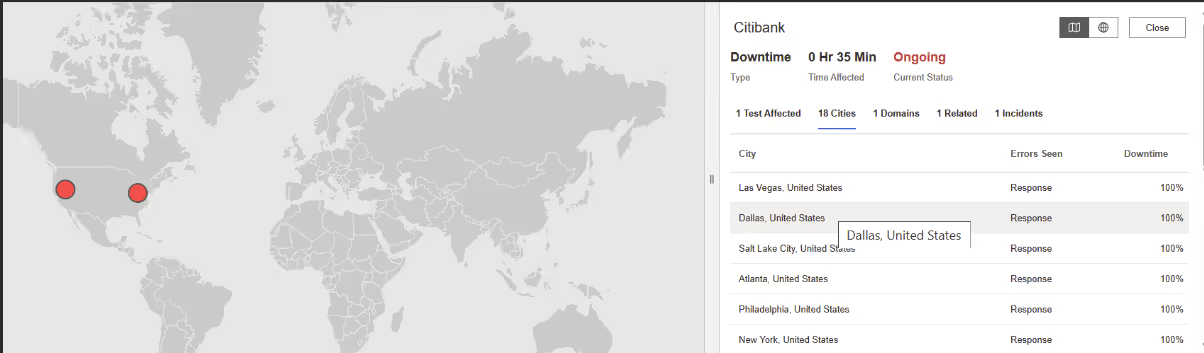

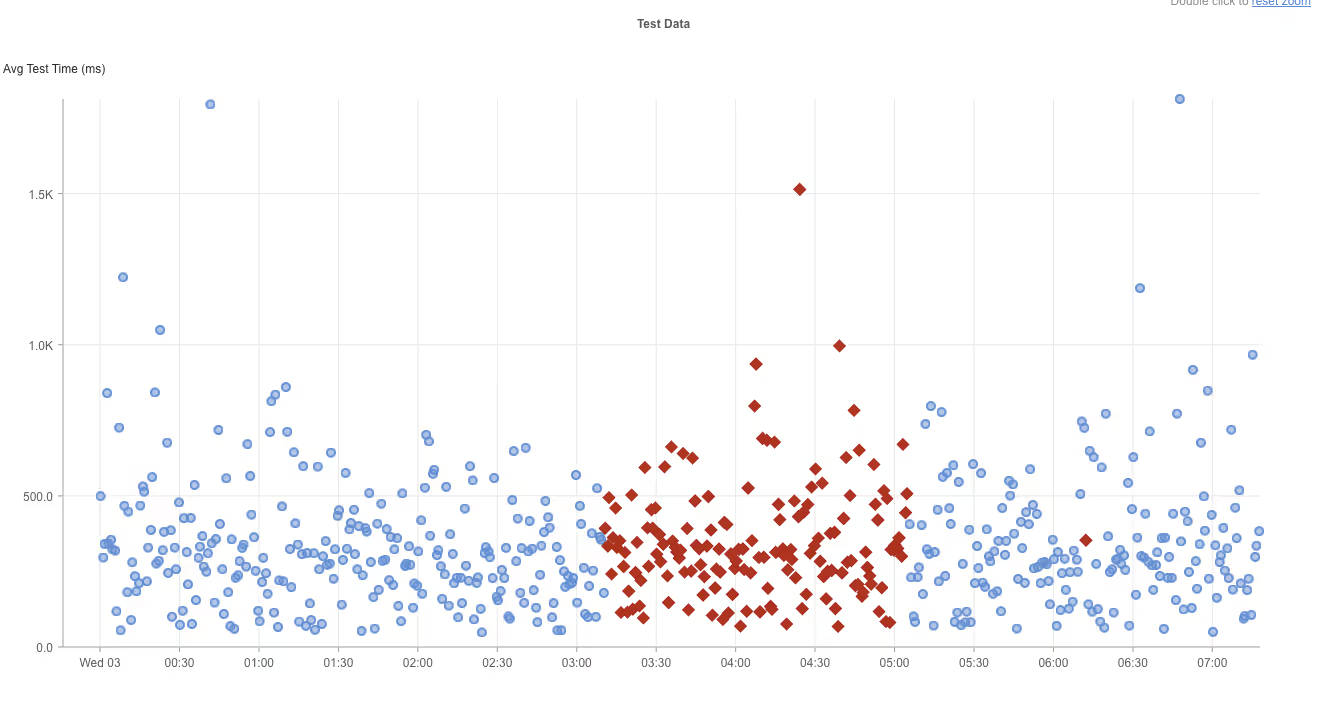

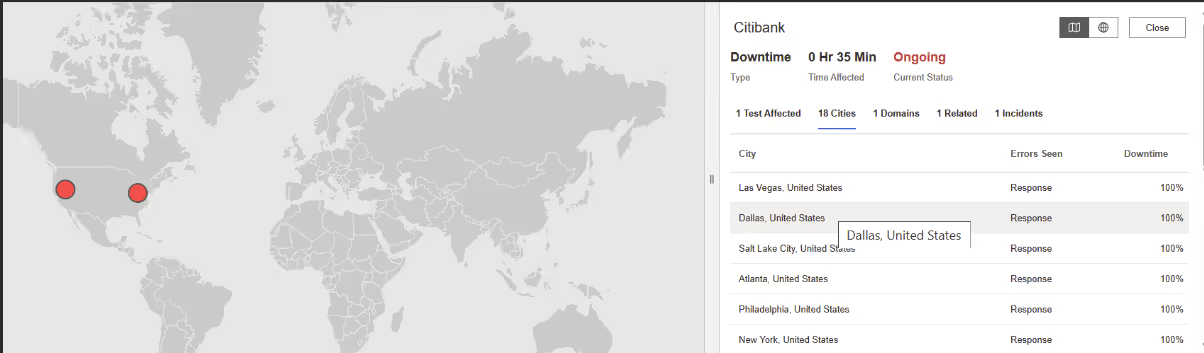

Citibank

What Happened?

From 3:10 to 5:04 AM EDT, Citibank services were disrupted across North America. Customers faced HTTP 502 Bad Gateway errors, showing that front-end servers couldn’t reach the banking systems behind them.

Takeaways

For financial institutions, downtime blocks critical transactions and erodes trust. Monitoring across DNS, TLS, and application performance layers provides early warnings and helps ensure banking services remain resilient.

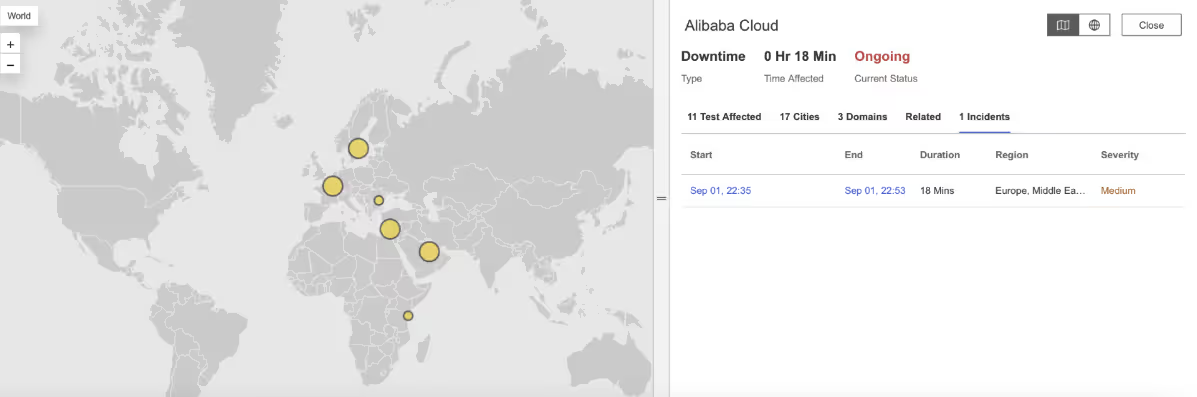

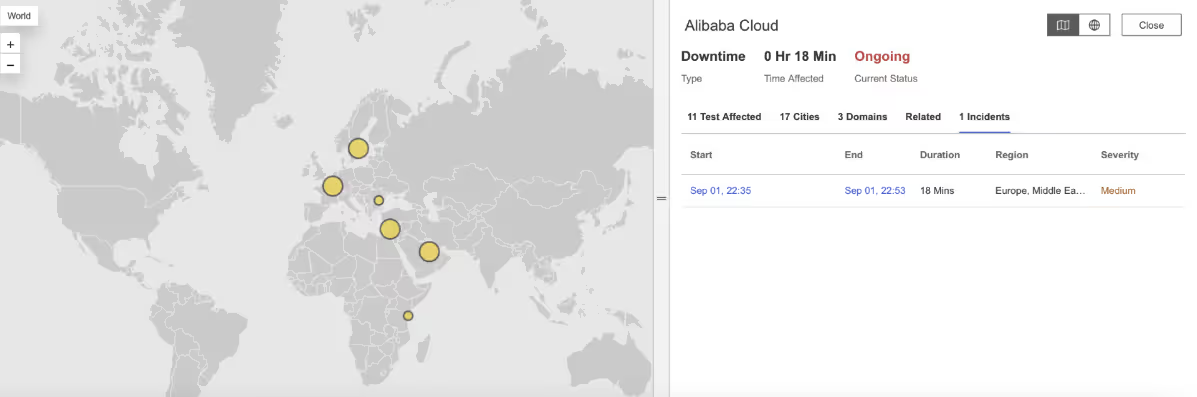

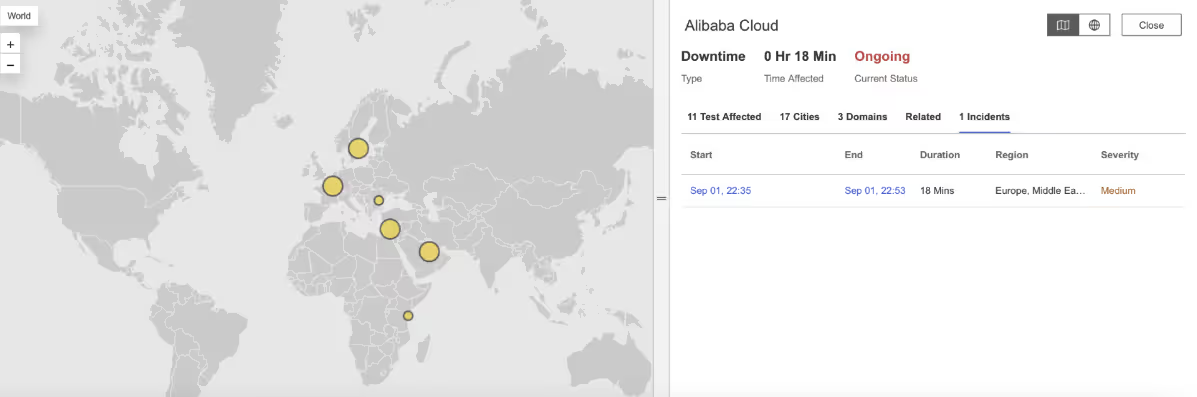

Alibaba Cloud

What Happened?

From 10:35 to 10:50 PM EDT, Alibaba Cloud experienced a regional outage. Users saw slow responses and a mix of errors: HTTP 500 Internal Server Error, 502 Bad Gateway, 504 Gateway Timeout, and 413 Payload Too Large.

Takeaways

The mix of errors shows stress across multiple parts of Alibaba Cloud’s infrastructure — from server overloads to request handling limits. With synthetic monitoring from distributed locations, businesses can confirm the scope of failures and reroute workloads to unaffected regions to maintain service availability.

August

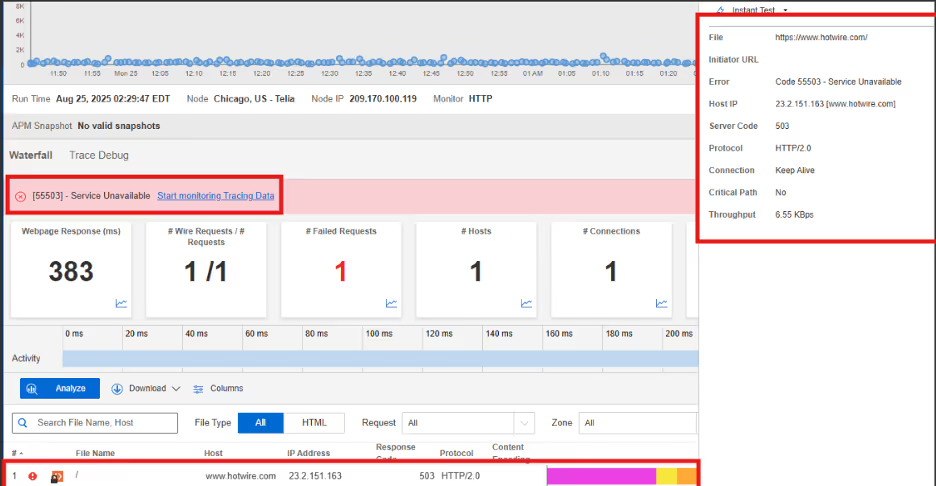

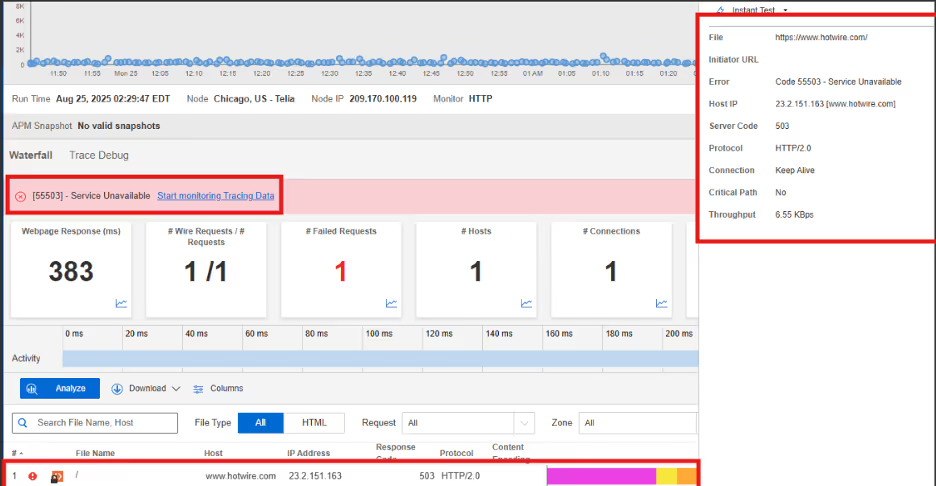

Hotwire

What Happened?

On August 25, 2025, at 2:09 AM EDT, Internet Sonar detected an outage affecting Hotwire services across multiple regions, including the US and Canada. During the incident, requests to https://www.hotwire.com/ returned HTTP 504 (Gateway Timeout) and HTTP 503 (Service Unavailable) responses from multiple locations, starting at 2:09 AM EDT.

Takeaways

Service unavailability and gateway timeout errors can occur simultaneously, suggesting both server-side resource strain and upstream communication issues. The impact across multiple regions indicates that the outage was not localized, but rather a broader service disruption. Continuous monitoring with distributed vantage points was key to rapidly identifying the extent and nature of the failures.

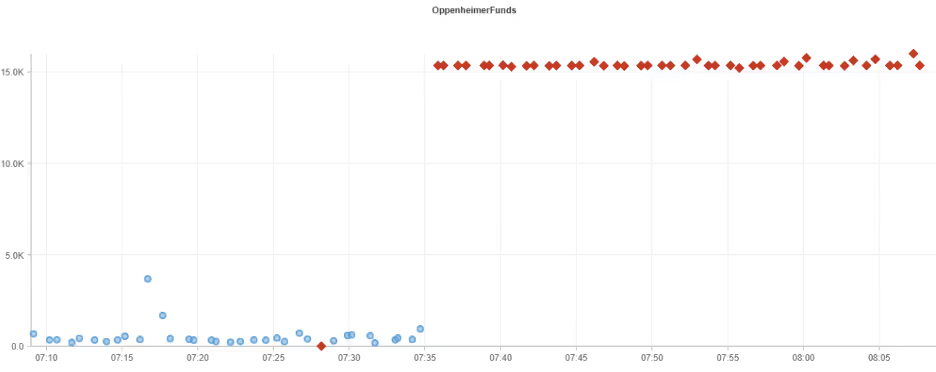

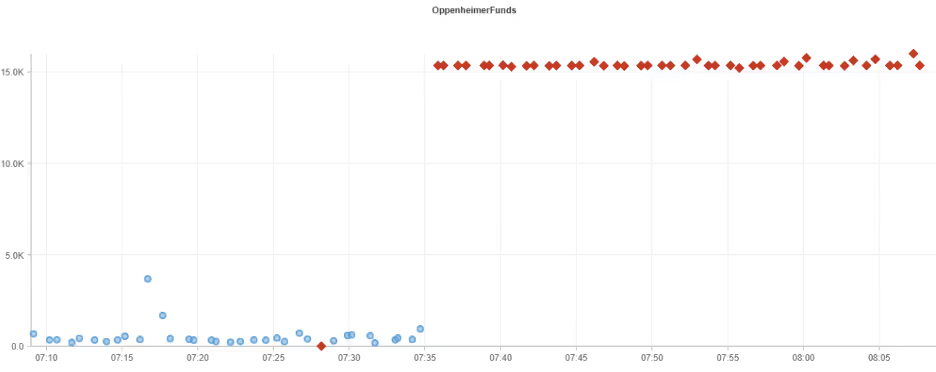

Oppenheimer Funds

What Happened?

On August 23, 2025, at 7:35 AM EDT, Internet Sonar detected an outage affecting Oppenheimer Funds services across the North America region. During the incident, high connection time was observed for requests which belonged to the domain: https://www.oppenheimerfunds.com/

Takeaways

Unlike hard failures, latency-driven disruptions often lead to slower page loads, transaction delays, and potential session timeouts. Organizations should monitor not only for outright service failures but also for performance degradation, as these can signal early warnings of infrastructure stress or misconfigured dependencies. Proactive performance monitoring and capacity planning are critical for minimizing the business impact of such issues.

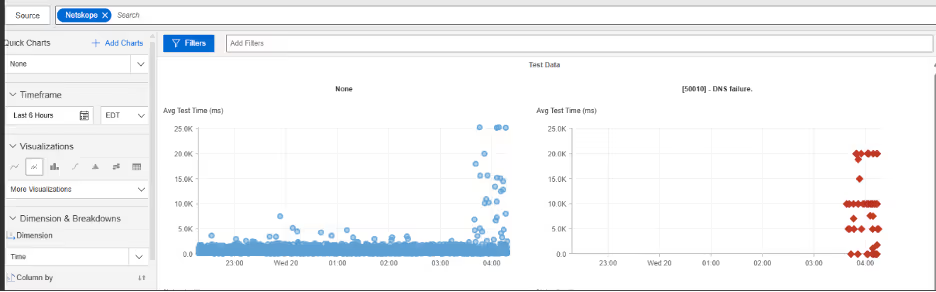

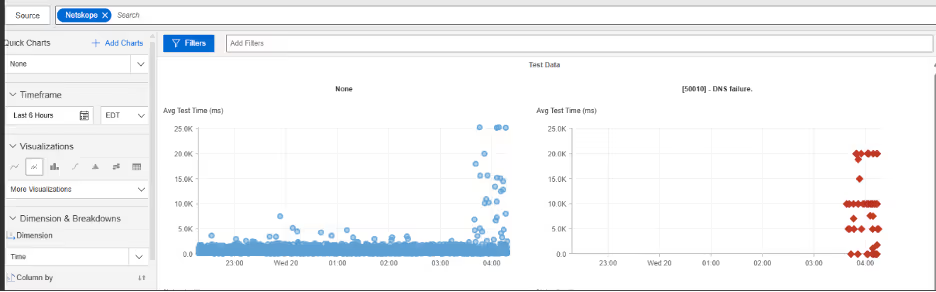

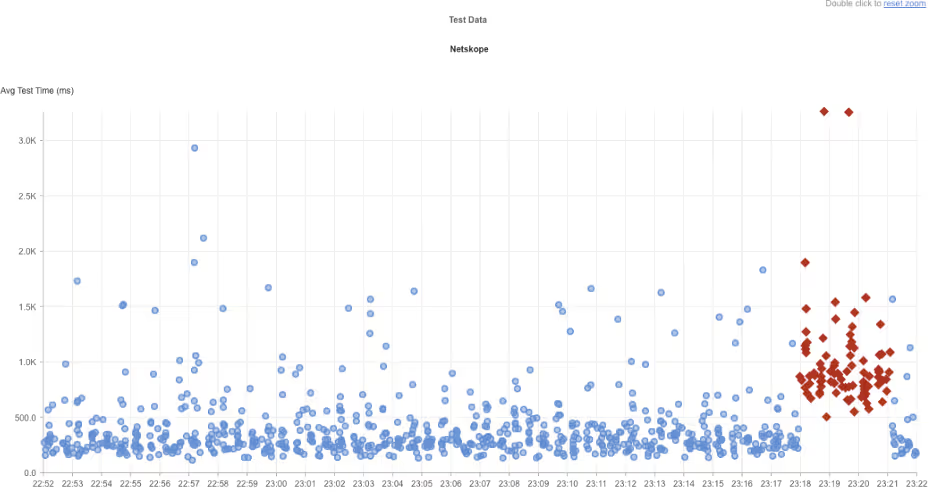

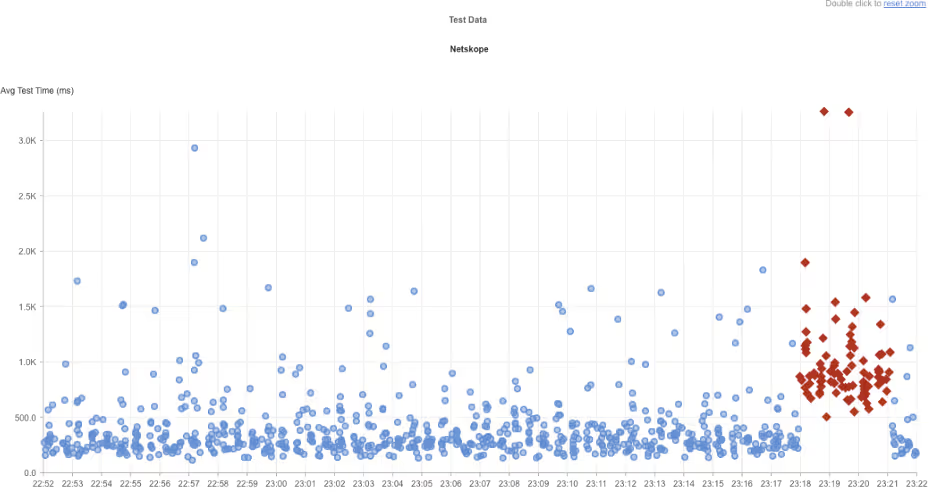

Netskope

What Happened?

On August 20, 2025, at 3:38 AM EDT, Internet Sonar detected an outage affecting Netskope across multiple regions of the United States. During the outage DNS resolution failures were observed for the domain https://www.netskope.com/, starting at 03:38:16 EDT from multiple US locations. Queries at Level 2 nameservers returned “unknown” responses due to 100% packet loss.

Takeaways

Even when application servers remain healthy, failures at the nameserver level can render services inaccessible to users. The 100% packet loss indicates a systemic issue rather than localized degradation, pointing to either a provider-side misconfiguration or a broader infrastructure disruption. To mitigate risks, organizations should consider implementing redundant DNS providers, monitoring resolution paths from diverse geographies, and preparing failover strategies that minimize user-facing impact when primary nameservers fail.

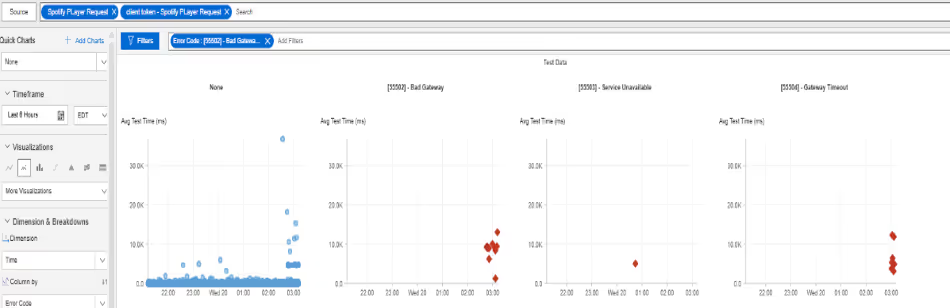

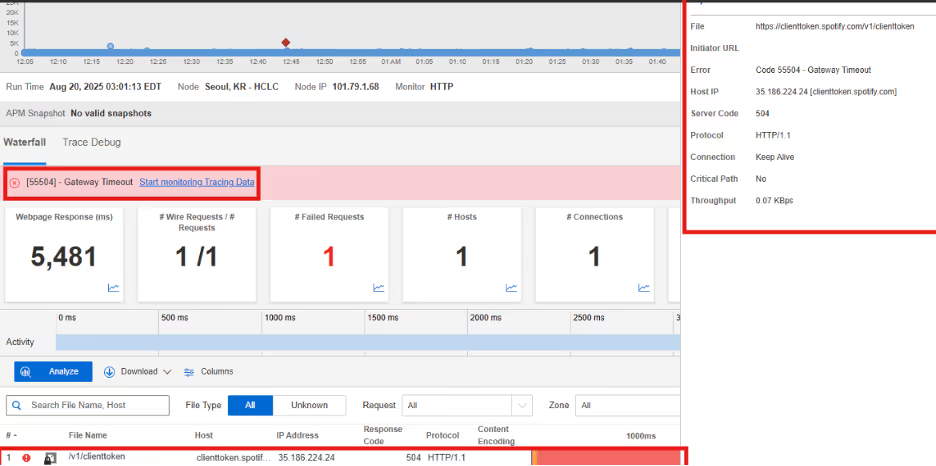

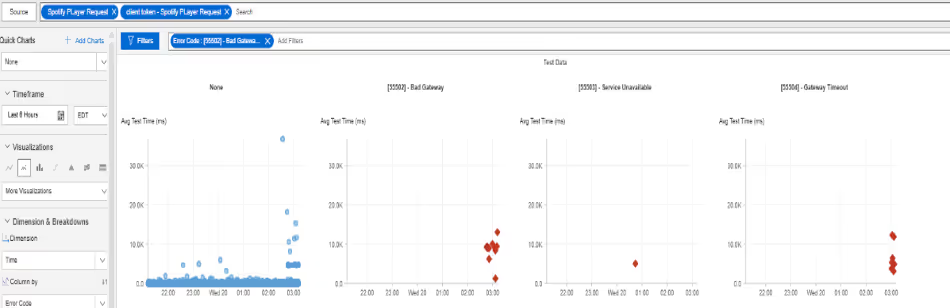

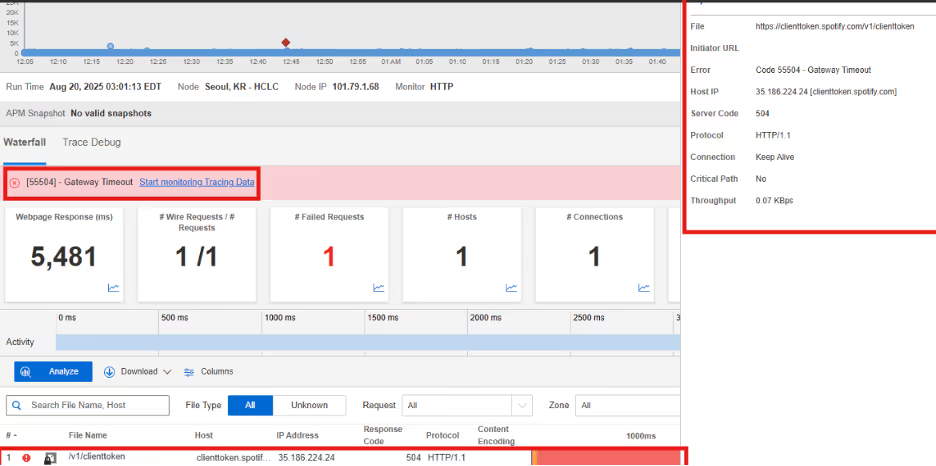

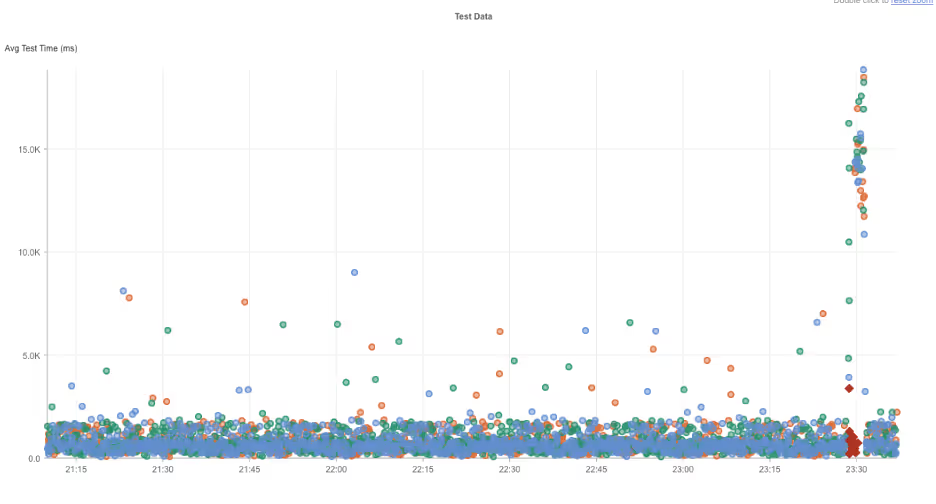

Spotify

What Happened?

On August 20, 2025, at 2:45 AM EDT, Internet Sonar detected an outage affecting Spotify services across multiple locations in the Asia Pacific region. During the incident, requests to clienttoken.spotify.com and apresolve.spotify.com returned HTTP 502 (Bad Gateway) and HTTP 504 (Gateway Timeout) responses.

Takeaways

This outage highlights the fragility of token authentication and service resolution endpoints, both of which are critical to ensuring seamless user access and playback functionality. Failures at these layers often prevent session validation and disrupt connectivity between client applications and core infrastructure. Organizations operating at global scale should implement robust redundancy for authentication and service discovery components, as well as proactive health checks to quickly detect and remediate gateway errors before they cascade into regional outages.

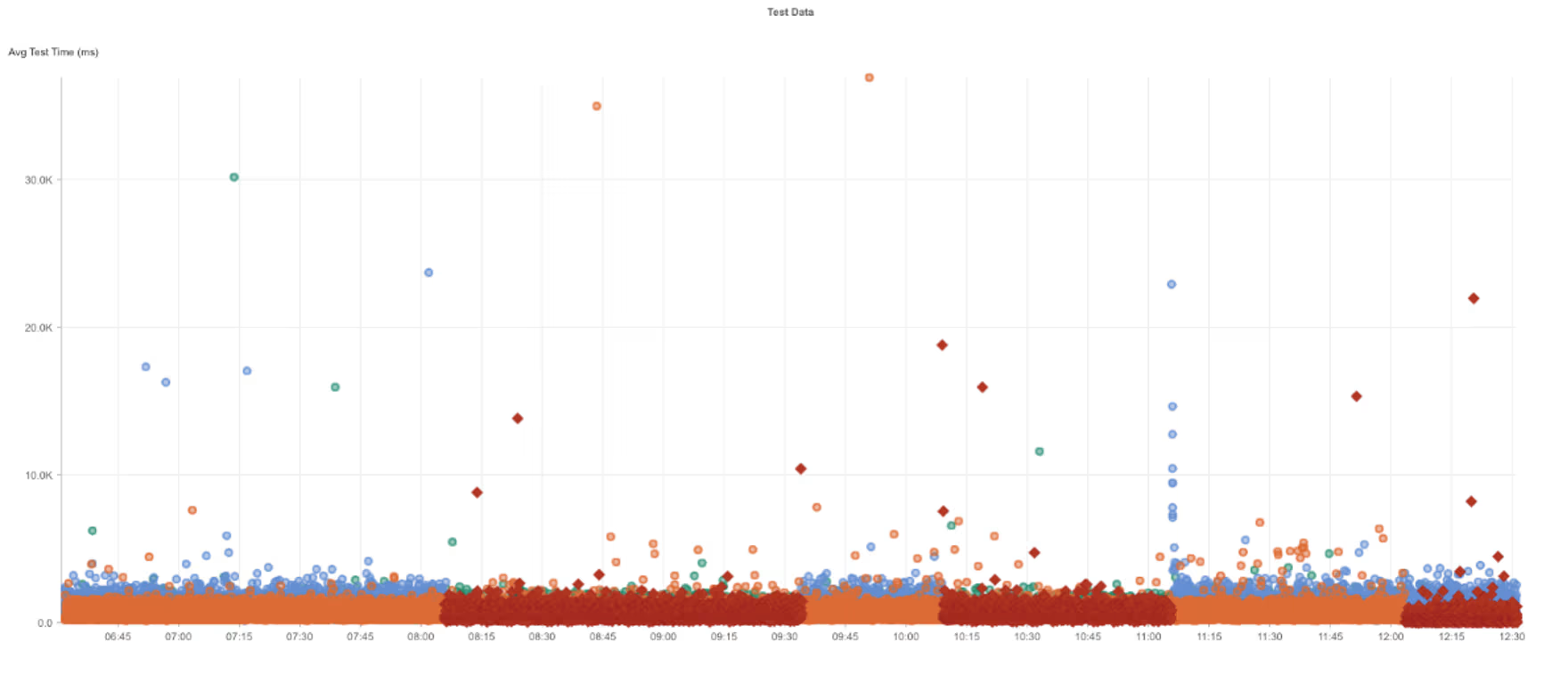

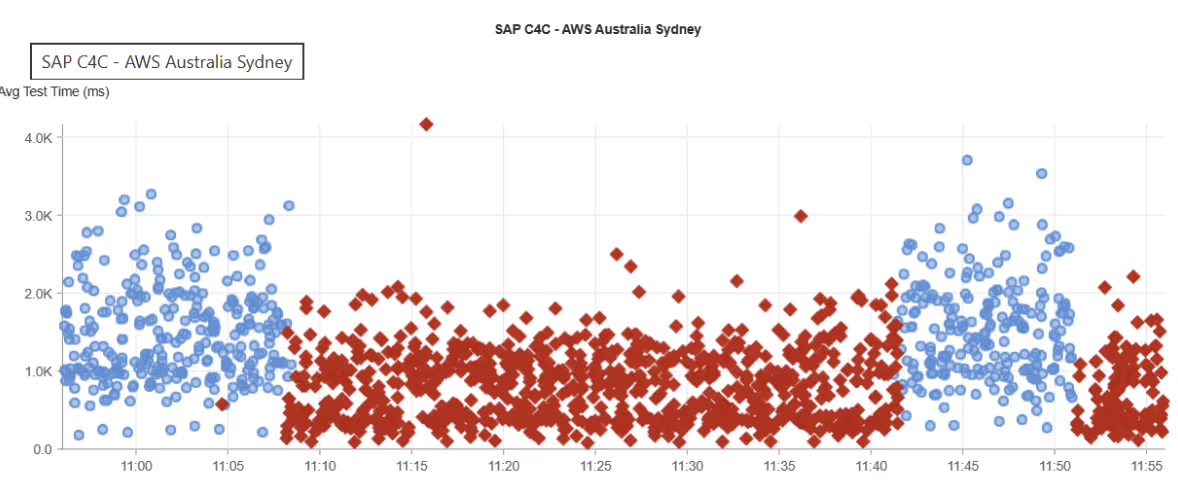

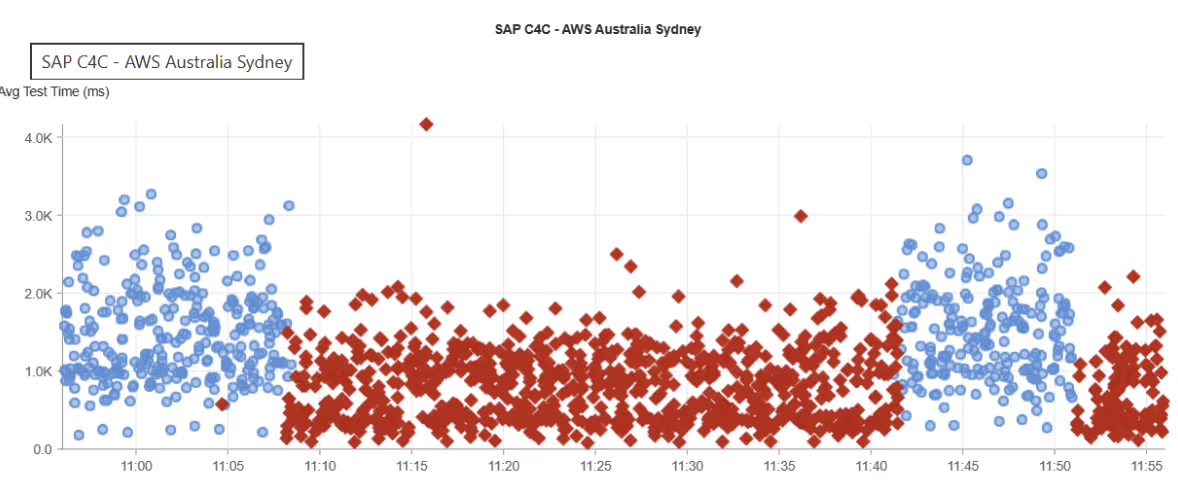

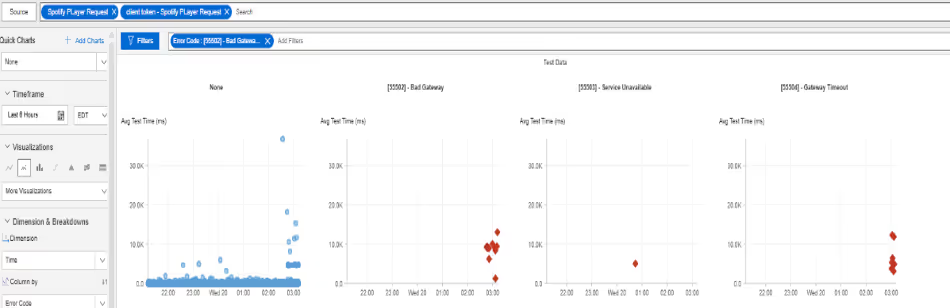

SAP C4C

What Happened?

On August 16, 2025, at 9:06 AM EDT, Internet Sonar detected an outage impacting SAP C4C services across multiple regions, including Asia Pacific, Europe, the Middle East and Africa, Latin America, and North America. During the incident, requests to https://my354302.crm.ondemand.com returned HTTP 503 Service Unavailable responses.

Takeaways

This widespread outage demonstrates how service-layer failures can propagate globally when centralized infrastructure experiences disruption. The uniform 503 errors suggest resource exhaustion or unavailability of backend systems rather than isolated network issues. For cloud-based CRM platforms supporting distributed enterprises, such incidents can severely hinder business continuity. To mitigate risk, providers should ensure adequate load balancing, geographic redundancy, and capacity safeguards to maintain availability across all served regions.

Datadog

What Happened?

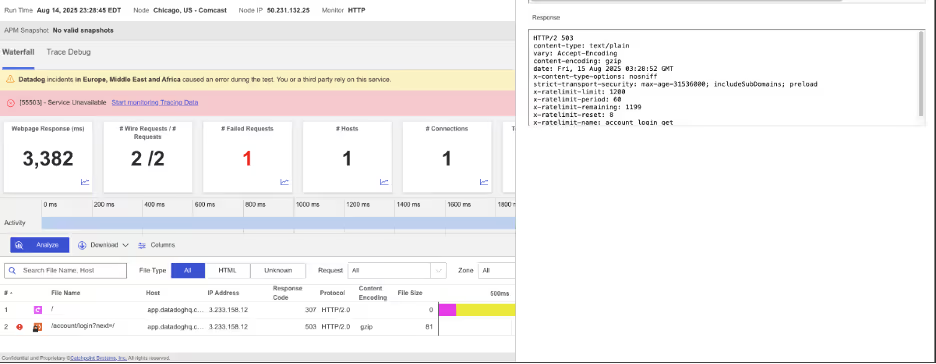

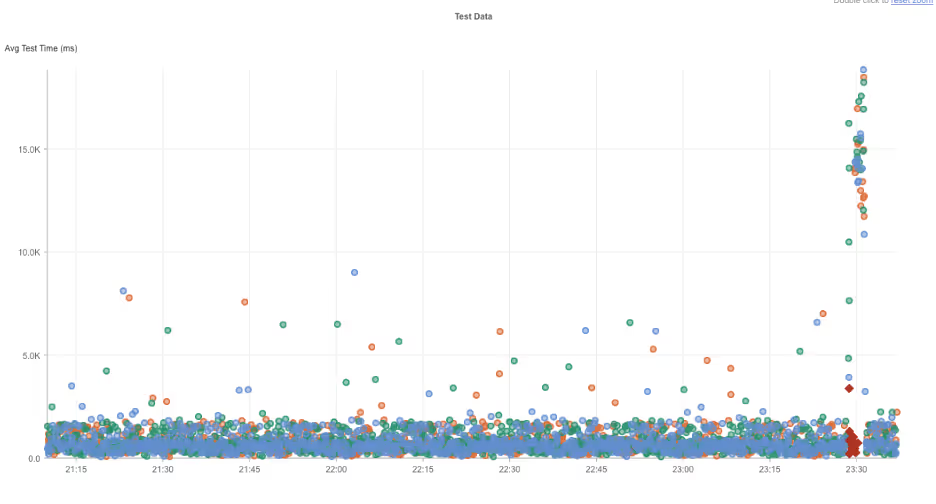

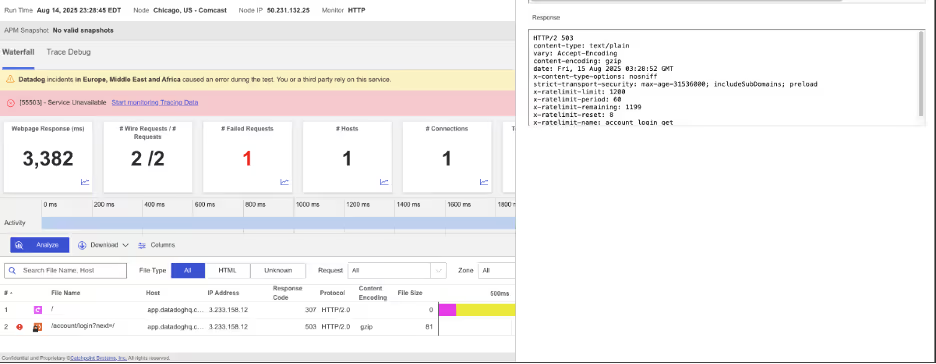

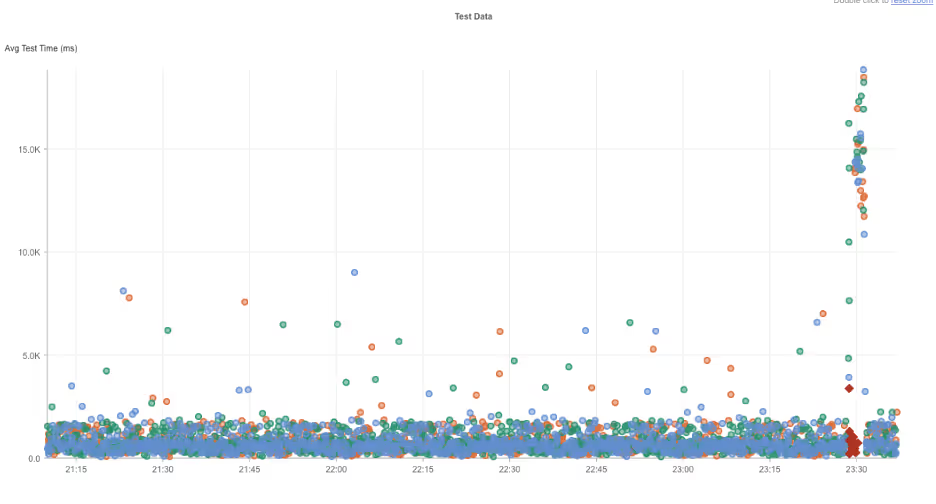

On August 14, 2025, at 11:25 PM EDT, Internet Sonar detected an outage affecting Datadog services across multiple regions, including Europe, the Middle East, Africa, and North America. During the incident, requests to multiple Datadog domains, including app.datadoghq.com, logs.datadoghq.com, and synthetics.datadoghq.com, returned HTTP 503 Service Unavailable responses. The service disruption lasted approximately 5 minutes, with recovery observed by 11:30 PM EDT.

Takeaways

Although brief, this outage illustrates the operational impact of simultaneous failures across multiple critical service domains. For a platform like Datadog, which provides observability and monitoring at scale, even short-lived disruptions can have cascading effects on customers’ ability to track application health, detect incidents, and respond to ongoing issues. This event highlights the importance of service segmentation, robust failover mechanisms, and proactive incident communication to reduce the business impact of multi-domain availability failures.

It also raises the question of “who monitors the monitors?” Because Datadog is cloud-hosted, any disruption to its underlying hosting environment directly affects both its own services and customers’ visibility into their systems. This underlines the value of leveraging a robust monitoring strategy with multiple independent vantage points, ensuring continuity of insight even when a primary monitoring provider experiences downtime.

Netskope

What Happened?

On August 14, 2025, at 11:17 PM EDT, Internet Sonar identified an ongoing outage affecting Netskope services across multiple regions, including Asia Pacific, North America, Europe, the Middle East, and Africa. Requests to www.netskope.com have been returning HTTP 500 Internal Server Error responses from multiple global locations since the start of the incident, indicating a widespread server-side issue.

Takeaways

This incident demonstrates the risks posed by core server-side failures, where application infrastructure becomes unable to process requests globally. HTTP 500 errors typically point to misconfigurations, software bugs, or overloaded backend systems—issues that can quickly cascade across a cloud-delivered platform like Netskope. The simultaneous global impact underscores the importance of resilient deployment strategies, such as distributed service clusters, failover mechanisms, and staged rollouts to minimize widespread disruption.

For security and cloud access providers, outages of this nature can be particularly disruptive, as they impair the very services enterprises rely on for secure connectivity. Proactive monitoring across multiple regions is essential for rapid detection and faster root-cause isolation. Although brief, this outage illustrates the operational impact of simultaneous failures across multiple critical service domains.

TikTok

What Happened?

On August 14, 2025, at 4:36 PM EDT, Internet Sonar detected an outage impacting TikTok services in North America. During the incident, requests to https://www.tiktok.com/en/ began returning HTTP 504 Gateway Timeout responses. The outage lasted approximately 11 minutes, with services restored by 4:47 PM EDT.

Takeaways

This short-lived but disruptive outage highlights how gateway-level failures can quickly impact availability for a large user base. HTTP 504 errors often point to issues with upstream services or overloaded edge infrastructure, preventing requests from being properly routed or processed. For consumer-facing platforms like TikTok, even brief downtime can cause a noticeable user experience impact at scale. Ensuring redundancy at the gateway layer and deploying rapid failover mechanisms are critical steps for minimizing the effect of such time-sensitive disruptions.

Aurus Credit Processing

What Happened?

On August 14, 2025, at 1:23 AM EDT, Internet Sonar detected an outage affecting Aurus Credit Processing services across multiple regions, including Asia Pacific and North America. During the outage, requests to www.aurusinc.com experienced connection failures and elevated connect times. The disruption was short-lived, with services recovering by 1:30 AM EDT.

Takeaways

Even brief outages in payment and credit processing services can have outsized consequences, disrupting transaction flows and undermining customer trust. In this case, elevated connection times paired with outright failures suggest transient network or infrastructure strain rather than a full service breakdown. Such incidents highlight the importance of monitoring latency as closely as outright availability, since early performance degradation often precedes broader outages. Implementing redundancy in payment gateways and ensuring rapid failover mechanisms are key to minimizing disruption in mission-critical financial services.

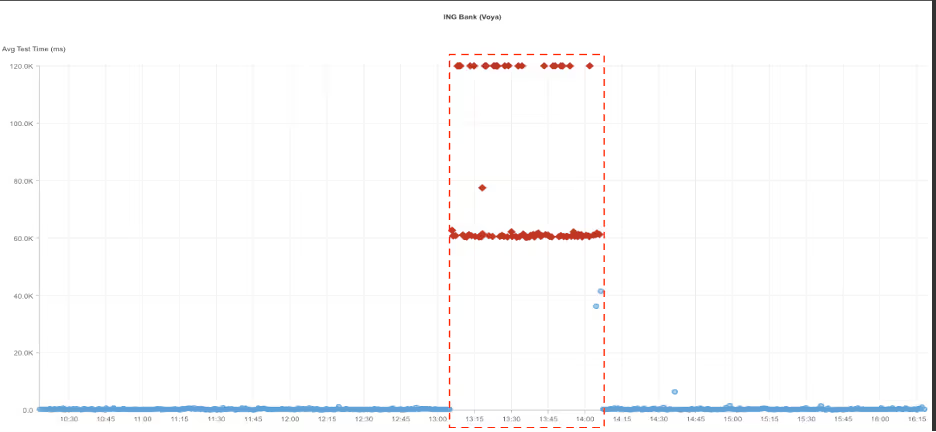

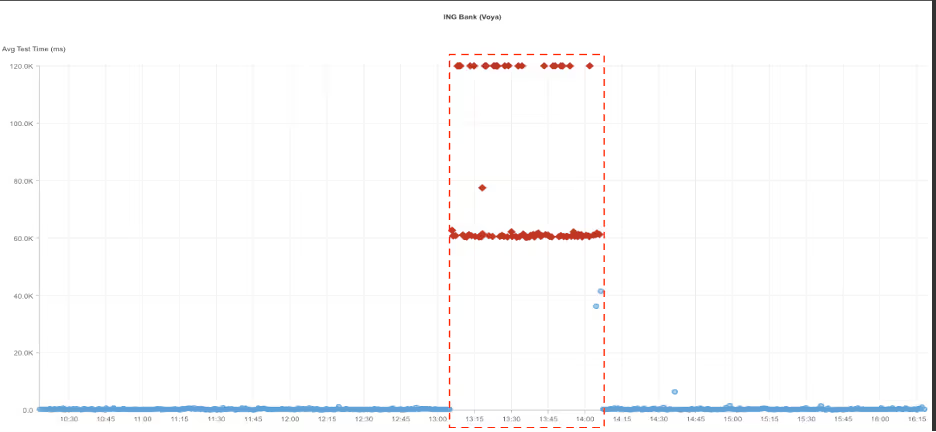

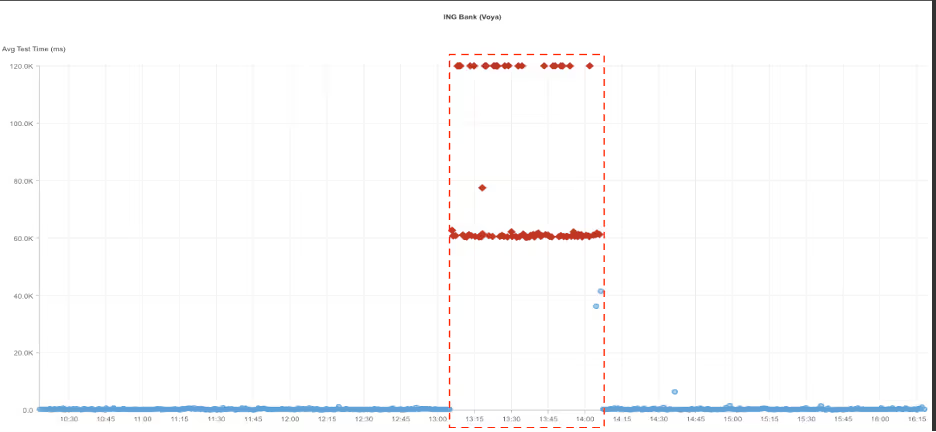

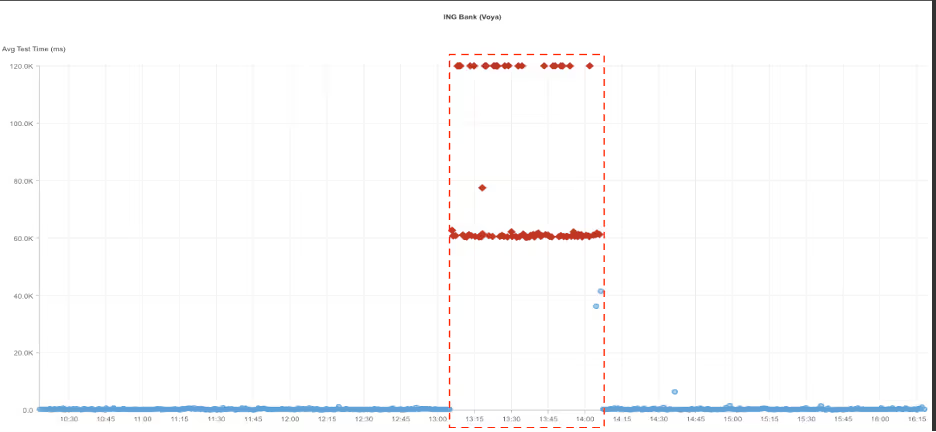

ING Bank (Voya)

What Happened?

On August 13, 2025, at 1:05 PM EDT, Internet Sonar detected an outage impacting ING Bank (Voya) services. During this period, requests to https://www.ing.com returned HTTP 504 Gateway Timeout responses. The outage was observed for approximately one hour, with normal functionality restored by 2:05 PM EDT.

Takeaways

A one-hour outage for a major financial institution highlights the critical nature of maintaining consistent online availability in the banking sector. Gateway timeout errors typically indicate issues with upstream servers or overloaded infrastructure, suggesting that backend systems were unable to respond to client requests during the disruption. For customers, the inability to access digital banking services for an extended period can erode trust and disrupt critical financial activities.

This incident underscores the need for robust redundancy, proactive traffic management, and continuous monitoring to quickly identify and remediate infrastructure bottlenecks. Financial institutions, in particular, benefit from layered failover mechanisms that can mitigate the impact of gateway-level failures and minimize customer-facing downtime.

Azure Central India

What Happened?

On August 11, 2025, at 2:38 PM EDT, Internet Sonar detected an outage impacting Azure Central India services, specifically affecting GitHub availability. During the incident, requests to https://github.com began returning HTTP 503 Service Unavailable responses. The outage was observed across the Asia pacific region and lasted approximately 14 minutes, with outage recovering by 2:52 PM EDT

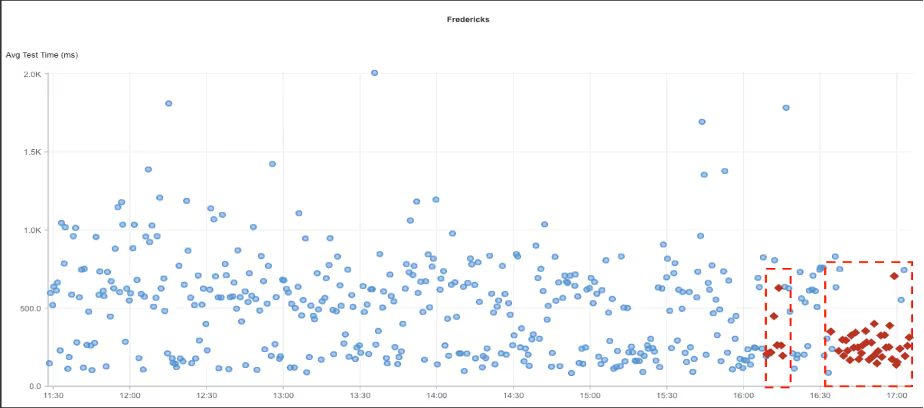

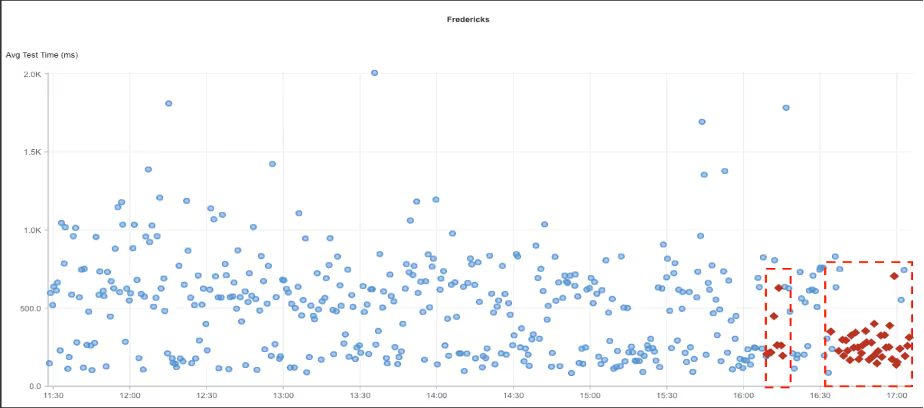

Fredericks

What Happened?

On August 7, 2025, at 4:34 PM CDT, Internet Sonar detected an outage impacting Fredericks services. The issue was observed across multiple cities in the United States. Requests to the website, https://www.fredericks.com, began returning HTTP 500 Internal Server Error responses, indicating a server-side failure.

Takeaways

HTTP 500 errors point to underlying server or application issues rather than network-level disruptions, suggesting that Fredericks’ backend systems were unable to handle incoming traffic during the outage. For retail and e-commerce platforms, such failures can directly affect revenue and customer trust, particularly if they occur during peak traffic periods. This event underscores the importance of robust application monitoring, load testing, and redundancy in backend infrastructure to minimize downtime caused by server-side instability.

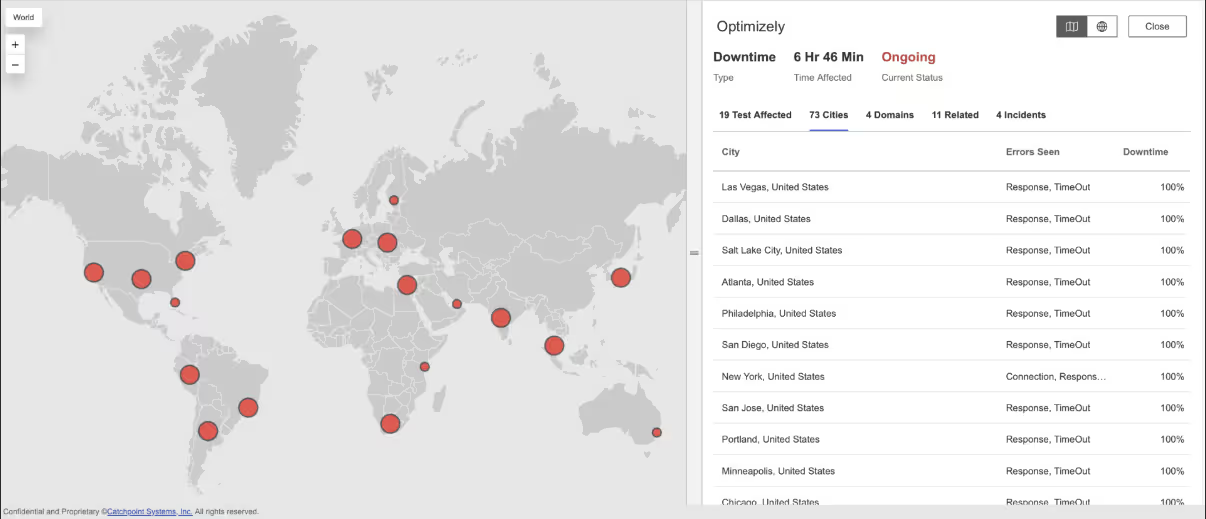

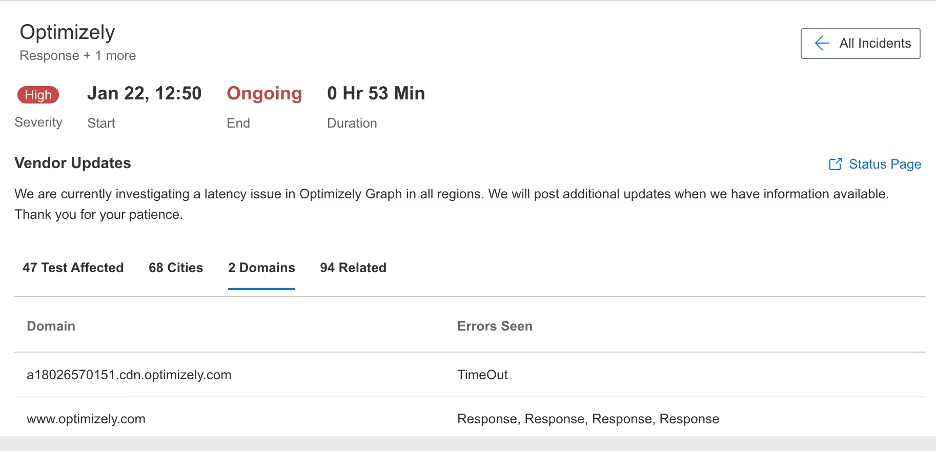

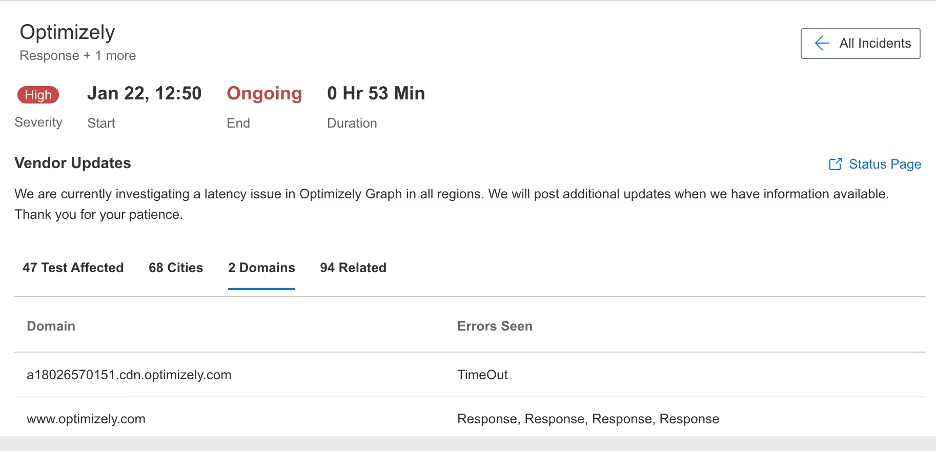

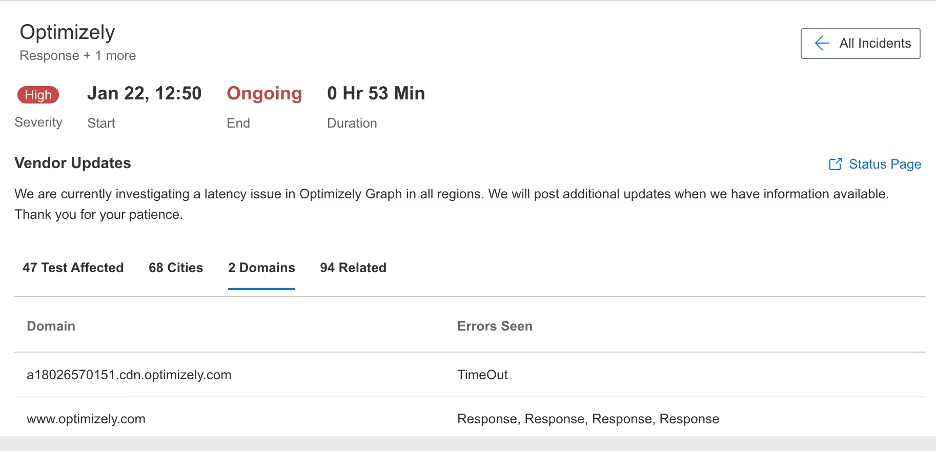

Optimizely

What Happened?

On August 5, 2025, at 4:24 AM EDT, Internet Sonar detected a global outage affecting Optimizely services. The incident impacted users across multiple regions, including Asia Pacific, Americas, Europe, Middle East, and Africa. Requests to the primary domain, www.optimizely.com, began returning HTTP 502 Bad Gateway errors, accompanied by high wait times. These issues were consistently observed from several global locations, indicating a widespread disruption in service availability.

Takeaways

This outage illustrates how upstream service failures can escalate into global availability problems, with bad gateway errors signaling breakdowns in communication between edge servers and core application infrastructure. The concurrent observation of high wait times suggests that backend systems were not only failing but also struggling to respond under load. For digital experience platforms like Optimizely, which customers depend on for real-time content delivery and experimentation, even short-lived disruptions can interrupt critical business operations worldwide.

To mitigate risks of this scale, organizations should implement multi-region redundancy, strengthen gateway failover mechanisms, and proactively test performance under load to identify bottlenecks before they result in systemic outages.

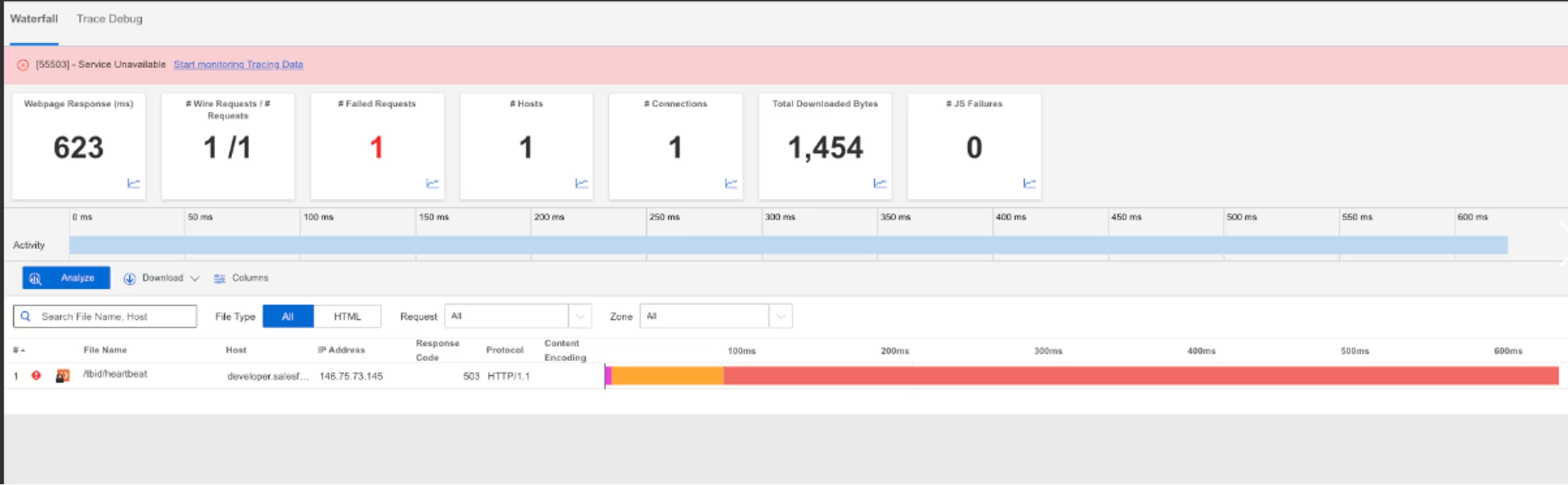

ServiceNow

.avif)

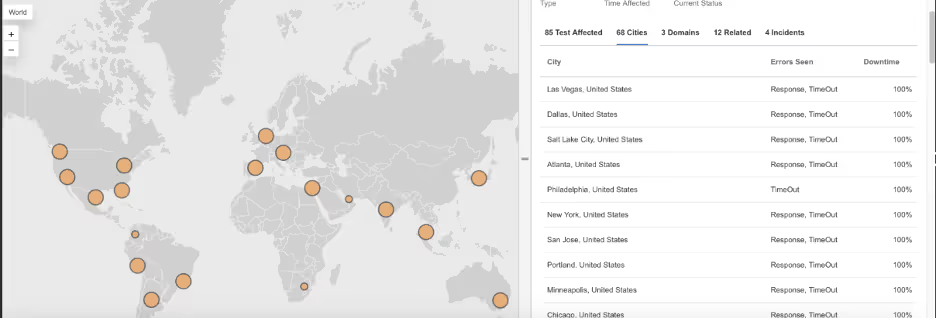

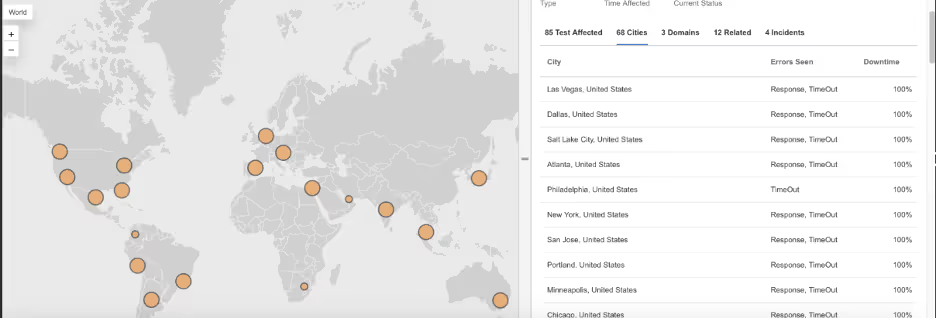

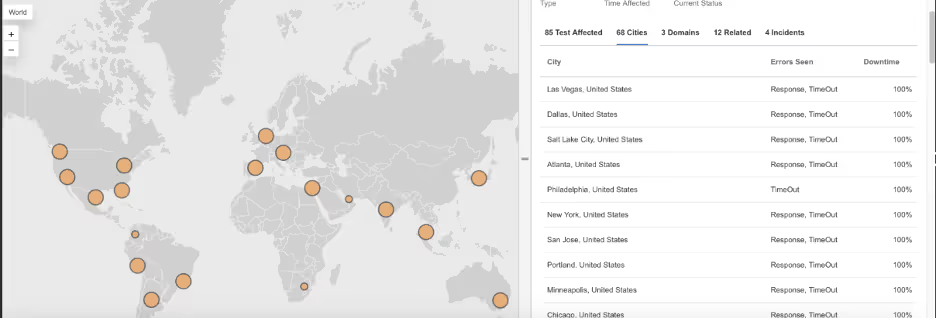

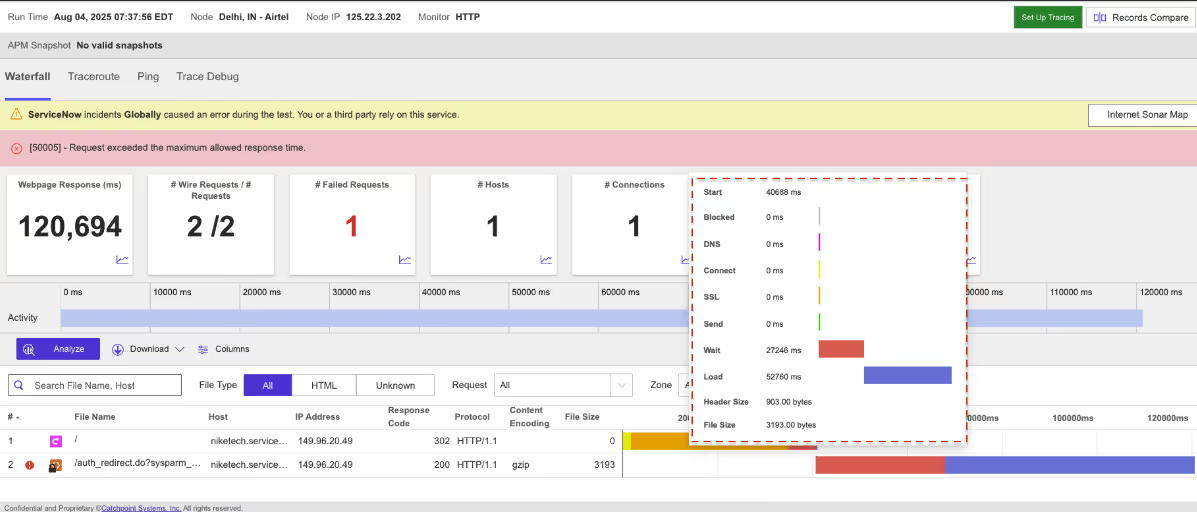

What Happened?

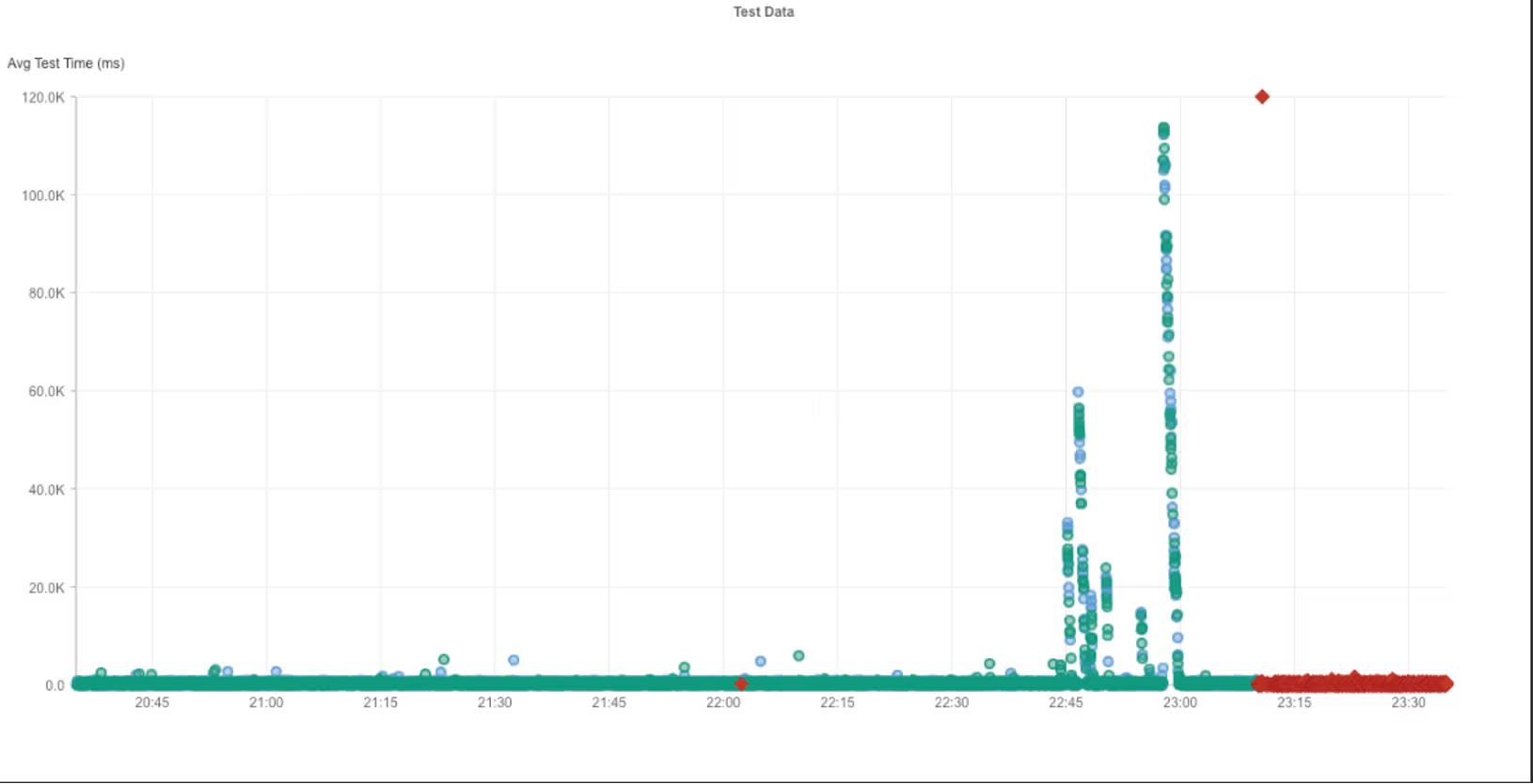

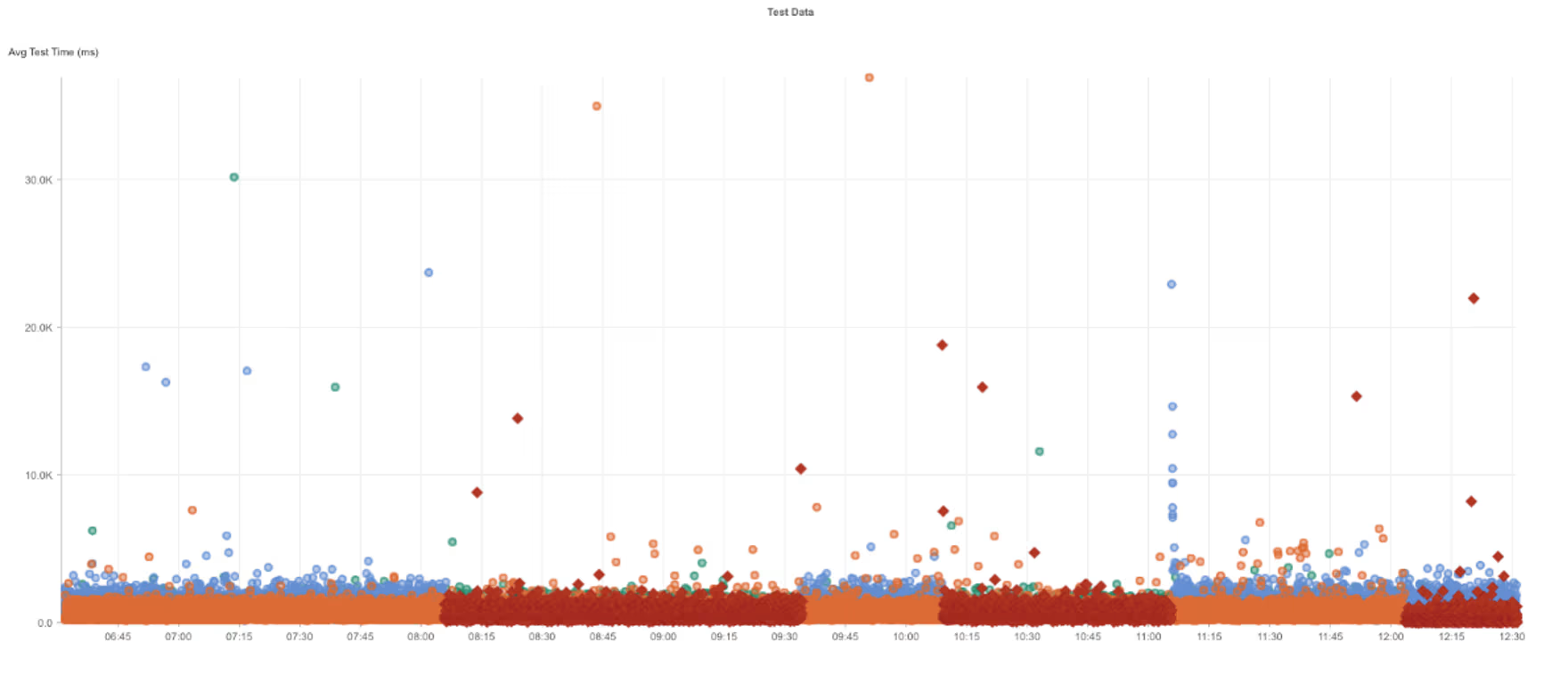

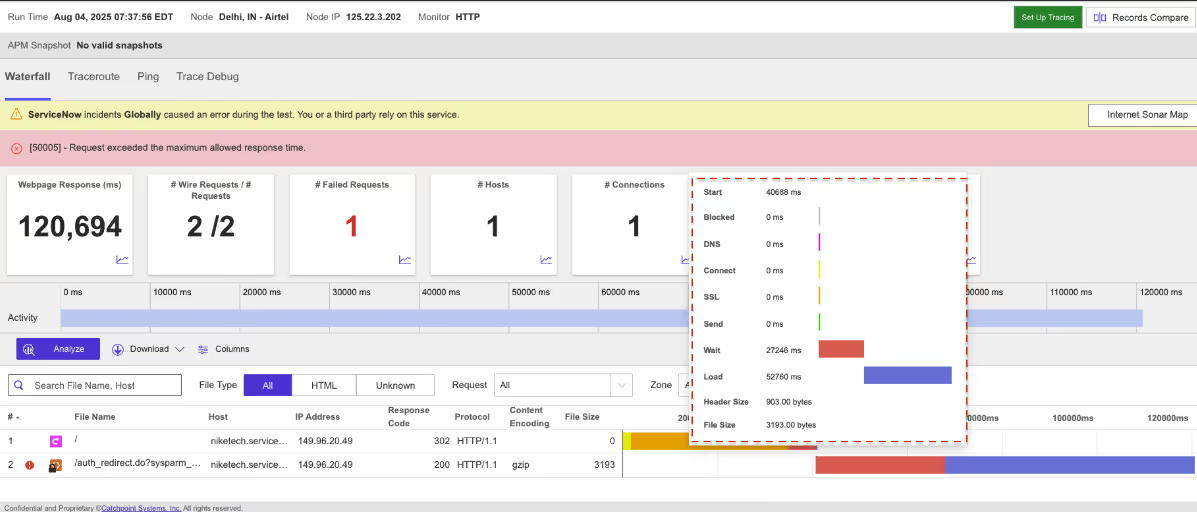

On August 4, 2025, between 7:35 AM and 8:00 AM EDT, Internet Sonar detected an outage affecting ServiceNow services across multiple regions. The disruption was linked to high load conditions, which led to increased connection times and widespread connection failures for requests directed at ServiceNow.

Takeaways

Short-lived but multi-region outages caused by high load can have outsized effects, especially for enterprise platforms like ServiceNow that underpin critical workflows. Even a 25-minute disruption can cascade into missed service tickets, delayed automations, and user frustration. This incident highlights the importance of proactive capacity planning, load balancing across regions, and early detection of rising connect times—not just outright failures. Monitoring for these early warning signs enables faster intervention before performance degradation escalates into visible outages

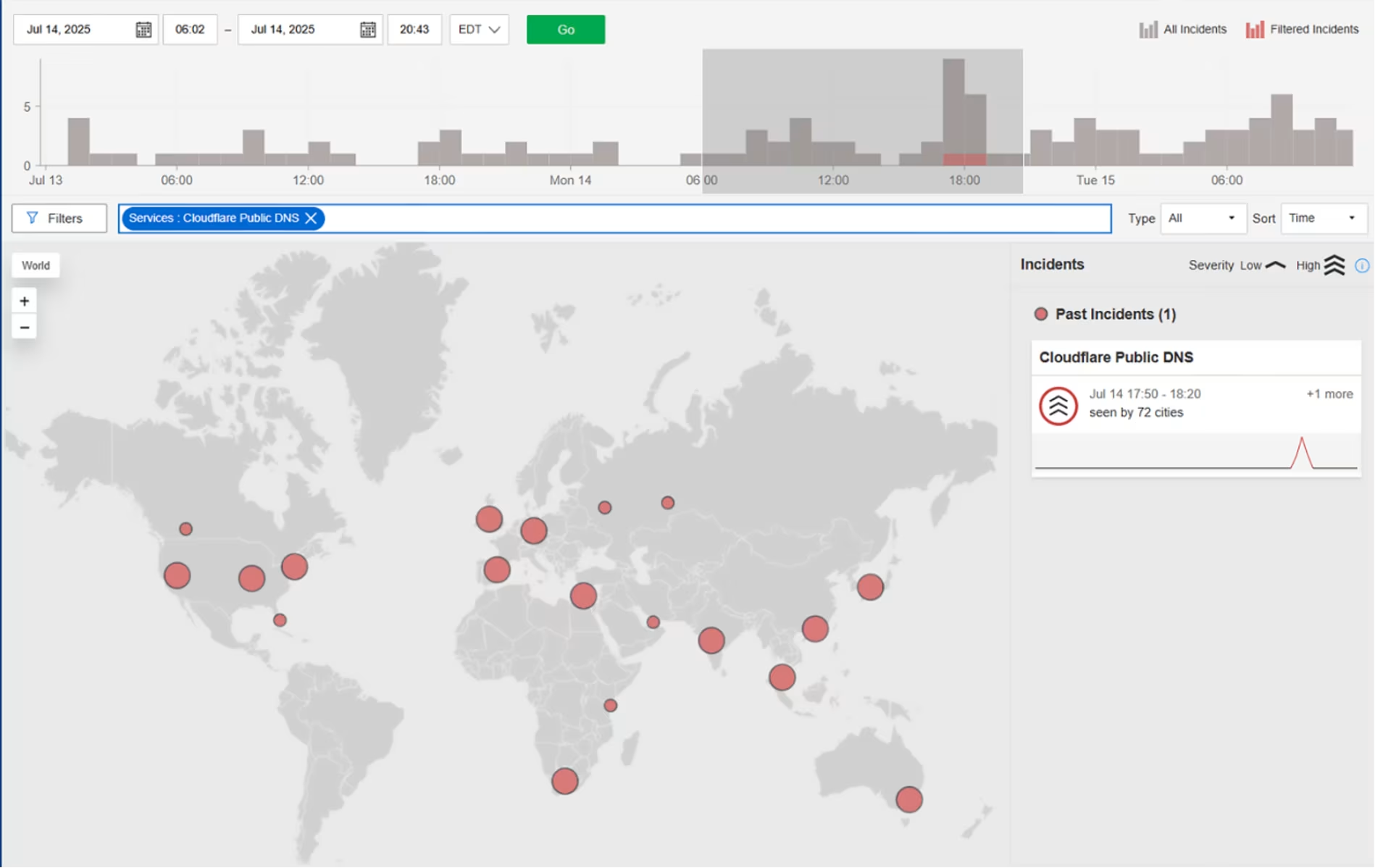

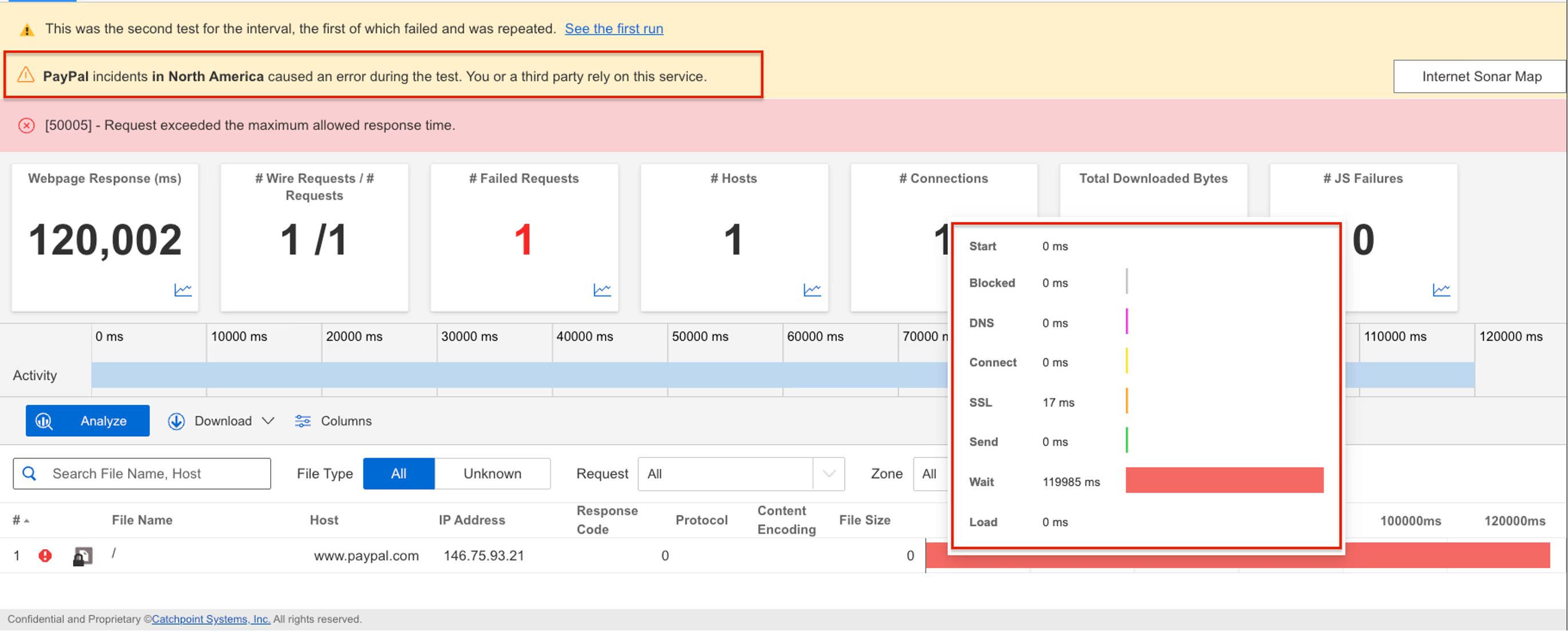

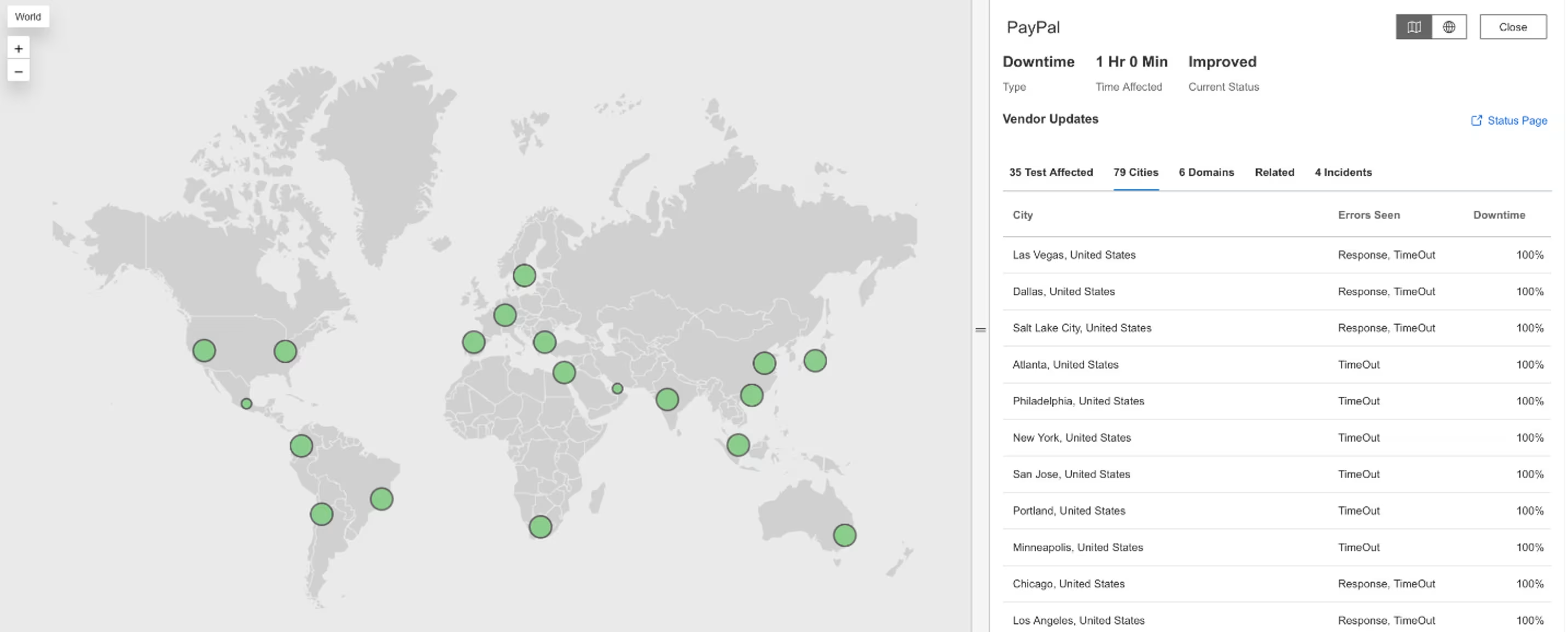

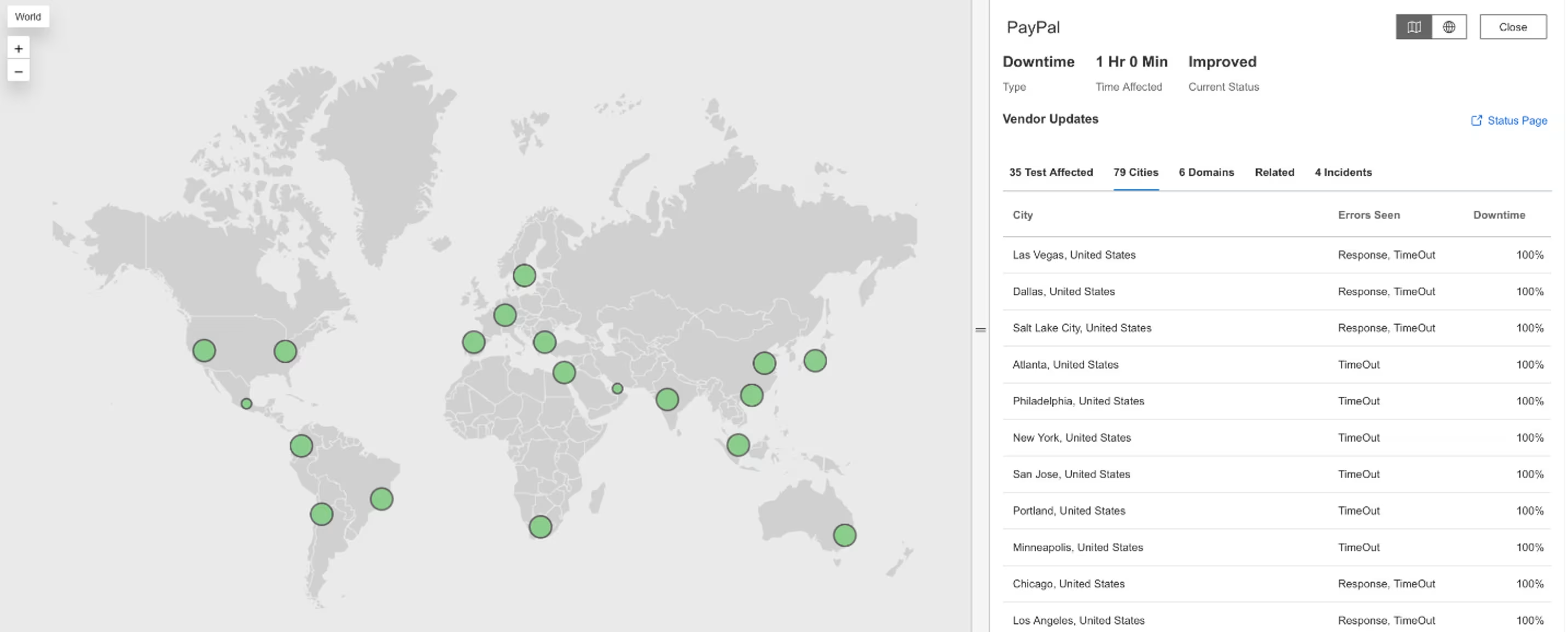

PayPal

.avif)

.avif)

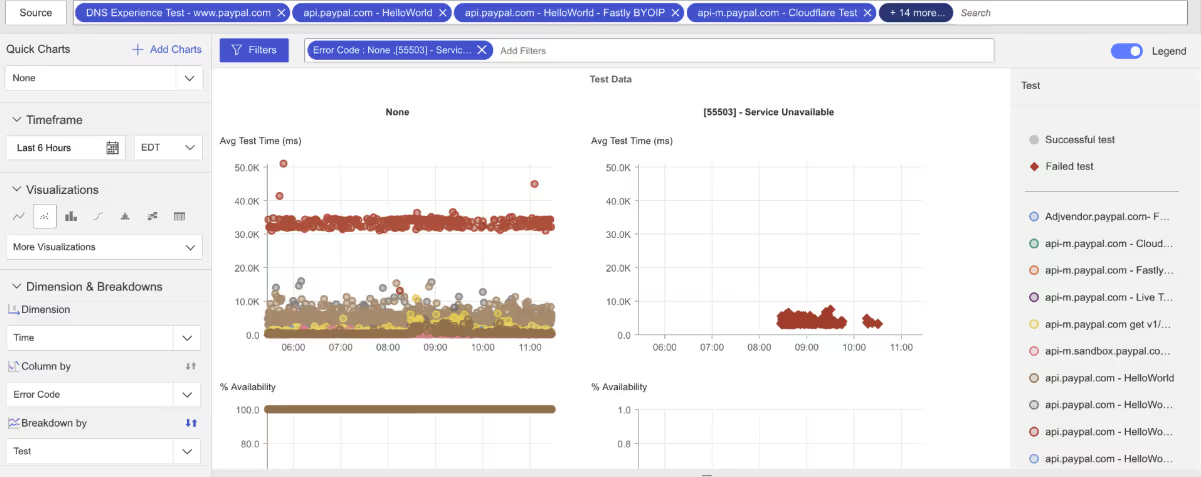

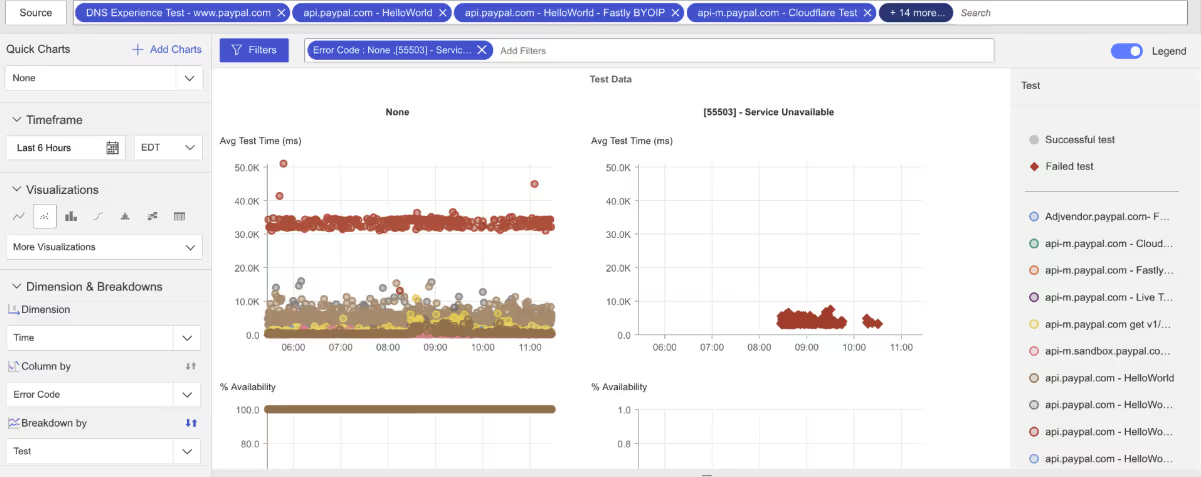

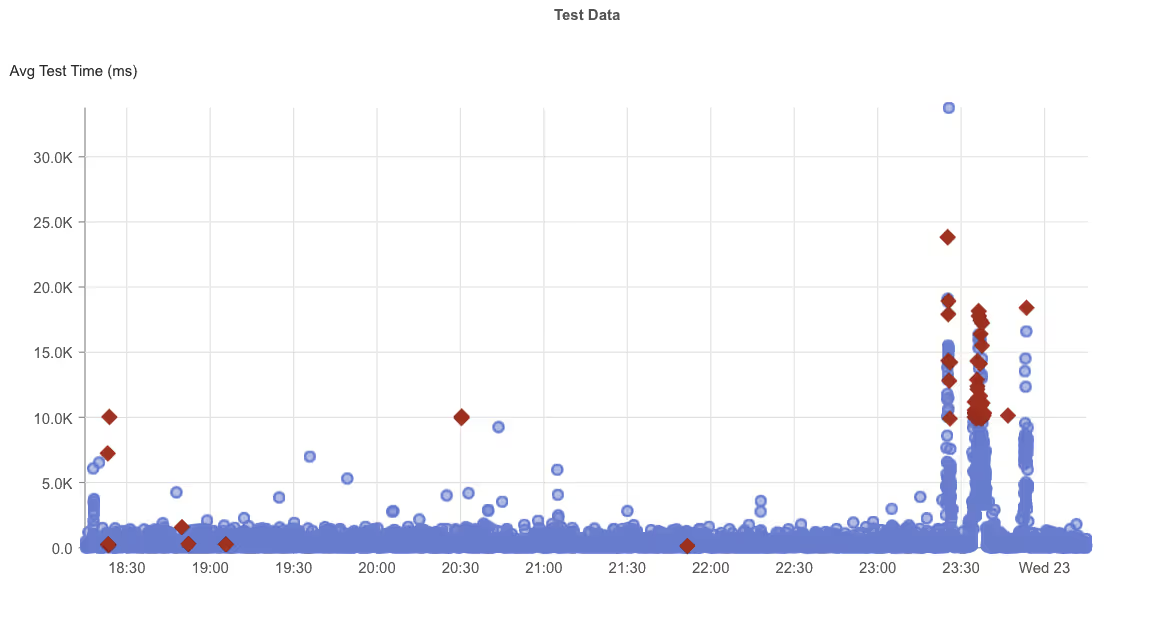

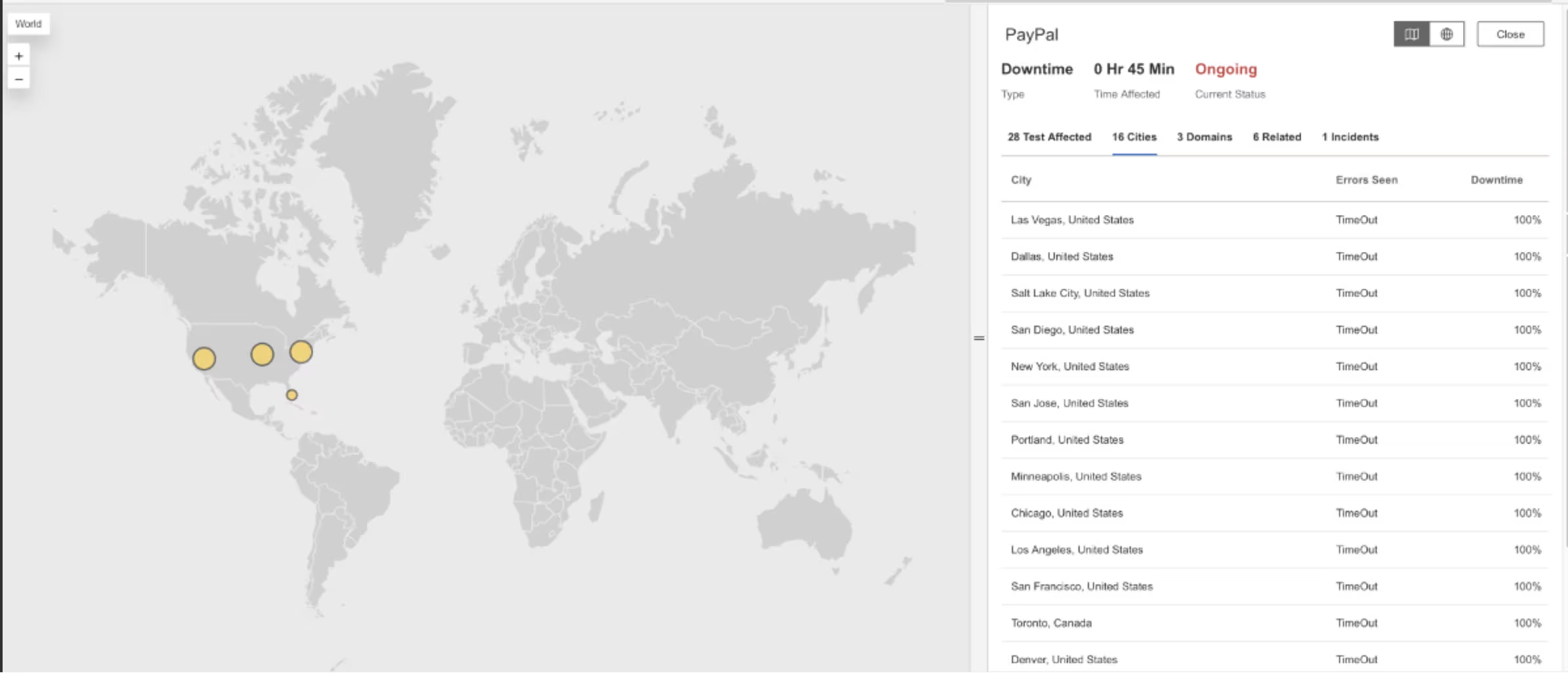

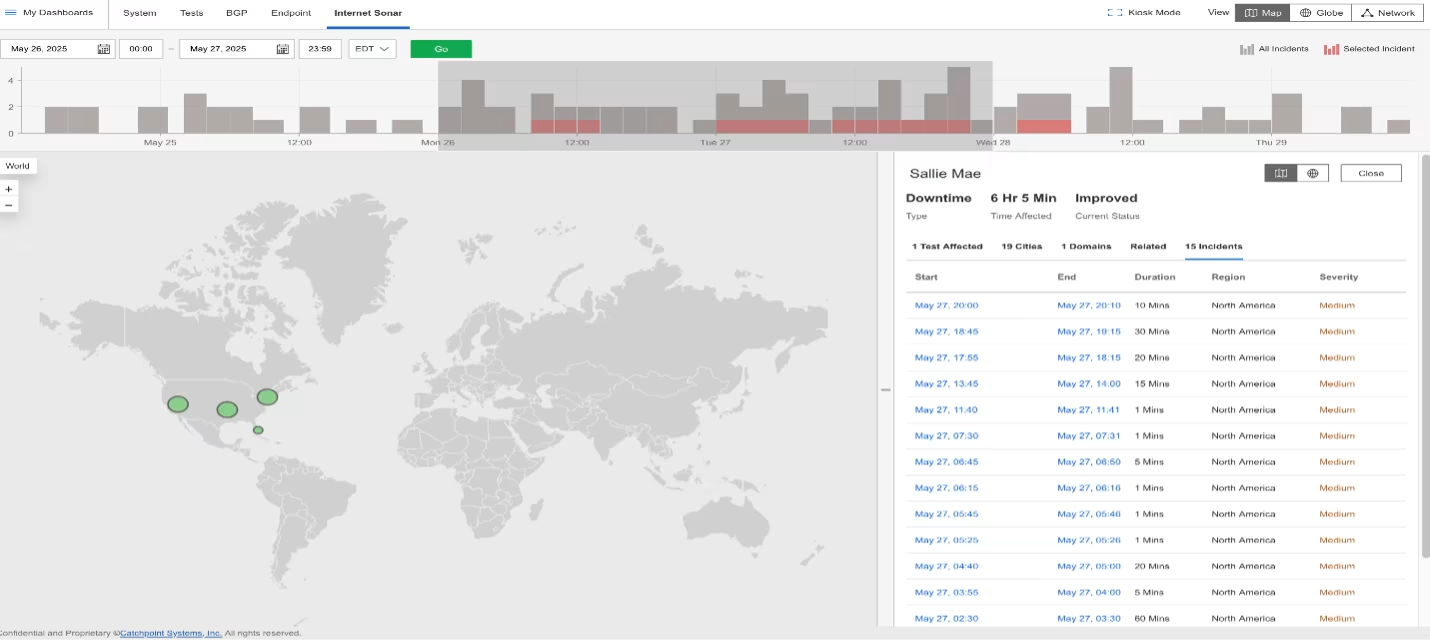

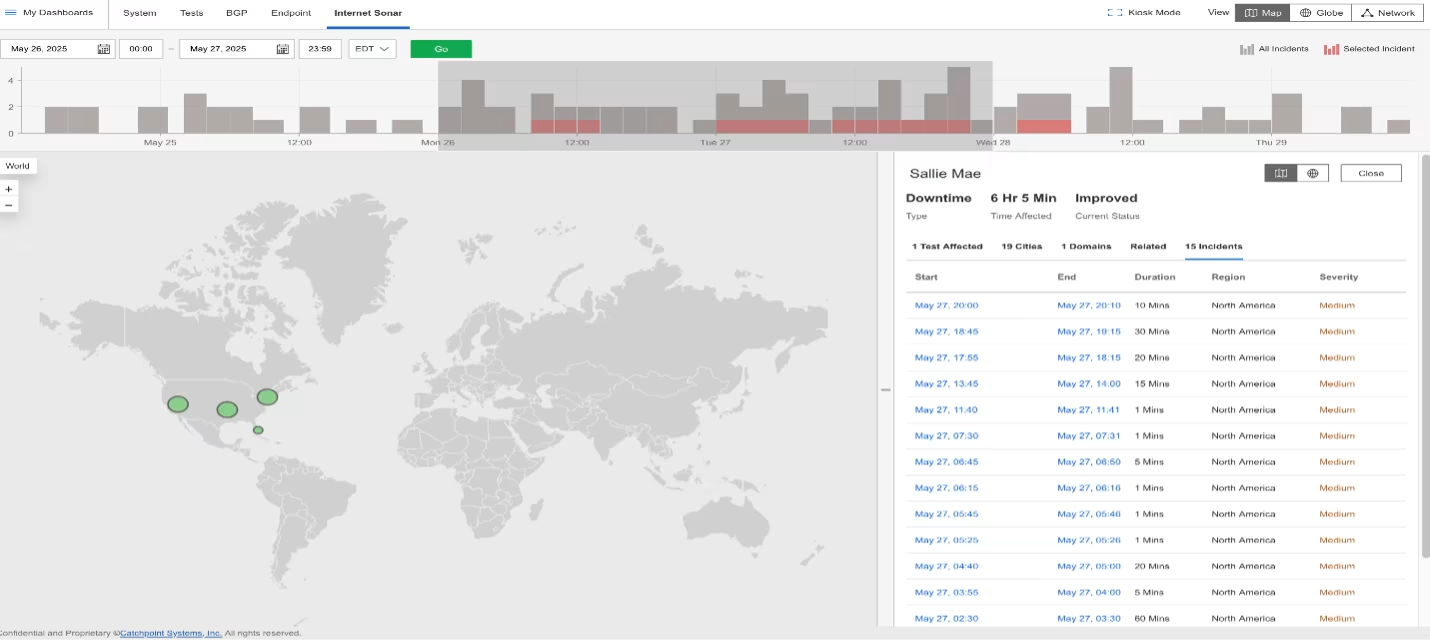

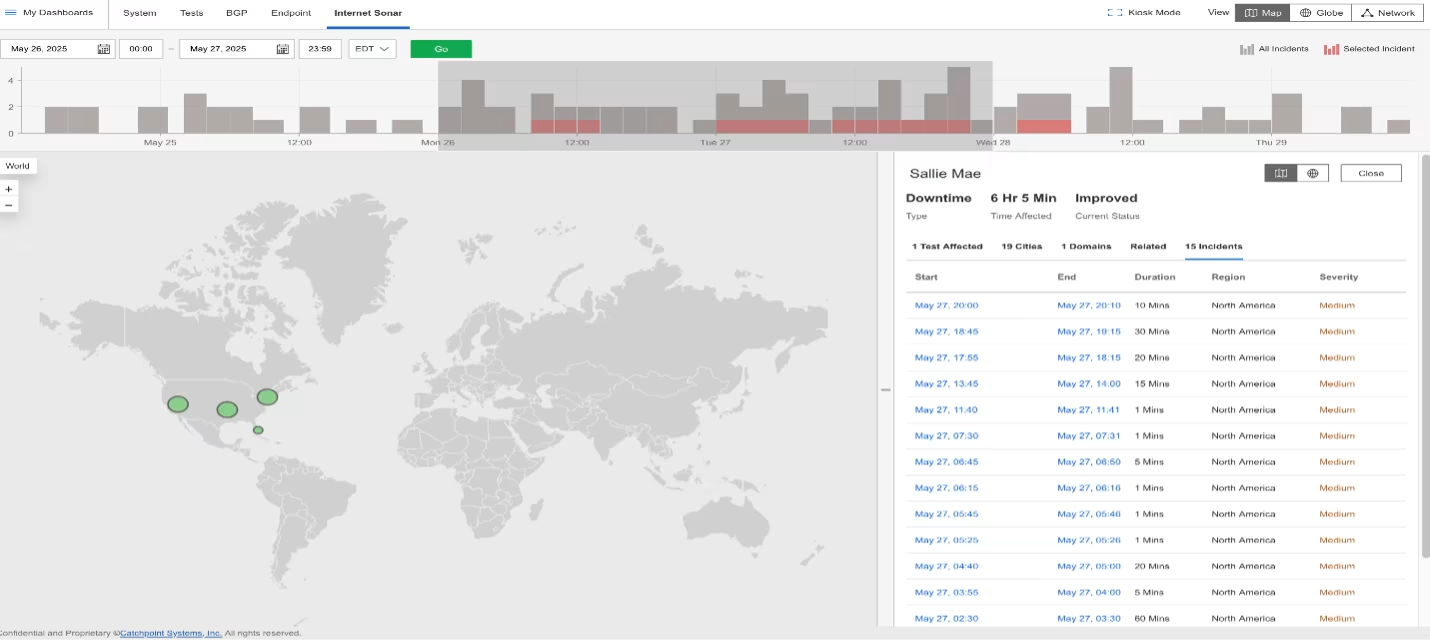

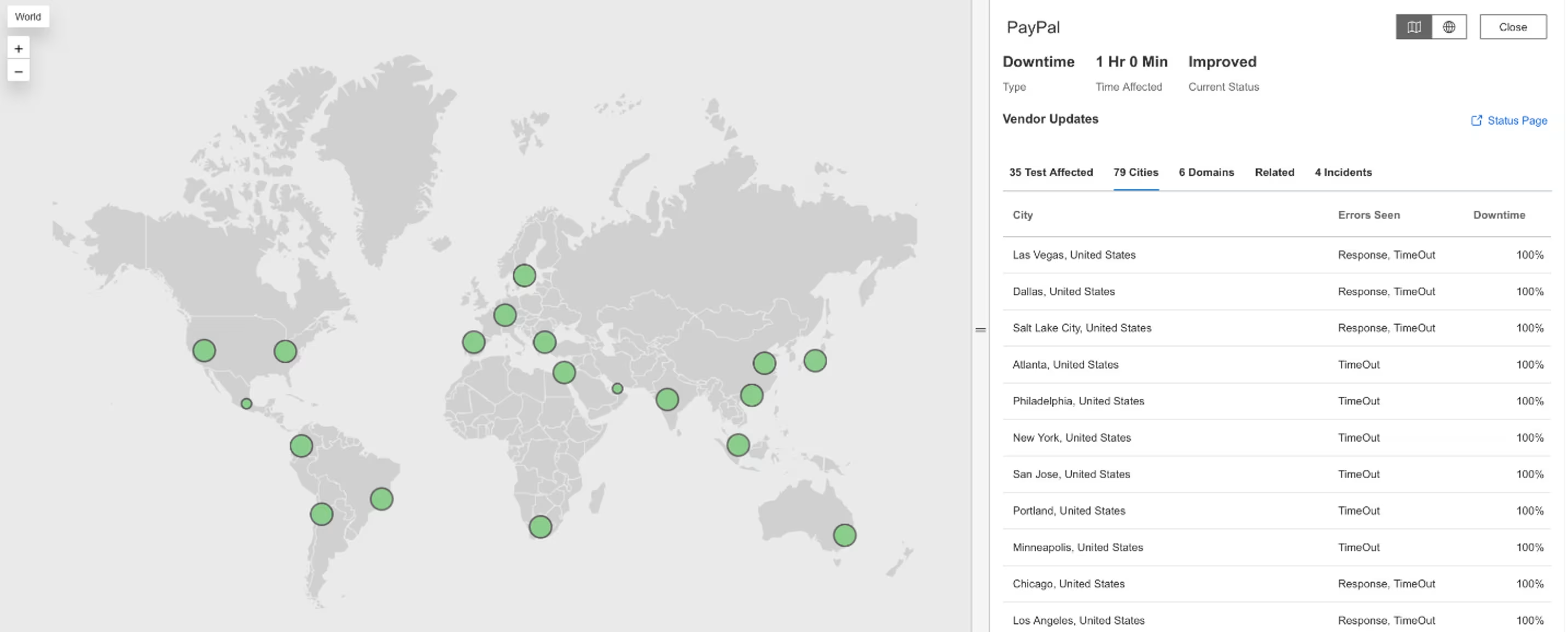

What Happened?

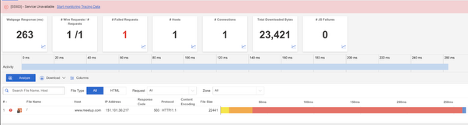

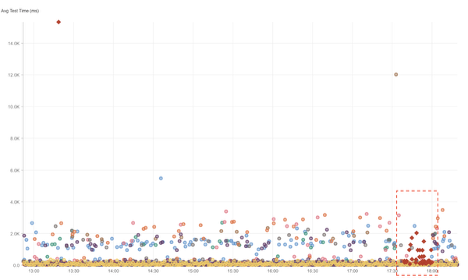

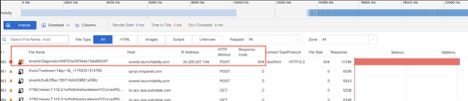

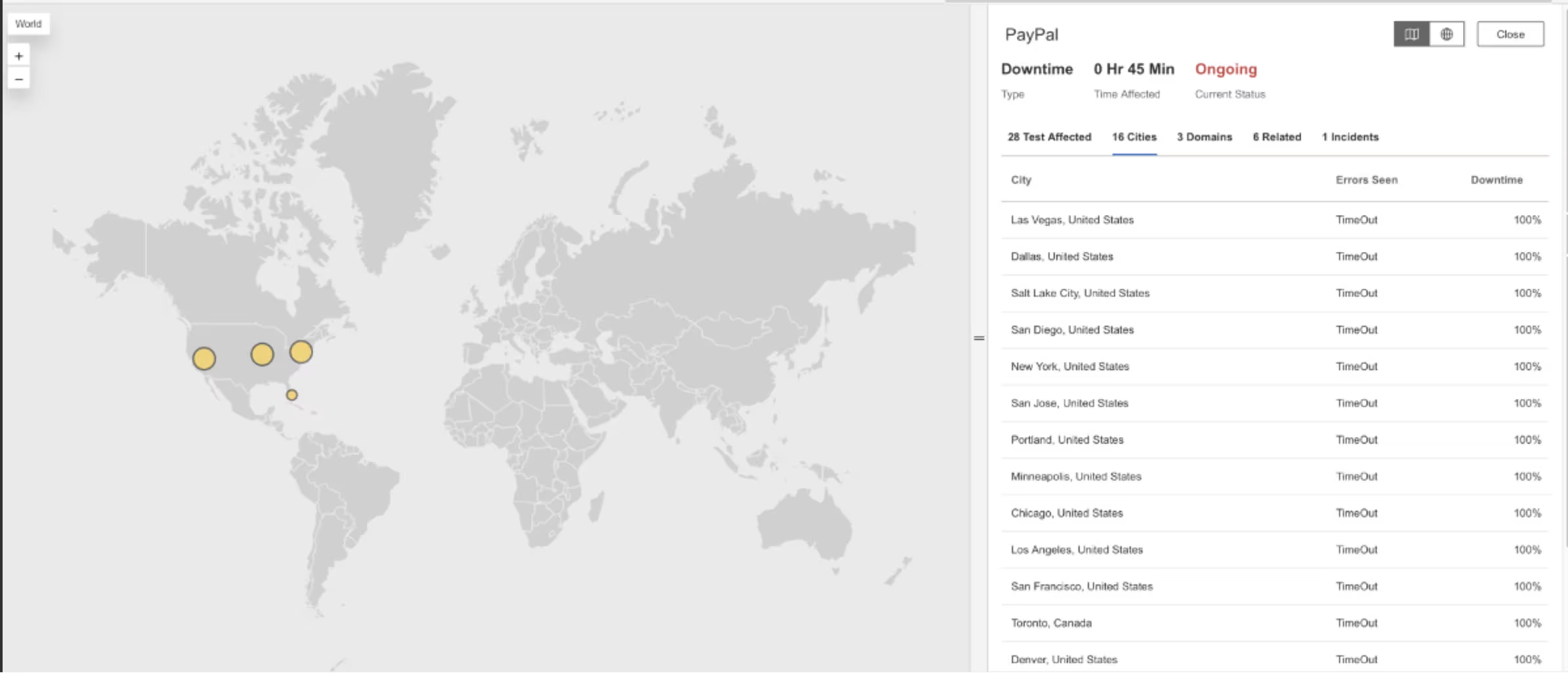

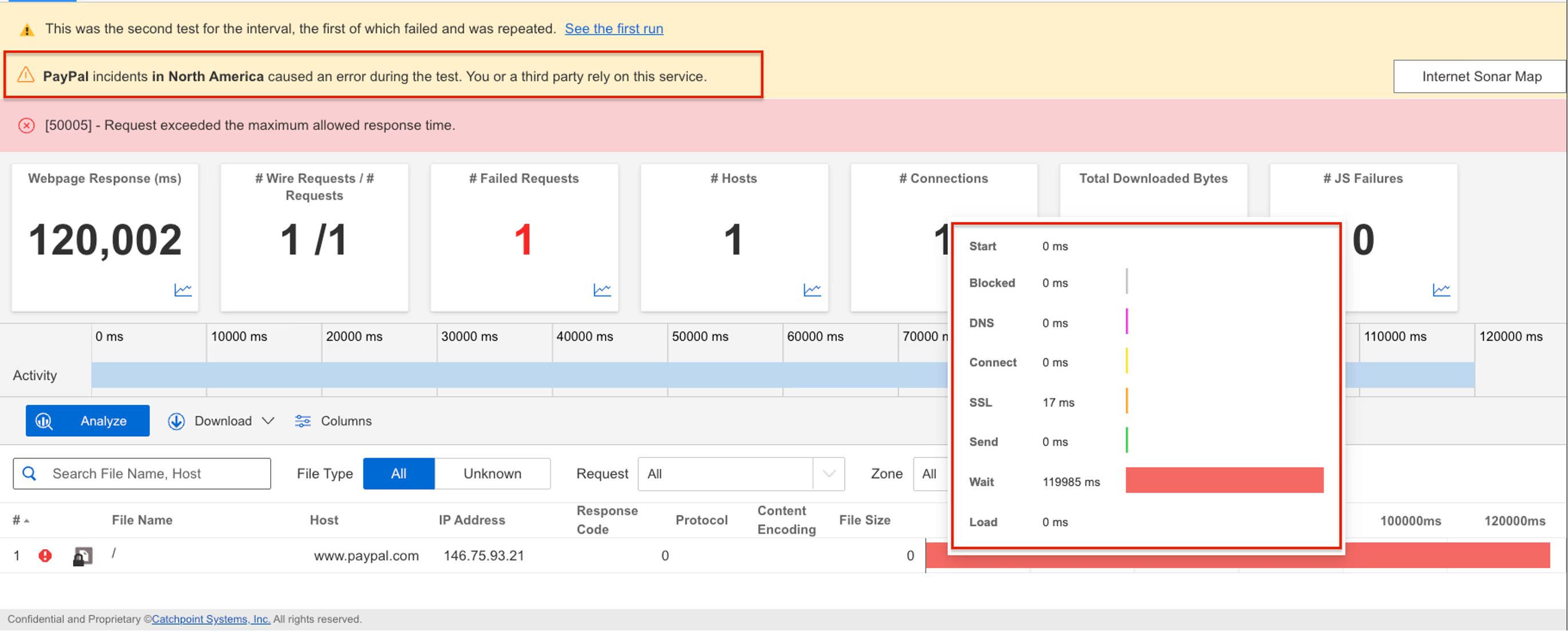

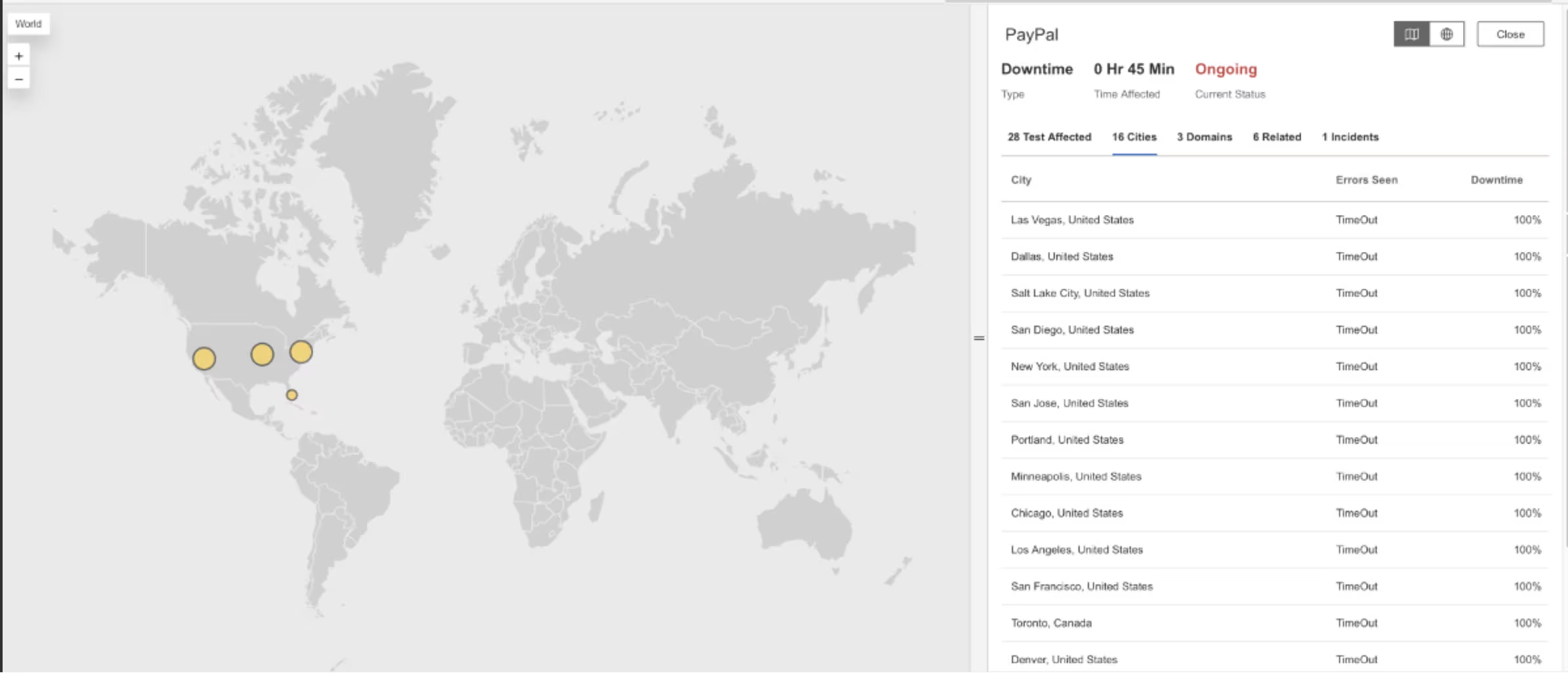

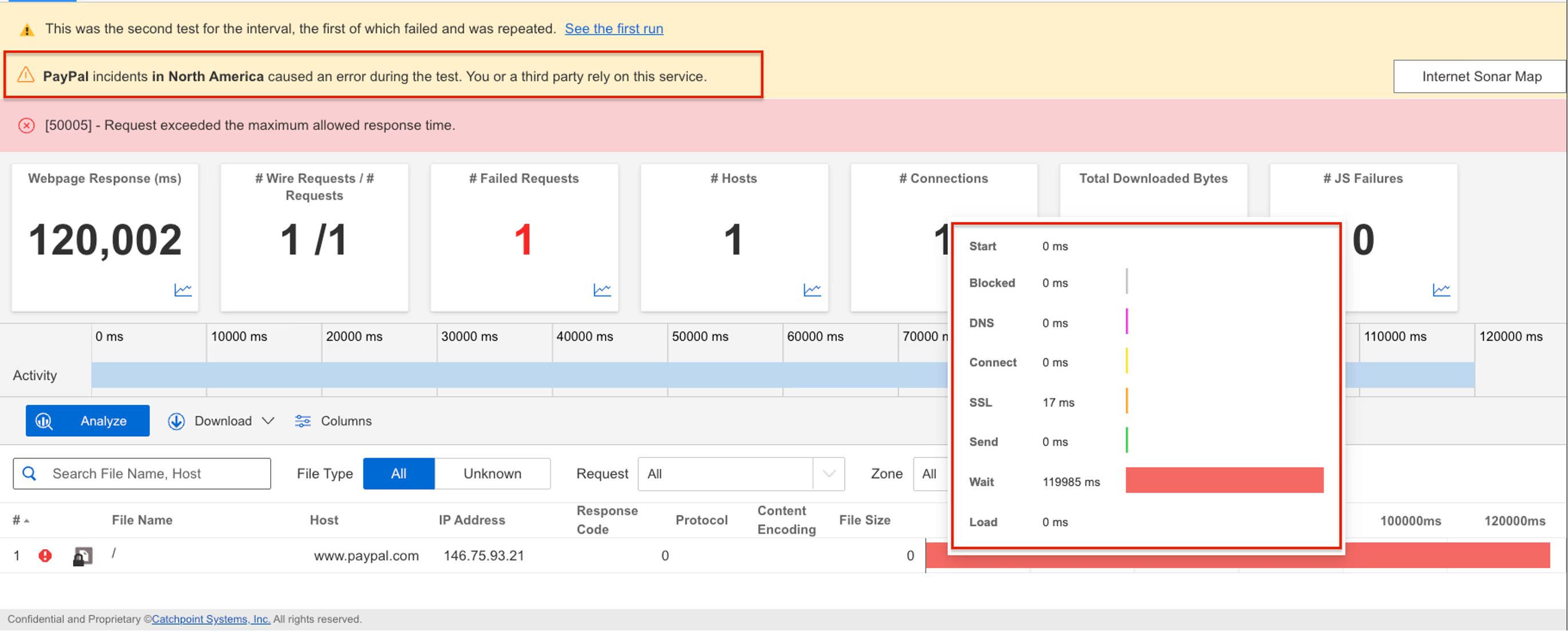

On August 1, 2025, from 8:25 AM to 9:45 AM EDT, Internet Sonar detected a global outage impacting PayPal services across multiple regions. Beginning at 8:27 AM EDT, requests to the domains api.paypal.com and paypal.com returned HTTP 503 Service Unavailable errors from several locations, indicating widespread service disruption.

.avif)

Takeaways

When a global payments platform like PayPal experiences 503 errors, even for a little over an hour, the impact can ripple across e-commerce, retail checkouts, and peer-to-peer transactions. For financial services, availability is as critical as security—every failed request represents lost revenue and customer trust. This outage underscores the need for redundant payment routes, automated failover strategies, and real-time monitoring that distinguishes between localized slowdowns and systemic backend failures. Proactive mitigation can keep essential transaction flows running, even during upstream service instability

July

Bluecore

.avif)

.avif)

What Happened?

On July 22, 2025, at 11:25 PM EDT, Internet Sonar detected an outage affecting Bluecore services across multiple regions. The incident impacted users in the Asia Pacific, Europe, Middle East and Africa, and America. Requests to the domain www.bluecore.com returned HTTP 500 Internal Server Error responses from several locations, indicating a server-side failure and resulting in service disruption.

.avif)

Takeaways

HTTP 500 errors point to underlying server-side issues that can quickly ripple across regions when left unmitigated. For platforms like Bluecore, which power customer engagement and marketing operations, even short outages can delay campaigns and reduce user trust. This incident highlights the importance of resilient backend architectures, failover-ready application tiers, and proactive monitoring that can spot and isolate server-side breakdowns before they cascade globally. Fast detection and escalation are essential to minimize downtime and protect customer-facing operations.

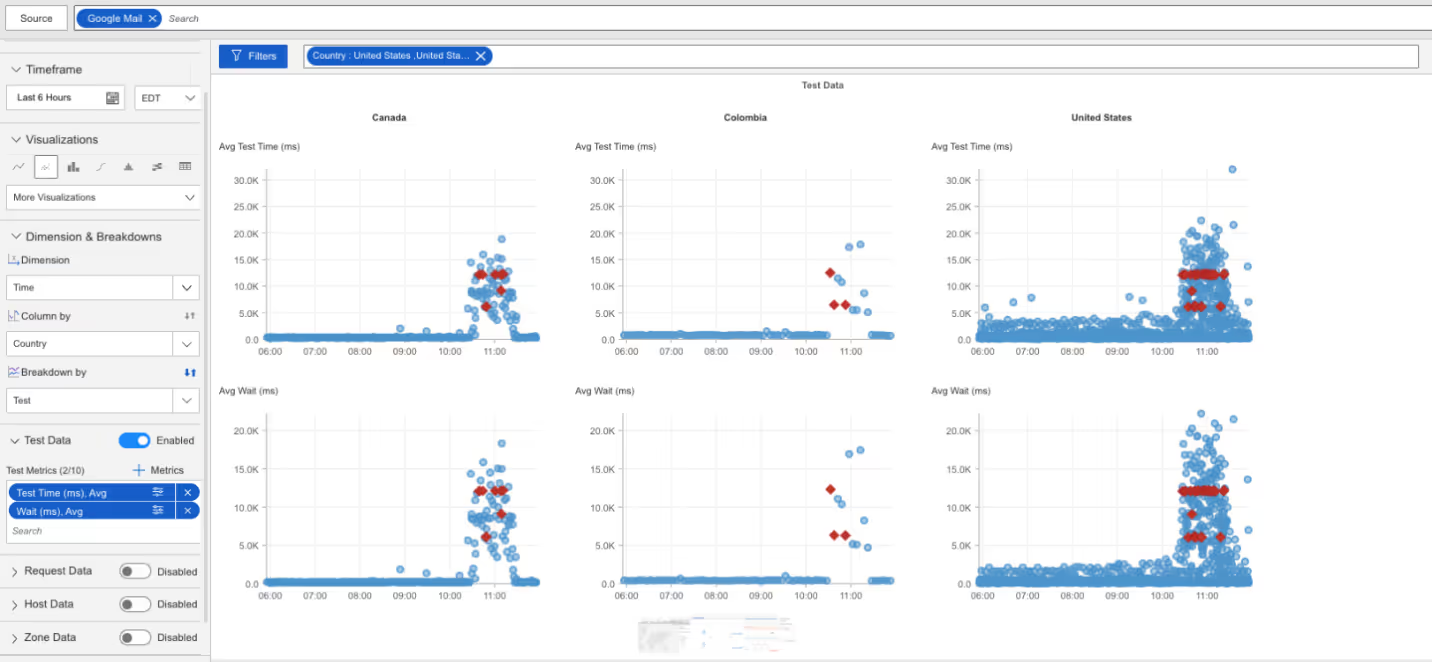

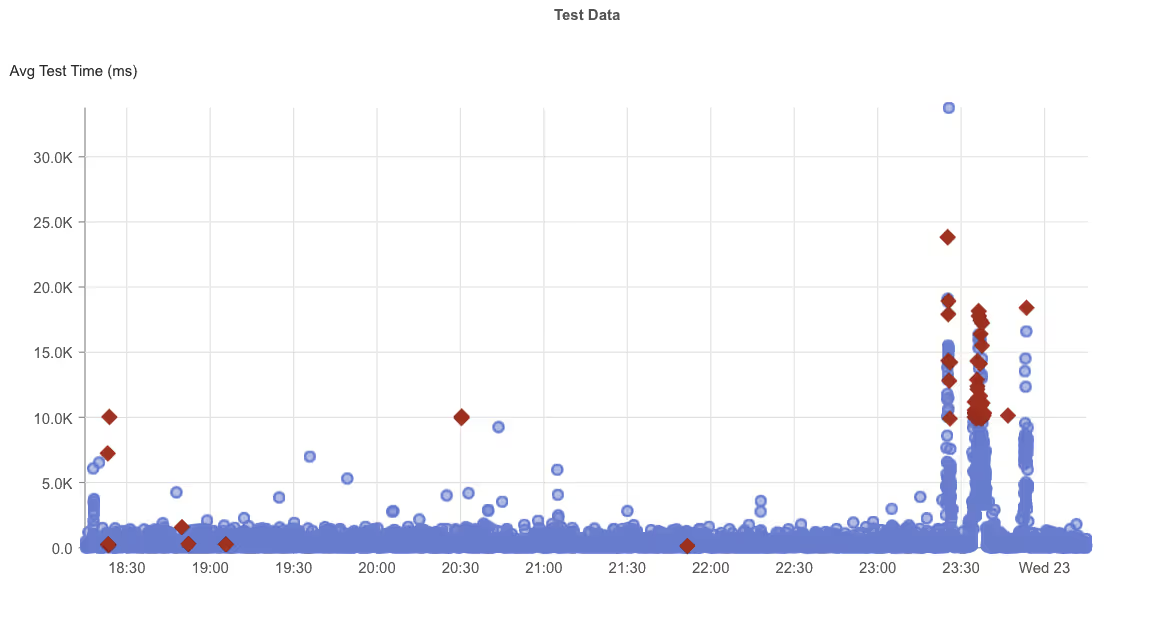

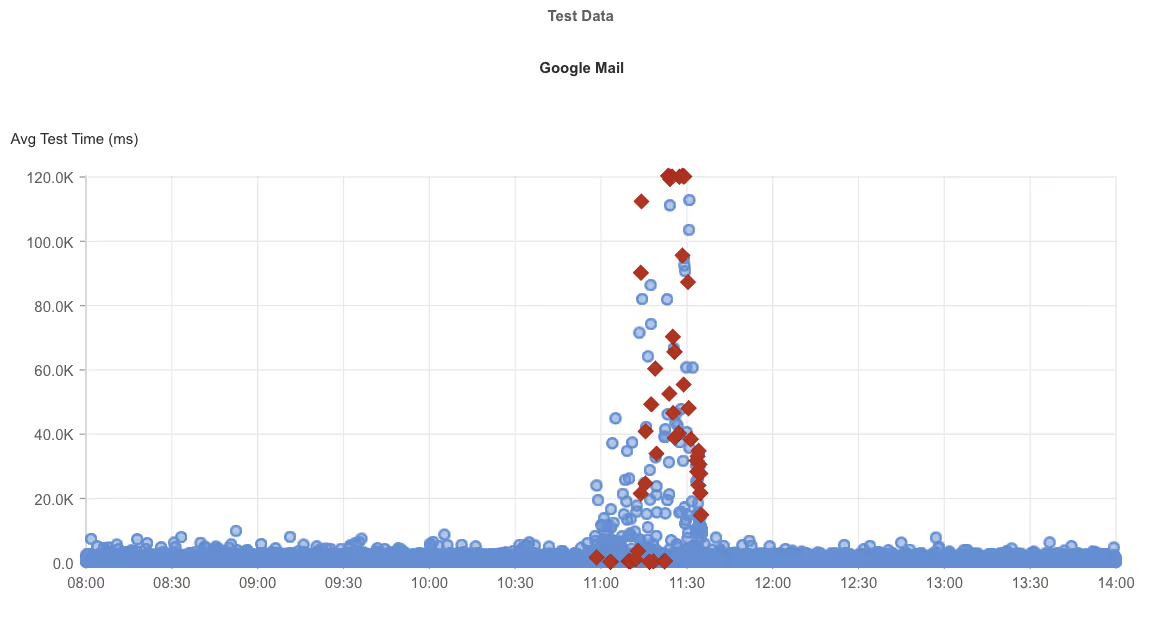

Google Mail

.avif)

.avif)

What Happened?

On July 18, 2025, from 10:58 AM to 12:01 PM EDT, Internet Sonar detected an outage impacting Google Mail in the US and Canada. Requests to accounts.google.com returned HTTP 503 Service Unavailable and 535 unofficial errors, accompanied by elevated wait times. The disruption caused widespread service instability, leaving users unable to reliably access Google Mail.

.avif)

Takeaways

Mixed error codes like 503 and unofficial 535s, combined with long connection times, suggest backend strain that outpaced available capacity. For productivity-critical platforms like Google Mail, even a little over an hour of downtime can stall business operations and personal communications. This incident reinforces the need for granular monitoring of both error diversity and latency trends. Proactive throttling, load balancing, and regional failover strategies are key to preventing high-volume demand spikes from cascading into widespread mail disruptions.

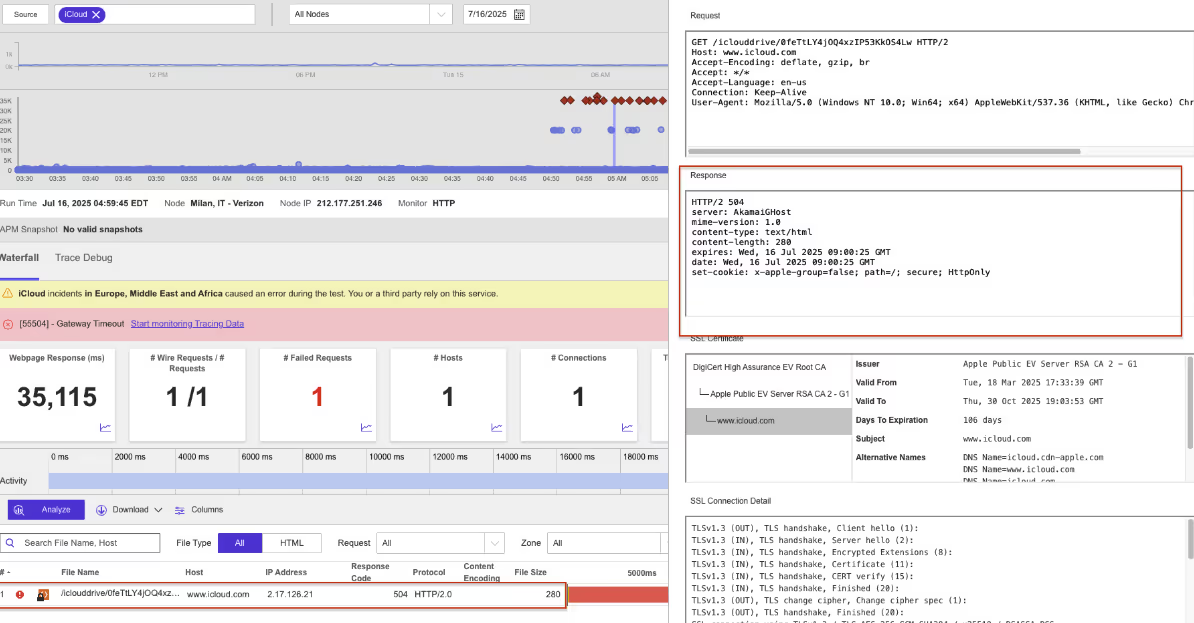

iCloud

.avif)

.avif)

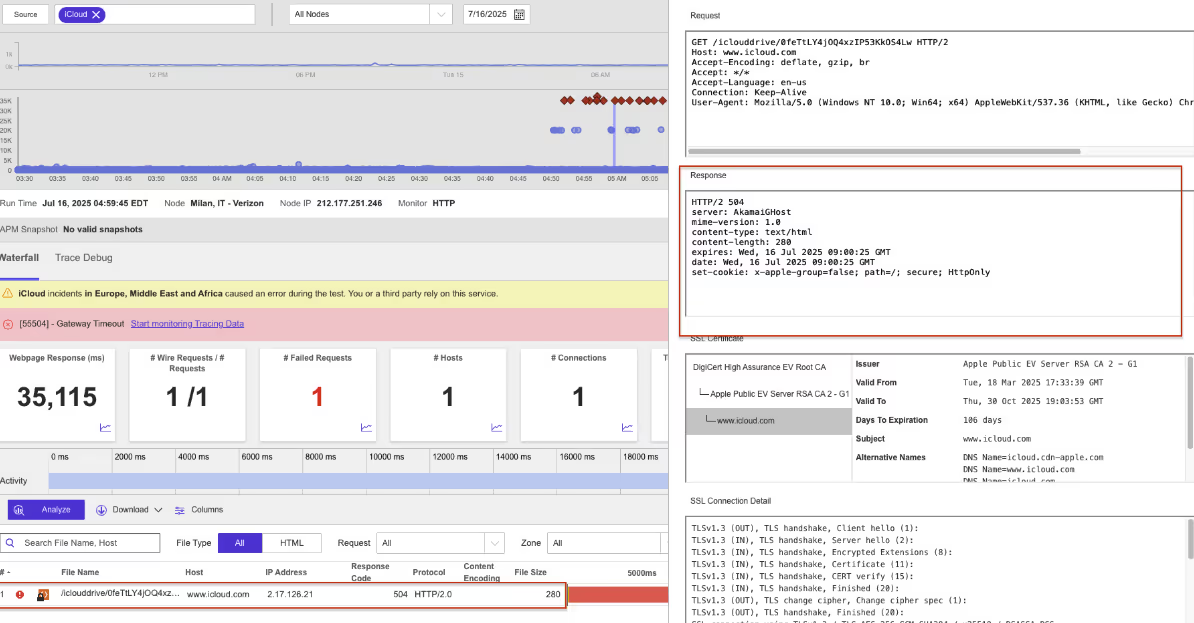

What Happened?

On July 16, 2025, from 04:52 AM to 06:21 AM EDT, Internet Sonar detected a regional outage affecting iCloud services. The incident impacted users in Colombia, France, and Italy. Requests to the domain www.icloud.com returned HTTP 504 Gateway Timeout and 503 Service Unavailable errors during this period, indicating service instability.

.avif)

Takeaways

A mix of 504 Gateway Timeout and 503 Service Unavailable errors points to backend overload compounded by upstream connectivity issues. For cloud storage and synchronization platforms like iCloud, regional outages can leave users locked out of files, backups, and device sync operations—critical daily workflows. This incident highlights the importance of regional redundancy, proactive capacity safeguards, and automated failover to keep essential services resilient. Continuous monitoring for timeout trends, not just outright failures, can help detect early warning signs before full service loss.

Optimizely

.avif)

.avif)

What Happened?

On July 15, 2025, at 7:20 PM EDT, Internet Sonar detected a global outage affecting Optimizely services. The incident impacted users across Asia Pacific, Europe, Middle East and Africa, and the Americas. Requests to the primary domain, www.optimizely.com, returned a mix of error responses, including HTTP 502 Bad Gateway, 503 Service Unavailable, and unofficial status codes such as 524, 525, and 535. High wait times were also observed from multiple global locations. Manual access attempts confirmed the application was inaccessible during the outage, indicating service disruption

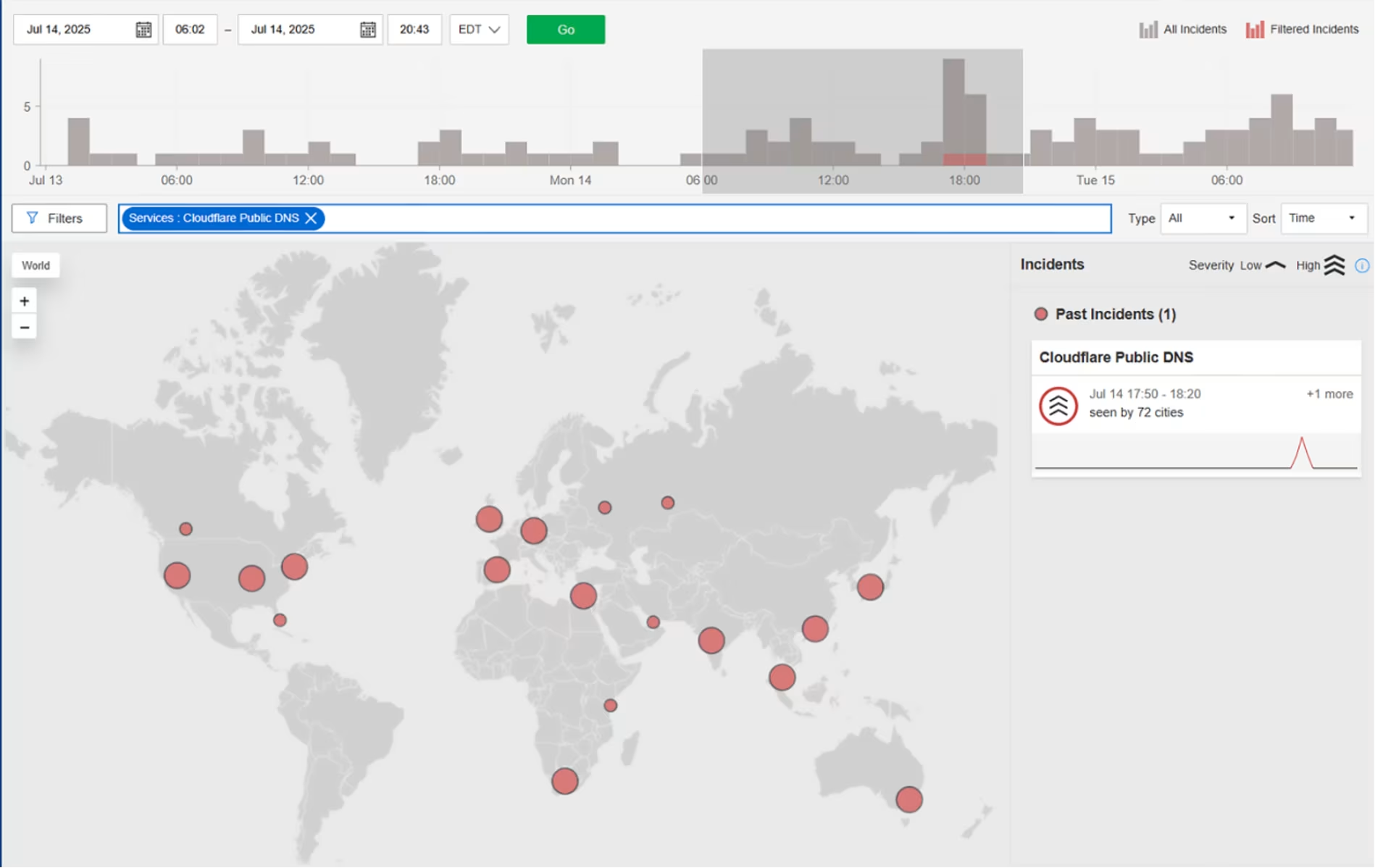

Cloudflare DNS Resolver

What Happened?

On July 15, 2025, starting at 5:50 PM EDT, Cloudflare’s 1.1.1.1 DNS resolver experienced a global outage lasting around 30 minutes. A misconfiguration in Cloudflare’s internal systems linked the resolver’s IP prefixes to a non-production service topology. When a new test location was added, it unintentionally triggered a global withdrawal of those prefixes from Cloudflare’s data centers—disrupting DNS resolution worldwide. A BGP hijack, detected around the same time, was not the cause but a separate latent issue surfaced by the route withdrawals. Service was restored after Cloudflare deployed a fix.

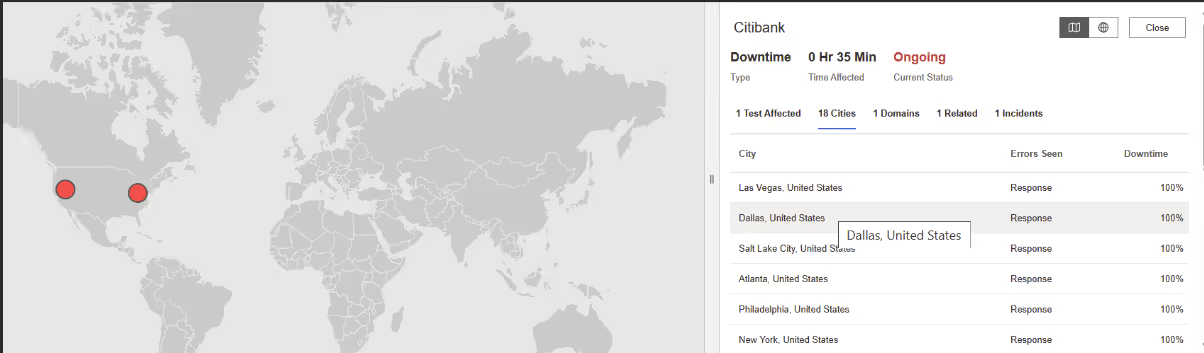

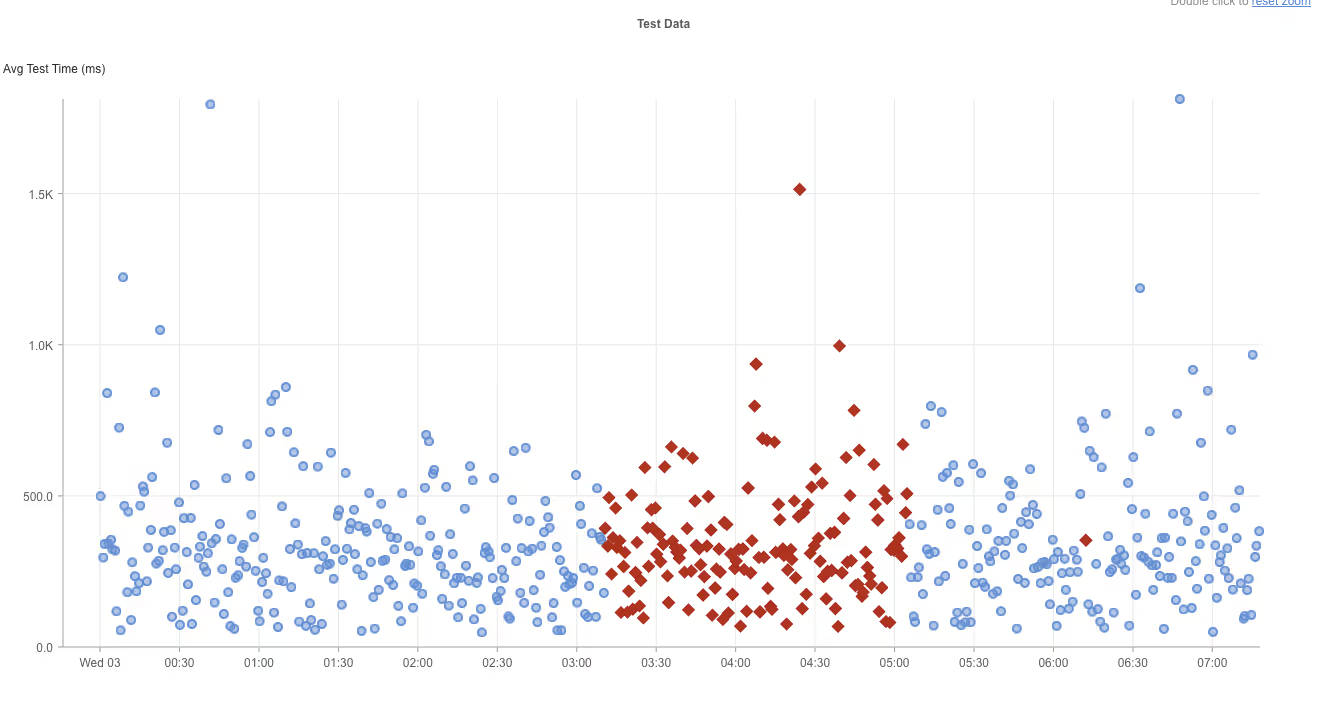

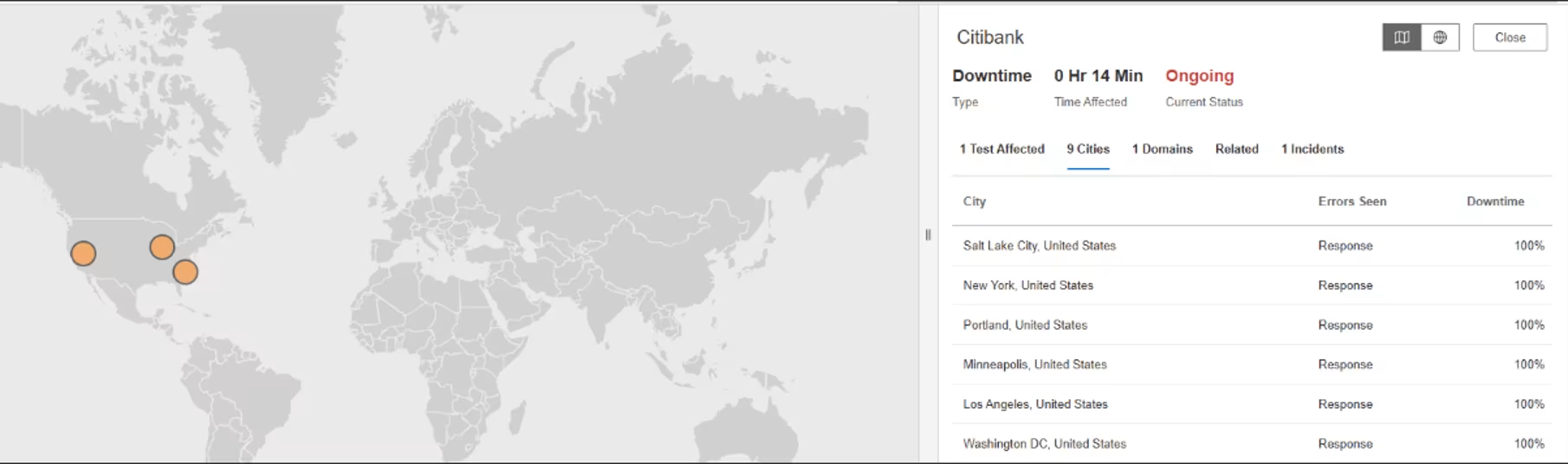

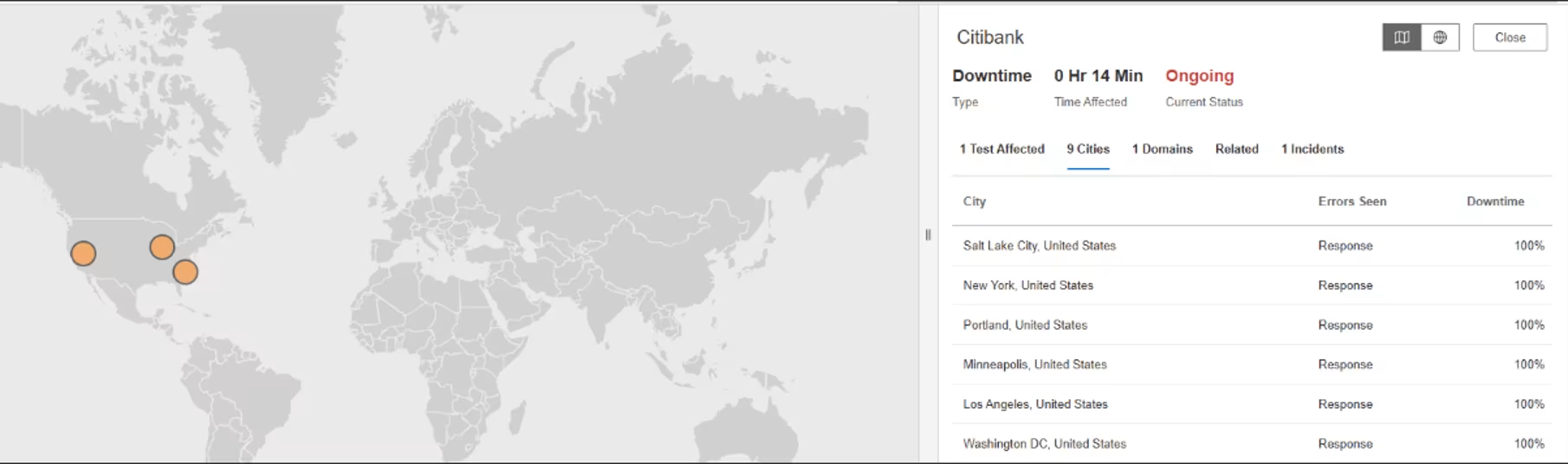

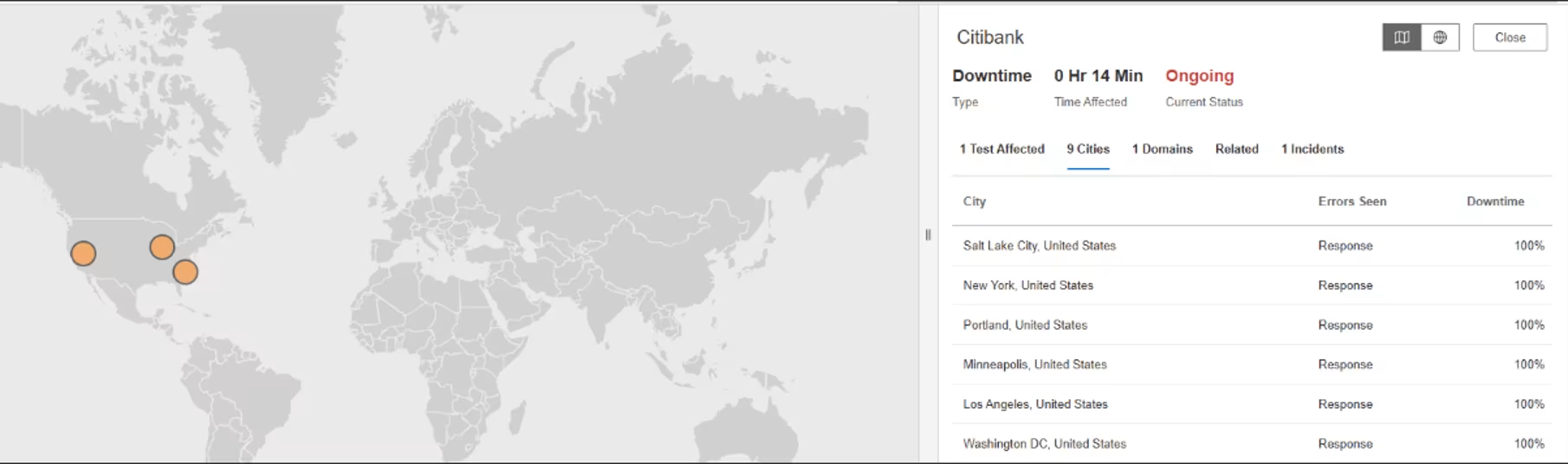

Citibank

What Happened?

On July 2, 2025, from 1:05 AM to 01:30 AM EDT, Catchpoint’s Internet Sonar detected a short but complete outage affecting Citibank services in the United States. Requests to www.citi.com returned consistent HTTP 502 Bad Gateway responses across at least nine cities, including New York, Los Angeles, Salt Lake City, and Washington D.C. The 25-minute disruption resulted in full downtime across all monitored locations, indicating a likely configuration or gateway-level failure that was quickly mitigated.

Takeaways

Short-lived but high-visibility outages like this can still erode user confidence. A 25-minute incident may sound brief, but for a banking platform, every minute of downtime can trigger customer complaints or failed transactions. This case highlights the importance of real-time alerting, fast root cause identification, and clear post-incident communication to maintain trust during service disruptions.

June

PayPal

What Happened?

On Jun 24, 2025, 0:02 AM EDT to Jun 24, 2025, 0:21 AM EDT, Internet Sonar detected an outage affecting PayPal services across multiple regions in North America. Requests to www.paypal.com showed unusually high wait times, indicating degraded performance and potential delays in service, application processing, or page loads.

Takeaways

Degraded performance—rather than a full outage—can be harder to detect and more frustrating for users. Elevated wait times without total failure suggest capacity bottlenecks or backend queuing issues. Monitoring for slowdowns is just as important as watching for outright errors, especially for high-volume platforms handling financial transactions.

Ometria

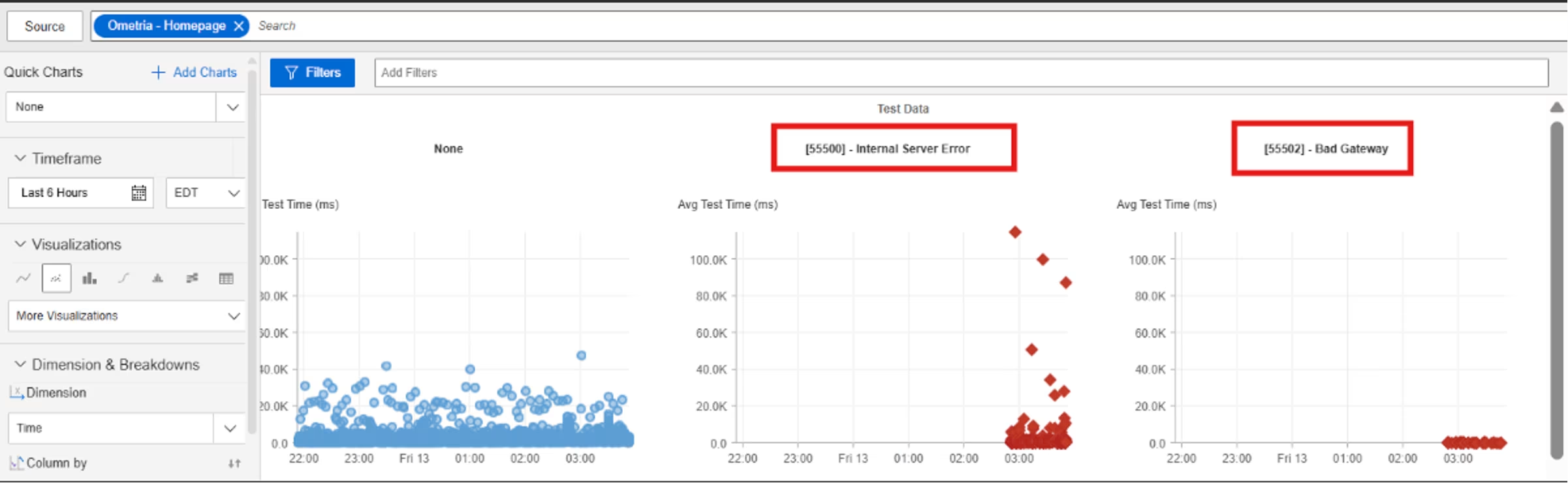

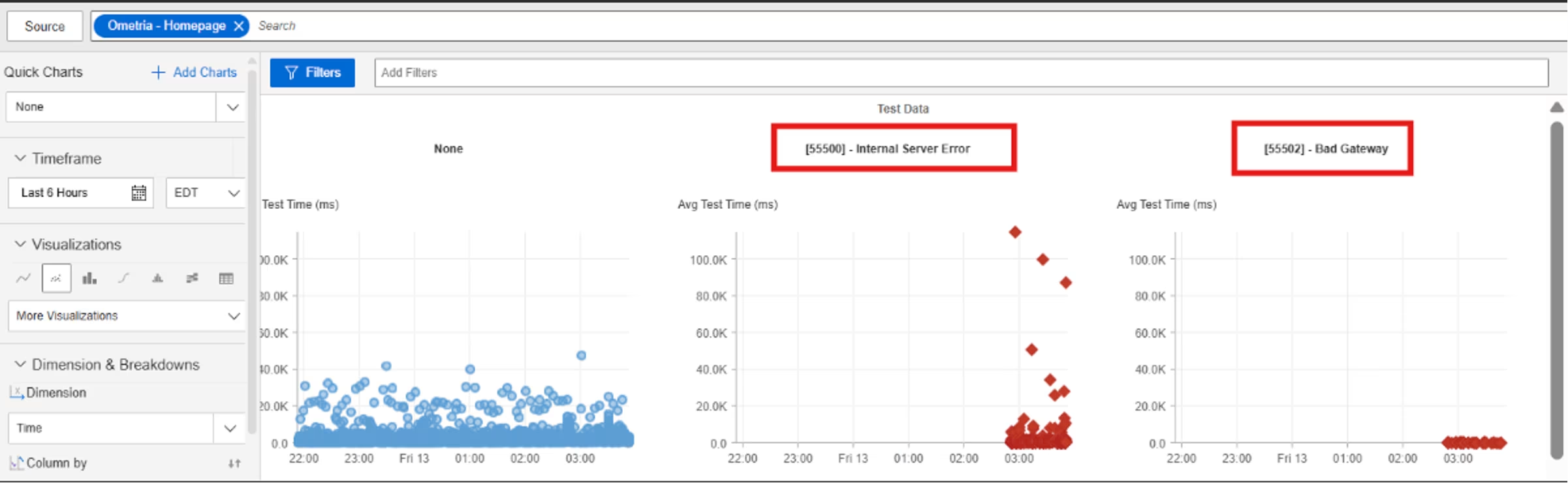

What Happened?

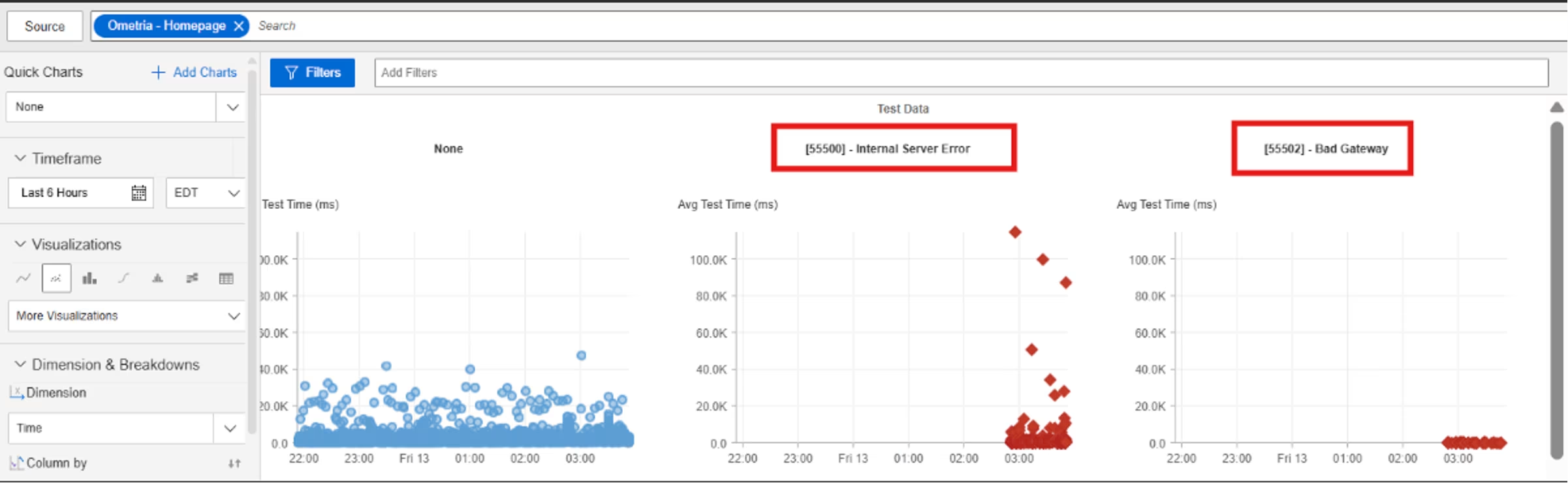

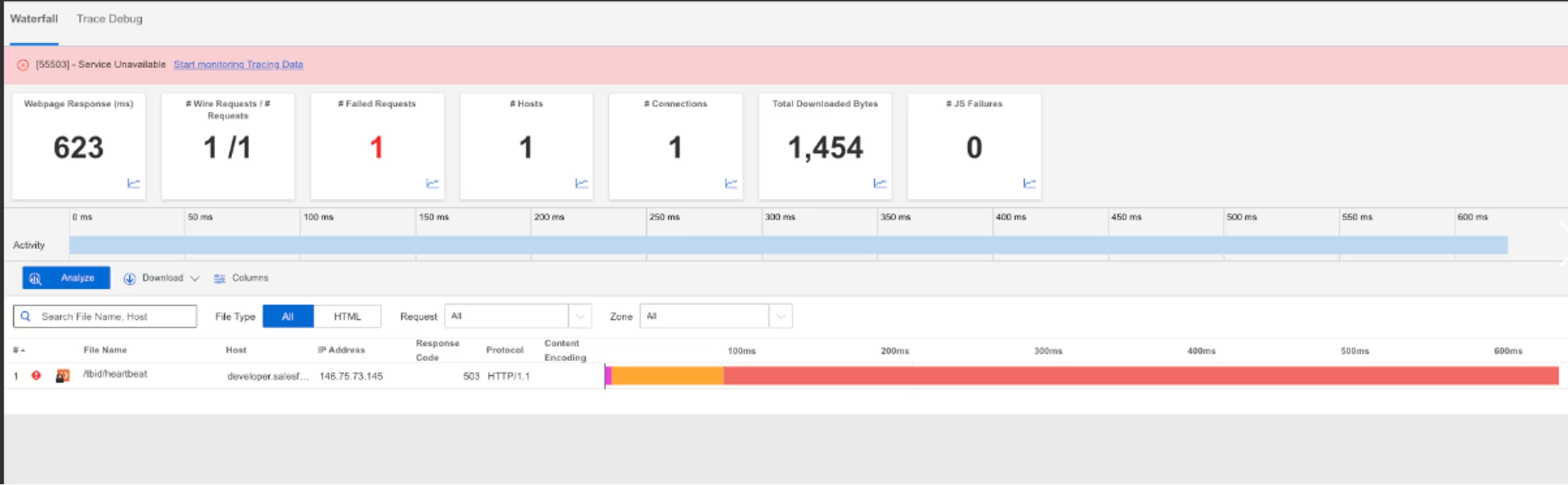

On June 13, 2025, at 2:49 AM EDT, Catchpoint’s Internet Sonar detected an extended outage affecting Ometria services. The disruption impacted 74 cities across the Americas, Europe, the Middle East, Africa, and Asia Pacific. Requests to ometria.com returned HTTP 500 (Internal Server Error) and 502 (Bad Gateway) responses, while cdn.ometria.com showed persistent connection failures—pointing to issues at both the origin and edge layers. The incident lasted nearly five hours, with widespread service disruption observed across both core domains.

Takeaways

500 and 502 errors across multiple regions point to backend or upstream provider issues, not just surface-level downtime. This incident shows why monitoring should flag sudden spikes in error types—not just outages—to catch partial failures early. Because the disruption spanned the US, Europe, and Asia, it also reinforces the need for globally distributed observability to capture the full scope of impact.

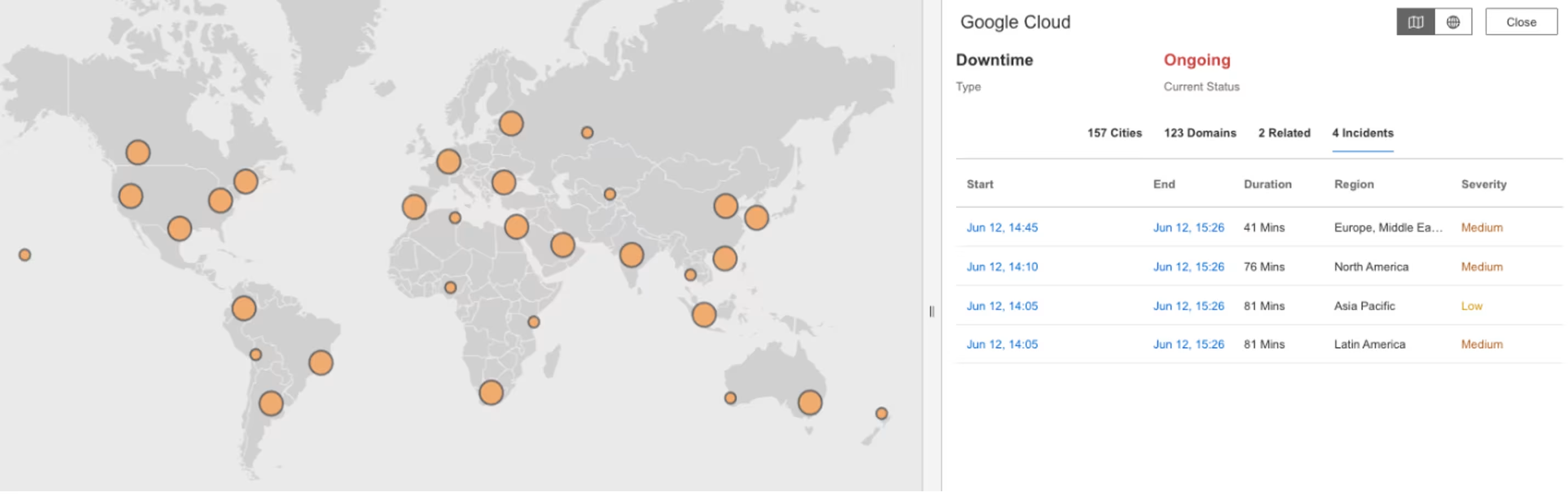

Google Cloud Platform

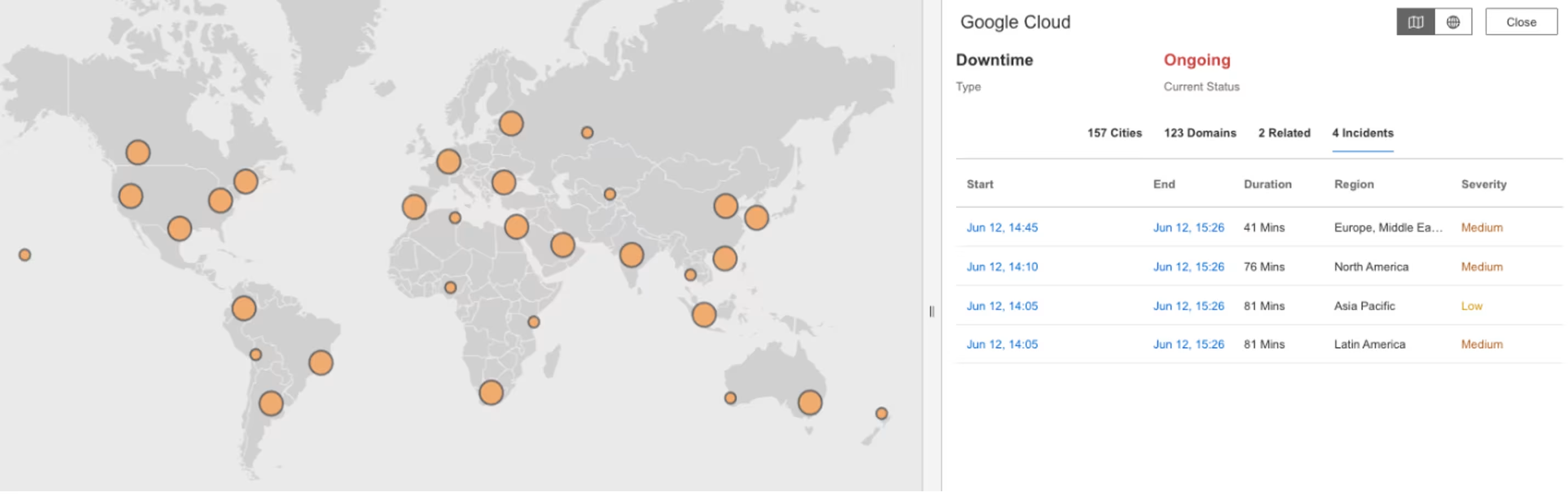

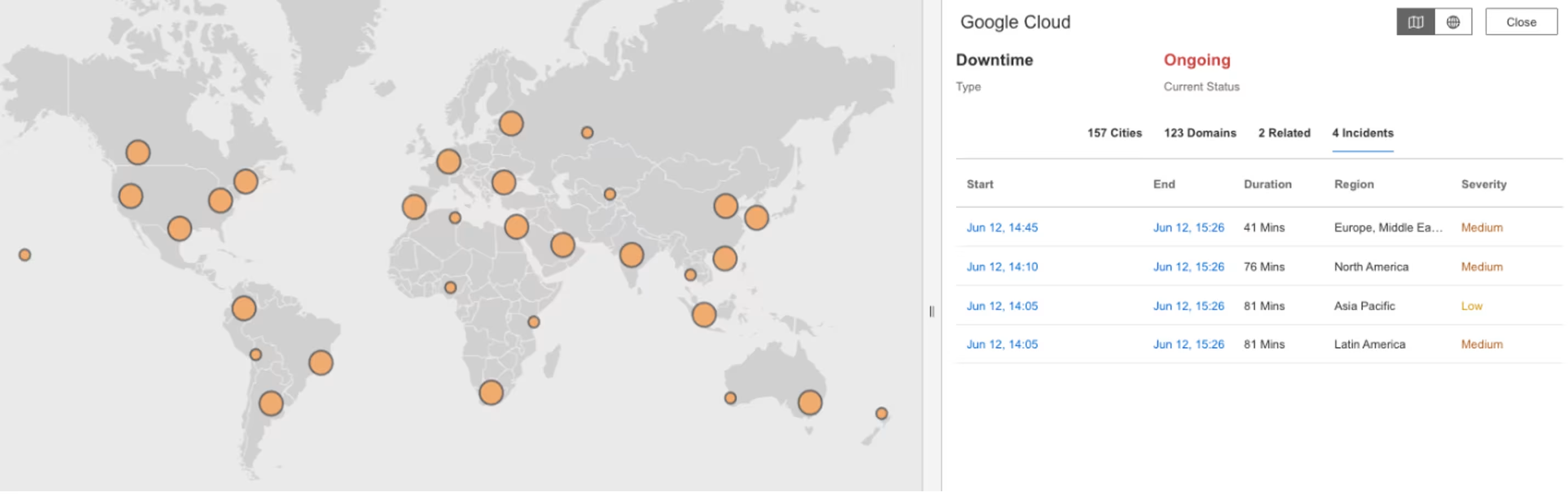

What Happened?

An automated quota update in Google Cloud’s global API-management system overwhelmed a policy database and triggered waves of 503 errors across more than 30 GCP services. The failure rippled outward, disrupting platforms such as Discord, Spotify, Snapchat, Twitch and Cloudflare. Most regions recovered within hours, while us-central1 remained degraded well into the afternoon.

Takeaways